AKADEMIA GÓRNICZO - HUTNICZA

IM. STANISŁAWA STASZICA W KRAKOWIE

______________________________________________________

WYDZIAŁ ELEKTROTECHNIKI AUTOMATYKI INFORMATYKI I ELEKTRONIKI

KATEDRA INFORMATYKI

Praca dyplomowa

Temat pracy:

System do poglądowego przedstawienia właściwości sieci neuronowych.

Autorzy: |

Piotr Swatowski Tomasz Góźdź |

|

|

Kierunek: |

Informatyka |

|

|

Ocena: |

................................. |

Promotor: |

Prof. dr hab. inż. Ryszard Tadeusiewicz |

Recenzent: |

|

Kraków 1998/99

1 Cel

Cel

Celem naszej pracy jest stworzenie środowiska (dydaktyczno - symulacyjnego programu komputerowego) umożliwiającego użytkownikowi zapoznanie się z możliwościami zastosowań oraz ze sposobem działania sieci neuronowych. Program ten w założeniu jest narzędziem edukacyjnym i służyć ma do wizualizacji wybranych właściwości sieci neuronowych oraz przykładów istotnych aspektów uczenia, testowania i wykorzystania sieci.

Do aplikacji dołączamy również system pomocy dla użytkownika (Help), zawierający wstęp teoretyczny i szczegółowe omówienie prezentowanych przez nas zagadnień.

Sztuczne sieci neuronowe

W rozdziale tym zawrzemy informacje o sieciach neuronowych, ich częściach składowych - neuronach, konstrukcji, typach, sposobach uczenia oraz testowania.

Naszkicujemy również historyczny aspekt ewolucji zainteresowania, budowy teorii jak i jej praktycznego wykorzystania w materii sztucznych sieci neuronowych.

Rys historyczny rozwoju sieci neuronowych

W początkowym okresie, gdy nie było formalnych podstawa nauki sztucznych sieci neuronowych zainteresowanie badaczy osadzonych mocno w dziedzinie neurofizjologii czy bioniki skierowane były na opisie mechanizmów działania mózgu czy pojedynczych komórek układu nerwowego. Dziedzina sieci neuronowych zaistniała samodzielnie wraz z wydaniem historycznej pracy [5], w której po raz pierwszy pokuszono się o matematyczny opis komórki neuronowej. W tejże pracy istotnym elementem było również określenie zasad przetwarzania informacji opartego na kanwie modelu sztucznego neuronu.

Kolejnym kanonem wyznaczającym na długi czas rozwój wiedzy o sieciach neuronowych stanowią dwie pozycje: książka [6] prezentująca tę problematykę od strony rozwiązań technicznych oraz książka [7] stanowiąca podstawowe źródło wiadomości biologicznych, które to od zarania dziedziny sztucznych sieci neuronowych są niedoścignionym wzorem i źródłem inspiracji dla kolejnych pokoleń badaczy.

Pierwszym szeroko znanym przykładem znanej sieci neuronowej był Perceptron [8]. Sieci ta jako układ częściowo elektromechaniczny a częściowo elektroniczny została zbudowana w 1957 w Cornell Aeronautical Laboratory. Sieć ta miała za zadanie rozpoznawać znaki. Programowanie tego rozwiązania oparto na zasadach prostego uczenia co stanowiło o wielkim kroku na przód w dziedzinie sieci neuronowych. Po ogłoszeniu wyników przez twórców nastąpił gwałtowny rozwój tego typu sieci neuronowych na całym świecie. Oczywiście większość naśladowców nie wyszło ponad odtworzenie pierwotnego rozwiązania, ale znaleźli się i tacy którzy twórczo przekształcili pomysły Rosenblatta i Wightmana.

Bardzo istotnym tu przykładem jest rozwiązania zaproponowane przez Bernarda Widrowa z Uniwersytetu Standforda sieć Madaline zbudowana w 1960 roku. Sieć ta składała się z pojedynczych elementów Adaline (ang. Adaptive linear element), który powielony oraz połączony dało układ Madaline (ang. Many Adaline). [9, 10]

W owych pionierskich czasach próbowano nawet tworzyć model całego mózgu. Obecnie gdy o mózgu wiemy już znacznie więcej nikt nie porywa się na takiego rodzaju zaangażowania.

Tempo rozwoju badań nad problematyką sztucznych sieci neuronowych zostało gwałtownie zahamowane na początku lat 70-tych po publikacji książki [11], która to zawierała formalny dowód, że sieci jednowarstwowe (podobne do perceptronu) mają bardzo ograniczony zakres zastosowań. Taki stan - impasu utrzymywał się przez około 15 lat aż do ukazania się serii publikacji, które w sposób bardzo sugestywny pokazywały, że sieci nieliniowe wolne są od ograniczeń pokazanych w pracy [11]. Jednocześnie mniej więcej w tym czasie ogłoszono kilka bardzo efektywnych, formalnych przepisów na uczenie sieci wielowarstwowych.

Okres lat 70-tych nie jest jednak zupełnie bezpłodny jeśli chodzi o tworzone nowe konstrukcje sieci neuronowych. Wymienić tu należy, chociażby zbudowaną przez Stephena Grossberga na uniwersytecie w Bostonie sieć Avalanche. Służyła ona do rozpoznawania mowy oraz sterowaniem ramieniem robota. Z kolei w MIT powstaje Cerebellatron skonstruowany przez badaczy Davida Mara, Jamesa Albusa i Andresa Pollioneze, służący także do sterowania robota. Odmienne zastosowanie miała sieć Brain State in the Box, zbudowana przez Jamesa Andersona z uniwersytetu Browna w 1977 roku. Funkcjonalnie była odpowiednikiem pamięci asocjacyjnej z dwustronnym dostępem (BAM), ale jej działanie nie było związane z iteracyjnym procesem poszukiwania, lecz polegało na szybkich zależnościach typu wejście - wyjście.

W momencie opracowania technologii wytwarzania sztucznych modeli komórek nerwowych w postaci układów scalonych pojawiły się w latach 80-tych pierwsze konstrukcje o dużych rozmiarach oraz znaczących mocach obliczeniowych.

W tym czasie pojawiają się pierwsze sieci ze sprzężeniami zwrotnymi. Istotnym przykładem takiej konstrukcji jest opracowana przez Johna Hopfielda z AT&T Bell Labs sieć wykorzystywana do odtwarzania obrazów z ich fragmentów, a także stosowana do rozwiązywania zadań optymalizacyjnych - słynny problem komiwojażera.

Renesans szerokiego zainteresowania tematyką sieci neuronowych datuję się na drugą połowę lat 80-tych. Wtedy to swoją przełomową książkę publikuje J.A. Anderson [12], , a J.J.Hopfield wprowadza rekurencyjną architekturę pamięci neuronowych i opisuje w swoich pracach obliczeniowe własności sieci ze sprzężeniem zwrotnym. Ożywienie wniosło także opublikowanie monografii opracowanej przez McClellanda i Rumelharta [19] na temat równoległego przetwarzania rozproszonego - publikacja ta spowodowała wzrost zainteresowania możliwościami sieci warstwowych.

Począwszy od lat 1986-87 datuje się wzrost liczby projektów badawczych w dziedzinie sieci neuronowych. Wzrasta również liczba zagadnień, które można rozwiązać przy użyciu sieci neuronowych - dokładna analiza różnego rodzaju zagadnień wskazuje często, że zachowanie się danego złożonego systemu jest zdeterminowane przez lokalne i jednoczesne oddziaływanie wielkiej liczby prostych składowych elementów takiego systemu - co wskazuje, że dla takiego zagadnienia można zastosować sieć neuronową. Wzrost liczby takich właśnie zagadnień i dziedzin powoduje rozszerzanie się zakresu zastosowań sieci neuronowych.

Definicja i podstawowe właściwości sieci neuronowych

Jako obiekt badań sieci neuronowe stanowią bardzo uproszczony (przez co łatwiejszy do ogarnięcia myślą lub do zamodelowania na komputerze), ale bogaty i ciekawy model rzeczywistego biologicznego systemu nerwowego.

Składają się one z połączonych ze sobą obiektów (umownie zwanych neuronami). Istotną cechą sieci takich elementów jest możliwość uczenia się - to jest modyfikowania parametrów charakteryzujących poszczególne neurony w taki sposób, by zwiększyć efektywność sieci przy rozwiązywaniu zadań określonego typu.

Sieci neuronowe mogą być bardzo skuteczne jako narzędzia obliczeniowe - i to w rozwiązywaniu takich zadań, z którymi typowe komputery i typowe programy sobie nie radzą. Jest tak z tego powodu, że sieci neuronowe mają w stosunku do typowych systemów obliczeniowych dwie zasadnicze zalety. Po pierwsze obliczenia są w sieciach neuronowych wykonywane równolegle, w związku z czym szybkość pracy sieci neuronowych może znacznie przewyższać szybkość obliczeń sekwencyjnych. Drugą zaletą sieci jest możliwość uzyskania rozwiązania problemu z pominięciem etapu konstruowania algorytmu rozwiązania problemu.

Sieci nie trzeba programować. Istnieją metody uczenia i samouczenia sieci pozwalają uzyskać ich celowe i skuteczne działanie nawet w sytuacji, kiedy twórca sieci nie zna algorytmu, według którego można rozwiązać postawione zadanie.

Zarówno program działania oraz informacje stanowiące bazę wiedzy, a także dane na których wykonuje się obliczenia, jak i sam proces obliczania - są w sieci całkowicie rozproszone.

Sieć działa zawsze jako całość i wszystkie jej elementy mają swój wkład w realizację wszystkich czynności, które sieć realizuje. Jedną z konsekwencji takiego działania sieci jest jej zdolność do poprawnego działania nawet po uszkodzeniu znacznej części wchodzących w jej skład elementów.

Struktura sieci powstaje w ten sposób, że wyjścia jednych neuronów łączy się z wejściami innych. Oczywiście konkretna topologia sieci powinna wynikać z rodzaju zadania, jakie jest stawiane przed siecią. Jednak decyzje dotyczące struktury sieci nie wpływają na jej zachowanie w stopniu decydującym. Zachowanie sieci w zasadniczy sposób determinowane jest przez proces jej uczenia, a nie przez strukturę czy liczbę użytych do jej budowy neuronów.

Znane są doświadczenia, w których strukturę sieci wybierano w sposób całkowicie przypadkowy (ustalając na drodze losowania, które elementy należy ze sobą połączyć i w jaki sposób), a sieć mimo to zdolna była do rozwiązywania stawianych jej zadań.

Sieci neuronowe mogą całą swoją wiedzę zyskiwać wyłącznie w trakcie nauki i nie muszą mieć z góry zadanej, dopasowanej do stawianych im zadań, jakiejkolwiek precyzyjnie określonej struktury. Sieć musi jednak mieć wystarczający stopień złożoności, żeby w jej strukturze można było w toku uczenia "wykrystalizować" potrzebne połączenia i struktury. Zbyt mała sieć nie jest w stanie nauczyć się niczego, gdyż jej "potencjał intelektualny" na to nie pozwala - rzecz jednak nie w strukturze, a w liczbie elementów.

Opis działania neuronu

Sztuczne neurony charakteryzują się występowaniem wielu wejść i jednego wyjścia. Sygnały wejściowe xi (i = 1, 2, . . . , n) oraz sygnał wyjściowy y mogą przyjmować wartości, odpowiadające pewnym informacjom. W ten sposób zadanie sieci sprowadzone do funkcjonowania jej podstawowego elementu polega na tym, że neuron przetwarza informacje wejściowe xi na pewien wynik y. Neurony traktować można jako elementarne procesory o następujących właściwościach:

każdy neuron otrzymuje wiele sygnałów wejściowych i wyznacza na ich podstawie swoją odpowiedź to znaczy jeden sygnał wyjściowy;

z każdym oddzielnym wejściem neuronu związany jest parametr nazywany wagą ( określa stopień ważności informacji docierających tym właśnie wejściem - na wyjście ma wpływ waga przemnożona przez wejście);

sygnał wchodzący określonym wejściem jest najpierw przemnażany przez wagę danego wejścia, w związku z czym w dalszych obliczeniach uczestniczy już w formie zmodyfikowanej: wzmocnionej (gdy waga jest większa od 1) lub stłumionej (gdy waga ma wartość mniejszą od 1) względnie nawet przeciwstawnej w stosunku do sygnałów z innych wejść gdy waga ma wartość ujemną (tzw. wejścia hamujące);

sygnały wejściowe (przemnożone przez odpowiednie wagi) są w neuronie sumowane, dając pewien pomocniczy sygnał wewnętrzny nazywany czasem łącznym pobudzeniem neuronu (w literaturze angielskiej net value);

do tak utworzonej sumy sygnałów dodaje niekiedy (nie we wszystkich typach sieci) pewien dodatkowy składnik niezależny od sygnałów wejściowych, nazywany progiem (w literaturze angielskiej bias);

suma przemnożonych przez wagi sygnałów wewnętrznych z dodanym (ewentualnie) progiem może być bezpośrednio traktowana jako sygnał wyjściowy neuronu ( w sieciach o bogatszych możliwościach sygnał wyjściowy neuronu obliczany jest za pomocą pewnej nieliniowej zależności między łącznym pobudzeniem a sygnałem wyjściowym);

Każdy neuron dysponuje pewną wewnętrzną pamięcią (reprezentowaną przez aktualne wartości wag i progu) oraz pewnymi możliwościami przetwarzania wejściowych sygnałów w sygnał wyjściowy.

Z powodu bardzo ubogich możliwości obliczeniowych pojedynczego neuronu - sieć neuronowa może działać wyłącznie jako całość. Wszystkie możliwości i właściwości sieci neuronowych są wynikiem kolektywnego działania bardzo wielu połączonych ze sobą elementów (całej sieci, a nie pojedynczych neuronów).

Uczenie sieci neuronowych

Cykl działania sieci neuronowej podzielić można na etap nauki, kiedy sieć gromadzi informacje potrzebne jej do określenia, co i jak ma robić, oraz na etap normalnego działania (nazywany czasem także egzaminem), kiedy w oparciu o zdobytą wiedzę sieć musi rozwiązywać konkretne nowe zadania. Możliwe są dwa warianty procesu uczenia : z nauczycielem i bez nauczyciela.

Uczenie z nauczycielem

Uczenie z nauczycielem polega na tym, że sieci podaje się przykłady poprawnego działania, które powinna ona potem naśladować w swoim bieżącym działaniu (w czasie egzaminu). Przykład należy rozumieć w ten sposób, że nauczyciel podaje konkretne sygnały wejściowe i wyjściowe, pokazując, jaka jest wymagana odpowiedź sieci dla pewnej konfiguracji danych wejściowych. Mamy do czynienia z parą wartości - przykładowym sygnałem wejściowym i pożądanym (oczekiwanym) wyjściem, czyli wymaganą odpowiedzią sieci na ten sygnał wejściowy. Zbiór przykładów zgromadzonych w celu ich wykorzystaniu w procesie uczenia sieci nazywa się zwykle ciągiem uczącym. Zatem w typowym procesie uczenia sieć otrzymuje od nauczyciela ciąg uczący i na jego podstawie uczy się prawidłowego działania, stosując jedną z wielu znanych dziś strategii uczenia.

Uczenie bez nauczyciela

Obok opisanego wyżej schematu uczenia z nauczycielem występuje też szereg metod tak zwanego uczenia bez nauczyciela (albo samouczenia sieci). Metody te polegają na podawaniu na wejście sieci wyłącznie szeregu przykładowych danych wejściowych, bez podawania jakiejkolwiek informacji dotyczącej pożądanych czy chociażby tylko oczekiwanych sygnałów wyjściowych. Odpowiednio zaprojektowana sieć neuronowa potrafi wykorzystać same tylko obserwacje wejściowych sygnałów i zbudować na ich podstawie sensowny algorytm swojego działania - najczęściej polegający na tym, że automatycznie wykrywane są klasy powtarzających się sygnałów wejściowych i sieć uczy się (spontanicznie, bez jawnego nauczania) rozpoznawać te typowe wzorce sygnałów.

Samouczenie jest też bardzo interesujące z punktu widzenia zastosowań, gdyż nie wymaga żadnej jawnie podawanej do sieci neuronowej zewnętrznej wiedzy , a sieć zgromadzi wszystkie potrzebne informacje i wiadomości.

Organizacja uczenia sieci

Kluczowym pojęciem dla uczenia sieci są wagi wejść poszczególnych neuronów. Każdy neuron ma wiele wejść, za pomocą których odbiera sygnały od innych neuronów oraz sygnały wejściowe podawane do sieci jako dane do obliczeń. Z wejściami tymi skojarzone są parametry nazywane wagami; każdy sygnał wejściowy jest najpierw przemnażany przez wagę, a dopiero później sumowany z innymi sygnałami. Jeśli zmienią się wartości wag - neuron zacznie pełnić innego rodzaju funkcję w sieci, a co za tym idzie - cała sieć zacznie inaczej działać. Uczenie sieci polega więc na tym, by tak dobrać wagi, żeby wszystkie neurony wykonywały dokładnie takie czynności, jakich się od nich wymaga.

Ze względu na rozmiar sieci (w wielu wypadkach mamy do czynienia z b. dużą liczbą neuronów) niemożliwe jest zdefiniowanie potrzebnych wag dla wszystkich wejść w sposób jednorazowy i arbitralny ręcznie. Można jednak zaprojektować i zrealizować proces uczenia polegający na rozpoczęciu działania sieci z pewnym przypadkowym zestawem wag i na stopniowym polepszaniu tych wag. W każdym kroku procesu uczenia wartości wag jednego lub kilku neuronów ulegają zmianie, przy czym reguły tych zmian są tak pomyślane, by każdy neuron sam potrafił określić, które ze swoich wag ma zmienić, w którą stronę (zwiększenie lub zmniejszenie) a także o ile. Oczywiście przy określaniu potrzebnych zmian wag neuron może korzystać z informacji pochodzących od nauczyciela (o ile stosujemy uczenie z nauczycielem), nie zmienia to jednak faktu, że sam proces zmiany wag (będących w sieci jedynym śladem pamięciowym) przebiega w każdym neuronie sieci w sposób spontaniczny i niezależny dzięki czemu może być realizowany bez konieczności bezpośredniego stałego dozoru ze strony osoby sterującej tym procesem.

W praktycznych zastosowaniach korzysta się czasem z dodatkowego mechanizmu "rywalizacji" między neuronami, który w niektórych zastosowaniach pozwala uzyskiwać znacznie lepsze wyniki działania sieci. Zaobserwowanie działania sieci z rywalizacją (competition network) możliwe jest po wprowadzeniu do sieci elementu porównującego ze sobą sygnały wyjściowe wszystkich neuronów i typującego wśród nich "zwycięzcę". Zwycięzcą w tej konkurencji zostaje neuron o największej wartości sygnału wyjściowego. Z wytypowaniem "zwycięzcy" mogą wiązać się różne konsekwencje (na przykład tylko temu jednemu neuronowi można nadać prawo uczenia się (sieci Kohonena), najczęściej jednak wytypowanie zwycięzcy służy do tego, by silniej spolaryzować wyjściowe sygnały z sieci - na przykład tylko neuron będący "zwycięzcą" ma prawo wysłać swój sygnał na zewnątrz, wszystkie pozostałe sygnały są natomiast zerowane. Taka zasada działania sieci, nazywana czasem WTA (Winner Takes All - zwycięzca zabiera wszystko) pozwala łatwiej interpretować zachowanie sieci (szczególnie wtedy, gdy ma ona wiele wyjść), ale niesie ze sobą pewne niebezpieczeństwa (wzmiankowane wyżej).

Projektowanie zbioru uczącego dla sieci neuronowej

Rozmiar zbioru

Jeśli sieć neuronowa ma działać efektywnie, zbiór uczący użyty musi spełniać dwa podstawowe warunki:

po pierwsze każda klasa powinna być reprezentowana w zbiorze uczącym (na ogół dane uczące składają się z kilku podgrup, z których każda określona jest przez pewien wzorzec - wszystkie takie wzorce powinny być reprezentowane w ciągu uczącym)

po drugie w ramach każdej klasy powinna być reprezentowana zmienność statystyczna (praca sieci odbywać się będzie na ciągach zawierających dane „zaszumione”, a nie idealnie czyste wzorce - projekt ciągu uczącego musi zapewniać odpowiednią różnorodność efektów szumu).

Z drugiej strony ograniczeniem dla wielkości zbioru jest czasochłonność procesu uczenia - wraz ze zbiorem uczącym wzrasta ona liniowo. Tak więc ze wzglądu na szybkość procesu należy dążyć do minimalizacji rozmiaru zbioru uczącego.

Błędy przypadkowe

Są to pojawiające się w trakcie pracy sieci niechciane „zdarzenia losowe” - zakłócenia w ciągu wejściowym dla sieci. Gdy wszystkie próbki określonej podklasy zakłócone są w ten sam sposób, to sieć nauczy się zakłóconego wzorca. W sytuacji, gdy w rzeczywistej pracy sieci wzorzec pojawi się bez zakłócenia sieć może go nie rozpoznać - bo nie nauczyła się go na podstawie ciągu uczącego.

Problem ten staje się szczególnie uciążliwy w sytuacji, gdy rozpatrywany przypadek znajduje się w pobliżu granicy „obszaru decyzyjnego” danej podklasy.

W takiej sytuacji, aby uniknąć uczenia wzorców przypadkowych zwiększa się liczność zbioru uczącego.

Zależność rozmiaru sieci i rozmiaru zbioru uczącego

Wielkość ciągu uczącego jest zależna od wielkości sieci, dla której jest on projektowany. Im większa jest sieć - tym większy ciąg uczący jest konieczny do nauczenia jej.

Skłonność do nadmiernego dopasowania sieci jest również proporcjonalna do wielkości sieci. Przy założeniu, ze jest n wejść oraz m neuronów ukrytych - sieć ma m x ( n + 1) wag . Przy n - rzędu kilkuset i m - kilkanaście (co jest możliwe w zastosowaniach przemysłowych) otrzymujemy w sieci b. dużą ilość parametrów swobodnych. Jedynym rozwiązaniem, które uchroni sieć przed „nauczeniem się na pamięć” danego ciągu jest zbudowanie ciągu tak dużego, by sieć nie mogła nauczyć się wszystkich szczegółów.

Można zalecić by minimalna liczba próbek była dwukrotnie większa od liczby wag sieci (choć liczba czterokrotnie większa od ilości wag wydaje się odpowiedniejsza). [2]

Rozwarstwienie zbioru uczącego

Jest to sytuacja, która wymusza zastosowanie bardzo dużego zbioru uczącego. Obecność wielu podklas stwarza bowiem konieczność powiększania tego zbioru, ponieważ częściej mogą pojawiać się błędy przypadkowe.

Ukryte błędy systematyczne

Jednym z istotnych niebezpieczeństw przy konstruowaniu zbiorów jest nieświadome uczenie sieci ludzkich błędów systematycznych. Sieć uczy się takich błędów tak samo jak innych wzorców. Jeśli ciąg uczący obciążony jest błędami systematycznymi, może to doprowadzić do sytuacji, gdy nauczona sieć działająca poprawnie na takim ciągu uczącym, zawiedzie przy pracy na danych nieobciążonych błędem systematycznym.

Reguły uczenia

Zostaną omówione dwie podstawowe reguły uczenia: reguła Delta leżącą u podstaw większości algorytmów uczenia z nauczycielem oraz reguła Hebba stanowiąca przykład uczenia bez nauczyciela.

Reguła Delta

Reguła delta jest regułą uczenia z nauczycielem. Polega ona na tym, że każdy neuron po otrzymaniu na swoich wejściach określone sygnały (z wejść sieci albo od innych neuronów, stanowiących wcześniejsze piętra przetwarzania informacji) wyznacza swój sygnał wyjściowy wykorzystując posiadaną wiedzę w postaci wcześniej ustalonych wartości współczynników wzmocnienia (wag) wszystkich wejść oraz (ewentualnie) progu. Sposoby wyznaczania przez neurony wartości sygnałów wyjściowych na podstawie sygnałów wejściowych omówione zostały dokładniej w poprzednim rozdziale. Wartość sygnału wyjściowego, wyznaczonego przez neuron na danym kroku procesu uczenia porównywana jest z odpowiedzią wzorcową podaną przez nauczyciela w ciągu uczącym. Jeśli występuje rozbieżność - neuron wyznacza różnicę pomiędzy swoim sygnałem wyjściowym a tą wartością sygnału, która była by - według nauczyciela prawidłowa. Ta różnica oznaczana jest zwykle symbolem greckiej litery δ (delta) i stąd nazwa opisywanej metody.

Sygnał błędu (delta) wykorzystywany jest przez neuron do korygowania swoich współczynników wagowych (i ewentualnie progu), stosując następujące reguły:

wagi zmieniane są tym silniej, im większy błąd został wykryty;

wagi związane z tymi wejściami, na których występowały duże wartości sygnałów wejściowych, zmieniane są bardziej, niż wagi wejść, na których sygnał wejściowy był niewielki.

Znając błąd popełniony przez neuron oraz jego sygnały wejściowe możemy łatwo przewidzieć, jak będą się zmieniać jego wagi.

Sieć stosując opisane metody w praktyce sama przerywa proces uczenia gdy jest już dobrze wytrenowana, gdyż małe błędy powodują jedynie minimalne korekty wag. Jest to logiczne, podobnie jak zasada uzależniania wielkości korekty od wielkości wejściowego sygnału przekazywanego przez rozważaną wagę, te wejścia, na których występowały większe sygnały miały większy wpływ na wynik działania neuronu, który okazał się błędny, trzeba je więc silniej "temperować". W szczególności opisany algorytm powoduje, że dla wejść, na których w danym momencie nie były podawane sygnały (podczas obliczeń miały one zerowe wartości) odpowiednie wagi nie są zmieniane, nie wiadomo bowiem, czy są dobre czy nie, gdyż nie uczestniczyły w tworzeniu aktualnego (błędnego, skoro trzeba coś poprawiać) sygnału wyjściowego.

W praktycznych realizacjach opisanego wyżej algorytmu dochodzi kilka dalszych godnych uwagi elementów. W pierwszej kolejności twórca sieci musi zdecydować, jak silne powinny być zmiany wag powodowane przez określone wartości sygnałów wejściowych i określoną wielkość błędu. Ten współczynnik proporcjonalności η, zwany learning rate, może być wybierany dowolnie, jednak każda konkretna decyzja ma określone konsekwencje. Wybranie współczynnika za małego prowadzi do bardzo powolnego procesu uczenia (wagi są poprawiane w każdym kroku bardzo słabo, żeby więc osiągnęły pożądane wartości trzeba wykonać bardzo dużo takich kroków). Z kolei wybór za dużego współczynnika uczenia powoduje bardzo gwałtowne zmiany parametrów sieci, które w krańcowym przypadku prowadzić mogą nawet do niestabilności procesu uczenia. Konieczny jest więc kompromisowy wybór współczynnika uczenia, uwzględniający zarówno korzyści związane z szybką pracą, jak i względy bezpieczeństwa, wskazujące na konieczność uzyskania stabilnej pracy procesu uczenia.

Reguła Hebba

Jest to jedna z najpopularniejszych metod samouczenia sieci neuronowych. Polega ona na tym, że sieci pokazuje się kolejne przykłady sygnałów wejściowych, nie podając żadnych informacji o tym, co z tymi sygnałami należy zrobić. Sieć obserwuje otoczenie i odbiera różne sygnały, nikt nie określa jednak, jakie znaczenie mają pokazujące się obiekty i jakie są pomiędzy nimi zależności. Sieć na podstawie obserwacji występujących sygnałów stopniowo sama odkrywa, jakie jest ich znaczenie i również sama ustala zachodzące między sygnałami zależności.

Po podaniu do sieci neuronowej każdego kolejnego zestawu sygnałów wejściowych tworzy się w tej sieci pewien rozkład sygnałów wyjściowych - niektóre neurony sieci są pobudzone bardzo silnie, inne słabiej, a jeszcze inne mają sygnały wyjściowe wręcz ujemne. Interpretacja tych zachowań może być taka, że niektóre neurony „rozpoznają” podawane sygnały jako „własne” (czyli takie, które są skłonne akceptować), inne traktują je „obojętnie”, zaś jeszcze u innych neuronów wzbudzają one wręcz „awersję”. Po ustaleniu się sygnałów wyjściowych wszystkich neuronów w całej sieci - wszystkie wagi wszystkich neuronów są zmieniane, przy czym wielkość odpowiedniej zmiany wyznaczana jest na podstawie iloczynu sygnału wejściowego, wchodzącego na dane wejście (to którego wagę zmieniamy) i sygnału wyjściowego produkowanego przez neuron, w którym modyfikujemy wagi. Łatwo zauważyć, że jest to właśnie realizacja postulatu Hebba - w efekcie opisanego wyżej algorytmu połączenia między źródłami silnych sygnałów i neuronami które na nie silnie reagują są wzmacniane.

Dokładniejsza analiza procesu samouczenia metodą Hebba pozwala stwierdzić, że w wyniku konsekwentnego stosowania opisanego algorytmu początkowe, najczęściej przypadkowe „preferencje” neuronów ulegają systematycznemu wzmacnianiu i dokładnej polaryzacji. Jeśli jakiś neuron miał „wrodzoną skłonność” do akceptowania sygnałów pewnego rodzaju - to w miarę kolejnych pokazów nauczy się te sygnały rozpoznawać coraz dokładniej i coraz bardziej precyzyjnie. Po dłuższym czasie takiego samouczenia w sieci powstaną zatem wzorce poszczególnych typów występujących na wejściu sieci sygnałów. W wyniku tego procesu sygnały podobne do siebie będą w miarę postępu uczenia coraz skuteczniej grupowane i rozpoznawane przez pewne neurony, zaś inne typy sygnałów staną się „obiektem zainteresowania” innych neuronów W wyniku tego procesu samouczenia sieć nauczy się, ile klas podobnych do siebie sygnałów pojawia się na jej wejściach oraz sama przyporządkuje tym klasom sygnałów neurony, które nauczą się je rozróżniać, rozpoznawać i sygnalizować.

Proces samouczenia ma niestety wady. W porównaniu z procesem uczenia z nauczycielem samouczenie jest zwykle znacznie powolniejsze. Co więcej bez nauczyciela nie można z góry określić, który neuron wyspecjalizuje się w rozpoznawania której klasy sygnałów. Stanowi to pewną trudność przy wykorzystywaniu i interpretacji wyników pracy sieci. Co więcej - nie można określić, czy sieć uczona w ten sposób nauczy się wszystkich prezentowanych jej wzorców. Dlatego sieć przeznaczona do samouczenia musi być większa niż sieć wykonująca to samo zadanie, ale trenowana w sposób klasyczny, z udziałem nauczyciela. - Szacunkowo sieć powinna mieć co najmniej trzykrotnie więcej elementów warstwy wyjściowej niż wynosi oczekiwana liczba różnych wzorów, które sieć ma rozpoznawać.

Bardzo istotną kwestią jest wybór początkowych wartości wag neuronów sieci przeznaczonej do samouczenia. Wartości te mają bardzo silny wpływ na ostateczne zachowanie sieci, ponieważ proces uczenia jedynie pogłębia i doskonali pewne tendencje istniejące w sieci od samego początku, przeto od jakości tych początkowych, „wrodzonych” właściwości sieci silnie zależy, do czego sieć dojdzie na końcu procesu uczenia. Nie wiedząc z góry, jakiego zadania sieć powinna się uczyć, trudno wprowadzać jakikolwiek zdeterminowany mechanizm nadawania początkowych wartości wag, jednak pozostawienie wszystkiego wyłącznie mechanizmom losowym może powodować, że sieć (zwłaszcza mała) może nie zdołać wystarczająco zróżnicować swego działania w początkowym okresie procesu uczenia i wszelkie późniejsze wysiłki, by znaleźć w strukturze sieci reprezentację dla wszystkich występujących w wejściowych sygnałach klas, mogą okazać się daremne. Można jednak wprowadzić pewien mechanizm wstępnego „rozprowadzania” wartości wag w początkowej fazie procesu uczenia. Metoda ta, zwana convex combiation modyfikuje początkowe wartości wag w taki sposób, by zwiększyć prawdopodobieństwo równomiernego pokrycia przez poszczególne neurony wszystkich typowych sytuacji pojawiających się w wejściowym zbiorze danych. Jeśli tylko dane pojawiające się w początkowej fazie uczenia nie będą różniły się istotnie od tych, jakie sieć będzie potem analizować i różnicować - metoda convex combination stworzy w sposób automatyczny dogodny punkt wyjścia do dalszego samouczenia i zapewni stosunkowo dobrą jakość nauczonej sieci w większości praktycznych zadań.

Opis implementacji poglądowej prezentacji wybranych przykładów sieci neuronowych

W rozdziale tym skoncentrujemy się na opisie zagadnień przedstawionych w poszczególnych modułach systemu. Określimy sposób dojścia do otrzymanego efektu - edukacyjnego programu komputerowego. Zaprezentujemy najistotniejsze fragmenty kodu źródłowego, formalnie opisanego w języku Pascal, określającego sposób implementacji wybranych cech rozpatrywanych sztucznych sieci neuronowych. Układ tej części został zorganizowany w modułu dokładnie odpowiadające częściom aplikacji tworzonej w Delphi.

Prezentacja neuronu

Sfera sztucznych sieci neuronowych opiera się na formalnych definicjach modeli neuronu (następnie ich układów - sieci) oraz ich późniejszej implementacji w postacie sprzętowej - np. układy VLSI lub oprogramowania - wszelkiego rodzaju symulacje.

Pierwszą formalną definicję neuronu opartą na uproszczonym modelu rzeczywistym podali McCulloch i Pitts (1943). [5]

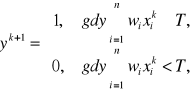

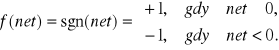

Sygnały wejściowe xi, i=1,2,...,n maja wartości 1 lub 0 w zależności od tego czy w danej chwili k impuls wejściowy pojawił się, czy też nie. Reguła aktywacji neuronu ma dla tego modelu postać:

gdzie k=0,1,2,... oznacza kolejne momenty czasu, wi zaś jest multiplikatywną wagą przypisaną połączeniu wejścia i z błoną neuronu.

Mimo swej prostoty, model ten wykazuje duże potencjalne możliwości . Przy odpowiednim doborze wag i progów można z jego pomocą zrealizować funkcje logiczne NOT, OR oraz AND bądź NOR lub NAND. Wprowadzając sprzężenie zwrotne można jednak budować także układy sekwencyjne. W przypadku sygnałów binarnych neuron z jednym wejściem pobudzającym i jednostkowym progiem wytwarza sygnał yk+1 = xk. Otrzymany prosty obwód zachowujący się jak jednobitowy rejestr jest zdolny zapamiętać stan wejścia pomiędzy dwoma momentami czasu. Zamykając pętlę sprzężenia zwrotnego powstaje komórka pamięci.

Ze względu na to, że model McCullocha-Pittsa zawiera szereg istotnych uproszczeń (obsługa jedynie stanów binarnych 0 i 1, założenie dyskretnego czasu pracy, synchronizm działania wszystkich neuronów w sieci, wagi i progi są niezmienne) wprowadza się ogólny opis sztucznego neuronu.

Ogólny model neuronu zakłada, że każdy neuron składa się z elementu przetwarzającego połączonego z wejściami synaptycznymi oraz jednym wyjściem. Przepływ sygnałów jest jednokierunkowy.

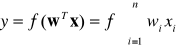

Sygnał wyjściowy neuronu dany jest zależnością:

gdzie w jest wektorem wag zdefiniowanym jako

![]()

x jest wektorem wejściowym:

![]()

Funkcja ![]()

określana jest zwykle nazwą funkcji aktywacji. Jej dziedziną jest zbiór łącznych pobudzeń neuronu. W literaturze często łączne pobudzenie określane jest symbolem net. W związku z czym funkcję aktywacji można zapisać jako ![]()

Łączne pobudzenie net jest odpowiednikiem potencjału pobudzającego w neuronie biologicznym.

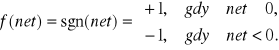

Typowymi funkcjami aktywacji, najczęściej stosowanymi przy konstruowaniu zarówno programowych jak i sprzętowych realizacji sztucznych sieci neuronowych są

![]()

oraz

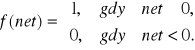

Powyższe funkcje aktywacji zwane są odpowiednio bipolarną funkcją ciągłą i bipolarną funkcją binarną (dyskretną). Odpowiednio skalując powyższe funkcje możemy otrzymać odpowiednio unipolarną funkcję ciągłą oraz unipolarną funkcję binarną dane wzorami:

![]()

oraz

Pierwsze z tych funkcji nazywane są funkcjami sigmoidalnymi.

Istotnymi z punktu widzenia projektowego parametrami opisującymi neuron są moc śladu pamięciowego (wektor wag), moc sygnału wejściowego.

W naszym programie zaprezentujemy model sztucznego neuronu umożliwiające zmianę wartości wektora wag oraz sygnału wejściowego. Oraz automatyczne obliczenie mocy sygnału wejściowego, mocy śladu pamięciowego jak i łącznego pobudzenia neuronu. Pokazane też zostaną wartości dwóch funkcje aktywacji: ciągłej sigmoidalnej oraz bipolarnej dla wyznaczonego łącznego pobudzenia neuronu.

Poniżej przedstawiamy algorytmy obliczające wyjście neuronu (dwie funkcje) przy zadanych wagach oraz sygnale wejściowym oraz parametry: moc śladu pamięciowego i moc sygnału wejściowego oraz łączne pobudzenie.

struktury danych algorytmu:

sygnały [5] - wektor sygnałów wejściowych (5 sygnałów wejściowych),

wagi [5] - wektor wag dla wejść (5 wartości wektora wag),

moc_sladu - moc śladu pamięciowego,

moc_sygnalu - moc sygnału wejściowego,

net - łączne pobudzenie neuronu obliczone z zadanych wektorów wag oraz sygnału wejściowego,

lambda - parametr λ ciągłej sigmoidalnej funkcji aktywacji neuronu,

c_funkcja - wartość ciągłej funkcji aktywacji ![]()

dla obliczonego łącznego pobudzenia neuronu,

d_funkcja - wartość dyskretnej, unipolarnej funkcji aktywacji

dla obliczonego łącznego pobudzenia neuronu,

moc sygnału wejściowego:

moc_sygnalu := 0;

for i := 1 to 5 do

moc_sygnalu := moc_sygnalu + sygnaly[i] * sygnaly[i];

moc śladu pamięciowego:

moc_sladu := 0;

for i := 1 to 5 do

moc_sladu := moc_sladu + wagi[i] * wagi[i];

łączne pobudzenie neuronu:

net := 0;

for i := 1 to 5 do

net := net + wagi[i] * sygnaly[i];

ciągła funkcja aktywacji:

c_funkcja := -1.0 + 2.0/(1+exp(-lambda*net));

dyskretne, unipolarna funkcja aktywacji:

d_funkcja := -1.0;

if net >= 0 then

d_funkcja := 1.0;

Jak widać z przedstawionego algorytmu neuron w przykładzie jest jedne (jeden zestaw wejść i wag) ale posiada, dla potrzeb prezentacji, trzy rodzaje odpowiedzi: Łączne pobudzenie, Ciągłą funkcję aktywacji oraz Binarną funkcję aktywacji przez co reprezentuje dwa rodzaje neuronów: zarówno liniowe jak i nieliniowe.

Prosta sieć neuronowa (z WAT)

Sieć neuronowa złożona jest z trzech nie powiązanych ze sobą neuronów. Każdy z neuronów posiada pięć wag; do każdego neuronu doprowadzony jest ten sam sygnał wejściowy. Działanie jednowarstwowej , trzyelementowej sieci oparte jest na zasadzie WAT (ang. Winer Take All) - zwycięzca bierze wszystko. Polega ona na tym, że do każdego z neuronów sieci doprowadza się ten sam sygnał wejściowy, następnie zostaje wyliczona wartość wyjściowa dla każdego neuronu. Neuron o największej (powyżej progowej wartości) wartości wyjścia zostaje zwycięzcą co dalej dla takiej sieci i takiego neuronu może rodzić różnorakie konsekwencje. Może to predysponować taki neuron do dalszego uczenia albo może np. stanowić wskazanie przynależności (faza eksploatacji lub testowania) obiektu definiowanego przy pomocy wektora wejściowego do klasy obiektów rozpoznawanych przez dany neuron (np. opis wrony poprzez odpowiednie wejście może być rozpoznane przez poprawnie nauczoną sieć jako obiekt przynależny do ptaków i do niczego więcej).

Praca danej sieci z zaimplementowanym progiem i przepisem działania WAT odbywa się według algorytmu:

struktury danych algorytmu:

NA1, NA2, NA3, NA4, NA5 - wagi neuronu A, wektor wag neuronu A to [NA1, NA2, NA3, NA4, NA5]

NB1, NB2, NB3, NB4, NB5 - wagi neuronu B, wektor wag neuronu B to [NB1, NB2, NB3, NB4, NB5]

NC1, NC2, NC3, NC4, NC5 - wagi neuronu C, wektor wag neuronu C to [NC1, NC2, NC3, NC4, NC5]

Ob1, Ob2, Ob3, Ob4, Ob5 - kolejne wartości wektora sygnału wejściowego wektor wejściowy to [Ob1, Ob2, Ob3, Ob4, Ob5]T

{ ----- wyjście dla neuronu A ----- }

Wyj := NA1 * Ob1 + NA2 * Ob2 + NA3 * Ob3 + NA4 * Ob4 + NA5 * Ob5;

TabPom[1] := Wyj;

{ ----- wyjście dla neuronu B ----- }

Wyj := NB1 * Ob1 + NB2 * Ob2 + NB3 * Ob3 + NB4 * Ob4 + NB5 * Ob5;

TabPom[2] := Wyj;

{ ----- wyjście dla neuronu C ----- }

Wyj := NC1 * Ob1 + NC2 * Ob2 + NC3 * Ob3 + NC4 * Ob4 + NC5 * Ob5;

TabPom[3] := Wyj;

{ zostały wyliczone wartości wyjść dla poszczególnych neuronów}

{teraz przechodzimy do ustalenia zwycięzcy - neuronu który zidentyfikował obiekt}

struktury danych algorytmu klasyfikacji WAT z progiem:

MaxWin - wartość progowa dla rozpoznawanych obiektów - wyjść poszczególnych neuronów zapisanych w trzyelementowej tablicy TabPom.

Winner - numer neuronu który rozpoznał obiekt

MaxWin - wartość określa próg przy którym można mówić o zwycięzcy. Jeśli wszystkie wartości wyjściowe poszczególnych neuronów są mniejsze od wartości progowej algorytm nie wyłania zwycięzcy przez co dany wektor sygnałów wejściowych jest odrzucany przez sieć trzech neuronów.

Winer := 0;

MaxWin := Prog;

for I := 1 to 3 do

if MaxWin <= TabPom[I] then

begin

MaxWin := TabPom[I];

Winer := I;

end;

{jeśli Winner jest równy 0, to znaczy, ze sieć nie potrafi zidentyfikować obiektu}

W przykładzie zostały wagi odpowiednio nazwane a wybór odpowiedniego - zwycięskiego - neuronu jest równoważny w rozpoznaniu wejścia jako nazwanego obiektu o określonych cechach (wartościami wag).

Uczenie pojedynczego neuronu

Sztuczny neuron przetwarza informacje wejściowe xi na pewien sygnał wyjściowy y. Neurony traktować można jako elementarne procesory o następujących właściwościach:

każdy neuron otrzymuje wiele sygnałów wejściowych i wyznacza na ich podstawie jeden sygnał wyjściowy,

z każdym oddzielnym wejściem neuronu związany jest parametr nazywany wagą,

sygnał wchodzący określonym wejściem jest najpierw przemnażany przez wagę danego wejścia, w związku z czym w dalszych obliczeniach uczestniczy już w formie zmodyfikowanej,

sygnały wejściowe (przemnożone przez odpowiednie wagi) są w neuronie sumowane, dając pewien pomocniczy sygnał wewnętrzny nazywany czasem łącznym pobudzeniem neuronu (w literaturze angielskiej net value),

do tak utworzonej sumy sygnałów dodaje niekiedy (nie we wszystkich typach sieci) dodatkowy składnik niezależny od sygnałów wejściowych, nazywany progiem (w literaturze angielskiej bias),

suma przemnożonych przez wagi sygnałów wewnętrznych z dodanym (ewentualnie) progiem może być bezpośrednio traktowana jako sygnał wyjściowy neuronu ( w sieciach o bogatszych możliwościach sygnał wyjściowy neuronu obliczany jest za pomocą zależności nieliniowej między łącznym pobudzeniem a sygnałem wyjściowym).

Każdy neuron dysponuje pewną wewnętrzną pamięcią (reprezentowaną przez aktualne wartości wag i progu) oraz pewnymi możliwościami przetwarzania wejściowych sygnałów w sygnał wyjściowy.

Proces uczenia neuronu sprowadza się do modyfikowania współczynników wagowych neuronu w taki sposób, by neuron działał zgodnie z oczekiwaniami użytkownika. W przykładzie tym wykorzystaliśmy uczenie z nauczycielem.

Uczenie z nauczycielem polega na tym, że neuronowi podaje się przykłady poprawnego działania, które powinien on potem naśladować w swoim bieżącym działaniu. Przykład należy rozumieć w ten sposób, że nauczyciel podaje konkretne sygnały wejściowe i wyjściowe, pokazując, jaka jest wymagana odpowiedź sieci dla pewnej konfiguracji danych wejściowych. W typowym procesie uczenia sieć otrzymuje od nauczyciela ciąg uczący i na jego podstawie uczy się prawidłowego działania, stosując jedną z wielu znanych dziś strategii uczenia

Najbardziej znaną z reguł uczenia z nauczycielem jest reguła delta.

Polega ona na tym, że każdy neuron po otrzymaniu na swoich wejściach określone sygnały (z wejść sieci albo od innych neuronów, stanowiących wcześniejsze warstwy sieci) wyznacza swój sygnał wyjściowy wykorzystując posiadaną wiedzę w postaci wcześniej ustalonych wartości wag, wartości wejść oraz (ewentualnie) progu. Wartość sygnału wyjściowego, wyznaczonego przez neuron na danym kroku procesu uczenia porównywana jest z odpowiedzią wzorcową podaną przez nauczyciela w ciągu uczącym. Jeśli występuje rozbieżność - neuron wyznacza różnicę pomiędzy swoim sygnałem wyjściowym a tą wartością sygnału, która była by - według nauczyciela prawidłowa. Ta różnica oznaczana jest zwykle symbolem greckiej litery δ (delta) i stąd nazwa opisywanej metody.

Sygnał błędu (delta) wykorzystywany jest przez neuron do korygowania swoich współczynników wagowych (i ewentualnie progu), stosując następujące reguły:

wagi zmieniane są tym silniej, im większy błąd został wykryty,

wagi związane z tymi wejściami, na których występowały duże wartości sygnałów wejściowych, zmieniane są bardziej, niż wagi wejść, na których sygnał wejściowy był niewielki.

W naszym przykładzie o zakończeniu procesu uczenia decyduje użytkownik. Proces uczenia może zostać uznany za zakończony gdy wyliczane po każdym kroku uczenia błędy są małe - powodują one minimalne korekty wag.

Program wczytuje dane z pliku zawierającego ciąg uczący (dane wejściowe i wzorcowe odpowiedzi) klasyfikuje obiekty, których dane są w tym pliku kolejno zapisane.

Podczas symulowanego uczenia użytkownik może śledzić w kolejnych krokach postęp uczenia, obserwując, jak zmieniają się współczynniki wag i błąd.

struktury danych algorytmu:

wyjscie - sygnał wyjściowy, odpowiedź neuronu dla zadanego sygnału wejściowego

wagi - wektor wag neuronu, modyfikowany w trakcie uczenia neuronu,

sygnaly - sygnały wejściowe; sygnały wczytywane są z pliku zewnętrznego - ciągu uczącego,

blad - wartość błędu wyliczana po każdej iteracji uczenia,

prawidlowe - wzorcowa prawidłowa wartość wyjścia (wczytywana z ciągu uczącego),

wspolczynnik - wartość współczynnika uczenia, ustalana przez użytkownika

-->Neuron ma 5 wejść, początkowe wartości współczynników wagowych są otrzymywane za pomocą generatora liczb pseudolosowych.[Author ID1: at Fri Sep 24 12:11:00 1999 ]

wyliczanie sygnału wyjściowego:

wyjscie := 0;

for i := 1 to 5 do

wyjscie := wyjscie + wagi[i] * sygnaly[i];

błąd po każdym kroku:

blad := prawidlowe - wyjscie;

modyfikacja wag, na podstawie wyliczonego błędu:

for i := 1 to 5 do

wagi[i] := wagi[i] + wspolczynnik * blad * sygnaly[i];

Testowanie neuronu polega na podawanie na jego wejścia określonych przez użytkownika sygnałów. Neuron wylicza dla tych wartości wejść sygnał wyjściowy.

Uczenie prostej sieci

Możliwe są dwa warianty procesu (strategii) uczenia sieci neuronowej: z nauczycielem i bez nauczyciela.

Uczenie z nauczycielem polega na tym, że sieci podaje się przykłady poprawnego działania które powinna ona potem naśladować w swoim bieżącym działaniu (w czasie egzaminu). Przykład należy rozumieć jako konkretnych sygnałów wejściowych i odpowiadających im sygnałów wyjściowe. W typowym procesie uczenia sieć otrzymuje od nauczyciela ciąg uczący i na jego podstawie uczy się prawidłowego działania.

Obok opisanego wyżej schematu uczenia z nauczycielem występuje też szereg metod tak zwanego uczenia bez nauczyciela (albo samouczenia sieci). Metody te polegają na podawaniu na wejście sieci wyłącznie szeregu przykładowych danych wejściowych, bez podawania informacji dotyczącej oczekiwanych sygnałów wyjściowych. Odpowiednio zaprojektowana sieć potrafi zinterpretować sygnały wejsciowe i zbudować na ich podstawie sensowny algorytm swojego działania - najczęściej polegający na tym, że automatycznie wykrywane są klasy powtarzających się sygnałów wejściowych i sieć uczy się (spontanicznie, bez jawnego nauczania) rozpoznawać te typowe wzorce sygnałów.

Uczenie może odbywać się zgodnie z jedną z wielu reguł uczenia. Do najbardziej znanych należą:

Reguła Hebba

W tej regule przyrost wag łączących węzeł [i] i węzeł [j] jest proporcjonalny do współczynnika uczenia, do wartości aktywacji wyjścia yj z neuronu [j] oraz agregacji wejść do neuronu [i], tj. xi.

![]()

Reguły należy do reguł uczenia bez nadzoru.

Reguła Delta

Jest to reguła uczenia z nauczycielem. Można zapisać ja w postaci:

![]()

Inne znane reguły uczenia to reguła LMS oraz reguła Widrow-Hoffa.

Przygotowany przez nas program wczytuje dane z pliku zawierającego ciąg uczący (dane wejściowe i wzorcowe odpowiedzi) klasyfikuje obiekty, których dane są w tym pliku kolejno zapisane.

Podczas symulowanego uczenia użytkownik może śledzić w kolejnych krokach postęp uczenia, obserwując, jak zmieniają się współczynniki wag i błąd .

Sieć składa się z 3 neuronów, z których każdy ma 5 wejść, początkowe wartości współczynników wagowych są otrzymywane za pomocą generatora liczb pseudolosowych.

struktury danych algorytmu:

wyjscie - wektor sygnałów wyjściowych,

wagi - tablica zawierająca wagi wszystkich neuronów,

sygnaly - wektor sygnałów wejściowych; sygnały wczytywane są z pliku zewnętrznego - ciągu uczącego,

blad - wektor wartość błędu wyjść sieci wyliczany po każdej iteracji uczenia,

prawidlowe - wzorcowa prawidłowa wartość wyjścia j (wczytywana z ciągu uczącego),

wspolczynnik - wartość współczynnika uczenia, ustalana przez użytkownika.

wyliczenie sygnałów wyjściowych:

for j := 1 to 3 do begin

wyjscie[j] := 0;

for i := 1 to 5 do

wyjscie[j] := wyjscie[j] + wagi[j, i] * sygnaly[i];

blad[j] := prawidlowe[j] - wyjscie[j];

end;

błąd po każdym kroku:

blad[j] := prawidlowe[j] - wyjscie[j];

modyfikacja wag, na podstawie wyliczonego błędu:

for i := 1 to 5 do

wagi[j, i] := wagi[j, i] + wspolczynnik * blad[j] * sygnaly[i];

Testowanie odbywa się poprzez podanie na wejścia sieci określonych przez użytkownika sygnałów.

Sieć neuronowa jako filtr sygnału z zakłóceniami

Kiedy sieć neuronowa ma dokładnie tyle samo neuronów wejściowych co wyjściowych oraz jej proces uczenia oraz pracy zasadza się na stanie przyporządkowania (odtworzenia) sygnałowi wejściowemu dokładnie określonego sygnału wyjściowego mamy wtedy do czynienia z siecią autoasocjacyjną (albo skojarzeniową). Sieci takie w swym zamyśle konstrukcyjnym nie mają za zadanie odtwarzać dokładnie sygnału wejściowego na wyjściu. Idea pracy takiej sieci polega na tym, że sieć po otrzymaniu na wejście sygnału podobnego do sygnału uczestniczącego w procesie uczenia odtworzy (skojarzy) na wyjściu wzorzec odpowiadający sygnałowi z fazy uczenia.

Podstawową zasadą uczenia jest to aby sieć trenowała swe „umiejętności” odtwarzanie wzorca (kilku - kilkunastu wzorców - to zależy od pojemności pamięciowej sieci, w przybliżeniu od ilości neuronów w warstwie ukrytej) podawanego na wejście w różnych odmianach (np. w różny sposób zakłóconego). Jeśli dane mają postać szeregu czasowego, to warianty otrzymuje się dla różnych opóźnień w czasie (kątów przesunięcia fazowego).

Jednym z istotnych zastosowań autoasocjacyjnej sieci neuronowej jest wykrywanie sygnału na tle szumu.

W naszym programie zaprezentujemy uczenie sieci filtrowania zadanego sygnału. Sygnał wprowadzany jest do programu przy pomocy pliku zawierającego trzy kolumny:

sygnał synchronizujący (można interpretować jako czas lub oś x na wykresie)

sygnał czysty, wzorcowy taki jaki sieć ma rozpoznawać z zaszumionego

sygnał zakłócony, stanowiący postawę uczenia sieci, jak i stanowiący postawę wstępnego testowania.

W przypadku gdy jesteśmy zadowoleni już z efektów działania naszej wytrenowanej sieci na wejście (zmiana pliku) można podać inaczej zakłócony sygnał wejściowy - dla testowania.

struktury danych dla algorytmu uczenia:

NRob - liczność zbioru uczącego, określana automatycznie na podstawie ilości elementów zapisanych w pliku ciągu uczącego

M - ilość wag w neuronie, w programie ustalona arbitralnie na 5, można to zmodyfikować poprzez ingerencję w dostarczony kod źródłowy programu prezentacyjnego,

WagiSieci - tablica określająca rozmiar sieci, ilość elementów sieci - neuronów o M. wagach wynosi NRob, liczebność tablicy to iloczyn M*NRob

WykArr - tablica z ciągami wzorcowym oraz zaszumionym (liczebność NRob*2)

aynok - stała określająca wektor ciągu uczącego w tablicy WayArr - wzorzec z zakłóceniami

ayok - stała określająca wektor ciągu uczącego w tablicy WayArr - wzorzec bez zakłóceń

Wspolczynnik - parametr określający szybkość uczenia neuronów, przed procesem uczenia użytkownik może

Randomize;

for J := 1 to NRob do

begin

for I := 1 to M do

WagiSieci[J, I] := -0.1 + 0.2 * Random;

if { uczenia ma uwzględniać wagę środkową } then

WagiSieci[J, Krok] := 1.0;

end;

for K := 1 to { ilość prezentacji ciągu uczącego} do

begin

for J := Krok - 1 TO (NRob - Krok) do

begin

Wyjscie := 0.0;

for I := 1 to M do

Wyjscie := Wyjscie+WagiSieci[J,I]*WykArr[J+I-Krok, aynok];

{ obliczenie błędu między wyjściem a wzorcem }

Blad := WykArr[J, ayok] - Wyjscie;

{ korekta wag }

for I := 1 to M do

WagiSieci[J, I] := WagiSieci[J,I]+ Wspolczynnik* Blad*WykArr[J+I-Krok, aynok];

end; {of J := ...}

end; {of K := ...}

Testowanie odbywa się poprzez podanie na wejście sieci sygnału zaszumionego. Uzyskuje się w ten sposób wykresy z nałożonym (opcjonalnie) sygnałem wzorcowym, sygnałem zakłóconym lub/i sygnałem przefiltrowanym.

Rozpoznawanie obrazu

Jak widać było we wcześniejszej części niniejszego opracowania dziedzina sieci neuronowych przeżywa wzloty i upadki. Niewątpliwie wielkim osiągnięciem w tej materii jest opracowanie mechanizmów definicji oraz konstrukcji wielowarstwowych sieci nieliniowych. Sieci takie posiadają wręcz nieograniczone możliwości przynajmniej jak na razie nie zostały one znalezione jak miało to miejsce dla sieci liniowych - publikacja Minsky'ego i Paperta. [11] Na pewno to opracowanie nie stanowiłoby przynajmniej próby ogarnięcia i zaprezentowania najistotniejszych zagadnień sieci neuronowych gdybyśmy nie pokusili się o przedstawienie uczenia i pracy takiej sieci.

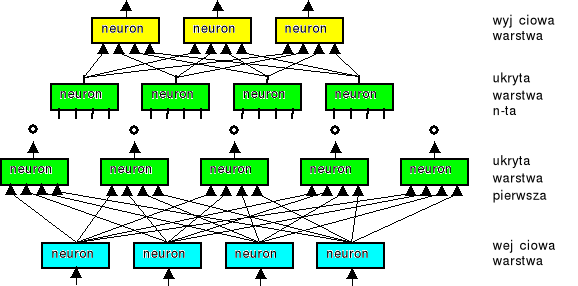

W przypadku konstrukcji wielowarstwowych sieci neuronowych korzysta się przeważanie z definicji nieliniowości neuronu określonej rozdziale Prezentacja neuronu tej pracy. Jeśli zaś chodzi o sferę związaną z topologią połączeń to wyróżnia się w takich układach następujące elementy:

warstwa wejściowa - zawiera ona tyle neuronów aby pokryć w pełni dziedzinę cech opracowywanego zjawiska czy obiektu; w większości przypadków warstwa ta nie będzie podlegać uczeniu; pełnić będzie rolę dyskryminacyjne oraz normalizacyjne dla sygnałów podlegających obróbce w dalszej strukturze sieci

warstwa ukryta - raczej powinno się tu mówić o warstwach ukrytych; one to stanowią o jakości sieci, jej potencjale pamięciowym, skomplikowaniu możliwego odwzorowania realizowanego przez sieć, o sposobie uczenia całej sieci; połączenie pomiędzy warstwami odbywają się na zasadzie wyjścia jednej warstwy stanowią wejścia następnej warstwy; uczeniu podlegają wszystkie neurony wchodzące w skład warstw ukrytych

warstwa wyjściowa - ma w zasadzie dwa zadania odebrać „odpowiedź” (przetworzony sygnał) warstw ukrytych oraz odpowiednio go przeskalować dla potrzeb danej realizacji; warstwa wyjściowa zwykle podlega uczeniu ale może być zmienione zgodnie z potrzebami konkretnej implementacji.

Rysunek poniższy w sposób obrazowy przedstawia jak modelowo konstruuje się wielowarstwowe sieci neuronowe:

Rys. 1. Model budowy wielowarstwowej sieci neuronowej

W programie przedstawiono aspekt uczenia i testowania po każdym kroku sieci neuronowej, wielowarstwowej z definicją nieliniowości pojedynczego neuronu daną wzorem:

![]()

gdzie net jest wartością dla neuronu (m) w warstwie (0..n+1):

dla warstwy wejściowej (0) - neuron posiada n1 - wag z doprowadzonymi sygnałami wejściowymi

:

![]()

dla warstw ukrytych (1..n); k - jest to ilość wag warstwy (j) a jednocześnie ilość neuronów w warstwie poprzedniej; y(i)(j-1) - odpowiedź i-tego neuronu warstwy (j-1)

![]()

dla warstwy wyjściowej mamy związek odpowiednio taki, jak dla warstw ukrytych

![]()

Sieć posiada dwa neurony warstwy wejściowej dwie warstwy ukryte o ilości elementów definiowanych przez użytkownika oraz jeden neuron wyjściowy. Taka konstrukcja posłuży nam do nauczenia sieci rozpoznawania obrazu dwuwymiarowego przedstawionego w postaci figur geometrycznych (kół) nakładanych na siebie.

struktury danych algorytmu:

LW - ogólna liczba warstw (ukryte plus dwie); jeśli w określeniu ilości neuronów w warstwach ukrytych podamy 0 to możemy otrzymać sieć wielowarstwową z warstwą wejściowa i wyjściową,

n - tablica z informacją ile elementów (neuronów) znajduje się w poszczególnych warstwach - tablica ta pełni funkcje sterująca dla ogólnej tablicy wag,

yy - tablica odpowiedzi poszczególnych neuronów w danym kroku dla wszystkich warstw,

Wagi - wielowymiarowa tablica wag całej sieci (trzy wymiarowa: warstwa, neuron, nr wagi w neuronie),

alfa - momentum - wpływ zmian w poprzednim kroku na zmiany w kroku bieżącym

eta - współczynnik uczenia

sigma - tablica pomocnicza pamiętająca propagację błędu w danym kroku

generacja wartości odpowiedzi sieci w bieżącym kroku:

for i := 1 to LW do

for k := 0 to n[i] - 1 do

begin

yy[i,k] := 0;

yy[i-1,n[i-1]] := -1;

for j := 0 to n[i-1] do

yy[i,k] := yy[i,k] + yy[i-1,j]*Wagi[i,j,k];

yy[i,k] := 1.0 / (1.0+Exp(-yy[i,k]));

end;

uczenie wielowarstwowej sieci neuronowej (backpropagation):

for i := LW downto 1 do

for j := 0 to n[i] - 1 do

begin

if i = LW then

blad := dd[j] - yy[i,j]

else

begin

blad := 0.0;

for k := 0 to n[i+1] - 1 do

blad := blad + sigma[i+1,k]*Wagi[i+1,j,k];

end;

sigma[i,j] := blad*yy[i,j]*(1-yy[i,j])

end;

Wagi2 := Wagi;

for i := 1 to LW do

for j:= 0 to n[i-1] do

for k := 0 to n[i] - 1 do

begin

zmiana := alfa*(Wagi[i,j,k]-Wagi1[i,j,k]);

zmiana := eta*sigma[i,k]*yy[i-1,j] - zmiana;

Wagi[i,j,k] := Wagi[i,j,k] + zmiana;

end;

Wagi1 := Wagi2;

Wielowarstwowe, nieliniowe sieci neuronowe stanowią obecnie jedną z najważniejszych dziedzin sfery określanej mianem Sztuczne sieci neuronowe.

Backpropagation - najpopularniejsza metoda uczenia liniowych sieci neuronowych

Algorytm wstecznej propagacji błędu (backpropagation) jest obecnie podstawowym (i jednym z najskuteczniejszych) algorytmem nadzorowanego uczenia wielowarstwowych jednokierunkowych sieci neuronowych.

Nazwa tego algorytmu wynika z kolejności obliczania sygnałów błędu δ, która przebiega w kierunku odwrotnym niż przechodzenie sygnałów przez sieć, to znaczy od warstwy wyjściowej poprzez warstwy ukryte w kierunku warstwy wejściowej.

Ogólnie algorytm propagacji wstecznej wymaga dla każdego wzorca uczącego wykonania następujących czynności:

Założenia: dana jest sieć o M warstwach, oraz zestaw danych uczących E = {E1, E2...EN}, gdzie każdy z przykładów składa się z wektora danych wejściowych X i z wektora wyjść D.

Przypisz wszystkim wagom wartości losowe bliskie 0. Wybierz wzorzec uczący EK.

Podaj wektor uczący EK na wejście sieci

Wyznacz wartości wyjść każdego elementu dla kolejnych warstw przetwarzania, od pierwszej warstwy ukrytej do warstwy wyjściowej

Oblicz wartość δMi błędów dla warstwy wyjściowej

δMi = f (xil-1 (t)) [di - yiM(t)]

Wyznacz kolejno błędy w warstwach l = M., M.-1, ...2 według postępowania

δl-1i (t) = f (xil-1 (t) ) Σi wlji (t) δli (t)

Wyznacz zmianę wartości wag

Δwlij (t) = γ δli (t) xil-1 (t)

Modyfikuj wszystkie wagi

wlji (t+1) = wlji (t) + Δwlij (t)

Wybierz kolejny wzorzec (o ile istnieje) i przejdź do punktu 2 (wczytanie wzorca)

W trakcie uczenia sieci można zaprezentować dowolną liczbę wzorców uczących. Jeśli sieć ma pracować z danymi zakłóconymi to część wektorów uczących powinna również zawierać zakłócenie. Jest to związane ze zdolnością sieci do uogólniania - niewielkie zaburzenie sygnałów wzorcowych może spowodować przyspieszenie zbieżności procesu uczenia ( choć sygnał zaburzony nigdy może się nie pojawić w rzeczywistej pracy sieci ).

Inne zasady obowiązujące przy konstruowaniu ciągów uczących zostały przedstawione w punkcie Projektowanie zbioru uczącego.

Pierwszą operacją w procesie uczeni jest inicjalizacja początkowego układu wag. Należy unikać symetrii w warstwach wag początkowych (mogłoby to spowodować nie nauczenie się sieci ). Najskuteczniejszym rozwiązaniem wydaje się być losowy wybór wag początkowych.

Istotnym problemem jest wybór współczynnika uczenia η. Parametr ten decyduje o szybkości i stabilności procesu uczenia. Przy zbyt małej wielkości tego współczynnika uczenie postępuje w bardzo wolnym tempie, i sieć potrzebuje b. dużej liczby operacji, by się nauczyć. W przypadku zbyt dużej wartości tego współczynnika algorytm może stać się niestabilny.

Wartość współczynnika η dobiera się zazwyczaj z przedziału [0.05 , 0.25].

obliczenia przejścia sygnału w sieci - struktury danych algorytmu:

iKrok - zmienna kontrolna programu - pokazująca, na którym kroku jest sieć

RN1, RN2, RN3, RN4 - obiekty typu neuron, przy czym RN1 i RN2 stanowią warstwę ukrytą, RN3 i RN4 - warstwę wyjściową.

begin

if (iKrok1 < 1) or (iKrok1 > 5) then

iKrok1 := 1;

case iKrok1 of

1: begin

Tytul1(`OBLICZENIE SUMY ILOCZYNÓW SYGNAŁÓW

WEJŚCIOWYCH ORAZ',0);

Tytul1(`WAG WARSTWY UKRYTEJ',1);

RN1.Krok1(We1.Value,We2.Value,Bias.Value);

RN2.Krok1(We1.Value,We2.Value,Bias.Value);

{przerysowanie ekranu, uwzględnienie zmian}

end;

2: begin

Tytul1(`OBLICZENIE ODPOWIEDZI NEURONÓW WARSTWY

UKRYTEJ',0);

Tytul1(`',1);

RN1.Krok2;

RN2.Krok2;

end;

3: begin

Tytul1(`OBLICZENIE SUMY ILOCZYNÓW WYJŚĆ

WARSTWY UKRYTEJ ORAZ',0);

Tytul1(`WAG WARSTWY WYJŚCIOWEJ',1);

RN3.Krok1(RN1.Odp.Value,RN2.Odp.Value,

Bias.Value);

RN4.Krok1(RN1.Odp.Value,RN2.Odp.Value,

Bias.Value);

{przerysowanie ekranu, uwzględnienie zmian}

end;

4: begin

Tytul1(`OBLICZENIE ODPOWIEDZI NEURONÓW WARSTWY

WYJŚCIOWEJ',0);

Tytul1(`',1);

RN3.Krok2;

RN4.Krok2;

end;

5: begin

Czysc;

Tytul1(`PARAMETRY SIEĆ NEURONOWEJ ZOSTAŁY

OKREŚLONE',0)

end;

end;

{przerysowanie ekranu - uwzględnienie zmian}

Inc(iKrok1);

end;

Procedury wywoływane w algorytmie głównym:

procedure TRN.Krok2;

begin

Odp.Value := 1.0/(1.0+exp(-SumWe.Value));

Odp.Text := FloatToStrF(Odp.Value,ffFixed,18,4);

end;

procedure TRN.Krok1(x1,x2,x3: Extended);

begin

Wej[1] := x1;

Wej[2] := x2;

Wej[3] := x3;

SumWe.Value := W[1].Value*x1 + W[2].Value*x2 + W[3].Value*x3;

SumWe.Text := FloatToStrF(SumWe.Value,ffFixed,18,4);

end;

uczenie sieci - struktury danych algorytmu:

RN21, RN22, RN23, RN24, RN25, RN26 - obiekty typu neuron, przy czym RN21 i RN22 stanowią warstwę wejściową, RN23 i RN24 - warstwę ukrytą, RN25 i RN26 - warstwę wyjściową.

Wyznaczenie błędów dla warstwy wyjściowej

begin

Tytul2('SIEĆ WYZNACZA BŁĘDY NEURONÓW WARSTWY

WYJŚCIOWEJ');

RN21.SetEtaAlfa(eta.Value,alfa.Value);

RN22.SetEtaAlfa(eta.Value,alfa.Value);

RN23.SetEtaAlfa(eta.Value,alfa.Value);

RN24.SetEtaAlfa(eta.Value,alfa.Value);

RN25.SetEtaAlfa(eta.Value,alfa.Value);

RN26.SetEtaAlfa(eta.Value,alfa.Value);

RN25.SetBlad(z1.Value);

RN26.SetBlad(z2.Value);

end;

Wsteczne rzutowanie błędu

begin

Tytul2('SIEĆ RZUTUJE WSTECZNIE BŁĘDY DO WARSTW

UKRYTYCH');

{ wylicznie sigmy dla neuronu }

RN25.ClcSigma;

RN26.ClcSigma;

{ proagacja wsteczna błędu }

RN23.ClcBladBP(RN25,RN26,1);

RN24.ClcBladBP(RN25,RN26,2);

RN23.PokazBlad(True);

RN24.PokazBlad(True);

{ wylicznie sigmy dla neuronu }

RN23.ClcSigma;

RN24.ClcSigma;

end;

Modyfikacja wag :

begin

Tytul2('SIEĆ USTALA NOWE WARTOŚCI

WSPÓŁCZYNNIKÓW WAG NEURONÓW');

RN23.ObliczNoweWagi(alfa.Value,eta.Value);

RN23.PokazNoweWagi(True);

RN24.ObliczNoweWagi(alfa.Value,eta.Value);

RN24.PokazNoweWagi(True);

RN25.ObliczNoweWagi(alfa.Value,eta.Value);

RN25.PokazNoweWagi(True);

RN26.ObliczNoweWagi(alfa.Value,eta.Value);

RN26.PokazNoweWagi(True);

end;

Kluczowe procedury wywoływane w algorytmie głównym:

procedure TRN.ObliczNoweWagi(pAlfa,pEta: Extended);

var

zm,W2: Extended;

i: integer;

begin

for i := 1 to 3 do begin

W2 := W[i].Value;

zm := pAlfa * (W[i].Value-W1[i]);

zm := pEta * Sigma*Wej[i] - zm;

WNew[i].Value := W[i].Value + zm;

W1[i] := W2;

end;

end;

procedure TRN.ClcSigma;

begin

Sigma := Blad.Value * Odp.Value * (1.0 - Odp.Value);

{ funckcja odwrotna dla funkcji aktywacji neurony }

end;

procedure TRN.ClcBladBP(pRN1,pRN2: TRN; nrWagi: integer);

begin

Blad.Value := pRN1.Sigma*pRN1.W[nrWagi].Value +

pRN2.Sigma*pRN2.W[nrWagi].Value;

end;

procedure TRN.SetBlad(pZadana: extended);

begin

Blad.Value := Odp.Value - pZadana;

PokazBlad(True);

end;

Sieć Kohonena

Sieci samoorganizujące w procesie ucznia spontanicznie tworzą odwzorowanie (ang. mapping) zbioru sygnałów wejściowych na zbiór sygnałów wyjściowych. Cechy jakimi musi charakteryzować się sieć samoorganizująca oraz proces uczenia, to koherentność i kolektywność.

Koherentności jest to efekt grupowania danych wejściowych w klasy podobieństwa. Grupowanie w klasy podobieństwa opisywane jest przez zestaw technik matematycznych (w większości przypadków statystycznych) zwanych analizą skupień (ang. cluster analysis). Wśród technik analizy skupień na uwagę szczególnie zasługują mechanizmy kwantyzacji wektorowej.

Kolektywność jest to efekt, który zachodzi w sieciach samoorganizujących. Główne cechy tego mechanizmu to, to że co rozpoznaje jeden neuron, w dużej mierze zależy także od tego co rozpoznają inne neurony. Ten efekt związany jest z pojęciem sąsiedztwa.

Ogólna zasada uczenia sieci Kohonena opiera się na następujących założeniach:

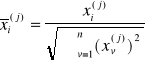

wektor sygnałów wejściowych X jest przed procesem uczenia normalizowany ||X|| = 1, co można zapisać jako

wszystkie neurony sieci dostają ten sam zestaw sygnałów wejściowych

wyliczana jest odpowiedź dla wszystkich neuronów

proces modyfikacji wag następuje w neuronie który zwyciężył w rywalizacji - posiada największą wartość odpowiedzi

wyliczanie nowej wartości wag dla neuronu który zwyciężył następuje według poniższego przepisu:

![]()

gdzie:

h(m,m*) - jest funkcją określającą sąsiedztwo

η(j) - określa współczynnik uczenia dla (j)-tego kroku

Sąsiedztwo jest to metoda, która pozwala na redukcję niepożądanych skutków uczenia sieci samoorganizujących w oparciu o konkurencje. Konkurencja w procesie uczenia może doprowadzić do sytuacji takiej, że tylko niewielki odsetek neuronów uzyska możliwość rozpoznawania obiektów pokazywanych sieci (nauczy się). Reszta neuronów nie będzie w trakcie uczenia zmieniać swoich wag i w ten sposób zatraci na zawsze swe użytkowe cech jako elementy wytrenowanej sieci neuronowej. Sąsiedztwo jest miarą w jakim stopniu sąsiad neuronu zwycięskiego będzie miał zmieniane wagi w danym kroku procesu uczenia. Zwykle wartość tego parametru jest określana na wartość 0 - 1.

Sąsiedztwo rozpatruje się w układach:

jednowymiarowych, neurony sąsiednie leżą na jednej linii,

dwuwymiarowych, neurony są ułożone w warstwie a sąsiadami są neurony położone na lewo i na prawo oraz u góry i u dołu rozpatrywanego neuronu, inny przypadek opisuje dodatkowe kontakty po przekątnych

wielowymiarowe, neurony ułożone są swobodnie w przestrzeniach wielowymiarowych a twórca danej sieci określa zasady sąsiedztwa.

Do najbardziej istotnych i użytecznych układów sąsiedztwa zaliczamy organizacje jedno- i dwuwymiarowe, dla nich właśnie dodatkowym istotnym parametrem jest określenie ile neuronów obok (sąsiadów z lewej, prawej itd.) ma podlegać uczeniu w przypadku zwycięstwa danego neuronu.

Po raz pierwszy opracowania na temat sieci samoorganizujących z konkurencją i sąsiedztwem pojawiły się w latach 70-tych za przyczyną opisów eksperymentów fińskiego badacza Kohonena. Stąd też tego typu sieci wraz z metodami uczenia nazywamy sieciami Kohonena. [13,14,15]

W naszym programie przedstawiamy przykład procesu uczenia sieci Kohonena rozpoznawania zadanej przez użytkownika figury geometrycznej. Po każdorazowym cyklu prezentacji określonej ilości losowych punktów następuje automatyczny test skuteczności sieci w rozpoznawaniu danej figury.

struktury danych algorytmu:

alfa0, alfa1 - parametry określające szybkość procesu uczenia sieci (parametr modyfikacji wag w kolejnych krokach uczenia);

epsAlfa - określa o ile ma się zmieniać wartość alfa0 oraz alfa1 w kolejnych krokach uczenia (po każdej prezentacji);

sąsiedztwo - parametr określający ile neuronów na się uczyć wraz z neuronem zwycięskim;

epsSasiedztwo - określa o ile ma się zmieniać wartość „sąsiedztwo” w kolejnych krokach uczenia (po każdej prezentacji);

m, n - rozmiar sieci (sieć ma konstrukcję obszaru o długości m na n neuronów);

MaxI - ilość prezentacji w epoce uczenia;

uczenie sieci Kohonene:

iInc := 1;

while iInc < MaxI do

begin

x := 5.0 - 10.0*Random;

y := 5.0 - 10.0*Random;

{ PokazPunkt - i dobry i zły }

if not „punkt należy do obszaru figury” then

continue

else

begin { uczenie dla dobrego punktu }

OdlMin := 10000.0;

imin := 1; jmin := 1;

{ obliczanie maksymalnej odpowiedzi sieci }

for i := 1 to m do

for j := 1 to n do

begin

odl := sqrt(sqr(w[i,j,0]-x) + sqr(w[i,j,1]-y));

if odl >= OdlMin then

continue;

OdlMin := odl; imin := i; jmin := j;

end;

{ ustawianie wag zwycięskiego neuronu oraz wag jego sąsiadów - parametr sąsiedztwo}

s := sasiedztwo;

for i := imin-s to imin+s do

for j := jmin-s to jmin+s do

begin

odl := Max(Abs(i-imin),Abs(j-jmin));

{ obliczenie parametru modyfikacji wag )

alfa := (alfa0*(s-odl) + alfa1*odl)/s

w[i,j,0] := w[i,j,0] + alfa*(x-w[i,j,0]);

w[i,j,1] := w[i,j,1] + alfa*(y-w[i,j,1]);

end;

{ zmiana parametrów uczenia }

alfa0 := alfa0*epsAlfa;

alfa1 := alfa1*epsAlfa;

sasiedztwo := (sasiedztwo-1.0)*epsSasiedztwo + 1.0;

Inc(iInc);

end; { koniec pętli uczącej }

Samouczenie sieci neuronowej

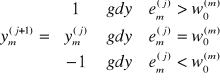

W przypadku gdy sieć nie może być uczona pod nadzorem nauczyciela poczytne miejsce zajmują strategie uczenia oparte na idei wprowadzonej do dziedziny neuropsychologii przez amerykańskiego badacza D.O. Hebba w 1949 roku. [16] Jednak ta idea znaczenia dla dziedziny sieci neuronowych zaistniała naprawdę w 1981 roku kiedy to inny badacz Sutton opracował formalne metody wykorzystania jej w uczeniu sieci neuronowych. Opracowana technika uczenia zwykle nazywana jest uczeniem Hebba lub uczeniem bez nauczyciela (ang. unsupervised lerning albo hebbian learning). Zasada tego uczenia polega na tym, że waga ![]()

i-tego wejścia m-tego neuronu wzrasta podczas prezentacji j-tego wektora wejściowego ![]()

proporcjonalnie do iloczynu i-tej składowej sygnału wejściowego ![]()

docierającego do rozważanej synapsy i sygnału wyjściowego ![]()

rozważanego neuronu. Opis formalny tego w postaci wzoru wygląda następująco:

![]()

przy czym oczywiście

![]()

Indeksy górne przy wagach neuronu ![]()

z jednej strony określają numerację neuronów, do którego wagi należą (m) z drugiej zaś numerację kroków określających kolejne pokazy.

Jeśli pokusić się o intuicyjną interpretację samouczenia sieci to można to określić jako stwierdzenie: „wzmocnieniu ulegają w niej te wagi, które są aktywne (duże ![]()

) w sytuacji, gdy „ich” neuron jest pobudzony (duże ![]()

)”. Tego też wynika, że sieci uczona taką strategią należy do klasy sieci autoasocjacyjnych.

Stosując prawa Hebba jako regułę uczenia uzyskuje się takie dopasowanie wag aby korelacja pomiędzy sygnałem wejściowym a zapamiętanym w formie wag wzorcem sygnału, na który dany neuron ma reagować. Stąd nazwa klasy takich strategii uczenia określana mianem uczenie korelacyjne (ang. correlation learning).

Sieć swoje działanie opiera na grupowaniu sygnałów wejściowych w klasy podobieństwa (ang. cluster) w trakcie procesu uczenia, by następnie nadchodzące sygnały klasyfikować pod względem podobieństwa do określonej klasy (dany neuron - reprezentant klasy - posiada największą wartość wyjscia).

Nasz program zawiera przykład, który obrazuje uczenie sieci neuronowej oparte o strategię reguł Hebba. Pozwala on w sposób krokowy bądź ciągły (cykle prezentacji sygnału wejściowego) obserwować zmiany wartości wag dwuwejściowych neuronów rzutowane na płaszczyznę.

struktury danych algorytmu:

LN - liczna neuronów w sieci

eta - współczynnik uczenia

lPokaz - liczba pokazów sygnału uczącego wykonanych w danej ćwiartce układu współrzędnych

lNeuron - liczba neuronów które w bieżącym kroku znajdują się w danej ćwiartce układu współrzędnych

cbxCiasno - przełącznik czy wagi początkowe mają być losowane z przedziału [-2,2] czy [-10,10] wokół losowego punktu startowego

wagi - tablica wag rozmiar tablicy jest ustalany przez wartość zmiennej LN, neurony posiadają po dwa wejścia więc wagi na neuron jest dwie

cbxLosowe - przełącznik czy ćwiartka układu współrzędnych do prezentacji ma być losowana czy zadana arbitralnie

sygnaly - wektor zawierający współrzędne punktu (sygnału) uczącego sieć

pobudzenie - tablica odpowiedzi neuronów w danym kroku przy ustalonej tablicy wag oraz zadanym sygnale uczącym

{ ile neuronów będzie uczestniczyć w pokazie }

LN := Trunc(enLiczbaNeuronow.Value);

{ ustalenie początkowej wartości współczynnika uczenia }

eta := 0.1;

{ wyczyszczenie informacji o położeniu neuronów w odpowiednich ćwiartkach układu współrzędnych }

for i := 1 to 4 do begin

lPokaz[i] := 0; lNeuron[i] := 0;

end;

for i := 1 to LN do

moc[i] := 0.0;

{ początkowe wartości wag ułożone wokół punktu startowego (x,y) }

Randomize;

x := 16.0*Random-8.0;

y := 16.0*Random-8.0;

for i := 1 to LN do

if not cbxCiasno then begin

wagi[i,1] := 20.0*Random-10.0;

wagi[i,2] := 20.0*Random-10.0;

moc[i] := sqr(wagi[i,1]) + sqr(wagi[i,2]);

end

else begin

wagi[i,1] := x-2.0*Random;

wagi[i,2] := y-2.0*Random;

moc[i] := sqr(wagi[i,1]) + sqr(wagi[i,2]);

end;

{ główna pętla losowania punktu uczącego, modyfikacji wag oraz wizualizacji tego procesu na ekranie }s

while True do

begin

{ wyczyszczenie obrazka }

.....

{ rysunek sieci }

for i := 1 to LN do begin

ix := pbrAuto.XRToPoint(wagi[i,1]);

iy := pbrAuto.YRToPoint(wagi[i,2]);

pbrAuto.Canvas.Polygon([Point(ix-2,iy-2),Point(ix+2,iy-2),Point(ix+2,iy+2),Point(ix-2,iy+2)]);

end;

{ losowanie ćwiartki lub wskazanie arbitralne przez użytkownika oraz wylosowanie punktu jako sygnału uczącego }

.....

{ zliczanie liczby pokazow }

.....

{ rysunek sygnału uczącego }

.....

{ wyliczenie pobudzenia neuronów przez wyznaczone sygnały }

.....

{ określenie maksymalnego pobudzenia }

max := 0.0;

for i := 1 to LN do begin

pobudzenie[i] := wagi[i,1]*sygnaly[1] + wagi[i,2]*sygnaly[2];

pobudzenie[i] := 4.0*pobudzenie[i]/moc[i];

if pobudzenie[i] > max then

max := pobudzenie[i];

end;

{ zerowanie liczników neuronów dla odpowiednich ćwiartek układu współrzędnych }

for i := 1 to 4 do lNeuron[i] := 0;

{ samouczenie sieci w oparciu o wyznaczone parametry pobudzenia }

for i := 1 to LN do begin

{ zapamiętanie starych wartości wag }

wagiOld[i,1] := wagi[i,1];

wagiOld[i,2] := wagi[i,2];

if pobudzenie[i] < 0.2 * max then pobudzenie[i] := 0.3 * pobudzenie[i];

if pobudzenie[i] < 0.0 then pobudzenie[i] := 0.1 * pobudzenie[i];

wagi[i,1] := wagi[i,1] + eta * pobudzenie[i] * (sygnaly[1]-wagi[i,1]);

wagi[i,2] := wagi[i,2] + eta * pobudzenie[i] * (sygnaly[2]-wagi[i,2]);

moc[i] := moc[i] + Sqr(wagi[i,1]) + Sqr(wagi[i,2]);

end;

{ zliczanie liczby neuronów w odpowiednich ćwiartkach }

.....

{ opisanie legendy uczenia w danym kroku }

WypiszLiczbyPN;

{ zerowanie liczników neuronów dla odpowiednich ćwiartek układu współrzędnych }

for i := 1 to 4 do lNeuron[i] := 0;

{ rysunek nowych wartości wag oraz obrazowanie zmiany }

.....

{ rysunek zmiany }

.....

{ rysunek starych pozycji w kolorach Czerwonym - pobudzany i Niebieskim - pobudzany przeciwnie }

.....

{ zliczanie liczby neuronów w odpowiednich ćwiartkach }

.....

{ opisanie legendy uczenia w danym kroku }

WypiszLiczbyPN;

{ zmniejszenie współczynnika uczenia }

eta := eta * 0.99;

end;

Sieć Hopfielda

Sieci Hopfielda są najczęściej stosowaną podklasą sieci neuronowych wykorzystywanych w praktyce. Zostały one zdefiniowane w historycznej pracy tego badacza, której publikacja w 1982 roku stała się punktem zwrotnym w badaniach sieci neuronowych i przywróciła zainteresowanie tymi systemami sferze dociekań naukowych. Sieci te charakteryzują się występowaniem sprzężeń zwrotnych. Wszystkie połączenia, które w tej sieci występują są sprzężeniami zwrotnymi, wszystkie sygnały wyjściowe są wykorzystywane jako wejścia i wszystkie wejścia do wszystkich neuronów przenoszą sygnały sprzężenia zwrotnego. W sieciach tych neurony mają nieliniowe charakterystyki:

![]()

gdzie

![]()

a nieliniowość ![]()

dana jest prostą binarną funkcją

Warto przy tym zwrócić uwagę na dwa szczegóły podanych wyżej wzorów. Otóż po pierwsze, współczynniki wagowe ![]()

łączące wyjście i-tego neuronu z wejściem m-tego neuronu nie zależą od j. Wynika to z faktu, że rozważając sieć Hopfielda na tym etapie nie dyskutujemy jej uczenia. Zakładamy, że wartości ![]()

zostały wcześniej ustalone za pomocą jakiegoś algorytmu ( najczęściej przyjmuje się tu algorytm Hebba) i obecnie nie podlegają zmianom. Numer j oznacza natomiast chwilę czasową, określającą w jakim momencie procesu dynamicznego następującego pop pobudzeniu sieci obecnie się znajdujemy. Zagadnienie to będzie niżej dokładnie dyskutowane. Po drugie sumowanie sygnałów wyjściowych ![]()

z poszczególnych neuronów w wzorze definiującym łączne pobudzenie ![]()

odbywa się po wszystkich elementach ![]()

czyli po wszystkich elementach sieci. Oznacza to, że w sieci przewidziane są także połączenia z warstw dalej położonych (wyjściowych) do warstw wcześniejszych - czyli sprzężenie zwrotne.

Jak było to wcześniej odnotowane, sieć o takim schemacie połączeń nazywana jest siecią autoasocjacyjną. W ramach tego sprzężenia każdy neuron jest także połączony jednym z wejść ze swoim własnym wyjściem, zatem zasada autoasocjacyjności odnosi się także do pojedynczych neuronów. Każdy neuron sieci ma także kontakt z pewnym, odpowiadającym mu sygnałem wejściowym ![]()

, zatem zaciera się tu podział na warstwę wejściową i pozostałe warstwy sieci.

Procesy zachodzące w sieciach Hopfielda są zawsze stabilne. Stabilność procesów w sieci Hopfielda osiągnięto dzięki:

wprowadzeniu bardzo regularnej struktury wewnętrzną sieci - w całej sieci neurony są łączone na zasadzie "każdy z każdym";

zabronione są sprzężenia zwrotne obejmujących pojedynczy neuron.

wprowadzane współczynniki wagowe muszą być symetryczne - to znaczy jeśli połączenie od neuronu o numerze x do neuronu o numerze y charakteryzuje się pewnym współczynnikiem wagi w, to dokładnie taką samą wartość w ma współczynnik wagowy połączenia biegnącego od neuronu o numerze y do neuronu o numerze x.

Z siecią Hopfielda kojarzy się tzw. „funkcje energii” (nazwa ta ma charakter czysto umowny - nie jest związana z rzeczywistą energią), zwaną też funkcją Lapunowa. Funkcja ta opisuje zbiór stanów sieci Hopfielda, zdefiniowanych przez zbiór wartości wyjść elementów przetwarzających tejże sieci. Można udowodnić, ze funkcja taka, dla sieci Hopfielda w skończonej ilości kroków osiągnie swoje minimum lokalne oraz że jest to funkcja nierosnąca w czasie - co jest równoznaczne ze stwierdzeniem, że procesy zachodzące w sieci Hopfielda są procesami stabilnymi.

Łatwość budowy i stosowania sieci Hopfielda powoduje, że są one bardzo popularne. Znajdują one liczne zastosowania - między innymi przy rozwiązywaniu zadań optymalizacji, a także przy generacji określonych sekwencji sygnałów, następujących po sobie w pewnej kolejności. Pozwala to za pomocą takich sieci tworzyć i wysyłać do różnych obiektów sygnały sterujące. Sieci Hopfielda mogą także pracować jako tzw. pamięci autoasocjacyjne.

Koncepcja pamięci autoasocjacyjnej wiąże się z jedną z podstawowych funkcji mózgu - z odtwarzaniem całości informacji na podstawie informacji niepełnej. Jest to zdolność sieci do prawidłowego zinterpretowania danych zniekształconych lub niekompletnych. Sieć pracująca jako pamięć autoasocjacyjna może także usuwać zakłócenia i zniekształcenia różnych sygnałów - także wtedy, gdy stopień „zaszumienia” sygnału wejściowego wyklucza praktyczne użycie jakichkolwiek innych metod filtracji.

struktury danych algorytmu:

Wagi - wektor wag neuronów w sieci

Wzorzec - wektor wzorców rozpoznawanych przez sieć

rozM - rozmiar sieci - poziomo (domyślnie 25)

rozN rozmiar sieci - pionowo (domyślnie 25)

nMax - ilość neuronów w sieci

Użyta w programie procedura TabNaWzorzec przepisuje do wzorca wartość elementy tymczasowego, procedura WzorzecNaTab działa dokładnie odwrotnie.

for k := 1 to 16 do

if tZrB[k] then begin

Inc(nElem);

if nrWzorca = k then nrWz := nElem;

TabNaWzorzec(tZr[k],Wzorzec[nElem]);

end;

if nrWz = 0 then

Exit;