STATYSTYKA OPISOWA

- to dział statystyki zajmujący się metodami opisu danych

statystycznych uzyskanych podczas badania statystycznego. Celem stosowania metod statystyki

opisowej jest podsumowanie zbioru danych i wyciągnięcie pewnych podstawowych wniosków i

uogólnień na temat zbioru.

Statystykę opisową stosuje się zazwyczaj jako pierwszy i podstawowy krok w analizie

zebranych danych.

Do technik statystyki opisowej można zaliczyć:

1. Opis tabelaryczny

Dane przedstawiane są w postaci tabel. Dla małych zbiorów danych tabele mogą prezentować

wszystkie dane, w przeciwnym przypadku tworzy się różnego rodzaju podsumowania, jak np.

szereg rozdzielczy.

Szereg rozdzielczy - Uzyskuje się go dzieląc dane statystyczne na pewne kategorie i podając

liczebność lub częstość zbiorów danych przypadających na każdą z tych kategorii.

Jeśli cecha ma charakter ciągły, wtedy przedział wartości cechy dzieli się na przedziały

klasowe. Liczba i rozpiętości przedziałów powinny być tak dobrane, aby dawały przejrzysty obraz

rozkładu. Na ogół przyjmuje się, że liczba przedziałów powinna być większa od 5 i mniejsza od 20.

Jeśli cecha ma charakter skokowy, ale liczba możliwych wartości jest bardzo duża, wtedy

można postąpić podobnie jak w przypadku cechy o charakterze ciągłym.

2. Graficzna prezentacja wyników

Dane prezentowane są w formie graficznej. Podstawowymi narzędziami są tutaj: histogram,

wielobok liczebności i krzywa liczebności, które wykreślane są bezpośrednio na podstawie danych z

szeregu rozdzielczego; wykres pudełkowy, przedstawiający zależności pomiędzy niektórymi

statystykami pozycyjnymi; krzywa Lorenza charakteryzująca koncentrację wartości cechy.

Histogram to jeden z graficznych sposobów przedstawiania rozkładu empirycznego cechy.

Składa się z szeregu prostokątów umieszczonych na osi współrzędnych.

3. Wyznaczanie miar rozkładu

Do opisu służą miary rozkładu - różnego rodzaju wielkości obliczane na podstawie uzyskanych

danych. Interpretacja wartości tych miar dostarcza informacji na temat charakteru rozkładu cechy.

Miary można podzielić na kilka podstawowych kategorii:

miary położenia, np. kwantyl

w tym miary tendencji centralnej:

np. średnia arytmetyczna, średnia geometryczna, średnia harmoniczna, średnia

kwadratowa, mediana, moda

miary zróżnicowania

np. odchylenie standardowe, wariancja, rozstęp, rozstęp ćwiartkowy, średnie odchylenie

bezwzględne, odchylenie ćwiartkowe, współczynnik zmienności

miary asymetrii

np. współczynnik skośności, współczynnik asymetrii, trzeci moment centralny

miary koncentracji

np. współczynnik Giniego, kurtoza

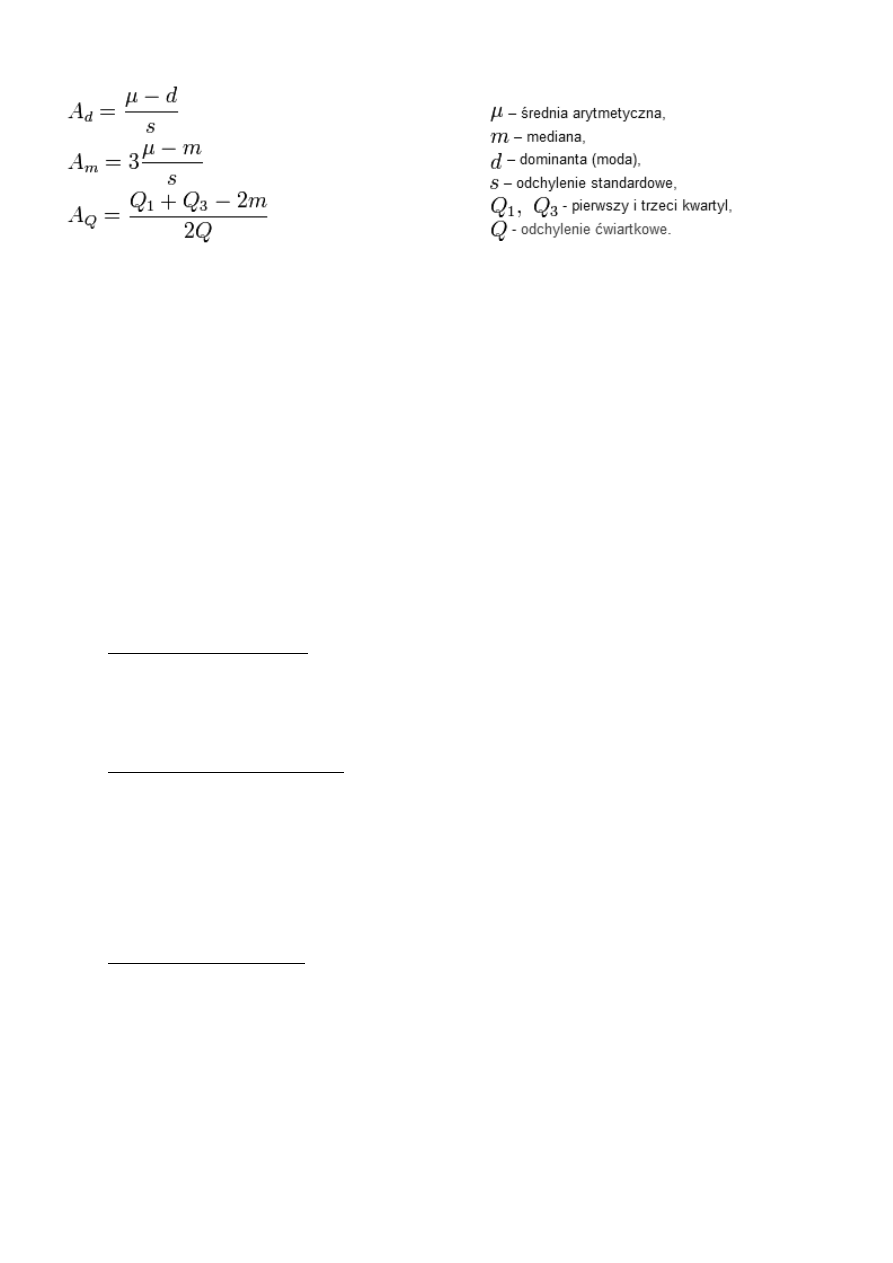

Asymetria rozkładu:

Współczynnik skośności przyjmuje wartość zero dla rozkładu symetrycznego, wartości

ujemne dla rozkładów o lewostronnej asymetrii (wydłużone lewe ramię rozkładu) i wartości

dodatnie dla rozkładów o prawostronnej asymetrii (wydłużone prawe ramię rozkładu).Nie ma

gwarancji, że powyższe wzory będą miały ten sam znak.

Jeśli funkcja gęstości prawdopodobieństwa (dla rozkładów ciągłych) lub funkcja masy

prawdopodobieństwa (dla rozkładów dyskretnych) po prawej stronie swojego maksimum (mody)

maleje wolniej niż po lewej stronie (rozkład ma "prawy ogon dłuższy"), to rozkład nazywamy

prawostronnie skośnym, dodatnio skośnym, prawostronnie asymetrycznym lub o prawostronnej

asymetrii. Rozkład taki ma wartość oczekiwaną (średnią) większą od mediany.

Miara rozkładu jest to liczbowa charakterystyka rozkładu cechy, dostarczająca informacji na temat

właściwości tego rozkładu.

Taką charakterystykę określa się w zależności od przedmiotu badania statystycznego jako:

parametr - jeśli analizowane są dane z pełnej populacji

statystykę - jeśli przedmiotem badania są dane z próby losowej

Miary rozkładu można podzielić na:

Miary położenia rozkładu, np.:

o

o

o

o

Miary zróżnicowania rozkładu, np.:

o

o

o

średnie odchylenie bezwzględne

o

o

o

o

ANALIZA REGRESJI

Regresja − metoda statystyczna pozwalająca na badanie związku pomiędzy wielkościami danych i

przewidywanie na tej podstawie nieznanych wartości jednych wielkości na podstawie znanych

wartości innych.

Formalnie regresja to dowolna metoda statystyczna pozwalającą estymować warunkową

wartość oczekiwaną zmiennej losowej, zwanej zmienną objaśnianą, dla zadanych wartości innej

zmiennej lub wektora zmiennych losowych (tzw. zmiennych objaśniających).

Estymacja to dział wnioskowania statystycznego będący zbiorem metod pozwalających na

uogólnianie wyników badania próby losowej na nieznaną postać i parametry rozkładu zmiennej

losowej całej populacji oraz szacowanie błędów wynikających z tego uogólnienia. Wyrażenie

nieznana postać jest kluczem do odróżnienia estymacji od drugiego działu wnioskowania

statystycznego, jakim jest weryfikacja hipotez statystycznych, w którym najpierw stawiamy

przypuszczenia na temat rozkładu, a następnie sprawdzamy ich poprawność.

Użycie regresji w praktyce sprowadza się do dwóch faz:

konstruowanie modelu - budowa tzw. modelu regresyjnego, czyli funkcji opisującej, jak

zależy wartość oczekiwana zmiennej objaśnianej od zmiennych objaśniających. Funkcja ta

może być zadana nie tylko czystym wzorem matematycznym, ale także całym algorytmem,

np. w postaci drzewa regresyjnego, sieci neuronowej, itp.. Model konstruuje się tak, aby jak

najlepiej pasował do danych z próby, zawierającej zarówno zmienne objaśniające, jak i

objaśniane. Mówiąc o wyliczaniu regresji ma się na myśli tę fazę.

stosowanie modelu - użycie wyliczonego modelu do danych w których znamy tylko zmienne

objaśniające, w celu wyznaczenia wartości oczekiwanej zmiennej objaśnianej.

Dział statystyki zajmujący się modelami i metodami regresji zwany jest analizą regresji. Regresja, w

której występuje więcej niż jedna zmienna objaśniająca, zwana jest regresją wieloraką

W modelach parametrycznych ogólna postać modelu jest założona z góry, a celem

procedury regresji jest dobranie takich jej parametrów, które definiowałyby funkcję możliwie

dobrze odpowiadającą próbie uczącej.

Zwykle stosuje się tzw. globalne modele parametryczne, gdzie wartości współczynników są

takie same dla dowolnych wartości zmiennych objaśniających.

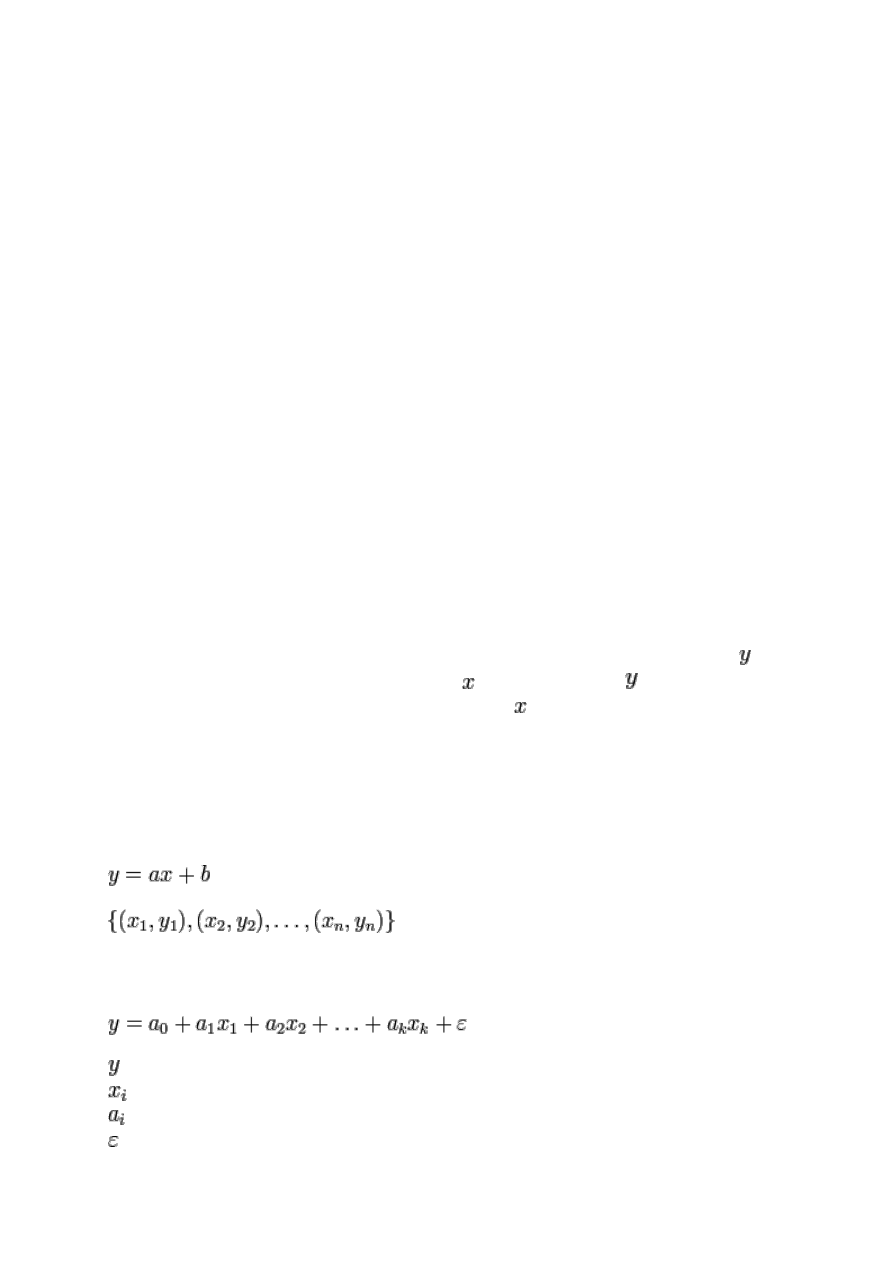

Regresja liniowa – w statystyce, metoda estymowania wartości oczekiwanej zmiennej przy

znanych wartościach innej zmiennej lub zmiennych . Szukana zmienna jest tradycyjnie

nazywana zmienną objaśnianą, lub zależną. Inne zmienne nazywa się zmiennymi objaśniającymi

lub niezależnymi. Zarówno zmienne objaśniane, jak i objaśniające, mogą być wielkościami

skalarnymi lub wektorami.

Regresja w ogólności to problem estymacji warunkowej wartości oczekiwanej. Regresja

liniowa jest nazywana liniową, gdyż zakładanym modelem zależności między zmiennymi zależnymi,

a niezależnymi, jest funkcja liniowa.

Dla jednej zmiennej objaśniającej zagadnienie polega na poprowadzeniu prostej

jak najlepiej dopasowanej do zbioru n punktów doświadczalnych

.

Celem dopasowania jest przede wszystkim uzyskanie ocen wartości parametrów a i b

opisujących prostą, oraz ich niepewności u(a) i u(b).

W ogólnym przypadku zadanie prowadzi do estymacji współczynników modelu statystycznego:

gdzie:

to współczynniki modelu

to błąd o wartości oczekiwanej zero

Najczęściej wykorzystuje się do tego celu klasyczną metodę najmniejszych kwadratów i jej

pochodne. Metoda ta jest najstarsza i najłatwiejsza do zastosowania, choć posiada wady (np.

niewielką odporność na elementy odstające), które udało się usunąć w innych, mniej

rozpropagowanych metodach. Są to np. odporne metody statystyczne (ang. robust methods), do

których należy m.in. regresja medianowa.

ANALIZA WARIANCJI

to metoda statystyczna, służąca do badania obserwacji, które zależą

od jednego lub wielu działających równocześnie czynników. Metoda ta wyjaśnia, z jakim

prawdopodobieństwem wyodrębnione czynniki mogą być powodem różnic między

obserwowanymi średnimi grupowymi. Analiza wariancji została stworzona w latach dwudziestych

przez Ronalda Fishera. Celem analizy wariancji (ANOVA) jest zazwyczaj testowanie istotności różnic

pomiędzy średnimi.

Modele analizy wariancji można podzielić na:

modele jednoczynnikowe - wpływ każdego czynnika jest rozpatrywany oddzielnie, tą klasą

zagadnień zajmuje się jednoczynnikowa analiza wariancji,

modele wieloczynnikowe - wpływ różnych czynników jest rozpatrywany łącznie, tą klasą

zagadnień zajmuje się wieloczynnikowa analiza wariancji.

Według kryterium podział modeli przebiega następująco:

model efektów stałych - obserwacje są z góry podzielone na kategorie,

model efektów losowych - kategorie mają charakter losowy,

model mieszany - część kategorii jest ustalona, a część losowa.

Jednoczynnikowa analiza wariancji jest testem statystycznym służącym do porównywania

średnich w wielu populacjach. Nazwa metody pochodzi od algorytmu postępowania przy

testowaniu układu hipotez. Całkowita wariancja (zmienność wyników) dzielona jest na część

pochodzącą z różnic między populacjami (zabiegami) oraz część pochodzącą z różnic między

wynikami wewnątrz populacji (błąd losowy).

Wyniki uzyskane metodą analizy wariancji mogą być uznane za prawdziwe, gdy spełnione są

następujące założenia:

Każda populacja musi mieć rozkład normalny

Pobrane do analizy próby są niezależne

Próby pobrane z każdej populacji muszą być losowymi próbami prostymi

Wariancje w populacjach są równe

Testy dla wariancji – są to testy parametryczne służące do weryfikacji hipotez statystycznych

dotyczących wartości wariancji w populacji generalnej lub też do porównania wartości wariancji w

dwóch lub kilku populacjach – na podstawie znajomości wartości badanej cechy w losowej próbie

(lub w kilku próbach). Rozstrzygnięcie pytań dotyczących wariancji jest ważne m.in. dlatego, że

wiele testów służących do porównania wartości średnich w dwóch lub kilku populacjach wymaga

przyjęcia założenia o równości wariancji w tych populacjach (tak zwane założenie o jednorodności

wariancji). Ponadto wariancja może być miernikiem dokładności w procesie pomiarowym lub

produkcyjnym (zbyt duża wariancja wyników pomiaru może na przykład świadczyć o uszkodzeniu

lub rozregulowaniu aparatury lub urządzeń).

Hipotezy dotyczące wariancji testuje się zgodnie z ogólnymi zasadami testowania hipotez

statystycznych: formułujemy hipotezy, zakładamy poziom istotności – dopuszczalną wartość

błędu pierwszego rodzaju (tj. prawdopodobieństwo odrzucenia prawdziwej hipotezy zerowej) i na

podstawie danych z próby wyznaczamy wartość statystyki testowej, po czym porównujemy ją z

wartościami krytycznymi odczytanymi z tablic odpowiedniego rozkładu teoretycznego. Przy

konstrukcji wszystkich omawianych niżej testów przyjmowane jest założenie, że badane cechy

maja w populacjach generalnych rozkład normalny.

Postać stosowanej statystyki testowej zależy od kilku czynników:

o

czy badamy hipotezę dotyczącą jednej, dwóch czy wielu wariancji?

o

czy porównujemy próby niezależne, czy zależne (skorelowane, powiązane)?

o

jaka jest liczebność próby (prób)?. Przyjmuje się na ogół (dość arbitralnie), że próba

jest duża, gdy jej liczebność przekracza 30 obserwacji

(można wtedy

zakładać, że statystyki mają rozkład normalny - patrz centralne twierdzenie

graniczne). W przypadku przeciwnym - mamy do czynienia z próbami małymi.

Liczba stopni swobody, df – liczba niezależnych wyników obserwacji pomniejszona o liczbę

związków, które łączą te wyniki ze sobą.

Liczbę stopni swobody można utożsamiać z liczbą niezależnych zmiennych losowych, które

wpływają na wynik. Inną interpretacją liczby stopni swobody może być: liczba obserwacji minus

liczba parametrów estymowanych przy pomocy tych obserwacji.

Liczba stopni swobody ogranicza liczbę parametrów które mogą być estymowane przy użyciu

danej próby.

Jeśli mamy do czynienia z jedną próbką losową zawierającą n obserwacji, z której

estymujemy jeden parametr (powiedzmy, wartość oczekiwaną) to w rezultacie pozostaje

nam

stopni swobody do dalszej estymacji (na przykład wariancji).

W przypadku dwóch próbek o

obserwacjach, zwykle musimy estymować dwie

wartości oczekiwane, a zatem pozostaje nam

stopni swobody.

Wariancja to w statystyce klasyczna miara zmienności. Intuicyjnie utożsamiana ze zróżnicowaniem

zbiorowości; jest średnią arytmetyczną kwadratów odchyleń (różnic) poszczególnych wartości

cechy od wartości oczekiwanej.

Pierwiastek kwadratowy z wariancji definiujemy jako odchylenie standardowe.

Pierwiastek z estymatora nieobciążonego wariancji jest często używany jako estymator

odchylenia standardowego, jednak jest wówczas obciążony.

Odchylenie standardowe – klasyczna miara zmienności, obok średniej arytmetycznej najczęściej

stosowane pojęcie statystyczne.

Intuicyjnie rzecz ujmując, odchylenie standardowe mówi, jak szeroko wartości jakiejś

wielkości (takiej jak np. wiek, inflacja, kurs akcji itp.) są rozrzucone wokół jej średniej

. Im

mniejsza wartość odchylenia tym obserwacje są bardziej skupione wokół średniej.

Odchylenie standardowe jest pierwiastkiem kwadratowym z wariancji. Pojęcie odchylenia

zostało wprowadzone przez pioniera statystyki, Karla Pearsona w 1894 roku

Wyróżnia się:

odchylenie standardowe zmiennej losowej, będące właściwością badanego zjawiska. Daje

się ono obliczyć na podstawie ścisłych informacji o rozkładzie zmiennej losowej

. Rozkład

ten w praktycznych badaniach nie jest zwykle znany.

odchylenie standardowe w populacji, które jest liczbą dającą się obliczyć dokładnie, jeśli

znane byłyby wartości zmiennej dla wszystkich obiektów populacji; odpowiada odchyleniu

zmiennej losowej, której rozkład jest identyczny z rozkładem w populacji.

odchylenie standardowe z próby, które jest oszacowaniem odchylenia standardowego w

populacji na podstawie znajomości wyłącznie części jej obiektów, czyli właśnie tzw. próby

losowej. Stosowane do tego celu wzory nazywane są estymatorami odchylenia

standardowego.

Kowariancja,

– liczba określająca zależność liniową między zmiennymi losowymi X i Y.

Jeżeli między zmiennymi losowymi X i Y nie istnieje żadna zauważalna korelacja liniowa i

istnieją ich wartości oczekiwane, to kowariancja przyjmuje wartość 0 (nie musi to być prawda dla

kowariancji w próbie losowej z tych zmiennych).

Innymi słowy: zmienne losowe X i Y są niezależne, a więc

Szeregi

Szereg szczegółowy - uporządkowany ciąg wartości badanej cechy statystycznej, wartości cechy

porządkujemy rosnąco lub malejąco.

Szereg rozdzielczy - stanowi zbiorowość statystyczną, podzieloną na części (klasy) według

określonej cechy z podaniem liczebności każdej z wyodrębnionych klas.

Średnia arytmetyczna nieważona

-suma odchyleń poszczególnych wartości cechy od średniej równa się zero

-Suma kwadratów odchyleń poszczególnych wartości cechy od średniej jest minimalna

-średnia arytmetyczna jest wrażliwa na skrajne wartości cechy

-średnia arytmetyczna z próby jest dobrym przybliżeniem wartości przeciętnej

Średnią geometryczną

Stosuje się w badaniach średniego tempa zmian zjawisk, a więc gdy zjawiska są ujmowane

dynamicznie.

Medianą

Oznaczaną xmed nazywamy następującą wielkość: Pożądaną cechą mediany jest jej brak

wrażliwości na wartości odstające, czyli wartości bardzo wyraźnie oddalone od innych i w tym

sensie zdecydowanie nietypowe dla zaobserwowanego rozkładu.

Modalna Mo (dominanta D, moda, wartość najczęstsza

Jest to wartość cechy statystycznej, która w danym rozdziale empirycznym występuje najczęściej.

Rozstęp

Jest to różnica pomiędzy wartością maksymalną, a minimalną cechy - jest miarą charakteryzującą

empiryczny obszar zmienności badanej cechy. Rozstęp nie podaje informacji o zróżnicowaniu

poszczególnych wartości cechy w zbiorowości.

Kwantyle

Definiuje się jako wartości cechy badanej zbiorowości, przedstawionej w postaci szeregu

statystycznego, które dzielą zbiorowość na określone części pod względem liczby jednostek.

Kwartyl

pierwszy Q1

dzieli zbiorowość na dwie części w ten sposób, że 25% jednostek zbiorowości ma wartości

cechy niższe bądź równe kwartylowi pierwszemu Q1, a 75% równe bądź wyższe od tego

kwartyla

Kwartyl drugi

(mediana Me)

dzieli zbiorowość na dwie równe części; połowa jednostek ma wartości cechy mniejsze

lub równe medianie, a połowa wartości cechy równe lub większe od Me; stąd nazwa

wartość środkowa

Kwartyl

trzeci Q3

dzieli zbiorowość na dwie części w ten sposób, że 75% jednostek zbiorowości ma wartości

cechy niższe bądź równe kwartylowi pierwszemu Q3, a 25% równe bądź wyższe

od tego kwartyla

Decyle

np. decyl pierwszy oznacza, że 10% jednostek ma wartości cechy mniejsze bądź równe

od decyla pierwszego, a 90% jednostek wartości cechy równe lub większe od decyla

pierwszego

Wariancja

Jest to średnia arytmetyczna kwadratów odchyleń poszczególnych wartości cechy od średniej

arytmetycznej zbiorowości.

Odchylenie standardowe

jest to pierwiastek kwadratowy z wariancji. Stanowi miarę zróżnicowania o mianie zgodnym z

mianem badanej cechy, określa przeciętne zróżnicowanie poszczególnych wartości cechy od

średniej arytmetycznej.

Typowy obszar zmienności cechy Około 2/3 wszystkich jednostek badanej zbiorowości

statystycznej posiada wartości cechy w odległości 1 sigma ,zgodnie z regułą 3 sigma.

Współczynnik zmienności

jest ilorazem bezwzględnej miary zmienności cechy i średniej wartości tej cechy, wielkość

niemianowana, najczęściej podawana w procentach. Współczynnik zmienności stosuje się w

porównaniach zróżnicowania:

• kilku zbiorowości pod względem tej samej cechy,

• tej samej zbiorowości pod względem kilku różnych cech.

Współczynnik skośności

Jest stosowany w porównaniach, do określenia siły oraz kierunku asymetrii, liczba niemianowana,

im większa wartość tym silniejsza asymetria. W zależności od znaku współczynnika rozkład jest:

• prawostronnie (dodatnio) skośny dla dodatnich wartości współczynnika - ma dłuższy prawy

,,ogon'',

• symetryczny dla równego zero,

• lewostronnie (ujemnie) skośny dla współczynnika ujemnego - ma dłuższy lewy ,,ogon''.

Wykres skrzynkowy może obrazować zmiany rozkładu w kolejnych próbkach, jeśli dla każdej z nich

wyznaczono kwartyle (w tym medianę) i rozstęp.

Proste regresji drugiego rodzaju

Prostą regresji zmiennej losowej Y względem zmiennej losowej X nazywamy prostą o równaniu:

y = β1 + β2x,

którego współczynniki β1, β2 są tak dobrane, aby średnie odchylenie kwadratowe zmiennej

losowej Y od zmiennej losowej

β1 + β2Xbyło jak najmniejsze (ze względu na współczynniki β1 i β2)

Wyszukiwarka

Podobne podstrony:

Algorytm analizy korelacji i regresji liniowej, Statystyka opisowa

Analiza korelacji i regresji, Statystyka opisowa i matematyczna

Analiza korelacji i regresji 3, STATYSTYKA (WYK?AD 16

Analiza korelacji i regresji 3, STATYSTYKA (WYK?AD 16

Elementy analizy korelacji i regresji

ANALIZA KORRELACJI I REGRESJI

analiza opisowa i wskazówki, Studia - pedagogika

ANALIZA KORELACJI I REGRESJI-wzory, Statystyka, statystyka(3)

Analiza korelacji i regresji, studia, statystyka

5 Analiza korelacji i regresji (30 03)

STATYSTYKA - analiza korelacji i regresji, ŚCIĄGI Z RÓŻNYCH DZIEDZIN, Statystyka

ANALIZA KORELACJI I REGRESJI”, Statystyka, statystyka(3)

analiza korelacji i regresji

Analiza korelacji i regresji

Analiza korelacji i regresji

więcej podobnych podstron