Def inteligencji , zagrożenia i perspektywy rozwoju sztucznej inteligencji.

Inteligencja - uzdolnienie intelektualne , jest to zdolność do penetrowania informacji na poziomie abstrakcyjnym, to zdolnośc do twórczego , a nie tylko mechanicznego penetrowania info ,czyli tworzenia zupełnie nowych pojec i ich zastosowania

Budowa ludzkiego mózgu

V=1400cm3

A=2000cm2

M=1,5 kg

W korze mozgowej (3mm grubości) zawiera się 1018 neuronów z czeko 1011 połączonych i 1015połączeń

Długość połączeń :0,01 mm do kilku m

Cz. pracy od 1 do 100 Hz

Impulsy przychodzące od 1 do 2 ms

Napięcie 100 mV

Szybkość przesylu miedzy Komorkami nerwowymi 100 m/s

Budowa mózgu nie jest do konca rozpoznana, znane są tylko obrazy o różnych zastosowaniach . Pamięć zalezy od połączeń między neuronoami

budowa ludzkiego neuronu

Soma-cialo komorki , dendryt - wejście , akson -wyjscie , dużo dendrytów , jeden akson - z którego do wielu neuronów można wysłać inf. Pobudzenie przekazywane przez złącze zwane synapsą

budowa i równanie sztucznego neuronu

Wagi pełnią rolę synaps, f. aktywacji określa wartość na wyjściu, podczas uczenia, zmianą podlegają wartości wag.

funkcje aktywacyjne neuronow

Funkcja aktywacji, w zależności od konkretnego celu, jakiemu służy neuron, może przyjmować różne postacie.

-skokowa : od 0 do 1

od minus jeden do plus jeden

-liniowa

-sigmoidalna (0d 0 do 1 v -1 do 1)

Gdy b-> nieskończoność - wtedy skokowa

Zaleta f. sigmoidalnej jest ciągłość funkcji.

-gaussa (neurony radialne)

-liniowa z ograniczeniem

dzialanie neuronu dwuwejściowego. Granica decyzyjna

Działanie neuronu: ?

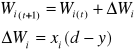

metody uczenia neuronow. reguła delta

Metody uczenia :

-nadzorowana (z nauczycielem) - podanie na wejście sygnału przy znanej odpowiedzi, jeśli generuje poprawny wynik to waga się nie zmienia

-nienadzorowana - mniej skuteczna z opracowaną funkcja określającą zmianę wag

Z nauczycielem - met. Widrowa-Hoffa : metoda delta

xi=ui- wekście , d-sygnał od nauczyciela![]()

![]()

-współczynnik uczenia się: (0:1)

Bez nauczyciela - met. Hebba ![]()

![]()

- im wieksze tym szybciej się uczy neuron, ale czasem może się nigdy nie nauczyc

Reguła delta : Z regułą delta mamy do czynienia, gdy uaktualnianie wag następuje każdorazowo po prezentacji jednej pary uczącej. Gdy uaktualnianie zachodzi po prezentacji wszystkich par uczących mamy wtedy do czynienia z tzw. skumulowaną regułą delta.

Reguła delta przeznaczona jest dla neuronów z ciągłymi funkcjami aktywacji i stanowi odpowiednik reguły perceptronowej. Nazywa jest ona również ciągłą regułą perceptronową. Metoda ta łatwo daje się wprowadzić jako wynik minimalizacji kwadratowego kryterium błędu. Jej uogólnioną wersję można wykorzystać w sieciach wielowarstwowych.

Uczenie nadzorowanie perceptronu , równanie uczenia

Równanie uczenia: ![]()

Uczenie : powstaje problem bo posiadamy tylko sygnał wyjściowy nie wiemy co jest w warstwach ukrytych ( błąd się nawarstwia z warstwy na warstwe). Błąd neuronu mnoży się razy wagę wyjścia

struktura programu modelującego neuron

????????????????????????????????????????

wpływ danych uczących (wejściowych) oraz współczynnika n na uczenie perceptronu.

ograniczenia perceptronu

adaline, budowa , uczenie (algorytm LMS)

ADALINE-adaptive-linear-neuron/element

Budowa:

LMS- met. najmniejszych kwadratów

Uczenie : algorytm Widrowa-Hoffa

inicjalizacja wag i wartości progowych =w(0)

podanie na wejścia sieci neuronowej nowego obrazu (?)

![]()

wyznaczenie y a następnie błędu

![]()

zakończyć jeżeli

większe od zadanej dokładnościadaptacja wektora wag

![]()

neuron sigmoidalny, budowa , uczenie -> równanie uczenia

Budowa:

Neuron typu sigmoidalnego ma strukturę podobną do modelu McCullocha-Pittsa, z tą różnicą, że w przeciwieństwie do perceptronu funkcja aktywacji jest ciągła i przyjmuje postać funkcji sigmoidalnej unipolarnej (0,1) lub bipolarnej (-1,1). Funkcja unipolarna ma zwykle postać

, natomiast bipolarna

(inaczej ![]()

) Parametr

jest dobierany przez użytkownika i jego wartość wpływa na kształt funkcji aktywacji. Przy małych wartościach

funkcja ma mały kąt nachylenia, w miarę wzrostu jej wartości przebieg staje się bardziej stromy. Przy

dążącym do nieskończoności funkcja sigmoidalna przechodzi w funkcję skokową, identyczną z funkcją aktywacji perceptronu. W praktyce przyjmuje się najczęściej dla uproszczenia współczynnik

=1

Uczenie neuronu sigmoidalnego odbywa się zwykle w trybie z nauczycielem, przez minimalizację funkcji celu, podobnie jak w przypadku perceptronu.

Założenie ciągłej funkcji aktywacji umożliwia zastosowanie w uczeniu metody gradientowej. Najprościej jest przyjąć metodę największego spadku, zgodnie z którą aktualizacja wektora wag odbywa się w kierunku ujemnego gradientu funkcji celu

Równanie uczenia: ![]()

neuron hebba, budowa, uczenie -> metody uczenia , równania (z i bez nauczyciela)

Siec hebba powinna odkryc bez dodatkowej pomocy wzajemne zależności, uczenie bez nauczyciela jest skuteczne, gdy mamy nadmiarowe dane uczące. Cecha niekorzystna jest niestabilność, brak …..?? , wynikiem uczenia jest wykładniczy wzrost wag.

Równanie modyfikacji wag: ![]()

neuron radialny , budowa ,uczenie

typowe architektury sieci (jednokierunkowa + rekurencyjna)

rozwiązanie problemu XOR (siec dwu i trój warstwowa perceptronowi)

algorytm propagacji wstecznej

zast. Ssn do rozpoznawania liter, cech sygnałów

model identyfikacji równoległej

Struktura układu z równoległym modelem identyfikacji pokazana jest na rys. 3. W strukturze tej, jednym

z wejść modelu jest jego niezakłócone i niezaszumione wyjście y (k +1) est , co pozwala zwiększyć dokładność

identyfikacji. Sieć neuronowa będąca modelem obiektu F musi być siecią rekurencyjną.

W rozpatrywanej strukturze stabilność modelu identyfikacji z siecią neuronową, z uwagi na

ograniczoność sygnałów wejściowych oraz wyjściowych, nie jest zagwarantowana. W konsekwencji błąd

wyjścia e(k+1) może nie dążyć do zera.

def zbiorow klasycznych i rozmytych. Podstawy logiki rozmytej

funkcje przynależności , rodzaje, kształty

na czym polega fuzzyfikacja ? jak się ja wykonuje i jakie SA zakresy niewrażliwości zmian sygnalu wejściowego na dzialanie regulatora rozmytego

baza regul- budowa

wyniki dzialania regul , poziom zaplonu, jak się go wyznacza, pokazac na przykaldzie

metoda defuzzyfikacji, na czym polega metoda cyfrowa i analogowa

tabela regul , jak się ja zapisuje i jak ja rozumiec

podstawowe pojecia w algorytmie genetycznym (populacja , chromosomy ,funkcja przystosowania)

opisac dzialanie algorytmu genetycznego

algorytm genetyczny do poszukiwania parametru optymalnego sterowania - schemat wraz z komentarzem

Wejście

Waga 1

Waga 2

Waga 3

Waga n

Sumator

Funkcja aktywacji

Wyjście

Wyszukiwarka

Podobne podstrony:

MSI-program-stacjonarne-15h-2011, logistyka, semestr IV, sieci neuronowe w log (metody sztucznej int

sciaga msi, Automatyka i Robotyka, Semestr 4, Metody sztucznej inteligencji

msi ściąga test, Automatyka i Robotyka, Semestr 4, Metody sztucznej inteligencji

Sprawozdanie Zbiory Rozmyte Język R MSI, Automatyka i Robotyka, Semestr 4, Metody sztucznej intelige

lab5 dodatek, ۞ Płyta Studenta Politechniki Śląskiej, Semestr 4, Msi - Metody sztucznej inteligencji

MSI-program-stacjonarne-15h-2011, logistyka, semestr IV, sieci neuronowe w log (metody sztucznej int

Indukcja drzew decyzyjnych, Robotyka, Metody sztucznej inteligencji

msi2, Automatyka i Robotyka, Semestr 4, Metody sztucznej inteligencji

Metody sztucznej inteligencji

Zapis reguł dokładnych przy użyciu języka CLIPS, Robotyka, Metody sztucznej inteligencji

Sztuczna inteligencja wyklad 2, WI, Semestr III N2, Metody sztucznej inteligencji

Sztuczna inteligencja lab 1, WI, Semestr III N2, Metody sztucznej inteligencji

Opracowanie na kolokwium, Automatyka i Robotyka, Semestr 4, Metody sztucznej inteligencji

sztuczna--, Robotyka, Metody sztucznej inteligencji

test1, Studia, ZiIP, SEMESTR IV, Metody sztucznej inteligencji

Automatyczne dowodzenie twierdzeń, Robotyka, Metody sztucznej inteligencji

SPRAWOZDANIE literki, POLITECHNIKA ŚLĄSKA Wydział Mechaniczny-Technologiczny - MiBM POLSL, Inżyniers

więcej podobnych podstron