Informacja genetyczna

Wykład 3 – Jeśli nie informacja, to

co?

Jeśli nie informacja, to co?

• –

ILOŚĆ informacji

• To nie to samo! Ilość wody w szklance, to

nie to samo, co woda w szklance. Ilość wody

w szklance można wyrazić poprzez masę

wody w szklance, objętość szklanki, itd... By

wyrazić co to jest woda jako woda trzeba

odnieść się do bytów zupełnie różnych od

szklanki, objętości i ilości, posługując się

pojęciem cząsteczki, atomu itd...

• Keith Devlin „Żegnaj Kartezjuszu” –

informacja a żelazo, era informacji a era

(epoka) żelaza. Ale zamiast tego:

Ceratonia – chleb świętojański – co to jest złoto i co to jest karat

rozumiany jako pewna ilość złota

My – złoto to pierwiastek (metal) o pewnych określonych

własnościach wynikających z położenia w układzie okresowym…

„Oni”: złoto to wartościowy kruszec (wartościowy – za niewielką

ilość można dostać dużo złota,….)

My: informacja to niematerialny aspekt komunikatu umożliwiający

sterowanie (sterowanie – wpływanie na stan układu poprzez

informację zawartą w komunikatach…)

„Oni” - ????

Definicja ilości informacji

i jej jednostki

• W czym definiujemy ilość informacji? W

komunikacie (Nie da się zdefiniować ilości wody w

ogóle, choć można np. ilość wody w szklance, we

Wszechświecie…).

• Co to jest jednostka czegoś – jest to ilość czegoś

zawarta we wzorcowej porcji tego czegoś

nazywanej ilością jednostkową. Dlatego o wiele

łatwiej zdefiniować jednostkę czegoś niż samo to

coś – amper to prąd jednostkowy, volt to potencjał

jednostkowy a atomowa jednostka masy, to masa

najlżejszego atomu (choć tak naprawdę 1/12

innego atomu, ale to już potem)

• Bit – ilość informacji zawarta w podstawowym

jednostkowym komunikacie

Definicja ilości

informacji

• Aby komunikat był komunikatem, musi zmieniać stan

układu poprzez stan wejścia. W najprostszym przypadku

mamy 2 możliwe stany 1 możliwego wejścia (albo wyjścia).

Nie można mówić o sterowaniu, jeżeli układ ma mniej niż

jedno wejście LUB wyjście, bądź mniej niż 2 stany tegoż

jednego wejścia.

• Ta jednostkowa porcja informacji jest potrzebna do zmiany

jednego stanu tego we(y)jścia w drugi możliwy.

• Ten sam komunikat nie może zmienić stanu we(y)jścia „z

powrotem”, musi to być inny komunikat. Innymi słowy – dla

jednego we(y)jścia o 2 stanach minimalna liczba

komunikatów wynosi 2.

• Widać tu, że o ilości informacji w komunikacie można

mówić jedynie w kontekście zbioru wszystkich możliwych

(niezbędnych) komunikatów i nie da się tego określić bez

odniesienia do stanu we(y)jścia rozpatrywanego układu.

Definicja ilości

informacji

• Czy jednostkowa ilość informacji jest minimalną ilością

informacji, jaką może zawierać komunikat?

• Załóżmy, że komunikat a zachodzi 10 razy częściej, niż

komunikat b, komunikat a zmienia stan wejścia z 0 na

1, a komunikat b z 1 na 0. Widać, że wejście będzie

znacznie częściej w stanie 1, niż 0, a stan układu

determinowany wejściem 1 bardziej prawdopodobny

niż determinowany wejściem 0. Komunikat b niesie

więc więcej informacji niż komunikat a.

• Widać z tego, że w szczególności – ilość informacji

zawarta w komunikacie może być ułamkowa (np. 0,1 b),

oraz że miarą ilości informacji zawartej w komunikacie

jest NIEPRAWDOPODOBIEŃSTWO zajścia komunikatu.

• Nie istnieje „kwantowa” teoria informacji, ale to nie

znaczy, że nie istnieją jednostkowe, niepodzielne

kwanty informacji. Tego nie wiemy. Na pewno można je

zidentyfikować dla konkretnego komunikatu, ale

wówczas mogą one zawierać zmienną ilość informacji.

Definicja jednostki

ilości złota

•1 karat złota to tyle

złota, ile równoważy 1

nasiono (nasienie ;)

ceratonii

Definicja jednostki ilości

informacji (bita)

• Kiedy układ w wyniku kolejnych aktów

komunikacji najczęściej zmienia stan?

• W sytuacji, gdy oba komunikaty są jednakowo

prawdopodobne, każdy z nich niesie 1 bit

informacji. Wówczas to akt komunikacji

najczęściej zmienia stan układu sterowanego.

• 1 bit informacji to tyle informacji, ile

zawiera 1 komunikat ze zbioru dwu

jednakowo prawdopodobnych, albo 1

komunikat o prawdopodobieństwie

wystąpienia 0.5

Definicja ilości informacji Problemy:

• Jeśli komunikat jest jeden, a ciąg stanów układu

wygląda tak: 1,1,1,1,1,1,…?

• Jeśli komunikat jest jeden, a ciąg stanów układu

wygląda tak: 0,1,1,1,1,1,…?

• Jeśli komunikaty są 3, 4, 5….?

• Jeśli komunikat jest jeden i ten sam, a układ za każdym

razem binarnie zmienia stan: 0,1,0,1,0,1…?

• Złożoność Kołmogorowa to stopień skomplikowania

najkrótszego komunikatu szyfrującego daną wiadomość.

Na przykład, żeby przesłać milion dziewiątek, nie trzeba

ich wszystkich wypisywać; wystarczy nadać komunikat:

„przesyłam tobie milion dziewiątek”. Złożoność

Kołmogorowa takiej wiadomości jest niewielka, na

pewno nie trzeba do tego używać miliona znaków. W

pewnym uproszczeniu można powiedzieć, że gdybyśmy

kompresowali plik z komunikatem za pomocą

optymalnego programu zipującego, to po kilku kolejnych

iteracjach, gdy już długość wielokrotnie wykonanej

kompresji na tych samych danych nie skraca pliku,

otrzymamy coś, co ma długość w przybliżeniu równą

złożoności Kołmogorowa.

Złożoność

Kołmogorowa

•

Obiekty o małej Z.K.: fraktale, liczba pi

•

Obiekty o nieskończonej Z.K.

(praktycznie): PRAWIE wszystkie

liczby rzeczywiste (zbiór niepoliczalny,

zbiór wszystkich

programów/algorytmów – policzalny…)

•

„

Niestety, ten dział matematyki jest w centrum

zainteresowania organizacji wojskowych i na dobrą

sprawę nie wiadomo, jak daleko są obecnie posunięte

badania w tej dziedzinie. Obserwując to, co się dzieje

w Internecie, te kilobajty idiotycznie generowane,

żeby przesłać jakąś bzdurę, tęsknię za powszechnym

rozbrojeniem i za udostępnieniem cywilnym

zastosowaniom tych pięknych technik

matematycznych, solidnie obecnie utajnionych.„

• KRYPTOLOGIA: muzyka/ wielokulturowość/

matematyka (Enigma – muzyk)

Na marginesie – nie

istnieją programy

zipujące sekwencje

nukleotydów. Ale to

nie oznacza, że ich się

nie da zzipować.

Odkrycie takich

algorytmów będzie

się równało odkryciu,

jak komórka

kompresuje dane.

Definicja ilości

informacji i bita

• 1 bit to ilość informacji niesiona przez 1 komunikat w sytuacji minimalnej

sensownej liczności zbioru komunikatów o płaskim rozkładzie p., czyli

ilość informacji zawartej w jednym z dwu możliwych jednakowo

prawdopodobnych komunikatów.

• Jeżeli liczba możliwych komunikatów wzrosłaby do 4, wówczas ilość

informacji niesionej przez każdy z tych komunikatów wcale nie wzrasta

do 4 bitów. Stany wejścia są nadal 2, a zatem, przy założeniu płaskiego

rozkładu prawdopodobieństwa, dany stan wejścia będzie realizowany

przez PARĘ komunikatów (2 komunikaty są jednym komunikatem).

• Ten układ jest nadmiarowy (redundantny), bo aby zmieniać (przełączać)

stan układu wystarczy zbiór 2 komunikatów. 2 są zbędne i mogłyby

przełączać stany jakiegoś DRUGIEGO wejścia.

• Wówczas – para realizuje jedno, a druga para drugie wejście, a w każdej z

par jeden komunikat przełącza 1 na 0 a drugi 0 na 1. Widać wyraźnie, że

każdy komunikat zawiera 2 bity informacji: o które wejście i o który stan

chodzi. Stan układu determinowany jest binarnym stanem dwu wejść…

Definicja ilości

informacji i bita

• Ogólnie – ilość informacji wzrasta jak LOGARYTM z liczności zbioru

komunikatów. Przy założeniu o płaskim rozkładzie prawdopodobieństwa

liczność zbioru komunikatów jest odwrotnością prawdopodobieństwa

każdego z komunikatów, czyli nieprawdopodobieństwem jego zajścia:

• p

k

=1/L=>L=1/p

k

=p

k-1

,

• I

k

=

log

2

p

k-1

=- log

2

p

k

=-lb(p

k

)

• Oczywiście wzór ten jest ważny również dla innych rozkładów

prawdopodobieństwa , choć wówczas nie są one odwrotnością liczności

zbioru wszystkich komunikatów.

• Wynika z tego również, że w ten sposób zdefiniowana ilość

informacji jest miarą minimalnej liczby niezbędnych decyzji, jakie

musimy podjąć, by jednoznacznie wybrać dany komunikat ze zbioru

wszystkich możliwych komunikatów.

– Musimy albo i nie musimy – jeżeli prawdopodobieństwo wyboru jednego

komunikatu wynosi 0.9, to sobie możemy dać spokój, choć ryzykujemy

(10% ryzyka), że akurat wybierzemy ten niewłaściwy komunikat.

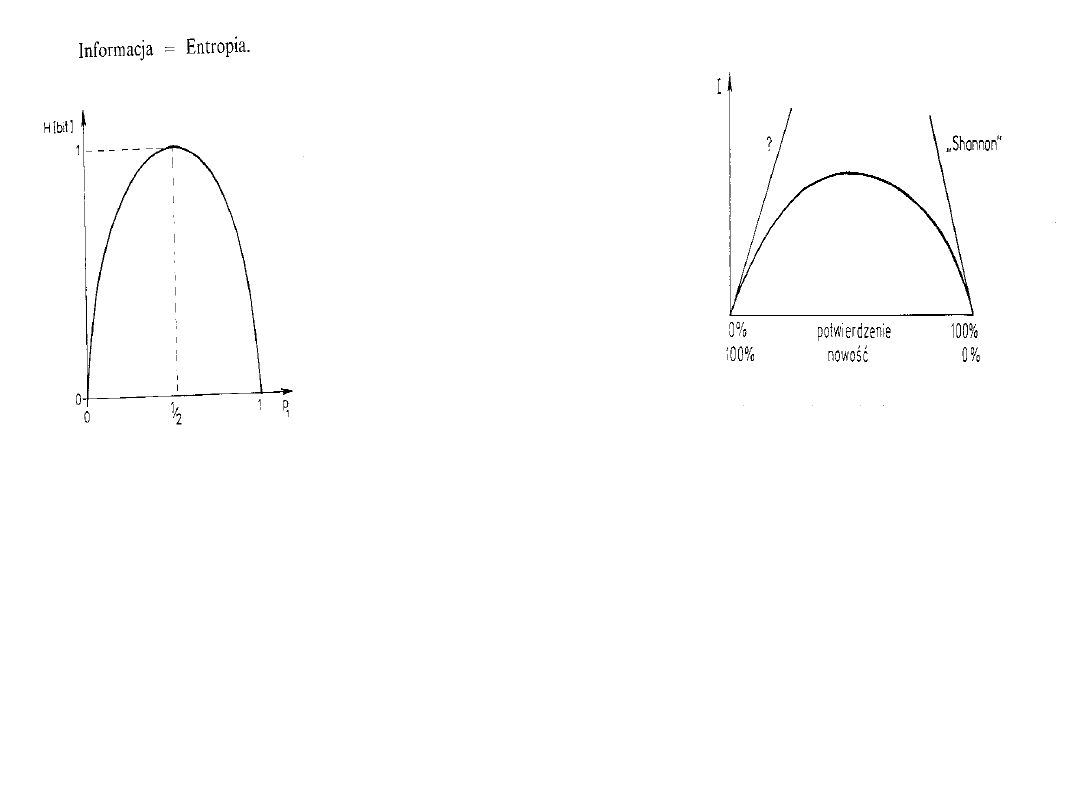

Kiedy komunikat zawiera maksymalną ilość

informacji?

Mówiliśmy, że ilość informacji w komunikacie jest funkcją

całego zbioru komunikatów. Otóż i tu musimy się odnieść

do całego zbioru komunikatów. Jeżeli rozkład

prawdopodobieństwa jest płaski, wówczas ilość

informacji w każdym z komunikatów jest maksymalna.

H=lb(L)

(no bo

L=1/p

, czyli dla

I=-lb(p) -lb(1/L)=lb(L)

).

Jeżeli tak nie jest, wówczas niestety ale również te

komunikaty o mniejszym prawdopodobieństwie będą

zawierały mniej informacji… Tę ciekawą własność

informacji uchwycono w definicji ENTROPII

informacyjnej zbioru komunikatów, którą też oznacza się

przez H:

H=Σp

k

I

k

=-Σp

k

lb(p

k

)

Gdy maleje p, to rośnie I i vice versa.

Wynika stąd

coś

niezwykle

istotnego:

Aby komunikat

zawierał

optymalną ilość

informacji, musi

być już

częściowo znany

odbiorcy

Ilość informacji zawarta w komunikacie jest nie tylko

funkcją całego zbioru komunikatów, ale również

własności odbiorcy, no i (lub) nadawcy (wystarczy w

rozważaniach zmienić wejścia na wyjścia…)

Intuicyjnie nie oczywiste? Może,

ale rozważamy ilość, a nie jakość

informacji. Informacja „On żyje”

i „on nie żyje” zawiera tyle samo

bitów, ale różna jest jej jakość :-)

Przykład

• Dziś w Krakowie parę osób

zachorowało na grypę

• Dziś w Krakowie parę osób

zachorowało na toksokarozę

• Dziś w Krakowie parę osób

zachorowało na ptasią grypę

• Dziś w Krakowie parę osób

zachorowało na ornitozę (chorobę

papuzią)

Kiedy komunikat zawiera optymalną ilość

informacji – szumy i redundancja.

r=(H-I)/H

Przykład z jednym

wejściem i czterema

komunikatami:

H=2, I=1, r=0.5,

Czyli zbiór komunikatów

pracuje „na pół gwizdka”.

r≤1 – jest to miara

odchylenia rozkładu

prawdopodobieństw

zbioru komunikatów od

rozkładu płaskiego.

Kolejne potyczki z intuicją

• Jak ma się entropia do informacji?

• Entropia Boltzmannowska:

S=klnW

, gdzie W

– prawdopodobieństwo termodynamiczne

układu; S jako miara RÓŻNORODNOŚCI

DYSTRYBUCJI ENERGII na poziomach

energetycznych układu

• Entropia jako miara NIEWIEDZY o układzie –

ilości informacji, o jaką należy uzupełnić

naszą wiedzę, aby uzyskać pełną wiedzę o

układzie (dla S=0 I=0)

• Entropia Boltzmannowska i Shannonowska a

II zasada termodynamiki – demon Maxwella…

Entropia

• S=klnW

• W=n!/n

0

!n

1

!n

2

!....n

k

!

gdzie n – liczba wszystkich molekuł w układzie, n

i

-liczba molekul na

i-tym poziomie energetycznym

• im więcej poziomów obsadza dana liczba molekuł, tym większe W

• nieobsadzone poziomy nie mają wpływu na entropię, gdyż 0!=1

• Molekuły uzyskując energię dążą do obsadzenia jak największej

liczby poziomów energetycznych zgodnie z rozkładem Boltzmanna,

S rośnie. Oddając energię otoczeniu układ obniża entropię (wyższe

poziomy pozostają nieobsadzone) ale rośnie entropia otoczenia

Entropia

• Entropia

nie jest

miarą nieuporządkowania

przestrzennego układu!!

• Entropia jest miarą różnorodności dystrybucji

energii na poziomach energetycznych. W stanie

równowagi termodynamicznej zmiana dystrybucji

energii powoduje zmianę stanu układu z

najmniejszym prawdopodobieństwem. W tym stanie

zmiana dystrybucji energii zwykle powoduje

przejście układu do innej dystrybucji, ale nie

powoduje to zmiany stanu układu, bo różnorodność

tej dystrybucji jest maksymalna i najbardziej

prawdopodobne jest, że ta nowa dystrybucja również

będzie realizować ten sam stan układu.

• przykład!

Entropia

• rośnie w miarę wzrostu temperatury czyli

wzrostu liczby obsadzonych poziomów

energetycznych

• układ o gęstszych poziomach ma większą

entropię niż inny układ w tej samej

temperaturze i o tej samej liczbie molekuł,

lecz o rzadszych poziomach energetycznych

– wzrost masy molekuł „zagęszcza” poziomy

energetyczne

– w warunkach normalnych (300K, ciśnienie

atmosferyczne, pow. Ziemi) szczególną rolę

odgrywają tu poziomu energii translacyjnej

Entropia

Nie jest miarą nieuporządkowania:

• 2 układy o tej samej liczbie

molekuł i temp. He, Ar. Masa

atomowa Ar jest większa:

– S

Ar

>S

He

bo Ar ma gęściej upakowane

poziomy translacyjne

– A uporządkowanie takie samo!

Entropia

• Deuter (D

2

) i hel (He): Takie same

układy i cząsteczki o takiej samej

masie:

• S(D

2

)>S(He),

– bo deuter posiada również poziomy

oscylacyjne i rotacyjne

– A stopień uporządkowania taki sam

Entropia

• Entropia tlenu a entropia fluoru

• O

2

mniejsza masa, F

2

większa, oba gazy – te

same ruchy (cząsteczki dwuatomowe)

• S tlenu >S fluoru

– bo w stanie podstawowym tlen trypletowy – stan

zerowy trójkrotnie zdegenerowany (dodatkowe 3

poziomy energetyczne o jednakowej energii) –

wkład S=Rln3 około 9,1 J/mol/K

– A stopień uporządkowania taki sam

Entropia a Informacja

• Entropia nie jest miarą

nieuporządkowania układu!!

• Entropia jest miarą niewiedzy o

układzie – ilości informacji jaką

należy

zdobyć

, aby odtworzyć

układ („

potencjalnej

”)

Jeden koduje, drugi dekoduje…

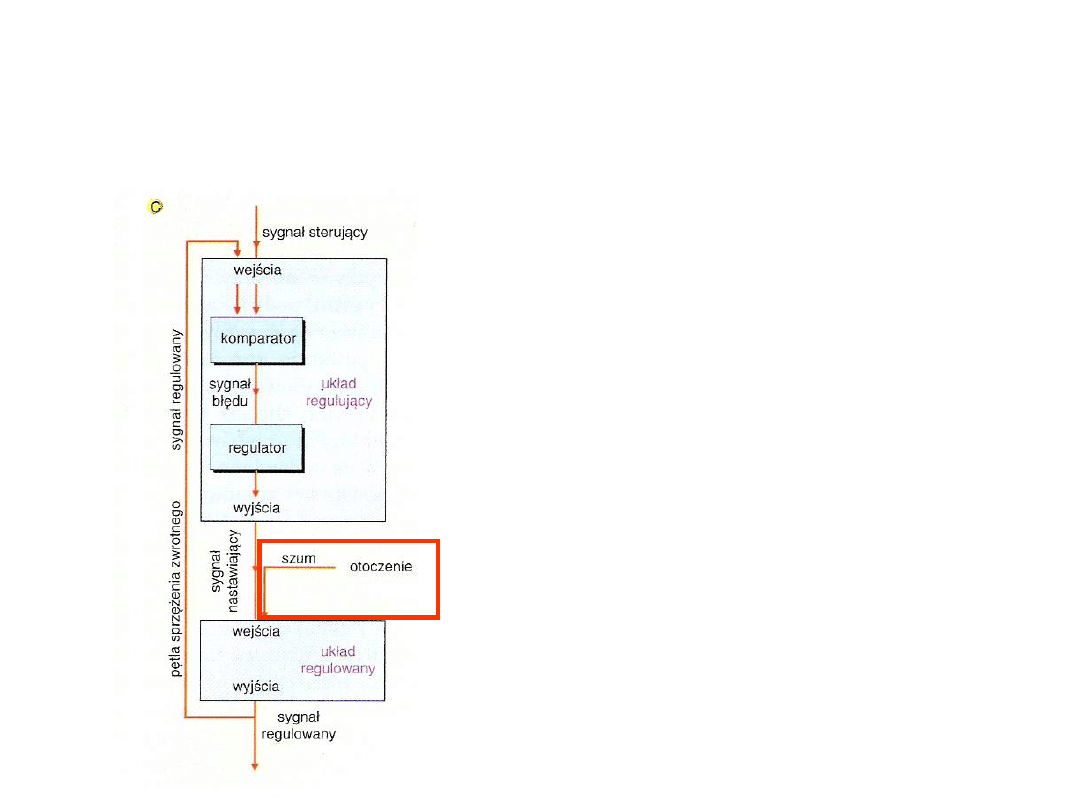

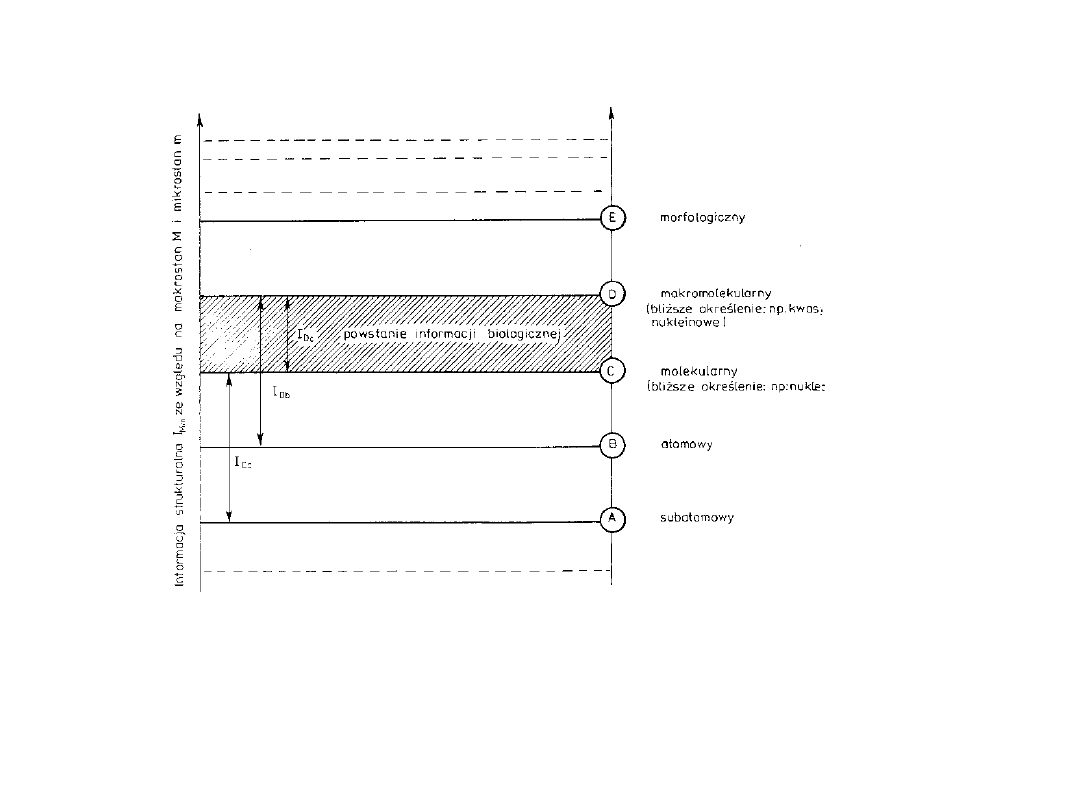

• Zjawisko fizyczne można rozpatrywać na różnych

poziomach.

• Nadawca wsadzając informację w komunikat (kodując)

działał na określonym poziomie – np. układał litery, ale nie

atomy farby drukarskiej.

• Odbiorca musi działać na tym samym poziomie, by wydobyć

informację z komunikatu (zdekodować). Stąd konieczność

ustalenia owych poziomów a priori. I tego zwykle

dotyczy owa wiedza a priori niezbędna dla zajścia aktu

komunikacji

• Poziom całego komunikatu – makrostan: Poziom ODBIORU

komunikatu. Jest nim np. fala dźwiękowa, książka jako

całość, DNA jako całość, mRNA jako całość. Odbiorca

DEKODUJE makrostan, odnosząc się do jakiegoś poziomu

mikrostanów (poziomu dekodowania komunikatu). I

wówczas pojawia się właściwa informacja, może jej być

więcej albo mniej. Szereg przykładów:

– Sekwencja nukleotydów/loci

– Laryngolog

– List z niewoli

PODSUMOWANIE

3 aspekty informacji tkwiącej w komunikacie:

•Syntaktyczny – dotyczy fizycznych możliwości „upchania’

informacji w komunikacie

•Semantyczny – dotyczy tego, co i jak jest zakodowane w

komunikacie, czyli - o czym jest informacja i jak to się ma do

komunikatu („o czym jest komunikat”)

•Pragmatyczny - określa co trzeba zrobić, by we właściwy

sposób nadać i odebrać komunikat, co to znaczy „właściwy

sposób” i co z tego wynika (co się tak naprawdę zmienia w

wyniku zajścia procesu sterowania). Pojawia się tu problem

JAKOŚCI informacji. Można ją mierzyć i można ją

wartościować!

Tak więc informacja jest pewnym niematerialnym

aspektem komunikatu, o którym nie można nic

powiedzieć, o ile nie mamy wstępnej wiedzy dotyczącej

wszystkich możliwych komunikatów czyli wstępnej

wiedzy dotyczącej nadawcy i odbiorcy komunikatu. Czyli

– informacja jest funkcją całego układu, w którym

zachodzi sterowanie!

Literatura

• J.J. Jadacki (red.) – „Analiza pojęcia informacji” –

Semper, Warszawa 2003

• K. Devlin- „Żegnaj Kartezjuszu”, Prószyński i S-ka,

Warszawa 1999

• B.O Küppers – „Geneza informacji biologicznej” –

PWN, Warszawa 1991

• „Encyklopedia biologiczna” – Opres, Kraków, 1998-

2000

• M. Bryszewska, W. Leyko (red.) – „Biofizyka kwasów

nukleinowych dla biologów” – PWN W-wa 2000

• Z. Kęcki – „Podstawy spektroskopii molekularnej” –

PWN Warszawa 1992

• W. Jassem – „Mowa a nauka o łączności”PWN

Warszawa 1974

• L. Tiepłow – „O cybernetyce”, WNT, Warszawa 1967

Pytanie na następny

wykład

Co to jest język?

Pytania

• informacja a entropia

• względność ilości informacji w

komunikacie

• nasienie a nasiono

• definicja złota

• zapis informacji genetycznej

• zapis kodu genetycznego

Document Outline

- Slide 1

- Slide 2

- Slide 3

- Slide 4

- Slide 5

- Slide 6

- Slide 7

- Slide 8

- Slide 9

- Slide 10

- Slide 11

- Slide 12

- Slide 13

- Slide 14

- Slide 15

- Slide 16

- Slide 17

- Slide 18

- Slide 19

- Slide 20

- Slide 21

- Slide 22

- Slide 23

- Slide 24

- Slide 25

- Slide 26

- Slide 27

- Slide 28

- Slide 29

- Slide 30

Wyszukiwarka

Podobne podstrony:

Jeśli nie ludowa, to czyja

I TO JUŻ NIE JEST TO CO BYŁO

ATT00005, Człowiek nie tknięty filozofią zna w pierwszym rzędzie to, co może zobaczyć, czego może do

Nie udalo mi sie skopiowac testu, Nie udało mi się skopiować testu, ale wysyłam to co w nim jest:

MatLab 2 lista z zadaniami na koło, To co się udało zobaczyć, choć nie wiem czy dobrze wszystko zano

Ściąga z informatyki-2003, Co to jest internet-ściąga

Jeśli nie szata zdobi człowieka, to w czym tkwi jego wartość

Intermet-to co najważniejsze, wrzut na chomika listopad, Informatyka -all, INFORMATYKA-all, Informat

po co żyję, Pigułki szczęścia nie dają, Pigułki szczęścia nie dają / 28 marzec 2008

MatLab ROZWIĄZANA lista na koło, To co się udało zobaczyć, choć nie wiem czy dobrze wszystko zanotow

Nie ominie cię to co najlepsze, Rozwój duchowy

Mały podatnik to nie zawsze to samo co mały przedsiębiorca

Holt Anne Vik i Stubø 02 To co sie nigdy nie zdarza

Sieci Komputerowe, inf sc w3, Przez sieć komputerową rozumiemy wszystko to, co umożliwia komputerom

Ściąga z informatyki-2003, Co to jest komputer

Ściąga z informatyki-2003, Co to jest WWW-ściąga

więcej podobnych podstron