1

Prof. dr hab. inż. Jan T.Duda

Kraków, grudzien 2004

Katedra Analizy Systemowej i Modelowania Cyfrowego

AGH, tel. 617-45-06

Ekonometria – repetytorium

1. Przedmiot i narz

ę

dzia ekonometrii

Ekonometria – nauka o metodach badania ilościowych prawidłowości występujących w

zjawiskach ekonomicznych. Wykorzystuje do tego aparat rachunku prawdopodobieństwa i

statystyki matematycznej oraz algebrę liniową (rachunek macierzowy)

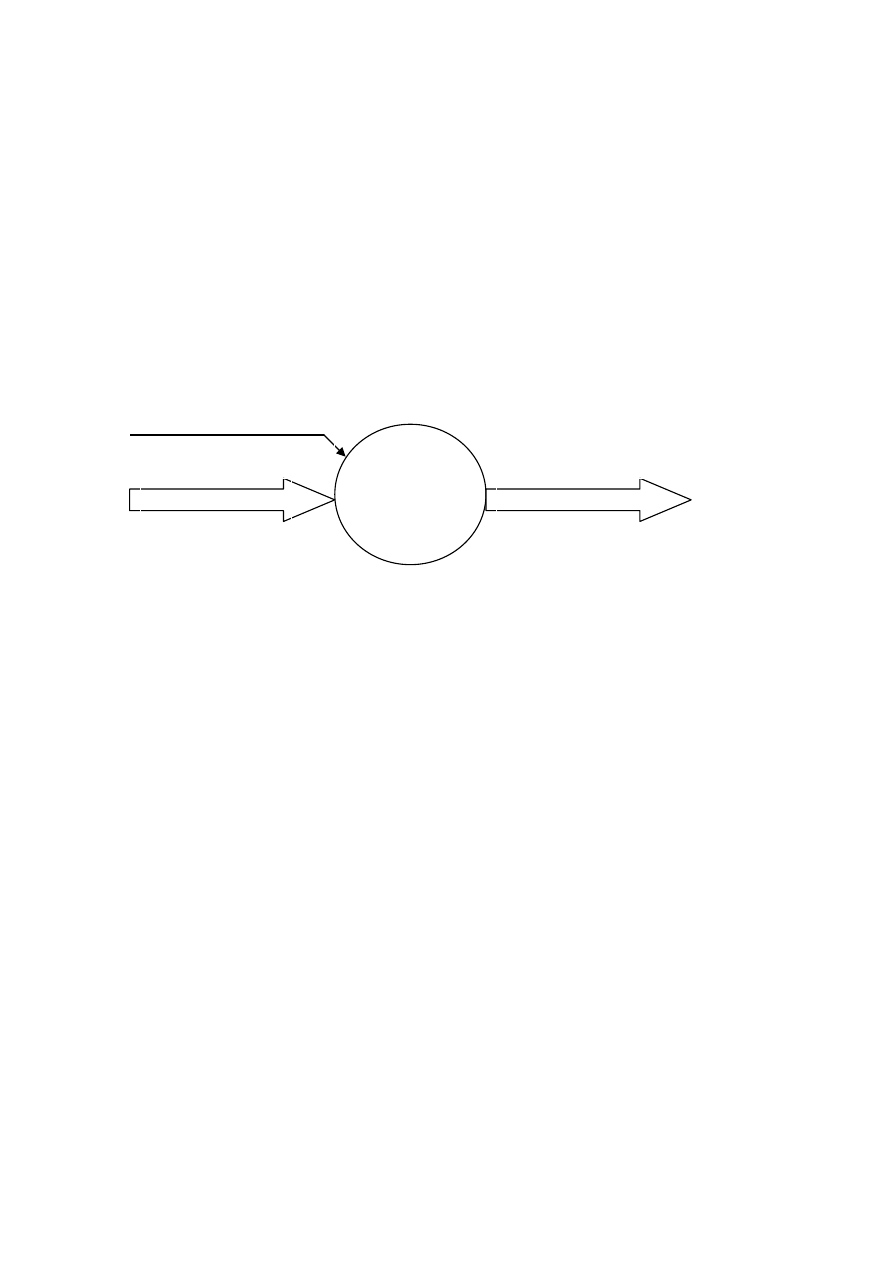

Rys.1. Ekonometryczne ujęcie zjawisk ekonomicznych

Ekonometria zajmuje się poszukiwaniem zależności ekonometrycznych f(X) (tj.

deterministycznych powiązań ilościowych pomiędzy zmiennymi objaśniającymi i

objaśnianymi) oraz analizą probabilistyczną składowej losowej e zmiennych objaśnianych.

Literatura:

1.

Henry Theil: Zasady ekonometrii, PWN, Warszawa, 1979

2.

Zbigniew Pawłowski: Ekonometria, PWN, Warszawa 1969

3.

Edward Nowak: Zarys metod ekonometrii – zbiór zadań, PWN, Warszawa 1994

4.

John Freund Podstawy nowoczesnej statystyki, PWE, Warszawa 1968

5.

G.E.P.Box, G.M.Jenkins: Analiza szeregów czasowych, PWN, Warszawa, 1983

2. Podstawowe poj

ę

cia rachunku prawdopodobie

ń

stwa

Literatura:

1.

I.E. Brontsztejn, K.A.Siemeindiajew: Matematyka – poradnik encyklopedyczny. Część

szósta – Opracowanie danych doświadczalnych,. PWN, Warszawa 1986

2.

Poradnik inżyniera – Matematyka – Rozdziały XXXII i XXXIII

3.

J.Greń: Statystyka matematyczna – modele i zadania, PWN, Warszawa 1982

Definicje intuicyjne: (Foralnie definicje można znależć np. w Poradniku 2)

Badane

zjawiska

ekonomiczne

Zm.egzogeniczne X

Wpływ otoczenia na proces

opisują zmienne objaśniające

(egzogeniczne) X

Wpływ procesu na otoczenie

opisują zmienne objaśniane

(endogeniczne) Y: Y=f(X)+e

e – reprezentacja losowości opisu

Zm.endogeniczne: Y=f(X)+e

Nieznane czynniki losowe v

2

Zdarzenie losowe: zdarzenie, którego zajście leży całkowicie lub częściowo poza zasięgiem

kontroli.

Definuje się:

iloczyn zdarzeń A i B jako równoczesne wystąpienie zdarzenia A i zdarzenia B; (A*B)

sumę (alternatywę) zdarzeń A, B, jako wystąpienie zdarzenia A lub zdarzenia B. (A+B)

zdarzenie przeciwne do A – zdarzenie zachodzące wtedy gdy A nie zachodzi (

~

A)

zdarzenie pewne – zachodzi zawsze (np. A+(

~

A));

zdarzenie niemożliwe – nie zachodzi nigdy (np. A*(

~

A)); oznaczamy go symbolem

∅

zdarzenia rozłączne A, B – takie, że A*B jest zdarzeniem niemożliwym

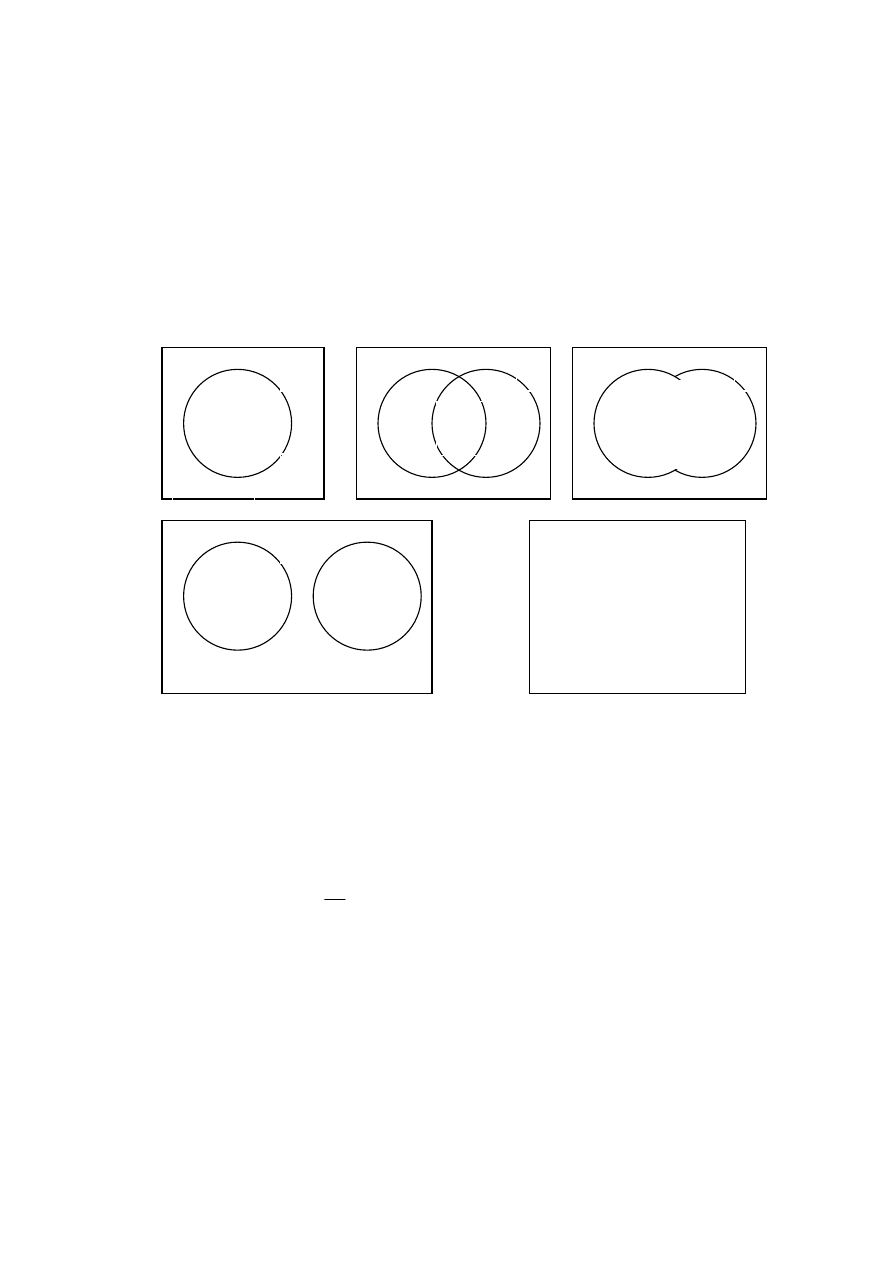

Rys.2. Graficzna ilustracja zdarzeń elementarnych i złożonych:

koła- elementarne zdarzenia losowe, całe ramki – wszystkie zdarzenia możliwe

Prawdopodobieństwo zdarzenia – liczba wyrażająca stopień możliwości zachodzenia

zdarzenia. Prawdopodobieństwo zdarzenia A czyli P(A) jest równe stosunkowi liczby

przypadków sprzyjających zdarzeniu A (n

A

) do wszystkich przypadków możliwych (n):

n

n

A

P

A

=

)

(

Wartość tak zdefiniowanego prawdopodobieństwa ilustrują stosunki pól figur (kół)

reprezentujących zdarzenia A, B na rysunkach powyżej, do pola całej ramki E.

Właściwości prawdopodobieństwa:

1.

Jeśli A, B, .. są zdarzeniami rozłącznymi (wykluczają się wzajemnie) to

P(A lub B lub ..)=P(A)+P(B)+..

(patrz rysunek d)

2.

Jeśli E jest zdarzeniem pewnym to

P(E)=1

(patrz rysunek e)

Stąd wynika, że dla dowolnego zdarzenia A

0

≤

P(A)

≤

1

A

~

A

nieA

A

B

A i B

A*B

A

B

Zdarzenia rozłączne A, B

E

Zdarzenie pewne E

(suma wszystkich zdarzeń

możliwych)

(a)

(b)

A lub B

(A+B)

(c)

(d)

(e)

A+(

~

A)=E

3

P(nieA)=1-P(A)

(patrz rysunek a)

Dla dowolnych zdarzeń A i B

P(A lub B)=P(A)+P(B)-P(A i B)

(patrz rysunki b, c)

Prawdopodobieństwo warunkowe i prawdopodobieństwo całkowite:

Mamy dwa zdarzenia losowe A i B. Niech P(B)>0. Jeśli zdarzenia A i B mogą występować

równocześnie to można mówić o prawdopodobieństwie zajścia zdarzenia A pod warunkiem,

ż

e zaszło zdarzenie B, co oznacza się symbolem P(A|B). W tym przypadku zbiór zdarzeń

możliwych redukuje się do zdarzenia B, zatem (zgodnie z rys.2b) mamy:

)

(

)

(

1

)

(

B

P

B

i

A

P

n

n

n

n

B

A

P

n

n

iB

A

B

iB

A

B

=

⋅

=

=

gdzie

n

n

B

P

n

n

B

i

A

P

B

AiB

=

=

)

(

;

)

(

Prawdopodobieństwo warunkowe nazywane jest prawdopodobieństwem a posteriori (po

uzyskaniu dodatkowej informacji) i na ogół różni się od P(A) zwanego prawdopodobieństwem

a priori (określonym dla dowolnych warunków przy których zachodzi A).

Jeśli w wyniku pewnego doświadczenia losowego realizuje się zawsze jedno z wzajemnie

wykluczających się zdarzeń B

1

, B

2

, .. B

N

(tzn. B

1

+ B

2

+.. B

N

=E oraz B

1

*B

2

=

∅

, B

i

*B

k

=

∅

dla

każdej pary zdarzeń B

i

, B

k

i

≠

k) to dla dowolnego zdarzenia A zachodzi równość:

∑

=

=

⋅

+

⋅

+

⋅

=

N

n

n

N

N

B

i

A

P

B

P

B

A

P

B

P

B

A

P

B

P

B

A

P

A

P

1

2

2

1

1

)

(

)

(

)

(

...

)

(

)

(

)

(

)

(

)

(

Jest to wzór na

prawdopodobieństwo całkowite.

Stosuje się go, gdy prawdopodobieństwa warunkowe P(A|B

n

) oraz prawdopodobieństwa P(A)

albo P(B

n

) są łatwe do oszacowania lub znane. Prawdopodobieństwo wystąpienia zdarzenia B

n

gdy zaszło zdarzenie A liczy się ze wzoru Bayesa:

;

)

(

)

(

)

(

)

(

)

(

)

(

)

(

)

(

)

(

)

(

1

A

P

AiB

P

A

P

B

P

B

A

P

B

P

B

A

P

B

P

B

A

P

A

B

P

n

n

n

N

i

i

i

n

n

n

=

⋅

=

⋅

⋅

=

∑

=

Jeśli zdarzenie B nie wpływa na prawdopodobieństwo zdarzenia A to zdarzenia A, B są

zdarzeniami niezależnymi. Wówczas obowiązuje zależność:

);

(

)

(

A

P

B

A

P

=

zatem

)

(

)

(

)

(

B

P

A

P

B

i

A

P

⋅

=

Zdarzenia A, B są zatem niezależne, gdy mogą występować w różnych okolicznościach, a ich

łączne wystąpienie jest tylko całkowicie przypadkowe.

Założenie niezależności zdarzeń jest

często wykorzystywane w obliczeniach probabilistycznych. W ekonometrii mamy na ogół

do czynienia ze zdarzeniami współzależnymi, ale założenie niezależności pozwala dokonać

zgrubnych oszacowań prawdopodobieństw iloczynu zdarzeń.

Zmienne losowe: liczby charakteryzujące rezultat zjawiska losowego

Zmienne losowe dyskretne – liczby losowe ze skończonego lub przeliczalnego zbioru

wartości. Na ogół są to liczby całkowite symbolizujące rozważane zdarzenia losowe,

zliczające ich krotność itp.

Zmienne losowe ciągłe: liczby rzeczywiste o losowej wartości, charakteryzujące ilościowo

zjawiska losowe:

4

Zdarzenia losowe odniesione do liczb losowych dotyczą wystąpienia określonych wartości

zmiennych dyskretnych oraz wystąpienia wartości zmiennych ciągłych w określonych

przedziałach.

Prawdopodobieństwa takich zdarzeń charakteryzują rozkłady prawdopodobieństwa

zmiennych losowych:

Dystrybuantą rozkładu zmiennej losowej x nazywamy prawdopodobieństwo wystąpienia

wartości x mniejszej niż argument dystrybuanty (założona wartość zmiennej) X.

F(X) = P(x < X)

Dystrybuanta posiada następujące cechy:

1.

F(-

∞

)=0;

2.

F(

∞

)=1;

3.

jest funkcją lewostronnie ciągłą i niemalejącą, tzn., jeśli X

1

<X

2

to F(X

1

)

≤

F(X

2

)

Dystrybuanta zmiennej losowej dyskretnej zmienia się skokowo w punktach

odpowiadających kolejnym wartościom zmiennej.

Rozkład prawdopodobieństwa takich zmiennych wygodniej jest charakteryzować podając

wprost prawdopodobieństwa wystąpienia poszczególnych wartości p(x

i

). Nazywa się to

krótko rozkładem prawdopodobieństwa zmiennych dyskretnych:

f(x)={p(x

i

); i=1,2, ...,N}, gdzie N oznacza liczbę możliwych wartości zmiennej x

W przypadku zmiennych losowych ciągłych (dokładnie – absolutnie ciągłych – patrz

Poradnik [2]) rozkład opisuje się tzw. funkcją gęstości prawdopodobieństwa f(x), którą

definiuje się jako pochodną dystrybuanty względem zmiennej x, tzn. w następujący sposób:

)

(

)

(

)

(

lim

)

(

2

2

x

F

dx

d

x

x

F

x

F

x

f

x

x

o

x

=

∆

−

−

+

=

∆

∆

→

∆

Zgodnie z własnością (3) dystrybuanty funkcja f(x) jest nieujemna

Uwaga !! Funkcja gęstości prawdopodobieństwa nie jest prawdopodobieństwem, ale pozwala

obliczyć prawdopodobieństwo wystąpienia wartości X w zadanym przedziale x

1

, x

2

z wzoru:

∫

⋅

=

≤

≤

2

1

)

(

)

(

2

1

x

x

dx

x

f

x

X

x

P

Wynika stąd, że

∫

∞

−

⋅

=

X

dx

x

f

X

F

)

(

)

(

oraz

∫

∞

∞

−

=

⋅

1

)

(

dx

x

f

Parametry rozkładu prawdopodobieństwa jednowymiarowych zmiennych losowych:

Rozkład prawdopodobieństwa zmiennej ciągłej charakteryzuje się przy pomocy parametrów

zwanych momentami. Moment i-tego rzędu m

i

(x) definiuje się następująco:

dx

x

f

x

x

m

i

i

⋅

⋅

=

∫

∞

∞

−

)

(

)

(

Moment rzędu zerowego jest zawsze równy 1.

Moment rzędu pierwszego zmiennej X nazywa się

wartością oczekiwaną zmiennej losowej

X, a operację jego obliczania oznacza się symbolem E(X).

5

Wartość oczekiwana jest też nazywana wartością przeciętną zmiennej losowej lub nadzieją

matematyczną.

Dla zmiennej losowej ciągłej wartość oczekiwaną wyraża wzór:

dX

X

f

X

X

E

X

m

def

⋅

⋅

=

=

∫

∞

∞

−

)

(

)

(

)

(

1

Dla zmiennej dyskretnej przyjmującej wartości x

i

z prawdopodobieństwem p

i

wartość

oczekiwaną oblicza się ze wzoru:

∑

∞

=

⋅

=

1

)

(

i

i

i

x

p

x

E

Właściwości wartości oczekiwanej:

1.

Każda ograniczona zmienna losowa ma wartość oczekiwaną.

2.

Wartość oczekiwana kombinacji liniowej zmiennych losowych jest kombinacją liniową

ich wartości oczekiwanych

)

(

...

)

(

)

(

)

...

(

2

2

1

1

2

2

1

1

N

N

N

N

x

E

a

x

E

a

x

E

a

x

a

x

a

x

a

E

⋅

+

+

⋅

+

⋅

=

+

+

+

3.

Jeśli

x

1

i

x

2

są niezależnymi zmiennymi losowymi to

)

(

)

(

)

(

2

1

2

1

x

E

x

E

x

x

E

⋅

=

⋅

Zmienna losowa ciągła

x będąca odchyłką zmiennej losowej oryginalnej X od jej wartości

oczekiwanej

m

1

(

X) nazywa się zmienną losową scentrowaną:

);

(

1

X

m

X

x

def

−

=

Oczywiście E(

x)=0

Momenty wyższego rzędu można obliczać dla oryginalnych zmiennych lub scentrowanych.

Momenty dla zmiennych scentrowanych nazywa się momentami centralnymi.

Centralny moment rzędu drugiego zmiennej nazywa się wariancją zmiennej

2

x

σ

∫

∫

∞

∞

−

∞

∞

−

=

−

=

=

=

−

=

σ

dx

x

f

x

dX

X

f

X

E

X

x

E

x

m

X

E

X

m

X

)

(

)

(

)]

(

[

)

(

)

(

)]

(

[

2

2

2

2

2

2

Właściwości wariancji:

1.

Znając pierwszy i drugi moment oryginalnej zmiennej losowej X można obliczyć jej

wariancję:

)

(

)

(

)

(

)

(

2

1

2

2

2

2

X

m

X

m

X

E

X

E

X

−

=

−

=

σ

bo:

)

(

)

(

)

(

)

(

2

)

(

)

(

)

(

)

(

)

(

2

)

(

)

(

)]

(

[

2

2

2

2

2

2

2

2

X

E

X

m

X

E

X

E

X

m

dX

X

f

X

E

dX

X

f

X

X

E

dX

X

f

X

dX

X

f

X

E

X

−

=

+

⋅

−

=

=

+

⋅

−

=

−

∫

∫

∫

∫

∞

∞

−

∞

∞

−

∞

∞

−

∞

∞

−

2.

Jeśli

x

1

,

x

2

...

x

N

są niezależnymi zmiennymi losowymi to

2

2

2

2

2

2

2

1

2

1

2

2

2

1

1

]

)

[(

xN

N

x

x

N

N

a

a

a

x

a

x

a

x

a

E

σ

+

+

σ

+

σ

=

+

+

+

Κ

Κ

Odchyleniem średnim (standardowym) lub

dyspersją

σσσσ

zmiennej losowej nazywamy

pierwiastek arytmetyczny z jej wariancji

.

Odchyleniem przeciętnym

β

X

zmiennej losowej X nazywamy wartość oczekiwaną modułu

scentrowanej zmiennej

x

β

X

=E(|X-E(X)|)

6

Parametry pozycyjne rozkładu – kwantyle

Kwantylem rzędu p zmiennej losowej x nazywamy taką wartość

λ

p

zmiennej, że

P(x

≤

λ

p

)

≥

p

P(x

≥

λ

p

)

≥

1-p

Kwantyl rzędu p=1/2 nazywa się medianą (jest to wartość zmiennej losowej rozdzielająca jej

zakres na dwie części o jednakowym prawdopodobieństwie wystąpienia p=0.5.

Kwantyle rzędu p=1/4 i ¾ nazywają się odpowiednio kwantylem górnym i dolnym.

Kwantyle rzędu p=0.1, 0.2 ....0.9 nazywa się decylami.

Zmienną losową o wartości oczekiwanej 0 i wariancji 1 nazywamy zmienną losową

standaryzowaną.

Jeśli mamy zmienną losową X o wartości oczekiwanej E(X) i dyspersji

σ

X

to odpowiadającą

jej zmienną standaryzowaną x uzyskuje się przez przekształcenie

X

X

E

X

x

σ

−

=

)

(

i odwrotnie, mając

zmienną standaryzowaną x, np. odczytaną z tablic rozkładu, uzyskuje się

zmienną X o zadanej :

)

( X

E

x

X

X

+

σ

⋅

=

Zmienne losowe wielowymiarowe

Jeśli rozważamy kilka zbiorów liczb losowych to mówimy o

zmiennej losowej wielowymiarowej.

Dystrybuantę zmiennej wielowymiarowej X=[X

1,

X

2,

... X

N

] definiuje się jako

prawdopodobieństwo zdarzenia polegającego na równoczesnym wystąpieniu wszystkich

rozważanych liczb losowych mniejszych od zadanych argumentów dystrybuanty [X

1,

X

2,

. X

N

]

F(X

1,

X

2,

... X

N

)=P[(x

1

<X

1

) i (x

2

<X

2,

) ...i (x

N

<X

N

)]

Wielowymiarowa zmienna losowa ma rozkład absolutnie ciągły jeśli istnieje taka funkcja

f(x

1,

x

2,

... x

N

) zwana

wielowymiarową gęstością prawdopodobieństwa, że

∫ ∫ ∫

∞

−

∞

−

∞

−

=

1

2

2

1

2

1

2

1

.

)

,

,.

(

)

,

,

(

x x

x

N

N

N

N

dx

dx

dx

x

x

x

f

X

X

X

F

Κ

Κ

Λ

Κ

Zmienne losowe X

1,

X

2,

... X

N

są niezależne, jeśli ich łączna dystrybuanta jest iloczynem

dystrybuant poszczególnych zmiennych:

F(X

1,

X

2,

... X

N

)=F(x

1

<X

1

)*F(x

2

<X

2,

)*...*F(x

N

<X

N

)

Zmienne losowe absolutnie ciągłe są niezależne, jeśli ich wielowymiarowa funkcja gęstości

prawdopodobieństwa jest iloczynem funkcji gęstości dla poszczególnych zmiennych:

Rozkłady brzegowe i warunkowe zmiennych losowych wielowymiarowych

Niech f(x

,

y) oznacza dwuwymiarowy rozkład zmiennych x, y.

Rozkładami brzegowymi są funkcje:

7

∫

∞

∞

−

=

.

)

,

(

)

(

dy

y

x

f

x

f

x

∫

∞

∞

−

=

dx

y

x

f

y

f

y

)

,

(

)

(

Oczywiście, obie spełniają warunek podstawowy:

∫

∞

∞

−

=

1

dx

x

f

x

)

(

i

∫

∞

∞

−

=

1

)

(

dy

y

f

y

Rozkładami warunkowymi są natomiast funkcje:

∫

∞

∞

−

=

=

=

dx

y

x

f

y

x

f

y

f

y

x

f

y

Y

x

f

y

x

)

,

(

)

,

(

)

(

)

,

(

)

(

0

0

0

0

0

oraz

∫

∞

∞

−

=

=

=

dy

y

x

f

y

x

f

x

f

y

x

f

x

X

y

f

x

y

)

,

(

)

,

(

)

(

)

,

(

)

(

0

0

0

0

0

Kowariancja zmiennych losowych X, Y – wartość oczekiwana iloczynu scentrowanych

zmiennych x, y:

cov(

X,Y)=E(x

⋅

y)=

)

(

)

(

)

(

)

,

(

)]

(

[

)]

(

[

Y

E

X

E

Y

X

E

dY

dX

Y

X

f

Y

E

Y

X

E

X

⋅

−

⋅

=

⋅

⋅

⋅

−

⋅

−

∫ ∫

∞

∞

−

∞

∞

−

Współczynnik korelacji

ρρρρ

XY

zmiennych X i Y to ich kowariancja przeliczona do zakr. [–1, 1]

ρ

XY

=cov(X,Y)/(

σ

x

⋅σ

y

)

Współczynnik korelacji przyjmuje wartość 0 gdy zmienne X, Y są niezależne i wartość

±

1

gdy są one

zależne liniowo (ale tylko liniowo np. X=a+bY, a, b stałe);

Wynika to z następujących rachunków:

cov(X

⋅

Y)=E(a

⋅

Y+b

⋅

Y

2

)-E(Y)

⋅

E(X)=a

⋅

E(Y)+b

⋅

E(Y

2

)-E(Y)

⋅

[a+b

⋅

E(Y)]=

=b

⋅

{E(Y

2

)-[E(Y)]

2

}=b

⋅σ

2

Y

σ

2

X

=E[(a+b

⋅

Y)

2

]-[E(a+b

⋅

Y)]

2

=E(a

2

+2a

⋅

bY+b

2

⋅

Y

2

)-[a+b

⋅

E(Y)]

2

=

=a

2

+2a

⋅

b

⋅

E(Y)+b

2

⋅

E(Y

2

)-a

2

-2a

⋅

b

⋅

E(Y)-b

2

⋅

[E(Y)]

2

=b

2

⋅

{E(Y

2

)-[E(Y)]

2

}=b

2

⋅σ

Y

2

Zatem

σ

X

⋅σ

Y

=|b|

⋅σ

Y

, czyli

ρ

XY

=cov(X

⋅

Y)/(

σ

X

⋅σ

Y)

=b/|b|=

±

1

UWAGA !!

Niezerowe, a nawet wysokie wartości współczynnika korelacji dwóch zmiennych

losowych nie oznaczają związku przyczynowo-skutkowego między nimi, a jedynie

współzależność stochastyczną, czyli istnienie wspólnych przyczyn dla obu zjawisk

Procesy stochastyczne

Procesem stochastycznym nazywa się zmienną losową sparametryzowaną czasem (ogólnie –

dowolną zmienną skalarną).

Z=(X,t)=X

t

Oznacza to, że

każdej chwili czasu t

o

przypisuje się zbiór zmiennych losowych X

to

(zwany

zbiorem możliwych realizacji procesu Z w chwili

t

o

), z jego wartością oczekiwaną E(

X

to

) i

rozkładem prawdopodobieństwa f(

X

to

).

8

Proces stochastyczny jest zatem szczególnym przypadkiem wielowymiarowej zmiennej

losowej i można dla niego definiować wielowymiarowe rozkłady prawdopodobieństwa

f(X

to

, X

t1

, .. , X

tN

), a także kowariancje cov(X

to

, X

t1

) odpowiadające różnym t

o

, t

1

(zwane

autokowariancjami lub funkcjami korelacyjnymi). Określa się je identycznie jak dla

wielowymiarowych zmiennych losowych. Współczynnik korelacji odpowiadający dwóm

różnym wartościom t, nazywa się współczynnikiem autokorelacji procesu.

Ważną klasą procesów stochastycznych są procesy stacjonarne.

Proces stochastyczny jest stacjonarny w węższym sensie jeśli wszystkie jego rozkłady

prawdopodobieństwa nie zależą od czasu, a jedynie od różnic wartości t

o

, t

1

, .. , t

N

dla

których są definiowane.

Zatem jednowymiarowe rozkłady prawdopodobieństwa zmiennych X

t

dla kolejnych t są

identyczne, czyli f(X

t

)=f(X), a rozkłady dwuwymiarowe f(X

t1

, X

t2

) zależą tylko od różnicy

czasów

τ

=t

2

-t

1

, tzn. f(X

t1

, X

t2

) = f(X,

τ

).

Także autokowariancja i współczynnik autokorelacji zależą tylko od

τ

. Nazywa się je funkcją

korelacyjną K

X

(

τ

) i funkcją autokorelacji r(

τ

)

)

(

))

(

(

)

(

)

(

2

τ

−

τ

−

⋅

=

−

⋅

=

τ

t

t

t

t

def

X

x

x

E

X

E

X

X

E

K

2

2

2

)

(

))

(

(

)

(

)

(

σ

⋅

=

σ

−

⋅

=

τ

τ

−

τ

−

t

t

t

t

def

X

x

x

E

X

E

X

X

E

r

czyli

2

)

(

)

(

σ

τ

=

τ

X

def

X

K

r

gdzie x

t

oznacza proces scentrowany (tj. E(x)=0).

Wartość funkcji autokorelacji w zerze wynosi zawsze 1, r(0)=1

Proces stochastyczny jest stacjonarny w szerszym sensie jeśli istnieje jego wartość

oczekiwana i jest ona stała w czasie, a funkcje korelacyjne zależą tylko od przesunięcia

czasu

ττττ

(nie zależą od wartości t

o

, t

1

):

m

X

(t)=E(X

t

)=m

X

=const

K

X

(t

1

, t

2

)=E(x

t1

⋅

x

t2

)=K

X

(

τ

)

Zatem procesy stochastyczne stacjonarne mają stałą wartość oczekiwaną, a relacje

probabilistyczne między ich wartościami w różnych chwilach czasu są określone

(deterministycznie) przez funkcję autokorelacji r(

τ

).

Mówimy, że funkcja autokorelacji opisuje właściwości dynamiczne procesu

stochastycznego stacjonarnego, natomiast jego właściwości chwilowe (statyczne)

charakteryzuje funkcja gęstości prawdopodobieństwa, czyli rozkład prawdopodobieństwa

Im wolniej maleje funkcja autokorelacji, tym mniej losowe są zmiany w czasie procesu, tzn.

zmiany te są powodowane głównie wewnętrzną inercją procesu, a nie czynnikami losowymi.

Transformata Fouriera funkcji autokorelacji nazywa się funkcją gęstości widmowej mocy

procesu lub spektrum procesu

UWAGA:

Funkcje analogiczne jak funkcja korelacyjna mogą być definiowane dla dwu różnych

procesów stochastycznych stacjonarnych przesuniętych względem siebie w czasie.

9

Modelowe rozkłady prawdopodobieństwa

Szereg zjawisk losowych można opisać rozkładami prawdopodobieństwa, których gęstości są

stosunkowo prostymi funkcjami analitycznymi zmiennej losowej.

Modelowe rozkłady prawdopodobieństwa dla zmiennych dyskretnych (I.E. Brontsztejn,

K.A.Siemeindiajew: Matematyka – poradnik encyklopedyczny. Część szósta –

Opracowanie danych doświadczalnych,. PWN, Warszawa 1986, str.782)

1.

Rozważmy zdarzenie losowe (zwane sukcesem) występujące w pewnym procesie

losowym ze stałym prawdopodobieństwem p>0. Prawdopodobieństwo nie wystąpienia

sukcesu wynosi (1-p).

Jeśli przeprowadzimy n niezależnych doświadczeń, to liczba sukcesów S

n

jest liczbą

losową o rozkładzie dwumianowym:

k

n

k

n

p

p

k

n

k

S

P

−

−

⋅

⋅

=

=

)

1

(

)

(

wartość oczekiwana E(S

n

)=n

⋅

p;

wariancja

2

Sn

σ

=n

⋅

p

⋅

(1-p)

2.

Prawdopodobieństwo łącznej liczby wystąpień X pewnego rzadkiego zdarzenia (o

małym prawdopodobieństwie) oblicza się z rozkładu Poissona, który jest przybliżeniem

rozkładu dwumianowego dla

∞

→

n

i

0

→

p

ale tak, że

0

>

λ

→

⋅

p

n

.

λ

−

λ

=

=

e

k

k

X

P

k

!

)

(

wartość oczekiwana E(X)=

λ

;

wariancja

λ

=

σ

2

X

Rozkład ten jest w praktyce stosowalny już dla n rzędu kilkudziesięciu, przy

λ

<10.

Przykładem zmiennej X może być liczba klientów zainteresowanych - w pewnym

przedziale czasu - luksusowym artykułem w sklepie odwiedzanym przez wielu klientów

zainteresowanych na ogół innymi artykułami (np. w kiosku). Można go wykorzystać do

oceny opłacalności zamawiania takich artykułów.

3.

Rozważmy sytuację jak w (1), ale gdy interesuje nas prawdopodobieństwo zdarzenia

polegającego na wystąpieniu

serii k sukcesów, po których następuje brak sukcesu.

Zakładając niezależność kolejnych prób uzyskuje się wyrażenie zwane

rozkładem

geometrycznym dyskretnej zmiennej losowej X wyrażającej długość serii niezależnych

sukcesów o jednakowym prawdopodobieństwie wystąpienia:

)

1

(

)

(

p

p

k

X

P

k

−

⋅

=

=

wartość oczekiwana

p

p

S

E

n

−

=

1

)

(

;

wariancja

2

2

)

1

(

p

p

X

−

=

σ

Modelowe rozkłady prawdopodobieństwa dla zmiennych ciągłych (I.E. Brontsztejn,

K.A.Siemeindiajew: Matematyka – poradnik encyklopedyczny. Część szósta –

Opracowanie danych doświadczalnych,. PWN, Warszawa 1986, str.783 i dalsze)

1.

Rozkład wykładniczy określa rozstęp czasowy x pomiędzy wystąpieniami zdarzenia

którego prawdopodobieństwo zależy tylko od przedziału czasu w którym się go oczekuje,

a nie zależy od czasu trwania procesu losowego (np. czas pomiędzy nadejściem dwu

kolejnych klientów, czas pomiędzy awariami urządzenia)

10

<

≥

⋅

=

−

0

0

0

)

(

x

gdy

x

gdy

e

a

x

f

ax

≥

−

<

=

−

0

1

0

0

)

(

x

dla

e

x

dla

x

F

ax

wartość oczekiwana E(x)=1/a; wariancja

2

2

1

a

X

=

σ

Jest to ciągły odpowiednik rozkładu geometrycznego, gdy x=k

⋅δ

t, a=(1-p)/

δ

t, 1-p=a

⋅δ

t,

δ

t

≅

0. (1-p) – prawdopodobieństwo wystąpienia zdarzenia

2.

Rozkład równomierny ma zmienna losowa x, gdy może przyjmować z tym samym

prawdopodobieństwem dowolną wartość z przedziału [a-b, a+b], b>0 i nie występuje poza

tym przedziałem:

+

−

∉

+

−

∈

=

]

,

[

0

]

,

[

2

1

)

(

b

a

b

a

x

gdy

b

a

b

a

x

gdy

b

x

f

wartość oczekiwana E(x)=a; wariancja

3

2

2

b

X

=

σ

Rozkład równomierny przypisuje się zmiennym losowym, których wartości są naturalnie

ograniczone i wynikają z oddziaływania pewnego czynnika o czysto losowym charakterze

i ograniczonej „sile”. Przykładowo, taki rozkład może mieć kwota wydawana przez

jednego klienta w małym sklepie spożywczym lub kiosku.

3.

Rozkład normalny czyli rozkład Gaussa: dla zmiennej X o wartości oczekiwanej m=E(X)

i dyspersji

σ

(oznaczany symbolem

N(m,

σσσσ

)):

σ

⋅

−

−

π

⋅

σ

=

2

2

2

)]

(

[

exp

2

1

)

(

X

E

X

X

f

Dla zmiennej standaryzowanej x rozkład Gaussa N(0, 1) ma postać

−

π

=

2

exp

2

1

)

(

2

x

x

f

i w tej postaci jest on dostępny w tablicach i generatorach liczb

Dystrybuanta rozkładu Gaussa jest funkcją nieanalityczną zapisywaną w postaci:

∫

∫

−

∞

−

+

=

−

π

+

=

−

π

=

x

x

x

x

erf

dt

t

dt

t

x

F

2

1

2

1

2

exp

2

2

1

2

1

2

exp

2

1

)

(

2

2

gdzie

erf(x) (error function – funkcja błędu) jest definiowana jako

( )

∫

−

−

π

=

−

∈

⋅

=

x

x

dt

t

x

x

t

P

x

erf

2

exp

2

1

])

,

[

2

(

)

(

Wartości funkcji

erf(x) dla x=1/

2

, 2/

2

, 3/

2

(czyli w otoczeniu wartości

oczekiwanej o szerokości

σσσσ

, 2

⋅⋅⋅⋅σσσσ

, 3

⋅⋅⋅⋅σσσσ

), wynoszą:

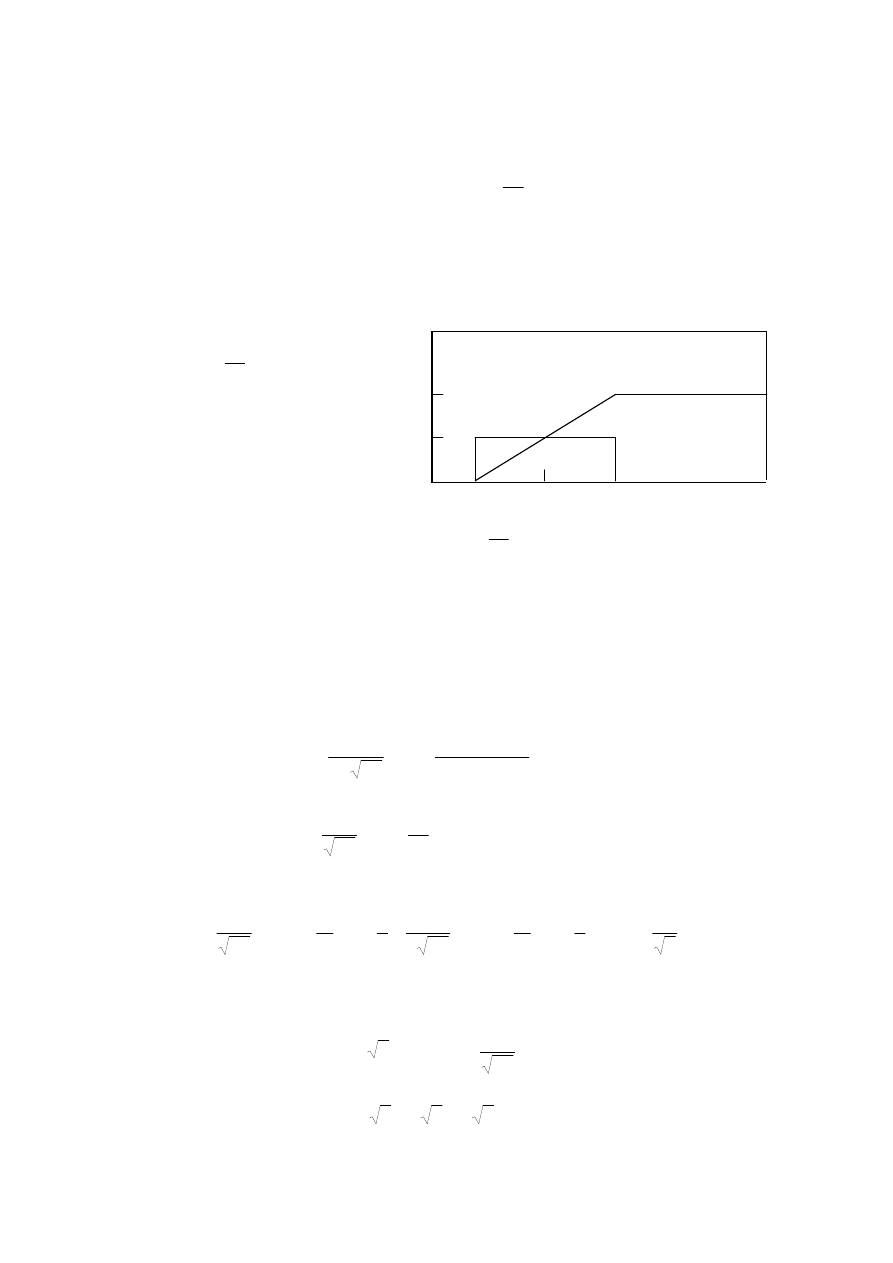

F(x)

0

f(x)

Dystrybuanta i gęstość rozkładu równomiernego

a+b

a-b

x

1

x=a

11

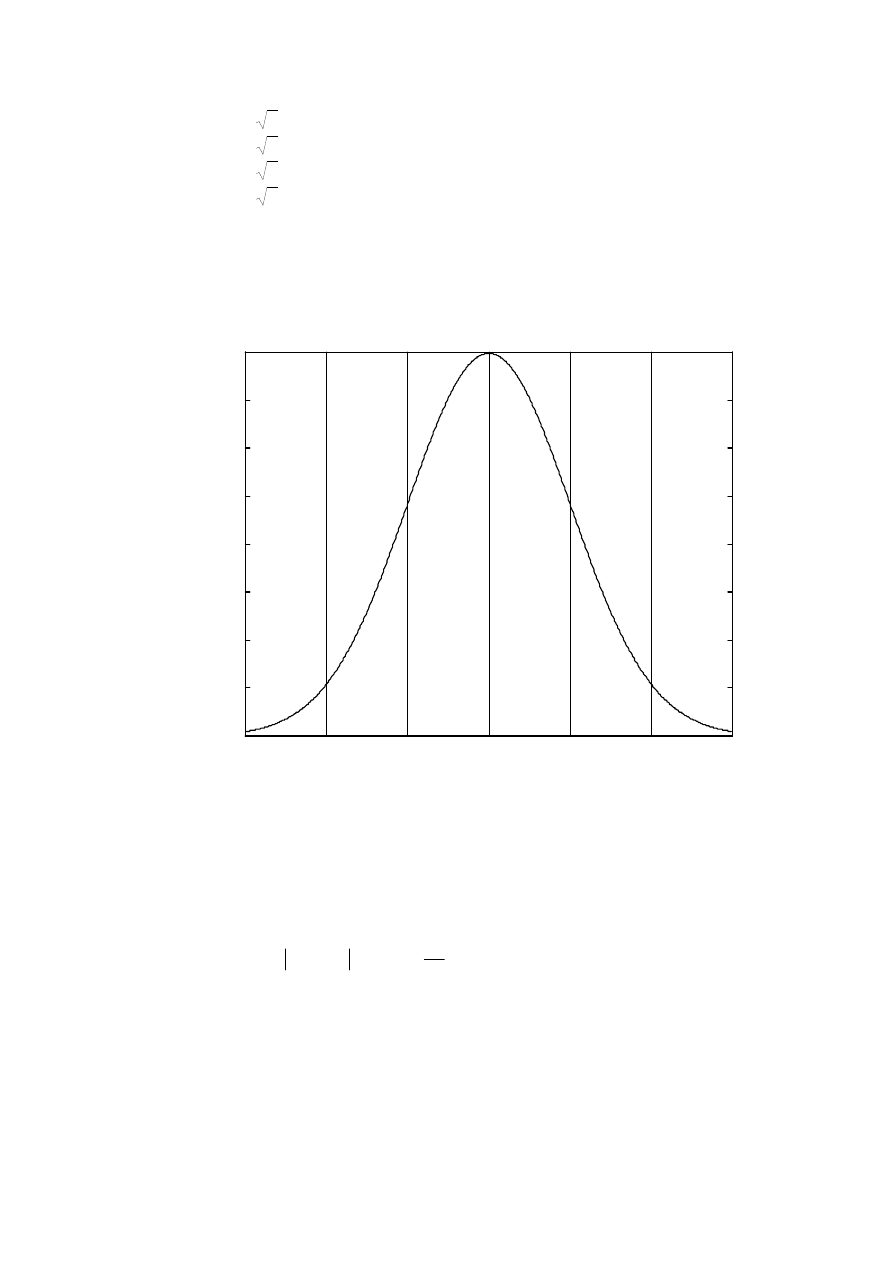

erf(1/

2

)=0.6827=68.3%

erf(2/

2

)=0.9545=95.5%

erf(3/

2

)=0.9973=99.7%

erf(4/

2

)=0.9999=99.99%

Jak widać, zmienne losowe o rozkładzie normalnym praktycznie mieszczą się w zakresie (m-

3

⋅⋅⋅⋅σσσσ

, m+3

⋅⋅⋅⋅σσσσ

) (z prawdopodobieństwem 99.7%). Jest to tzw. zasada trzech sigm.

UWAGA !!! Wartość erf(x) wylicza w MATLABie funkcja o nazwie erf()

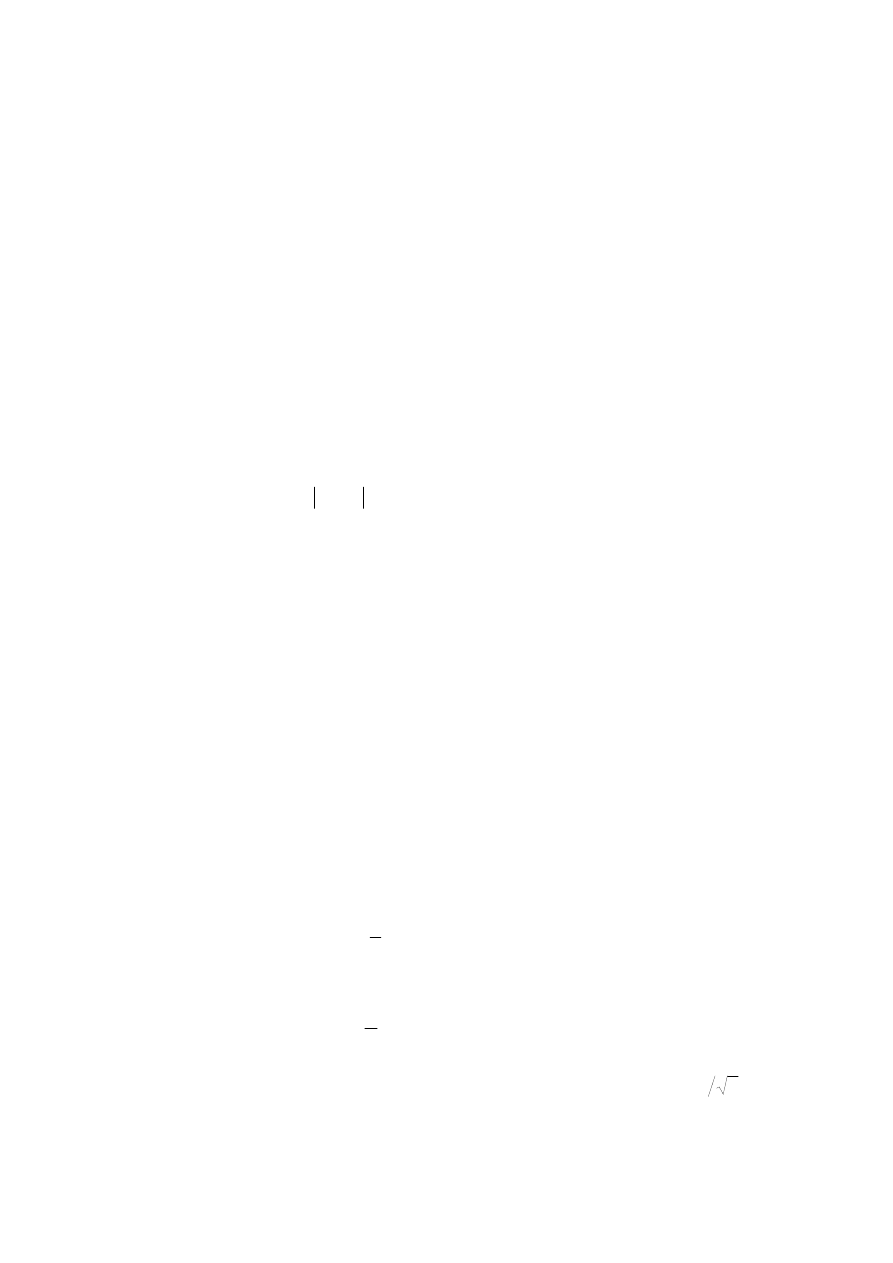

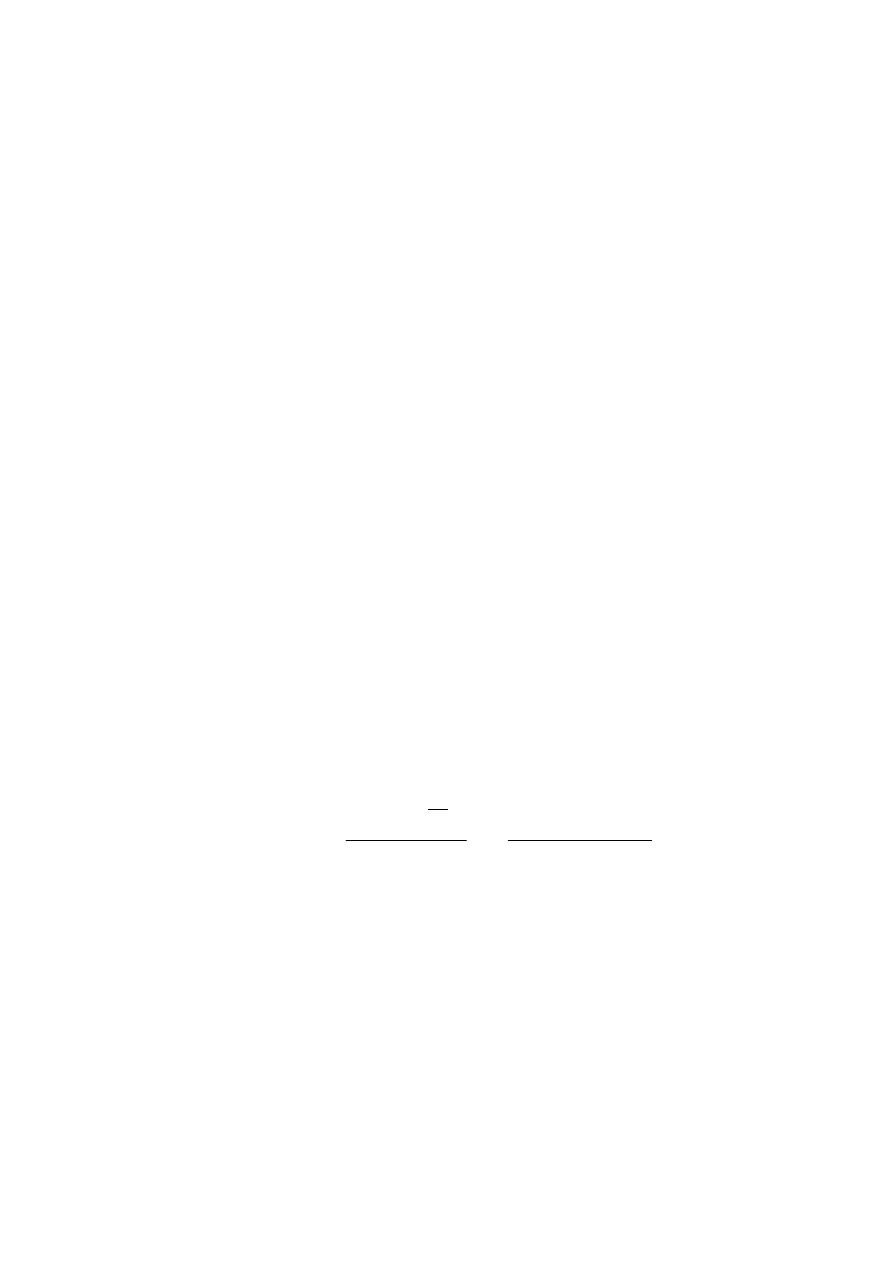

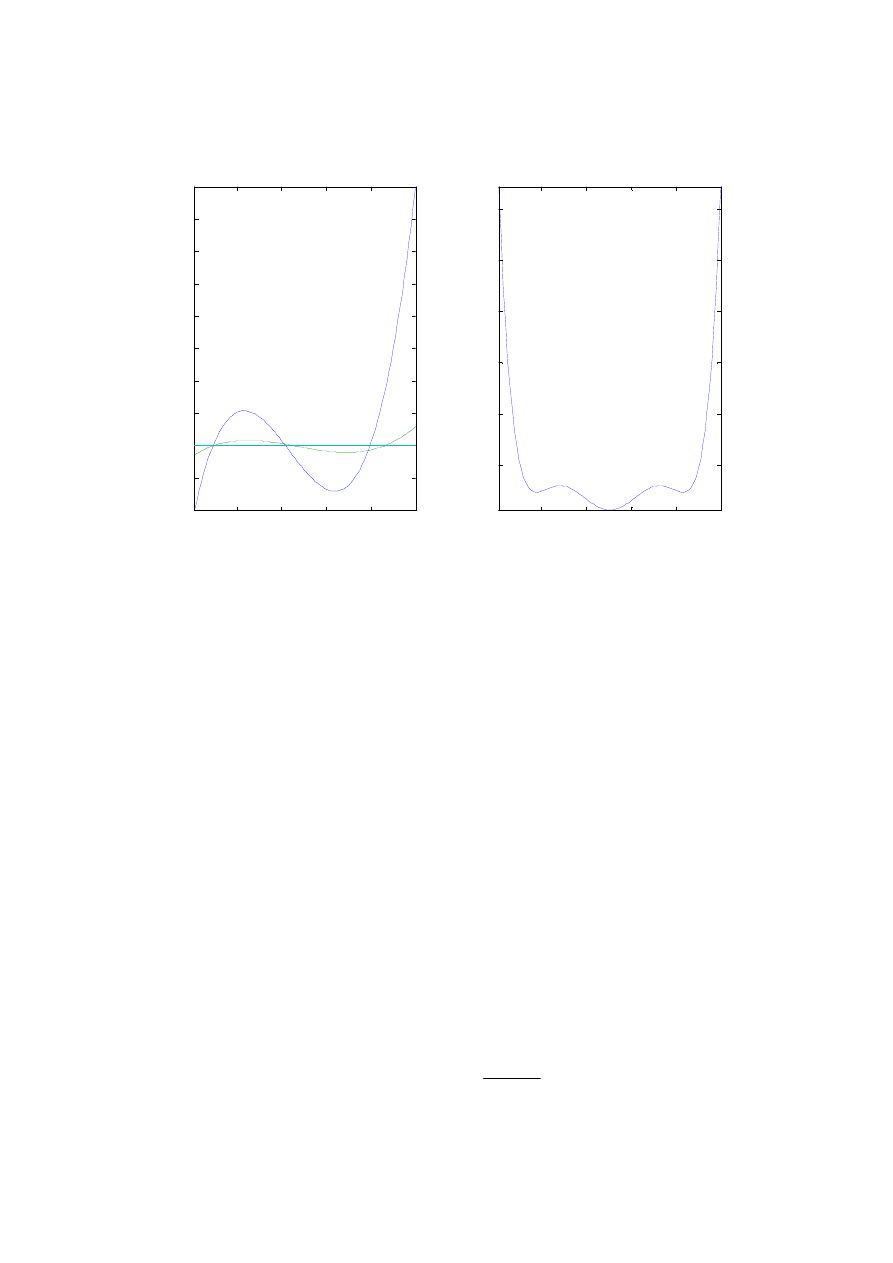

Rys. 3. Rozkład Gaussa N(0,1) dla standaryzowanej zmiennej losowej x

UZUPEŁNIENIE: Zasada trzech sigm stosuje się dla liczb losowych o dowolnym

rozkładzie.

Ujmuje to ogólnie nierówność Czebyszewa. Niech x oznacza zmienną losową o dowolnym

rozkładzie z ograniczoną wartością oczekiwaną E(x) i ograniczoną wariancją

σ

2

. Wówczas

(

)

2

1

)

(

k

k

x

E

x

P

≤

σ

⋅

>

−

Zatem, dowolna zmienna losowa mieści się w zakresie trzech sigm z prawdopodobieństwem

co najmniej 90%.

Rozkład normalny mają zmienne losowe, których wartości są zależne od wielu czynników,

przy czym każdy z nich indywidualnie ma mały wpływ na tę wartość. Z taką sytuacją mamy

bardzo często do czynienia w praktyce, w tym również w ekonometrii, dlatego rozkład

normalny odgrywa bardzo ważną rolę w zastosowaniach rachunku prawdopodobieństwa i w

statystyce matematycznej.

-3

-2

-1

0

1

2

3

0

0.05

0.1

0.15

0.2

0.25

0.3

0.35

0.4

x

f(x)

12

Formalnie ujmują to tzw. twierdzenia graniczne (patrz I.E. Brontsztejn, K.A.Siemeindiajew:

Matematyka – poradnik encyklopedyczny. Część szósta – Opracowanie danych

doświadczalnych,. PWN, Warszawa 1986, Poradnik inżyniera – Matematyka – Rozdział

XXXII).

1. Twierdzenie Lindberga-Leviego: Niech x

1,

x

2,

x

3,

... x

n,

będzie ciągiem niezależnych

zmiennych losowych, o jednakowym rozkładzie, posiadających wartość oczekiwaną m i

wariancję

σ

2

. Wtedy dla każdego rzeczywistego X spełniona jest relacja:

dy

y

X

n

m

n

x

P

X

n

k

k

n

⋅

−

π

=

<

⋅

σ

⋅

−

∫

∑

∞

−

=

∞

→

2

exp

2

1

lim

2

1

Oznacza to, że suma n takich zmiennych przy dużej liczbie składników n ma rozkład zbliżony

do normalnego z

wariancją równą n

⋅⋅⋅⋅σσσσ

2

i wartością oczekiwaną równą

n

⋅⋅⋅⋅

m.

Można pokazać, że jeśli liczby x

1,

x

2,

x

3,

... x

n

mają rozkład równomierny to już dla n

zbliżonych do 10 uzyskuje się praktycznie rozkład normalny.

2. Twierdzenie Lapunowa mówi, że

suma zmiennych x

1,

x

2,

x

3,

... x

n

zmierza do rozkładu

normalnego także wówczas, gdy mają one różne rozkłady, różne wartości oczekiwane m

k

i

wariancje

2

k

σ

, ale muszą mieć odpowiednio silnie ograniczone momenty centralne rzędu

trzeciego b

k

=E(|x

k

–m

k

|

3

), tak aby spełniony był następujący warunek:

0

lim

3

1

=

σ

∑

=

∞

→

n

k

k

n

b

;

gdzie

∑

=

σ

=

σ

n

k

k

1

2

jest dyspersją sumy zmiennych.

Wartość oczekiwana m rozkładu sumy takich liczb jest oczywiście sumą m

k

dla k=1, 2, ..n.

Z powyższego wynika, że

suma niezależnych zmiennych losowych o dowolnych

symetrycznych rozkładach (czyli o zerowych b

k

, ale posiadających ograniczone wartości

oczekiwane i ograniczone wariancje),

zmierza do rozkładu normalnego. Oczywiście,

zbieżność jest w tym przypadku wolniejsza niż dla liczb z Twierdzenia Lindberga-Leviego.

3.Lokalne twierdzenie graniczne Moivre’a-Laplace’a:

Rozkład dwumianowy o ustalonym

prawdopodobieństwie sukcesu p

zmierza do rozkładu normalnego, gdy liczba prób n

rośnie do nieskończoności.

Liczbę sukcesów S

n

w takiej sytuacji można obliczać jako zmienną losową (ciągłą) o

rozkładzie normalnym z wartością oczekiwaną m=n

⋅

p i wariancją

σ

2

= n

⋅

p

⋅

(1-p). Formalnie

zapisuje się to w postaci:

dy

y

b

p

p

n

p

n

S

a

P

b

a

n

n

⋅

−

π

=

≤

−

⋅

⋅

⋅

−

≤

∫

∞

→

2

2

1

1

2

exp

)

(

lim

13

Twierdzenie to stosuje się już dla n rzędu kilkudziesięciu. Pozwala ono oszacować przedziały

np. liczby sztuk S

n

pewnego artykułu (o stałym popycie) sprzedanych w ciągu dnia, z

wykorzystaniem tablic funkcji błędu erf(x) pakietu MATLAB,

gdzie

)

1

(

2

p

p

n

d

x

−

⋅

⋅

⋅

=

; d - promień przedziału S

n

wokół wartości oczekiwanej m=n

⋅

p.

Przykładowo, dla p=0.02 i n=50 (jeden dzień) mamy E(S

n

)=1,

σ

Sn

=0.99, co daje

P(S

n

∈

[0,2])

≅

0.68.

Dla n=300 (tydzień) mamy E(S

n

)=6,

σ

Sn

=2.43, co daje P(S

n

∈

[4,8])

≅

0.59 oraz

P(S

n

∈

[0,12])

≅

0.986, czyli, że sprzedaż tygodniowa praktycznie nie przekroczy 12 sztuk.

W analizie danych wykorzystuje się prawa wielkich liczb.

P

RAWO WIELKICH LICZB

Chinczyna (Poradnik inżyniera – Matematyka str.1072)

Niech x

1,

x

2,

x

3,

... x

n

oznacza ciąg niezależnych liczb losowych o jednakowym rozkładzie i

ograniczonej wartości oczekiwanej E(x)=m. Wtedy dla dowolnej liczby dodatniej

ε

zachodzi

równość:

0

1

lim

1

=

ε

≥

−

∑

=

∞

→

m

x

n

P

n

k

k

n

Jeśli dodatkowo niezależne liczby losowe x mają skończoną wariancję to słuszne jest

MOCNE PRAWO WIELKICH LICZB

, które mówi, że średnia arytmetyczna ciągu niezależnych

liczb losowych o ograniczonej wartości oczekiwanej i wariancji zmierza z

prawdopodobieństwem 1 do ich wartości oczekiwanej.

1

)

(

1

lim

1

=

=

∑

=

∞

→

x

E

x

n

P

n

k

k

n

4. ELEMENTY STATYSTYKI MATEMATYCZNEJ

Literatura:

1.

J.Greń: Statystyka matematyczna – modele i zadania, PWN, Warszawa 1982

2.

"Ekonometria. Metody i analiza problemów ekonomicznych". Pod red. K. Jajugi; Wydawnictwo

AE we Wrocławiu, Wrocław 1999.

3.

I.E. Brontsztejn, K.A.Siemeindiajew: Matematyka – poradnik encyklopedyczny. Część

szósta – Opracowanie danych doświadczalnych,. PWN, Warszawa 1986

4.

Poradnik inżyniera – Matematyka – Rozdział XXXIII

5.

Edward Nowak: Zarys metod ekonometrii – zbiór zadań, PWN, Warszawa 1994

6.

John Freund Podstawy nowoczesnej statystyki, PWE, Warszawa 1968

Pojęcia podstawowe statystyki (wg J.Greń: Statystyka matematyczna)

Metody statystyki stosuje się w ekonometrii w celu badania właściwości probabilistycznych

zmiennych ekonometrycznych. Zmienne te reprezentują pewne cechy badanej zbiorowości,

czyli populacji generalnej. Poddawane analizie dane (liczby losowe) są widziane jako losowa

próba populacji generalnej. Aby wynik badania był miarodajny, należy zadbać o

14

reprezentatywność próby. Uzyskuje się ją przez odpowiedni dobór (losowanie, rejestrację)

elementów próby z populacji generalnej.

Losowe wartości cechy w próbie o liczności n traktuje się jako jedną wartość n-wymiarowego

wektora losowego. Zbiór wszystkich możliwych wartości tej cechy w próbie o liczności n

nazywa się przestrzenią próby.

Rozkład populacji, to rozkład wartości badanej cechy w populacji generalnej. Zwykle zakłada

się, że rozkład populacji jest zbliżony do pewnego rozkładu modelowego (patrz poprzedni

rozdział).

Na podstawie zebranych danych losowych można obliczać statystyki z próby, czyli dowolne

funkcje zebranych zmiennych losowych. Statystyki są także zmiennymi losowymi.

Takimi statystykami mogą być zależności pozwalające na oszacowanie parametrów

rozkładów prawdopodobieństwa badanych cech populacji generalnej. Nazywa się je

estymatorami parametrów rozkładów. Wynikiem zastosowania estymatora jest estymata

poszukiwanego parametru rozkładu.

Estymator nieobciążony – estymator a pewnego parametru

α

spełniający równość E(a)=

α

,

co oznacza, że estymator szacuje wartość

α

bez błędu systematycznego, a więc pozwala

znaleźć faktyczną wartość parametru.

Estymator zgodny – estymator a pewnego parametru

α

spełniający warunek:

1

)

(

lim

=

ε

<

α

−

∞

→

n

n

a

P

tzn, estymator, który jest stochastycznie zbieżny do wartości parametru. Gdy używa się

estymatora zgodnego, to zwiększanie liczności próby zmniejsza błąd estymacji.

Ogólnie, estymator zgodny może być obciążony, a estymator nieobciążony może nie być

zgodny.

Estymator efektywny – estymator o możliwie małej wariancji.

Badania statystyczne zmiennych ekonometrycznych obejmują:

1.

analizę losowości zmiennych i określenie ich rozkładu prawdopodobieństwa;

2.

obliczanie czyli estymację parametrów tych rozkładów;

3.

weryfikację hipotez statystycznych dotyczących rozkładów populacji generalnej

Analiza losowości zmiennych i określenie ich rozkładu prawdopodobieństwa

Podstawowe estymatory rozkładów zmiennych losowych

1. Zgodnie z prawem wielkich liczb, jeśli cecha x populacji generalnej jest zmienną losową o

ograniczonej wariancji

σσσσ

2

i ograniczonej wartości oczekiwanej m, a ciąg wartości x

1,

x

2, ...

x

n

tej cechy w próbie jest ciągiem niezależnych liczb losowych, to estymatorem zgodnym,

nieobciążonym i najefektywniejszym wartości m=E(x) jest jej

średnia arytetyczna:

E(x)=m

≅

∑

=

−

=

n

k

k

x

n

x

1

1

Ś

rednia arytmetyczna liczb o rozkładzie normalnym ma rozkład normalny o wartości

oczekiwanej m (takiej jak liczby uśredniane) i wariancji

n

xs

σ

=

σ

2

Jeśli uśredniane liczby mają rozkład inny niż normalny to rozkład średniej arytmetycznej

zmierza (dla n zmierzającego do nieskończoności) do rozkładu normalnego

)

,

(

n

m

N

σ

(patrz Twierdzenie Lindberga-Leviego)

15

1. Zgodnie z prawem wielkich liczb, jeśli cecha x populacji generalnej jest zmienną losową o

ograniczonej wariancji

σσσσ

2

i ograniczonej wartości oczekiwanej m, a ciąg wartości x

1,

x

2, ...

x

n

tej cechy w próbie jest ciągiem niezależnych liczb losowych, to estymatorem zgodnym,

nieobciążonym i najefektywniejszym wartości m=E(x) jest jej

średnia arytetyczna:

E(x)=m

≅

∑

=

−

=

n

k

k

x

n

x

1

1

Ś

rednia arytmetyczna liczb o rozkładzie normalnym ma rozkład normalny o wartości

oczekiwanej m (takiej jak liczby uśredniane) i wariancji

n

xs

σ

=

σ

2

2.

Estymatorem zgodnym, nieobciążonym i najefektywniejszym wariancji cechy x na

podstawie ciągu wartości x

1,

x

2, ...

x

n

tej cechy w próbie o własnościach jak wyżej, jest

ś

redniokwadratowa odchyłka od wartości średniej obliczana wg wzoru

:

∑

∑

=

−

=

−

−

−

−

=

−

−

=

≅

σ

=

−

n

k

k

n

k

k

x

n

n

x

n

x

x

n

s

m

x

E

1

2

2

1

2

2

2

2

1

1

1

1

1

)

(

)

(

]

)

[(

Występująca w mianowniku różnica (n-1) powoduje, że estymator jest nieobciążony. Wynika

ona z faktu, że dane w liczbie n zostały już wykorzystane do obliczenia wartości średniej.

Zatem liczba jeszcze nie wykorzystanych danych wynosi (n-1).

Formalnie można to wykazać wychodząc z zależności:

∑

∑

=

−

=

−

−

=

−

=

−

n

k

k

n

k

k

x

E

M

n

x

E

M

x

x

E

M

m

x

E

1

2

2

1

2

2

}

)

{(

}

{

1

}

)

(

{

1

]

)

[(

gdzie M jest nieznanym jeszcze dzielnikiem estymatora.

Ze wzorów podanych w poprzednim rozdziale wynika, że:

2

2

2

}

{

m

x

E

x

k

+

=

σ

,

2

2

2

2

2

}

{

m

n

m

x

E

x

xs

+

=

+

=

σ

σ

Po podstawieniu do wzoru wyżej mamy:

2

2

1

2

2

2

2

2

2

)

1

(

)

1

(

1

]

)

[(

x

x

n

k

x

x

m

n

n

n

M

n

m

n

m

M

m

x

E

σ

σ

σ

σ

σ

⋅

−

=

⋅

−

=

−

−

+

=

−

=

∑

=

Wynika stąd, że aby uzyskać tożsamość, M powinno być równe (n-1).

Dzielenie przez n daje zatem błąd estymatora (obciążenie) jakkolwiek pozostaje on zgodny.

Dla dużych n można ten błąd zaniedbać i dzielić przez n.

∑

∑

=

−

=

−

−

=

−

≅

n

k

k

n

k

k

x

x

n

x

x

n

s

1

2

2

1

2

2

1

1

)

(

)

(

Estymata wariancji obliczona jak wyżej dla liczb o rozkładzie normalnym ma rozkład

χ

2

(chi-kwadrat) – patrz I.E. Brontsztejn, K.A.Siemeindiajew: Matematyka – poradnik

encyklopedyczny. Część szósta.

Zmienna losowa

η

ma rozkład

χ

2

o k stopniach swobody, gdy gęstość

)

(

)

(

χ

η

n

p

wyraża

się wzorem

1

2

2

2

)

(

2

2

2

)

(

−

−

Γ

=

k

k

k

k

k

e

p

χ

χ

η

Suma kwadratów N niezależnych liczb losowych o rozkładzie normalnym N(0,1) ma rozkład

χ

2

o N-1 stopniach swobody. Zatem

16

α

χ

χ

σ

η

=

=

−

<

<

−

∫

−

b

a

N

d

p

a

s

N

b

s

N

P

)

(

)

1

(

)

1

(

)

1

(

2

2

2

4.Estymatorem kowariancji dwóch zmiennych losowych x, y jest wyrażenie

:

∑

=

−

−

−

⋅

−

−

=

≅

=

−

⋅

−

n

k

k

k

xy

y

x

y

y

x

x

n

K

y

x

m

y

m

x

E

1

1

1

)

(

)

(

)

,

cov(

)]

(

)

[(

lub w przybliżeniu (dla dużych n)

∑

∑

=

−

−

=

−

−

⋅

−

⋅

=

−

⋅

−

≅

n

k

k

k

n

k

k

k

xy

y

x

y

x

n

y

y

x

x

n

K

1

1

1

1

)

(

)

(

Zachodzi równość: K

xy

=K

yx

Analogicznie, dla wielowymiarowych zmiennych losowych X=[X

1

, X

2

, .. X

M

], gdzie X

1

, X

2

, ..

X

M

są wektorami kolumnowymi (o jednakowej długości) losowych wartości kolejnych cech w

próbie, liczy się macierz kowariancji K wg wzoru macierzowego:

−

−

⋅

−

⋅

=

X

X

X

X

n

K

T

T

1

gdzie

T

oznacza transpozycję macierzy,

−

X jest wektorem wierszowym wartości średnich

kolejnych wektorów X

1

, X

2

, .. X

M,

, zatem

−

X

T

(wektor kolumnowy) pomnożony przez

−

X

(wektor wierszowy) daje macierz kwadratową o wymiarze MxM, czyli taką jak macierz K.

Jeśli wektory X

1

, X

2

, .. X

M

są wektorami wierszowymi (takie są na ogół produkowane przez

procedury pakietu MATLAB), to macierz kowariancji K liczy się wg wzoru:

T

T

X

X

X

X

n

K

−

−

⋅

−

⋅

=

1

Macierz kowariancji K jest symetryczna, tzn K

T

=K

5.

Estymator funkcji autokowariancji i autokorelacji

Jeśli ciąg liczb losowych jest uporządkowany wg czasu ich rejestracji, z jednakowym

rozstępem czasowym

∆∆∆∆

t między próbkami, czyli do kolejnych próbek można przypisać

czas liczony numerem kolejnym próbki

, to ciąg jest reprezentacją dyskretną procesu

stochastycznego (albo inaczej – zdyskretyzowanym procesem stochastycznym).

Jeśli badany proces stochastyczny jest stacjonarny, to estymatorem jego funkcji

autokowariancji z rozstępem m (czyli z rozstępem czasowym

ττττ

=m

⋅⋅⋅⋅∆∆∆∆

t) ma postać

∑

+

=

−

−

−

−

⋅

−

−

−

=

n

m

k

m

k

k

xn

x

x

x

x

m

n

m

R

1

1

1

)

(

)

(

)

(

Funkcję autokowariancji liczy się na ogół dla wystarczająco długich ciągów, aby można było

zastosować wzór:

∑

∑

+

=

−

−

+

=

−

−

−

−

⋅

−

=

−

⋅

−

−

≅

n

m

k

m

k

k

n

m

k

m

k

k

xn

x

x

x

m

n

x

x

x

x

m

n

m

R

1

2

1

1

1

)

(

)

(

)

(

Jeśli ciąg

x

1,

x

2, ...

x

n

jest ciągiem niezależnych liczb losowych reprezentujących stacjonarny

proces stochastyczny, to

>

=

σ

=

∞

−

0

0

0

2

m

dla

m

dla

m

R

x

xn

n

)

(

lim

17

Estymatorem unormowanej funkcji autokowariancji (czyli autokorelacji) r

xn

(m) jest

wyrażenie

2

x

xn

xn

s

m

R

m

r

)

(

)

(

=

Dyskusje ocen autokowariancji ciągu r

nm

dla kolejnych m zawiera podręcznik

[Mańczak Nahorski] str.66. Dla dużych n i dużych m mamy:

∑

∞

−∞

=

+

+

=

k

k

k

m

m

n

r

r

1

1

1

)

,

cov(

ρ

ρ

ρ

m

– prawdziwa wartość funkcji

Stąd wynika oszacowanie wariancji r

m

+

=

∑

∞

=

1

2

2

1

1

)

var(

k

k

m

n

r

ρ

(i)

Jeśli proces x

i

jest liniowy i spełnia warunki:

∑

∞

−∞

=

−

=

k

k

n

k

n

a

x

ξ

∑

∞

−∞

=

∞

<

k

k

a

2

∑

∞

−∞

=

∞

<

k

k

a |

|

∑

∞

−∞

=

∞

<

k

k

a

k

2

|

|

to wielowymiarowy rozkład zmiennych

)

,

0

(

)

(

W

N

r

n

n

m

m

∞

→

→

−

ρ

.

Dla dużych n istotność funkcji autokorelacji można badać metodą Boxa:

1.

Zakładamy, że

ρ

1

, ...,

ρ

k

są zerowe

2.

obliczamy wariancje r

m

ze wzoru (i) i sprawdzamy hipotezę j.w. dla m=1

3.

jeśli należy ją odrzucić przyjmujemy

ρ

1

=r

1

i sprawdzamy hipotezę dla m=2

4.

w taki sam sposób sprawdzamy dla dalszych m

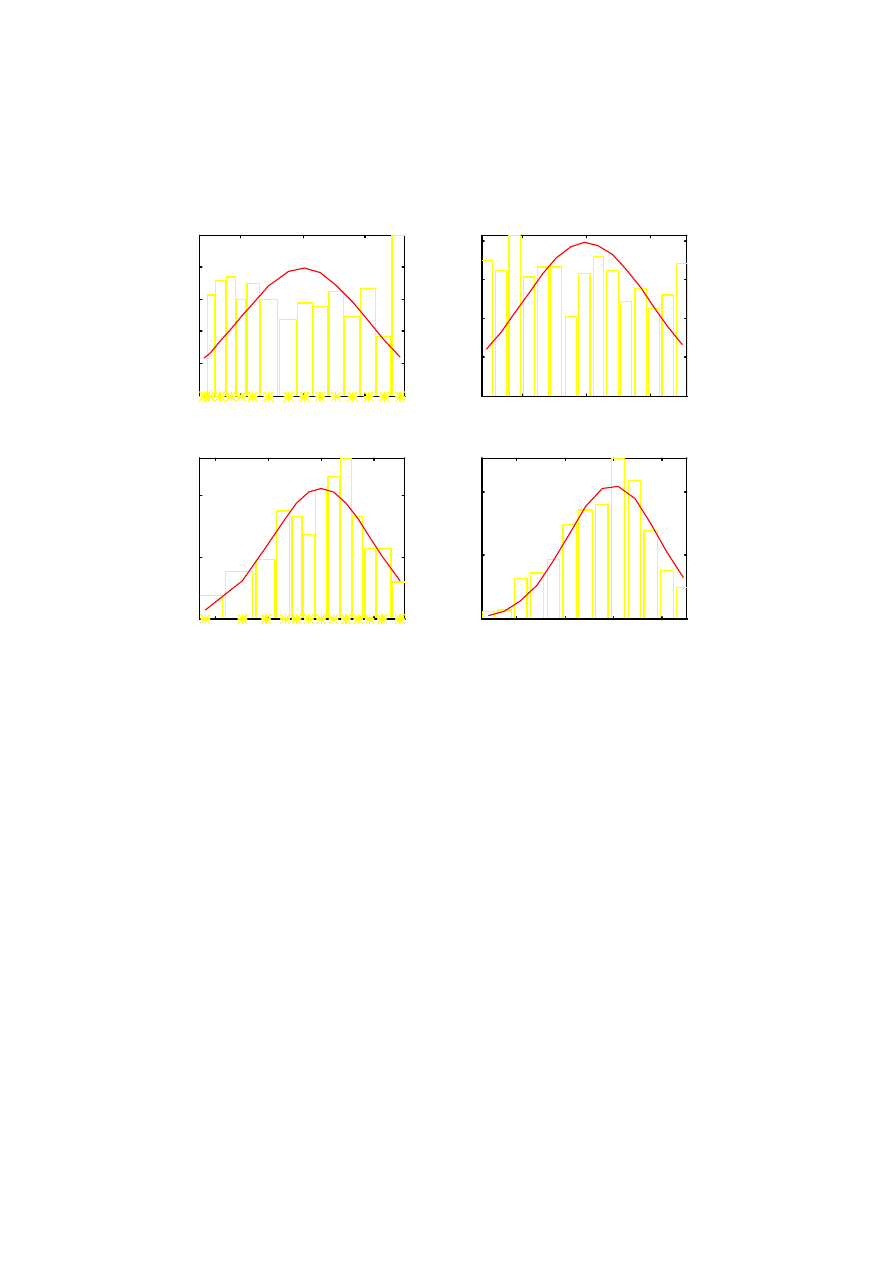

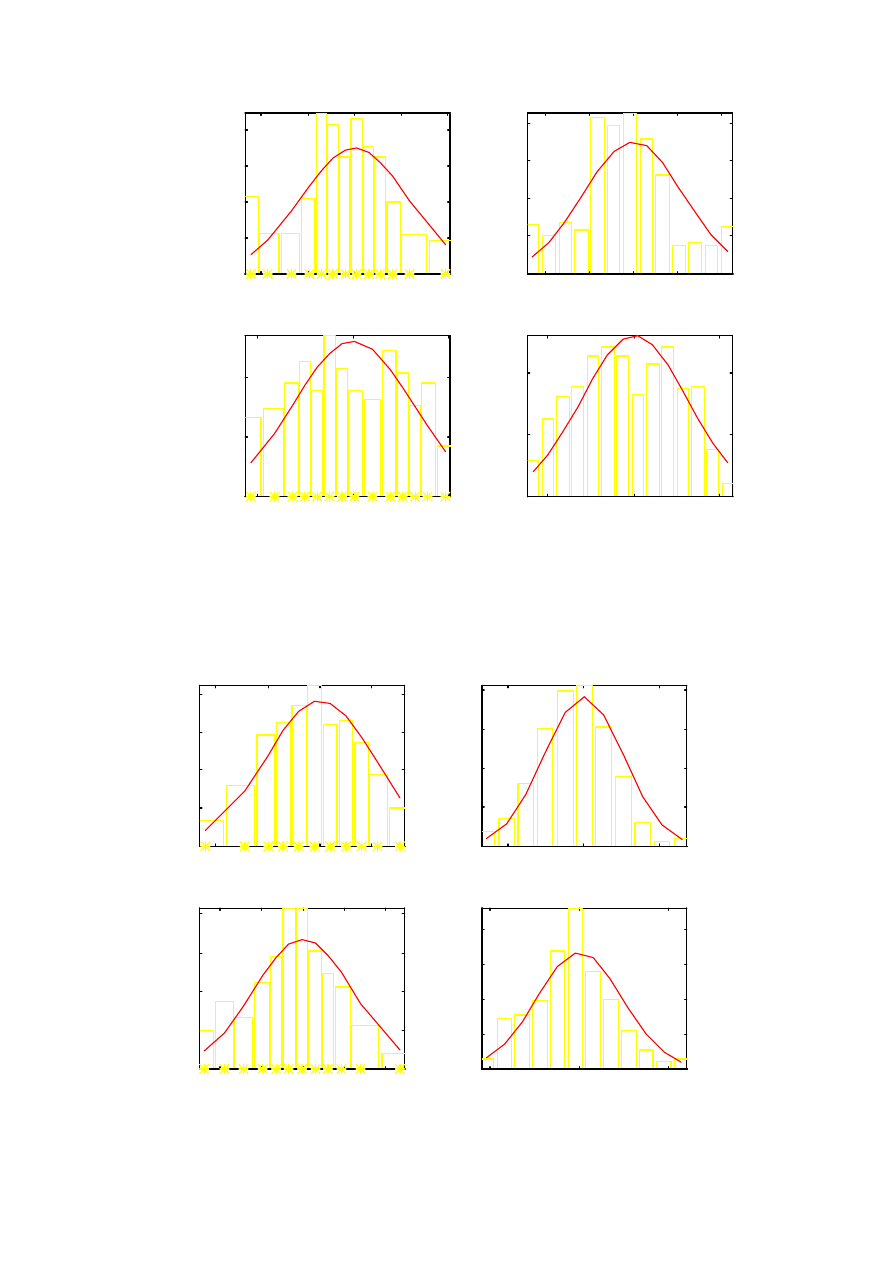

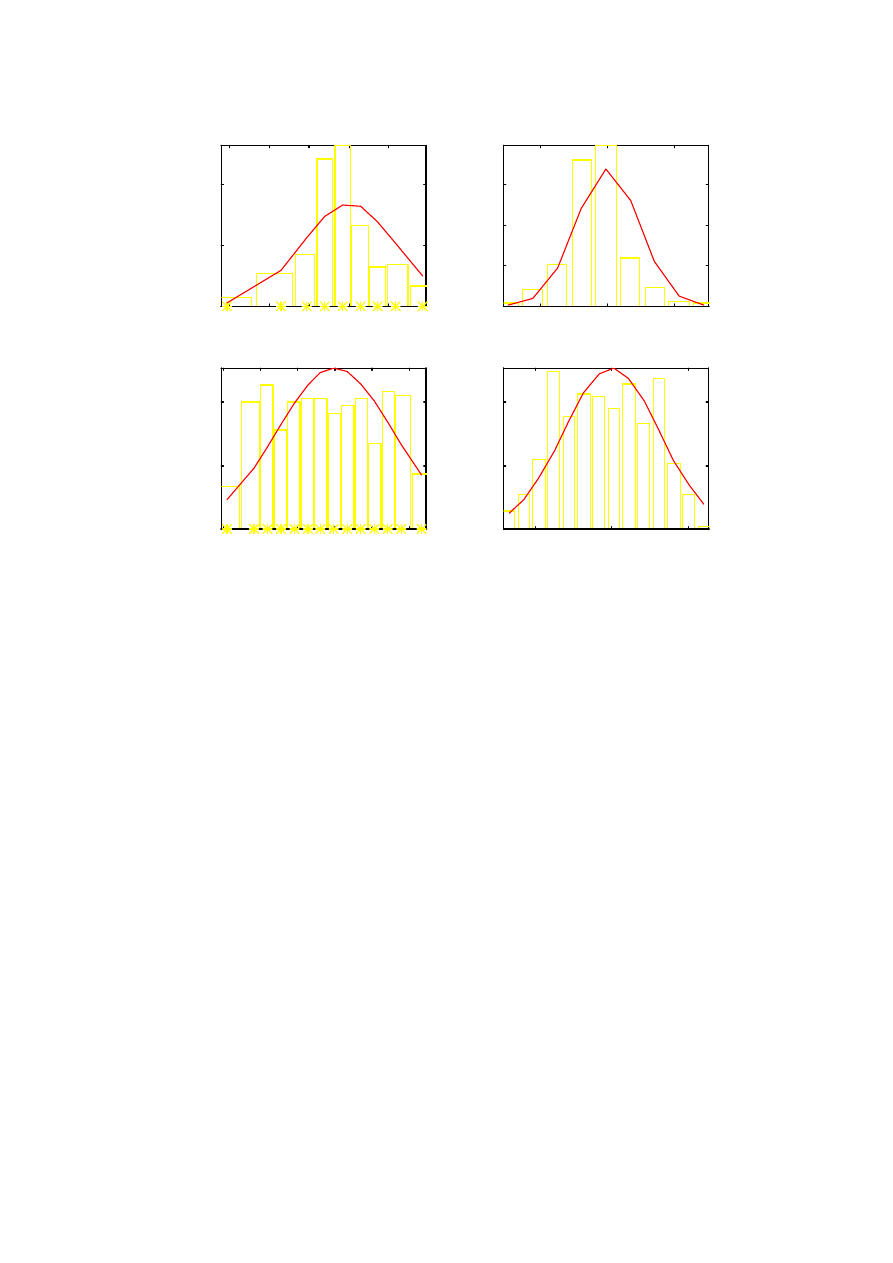

Szeregi rozdzielcze i estymacja rozkładu prawdopodobieństwa

Histogram

a)

dzielimy przedział zmienności zbioru liczb x na pewną liczbę m podprzedziałów o

szerokości

∆

x

i

. i grupujemy liczby w klasy takie, aby w i-tej klasie znalazły się wszystkie

liczby x

k

∈

(

]

.

,

.

i

i

i

i

x

x

x

x

∆

+

∆

−

−

−

5

0

5

0

Należy przy tym tak dobrać liczbę klas lub ich

szerokości, aby w każdej klasie znalazło się co najmniej 10 liczb Uzyskuje się w ten

sposób

szereg rozdzielczy zmiennej x.

b)

dla każdego przedziału liczymy wysokość słupka histogramu p

i

wg wzoru:

i

i

i

x

n

n

p

∆

=

1

Wartość p

i

jest estymatą prawdopodobieństwa P

i

{x

∈

(

]

.

,

.

i

i

i

i

x

x

x

x

∆

+

∆

−

−

−

5

0

5

0

}

c)

robimy wykres słupkowy wartości p

i

względem

i

x

−

i uzyskujemy histogram.

Na tle histogramu wskazane jest wykreślenie przypuszczalnego rozkładu teoretycznego (lub

zestawu rozkładów) populacji generalnej, z parametrami E(x) oraz s

2

obliczonymi jak wyżej.

Jeśli danych jest wystarczająco dużo, najwygodniej jest przyjąć stałą szerokość klas szeregu

rozdzielczego. Można do tego wykorzystać

funkcję hist(x,k) z pakietu MATLAB. Tworzy

ona szereg rozdzielczy wektora x z liczbą przedziałów k, a następnie wykreśla histogram dla

liczności n

i

próbek w podprzedziałach (a nie dla p

i

jak zalecono w punkcie b)

Histogram można wykonać dla dowolnego zbioru liczb, ale ma on sens, gdy liczby te są

liczbami losowymi. Sam kształt histogramu nie rozstrzyga kwestii losowości danych,

18

jakkolwiek może sugerować, że są lub nie są one losowe. Hipotezę losowości należy przyjąć

wcześniej na podstawie analizy przyczyn losowości danych, obecności pewnych oddziaływań

deterministycznych, czy wreszcie przypuszczalnego rozkładu prawdopodobieństwa danych.

Na ogół dla zmiennych ciągłych rozkład ten winien być zbliżony do normalnego, w pewnych

przypadkach – do równomiernego. Stwierdzenie dużych rozbieżności histogramu od takiej

hipotezy może być spowodowane:

a)

niejednorodnością próbki, tzn. występowaniem kilku (np. dwóch) klas danych o różnych

rozkładach;

b)

zależnością parametrów rozkładu (głównie wartości oczekiwanej) od pewnych czynników

nielosowych (np. czasu lub zmiennych egzogenicznych)

W przypadku (a) zbiór danych należy rozdzielić na podzbiory jednorodne statystycznie.

W przypadku (b) należy znaleźć najpierw odpowiednie zależności ekonometryczne badanej

zmiennej (endogenicznej) od znanych czynników egzogenicznych, a następnie poddać

analizie probabilistycznej odchyłki losowe danych od tych zależności. Będzie to przedmiotem

następnego rozdziału opracowania.

Estymacja przedziałowa

Jak, wspomniano, estymaty są liczbami losowymi o określonym rozkładzie

scharakteryzowanym dyspersją i wartością oczekiwaną. W związku z tym wynik estymacji

można przedstawić jako estymatę wartości oczekiwanej parametru oraz przedział, w którym

z zadanym prawdopodobieństwem – zwanym poziomem ufności – mieści się prawdziwa

wartość parametru. Przedział taki nazywa się przedziałem ufności, sam sposób postępowania

– estymacją przedziałową.

Zwykle podaje się przedział ufności o szerokości 1

⋅σ

, 2

⋅σ

lub 3

⋅σ

. Dla rozkładu normalnego

estymatora odpowiada to poziomowi ufności odpowiednio: 68.3%, 95.5% i 99.7%

Zgodność histogramu z założonym rozkładem prawdopodobieństwa testuje się m.in.

przy pomocy statystyki

χ

2

(kryterium

χ

2

Pearsona).

Niech F(x) oznacza założoną (teoretyczną) dystrybuantę zmiennej losowej x, f(x) – funkcję

gęstości prawdopodobieństwa,

∆

1

,

∆

1

, ...,

∆

j

, ...,

∆

L

ciąg rozłącznych przedziałów histogramu

o wartości średniej x

j

, n

j

- liczbę danych w j-tym przedziale. Wówczas, dla N

→∞

statystyka

(

)

∑

∑

∫

∫

=

=

∆

∆

∆

⋅

−

∆

⋅

≅

−

=

L

j

L

j

j

j

j

j

j

j

j

j

x

f

N

n

x

f

N

x

dF

N

n

x

dF

N

1

1

2

2

2

)

(

)

(

)

(

)

(

χ

ma rozkład

χ

2

o L-1

stopniach swobody. W praktyce wystarcza, aby min

j

N

f(x)

∆

j

>10.

5. Modele ekonometryczne

Literatura:

1.

Manikowski A., Tarapata Z.: Prognozowanie i symulacja rozwoju przedsiębiorstwa.

WSE Warszawa 2002

2.

Pawłowski Z. " Zasady predykcji ekonometrycznej" PWN, Warszawa 1982.

3.

Zeliaś A. "Teoria prognozy" PWE, Warszawa 1997.

4.

Dittmann P., Metody prognozowania sprzedaży w przedsiębiorstwie, wyd. 6, Wyd. AE

Wrocław, 2002.

19

5.

Gajda J.B., Prognozowanie i symulacja a decyzje gospodarcze, C.H.Beck Warszawa,

2001.

6.

Radzikowska B. (red.), Metody prognozowania. Zbiór zadań, wyd. 3, Wyd. AE Wrocław,

2001.

7.

Zeigler B.P, Teoria modelowania i symulacji, PWN Warszawa, 1984.

8.

K. Molenda, M. Molenda, Analiza i prognozowanie szeregów czasowych, Placet,

Warszawa 1999

9.

E. Nowak. (red.) Prognozowanie gospodarcze. Metody, modele, zastosowania,

przykłady. Placet 1998

10.

Cieślak M. Prognozowanie gospodarcze. Wydawnictwo AE Wrocław, 1998.

11.

Henry Theil: Zasady ekonometrii, PWN, Warszawa, 1979

12.

Zbigniew Pawłowski: Ekonometria, PWN, Warszawa 1969

6.

G.E.P.Box, G.M.Jenkins: Analiza szeregów czasowych, PWN, Warszawa, 1983

Modelem ekonometrycznym nazywa się zależność stochastyczną wartości oczekiwanych

zmiennych endogenicznych od deterministycznych zmiennych egzogenicznych.

Schemat ujęcia zagadnienia zilustrowano na Rys.1.

Model ekonometryczny zapisuje się ogólnie w postaci:

)

(

^

X

f

y

=

;

gdzie X jest wektorem wartości zmiennych, przyjętych jako istotnie oddziałujące na zmienną

objaśnianą y. Zmienna objaśniająca y ma wartość:

e

y

y

+

=

^

gdzie e jest błędem modelu spowodowanym z założenia tylko czynnikami losowymi.

Jeśli wektor X zawiera tylko zmienne egzogeniczne (zewnętrzne) przypisane do tej samej

chwili czasu co zmienna endogeniczna, to model jest równaniem algebraicznym opisującym

proces ekonomiczny w stanie wewnętrznej równowagi, a model nazywa się zależnością

statyczną.

Modele statyczne buduje się w celu znalezienia ilościowych i stałych w czasie powiązań

zmiennych egzogenicznych z endogenicznymi.

Jeśli co najmniej jedna spośród zmiennych X jest zmienną endogeniczną zarejestrowaną w

poprzednich chwilach czasu, lub zmienne egzogeniczne brane są z wcześniejszych chwil

czasu niż y, to model jest dyskretnym zapisem równania różniczkowego (czyli równaniem

różnicowy) i opisuje przebieg zjawiska dynamicznego (uwarunkowanego wewnętrzną

dynamiką badanego procesu ekonomicznego). Taki model nazywa się modelem dynamiki

zjawiska. Modele takie wykorzystuje się w ekonometrii głównie do prognozowania przebiegu

zjawiska w przyszłości (matematyczne prognozowanie procesów ekonomicznych, np. cen,

zapotzrzebowania itp.)

W ekonometrii czynniki losowe odgrywają zwykle dużą rolę, stąd konieczność poszukiwania

raczej prostych zależności f(X).

W praktyce najczęściej stosuje się modele jednoczynnikowe, gdzie mamy tylko jedną

zmienną objaśniającą. Opracowanie wiarygodnych modeli wieloczynnikowych jest zadaniem

bardzo trudnym i wymaga często długotrwałych badań.

20

Szczególnym przypadkiem modeli jednoczynnikowych są takie, gdzie jedyną zmienną

objaśniającą jest czas t. Zależność ekonometryczną tego typu nazywa się często trendem, a

wyliczanie odchyłek danych od takiej zależności – ekstrakcją trendu. Formalnie, zależność

taka jest zależnością statyczną, niemniej może być (i często jest) wykorzystywana do analizy

dynamicznego przebiegu zjawiska. W szczególności stosuje się takie modele do

prognozowania zjawisk (tzw. modele Browna).

Modele regresyjne, liniowe

Bardzo ważną grupę modeli ekonometrycznych stanowią modele liniowe o ogólnej postaci:

A

U

X

u

a

y

n

K

k

kn

k

n

⋅

=

⋅

=

∑

=

0

^

)

(

gdzie

U

n

jest wektorem wierszowym tzw. wejść uogólnionych [

u

0n

,

u

1n

, ...,

u

Kn

],

A –

wektorem kolumnowym nieznanych współczynników modelu

A=[a

0

,

a

1

, ...,

a

K

].

Wejścia uogólnione są to funkcje algebraiczne zmiennych objaśniających, zadane wraz ze

wszystkimi koniecznymi współczynnikami, tak aby mając wartości zmiennych X

n

w

kolejnych próbkach

n=1..N, można było obliczyć wszystkie wartości U

n

dla

n=1, ..N.

Zatem, dane o wejściach X pozwalają obliczyć całą macierz

U złożoną z wierszy U

n

.

Niech

^

,

Y

Y

oznaczają wektory kolumnowe wartości

^

,

n

n

y

y

dla n=1, .. N; E – wektor

kolumnowy kolejnych wartości zakłóceń e

1

,

e

2

, ..., e

N

. Można ogólnie zapisać formuły:

E

A

U

Y

+

⋅

=

; lub

E

Y

Y

+

=

^

gdzie

A

U

Y

⋅

=

^

W ekonometrii najczęściej wykorzystuje się takie modele bądź jako

modele wieloczynnikowe

liniowe, tj. biorąc U

n

≡

X

n

, lub jako

modele jednoczynnikowe, w których wejścia u(x) są

prostymi funkcjami, przeważnie jednomianami. W ostatnim przypadku mamy modele

wielomianowe (najpopularniejsze).

Postać wejść U oraz ich liczba to

struktura modelu regresyjnego. Struktura modelu

regresyjnego musi być ustalona arbitralnie. Mając tę strukturę należy obliczyć parametry A.

Wyznaczanie parametrów A nazywa się identyfikacją modelu. Realizuje się ją w następujący

sposób:

a)

Dokonuje się pomiarów w liczbie N>K+1, tak aby nadmiar danych w stosunku do liczby

nieznanych współczynników pozwolił dobrać optymalne współczynniki

b)

Definiuje się kryterium jakości modelu

c)

Oblicza się wartości współczynników rozwiązując zadanie optymalizacji polegające na

minimalizacji kryterium (b)

Najprostszy algorytm uzyskuje się przyjmując jako kryterium (b) sumę kwadratów błędów

modelu. Nazywa się to

metodą najmniejszych kwadratów MNK.

Takie zadanie ma rozwiązanie analityczne, tzn. optymalny wektor współczynników modelu

wyraża się wzorem macierzowym:

[

]

Y

U

U

U

A

T

T

⋅

⋅

⋅

=

−

1

UWAGA !!!

Wyznaczone w powyższy sposób

parametry A mają sens tylko wówczas, gdy macierz U jest

dobrze uwarunkowana, tzn. wynik jej odwracania jest słabo zależny od błędów

numerycznych.

Sprawdza się to procedurą svd() z biblioteki MATLAB. Uwarunkowanie nie

zależy od wartości wyjść procesu (i ich składnika losowego) ale tylko od struktury funkcji

21

regresji i zmienności wejść (im mniejsza zmienność tym gorsze uwarunkowanie).

Uwarunkowanie można zatem poprawić tylko przez zmianę struktury modelu lub zebranie

bardziej zróżnicowanych danych wejściowych.

Warto podkreślić, że taki sam wzór określa współczynniki optymalnej aproksymacji dowolnej

funkcji y(u) zadanej w N punktach. Model ekonometryczny ma być jednak zależnością

stochastyczną, a nie aproksymatą pewnej funkcji deterministycznej. Oznacza to, że błedy

modelu chcemy interpretować jako spowodowane tylko czynnikami losowymi, a nie

wynikające z arbitralnego doboru wartości funkcji.

Aby uzyskany model mógł być interpretowany jako zależność stochastyczna winny być

spełnione następujące warunki (podane przez Gaussa) (patrz Z.Pawłowski: Ekonometria):

a)

zmienne objaśniające X, a więc także U winny być nielosowe (czyli dokładnie znane), i U

nie mogą być liniowo współzależne (ogólnie – macierz U musi być dobrze

uwarunkowana, co jest konieczne, aby obliczenia dawały sensowne rezultaty)

b)

składnik losowy e zmiennej objaśnianej musi mieć zerową wartość oczekiwaną E(e)=0, i

skończoną oraz stałą wariancję (niezależną od czasu przypisanego do kolejnych danych)

c)

ciąg {e

n

, n=1,2, ..N}musi być ciągiem niezależnych liczb losowych

d)

składnik losowy e nie może być skorelowany ze zmiennymi objaśniającymi

uwzględnionymi w modelu.

Jeśli te założenia są spełnione to estymatory A współczynników modelu są zgodne i

nieobciążone, a ich macierz kowariancji wyraża się prostym wzorem:

2

1

]

[

r

T

A

s

U

U

K

⋅

⋅

=

−

gdzie

2

r

s oznacza estymatę wariancji reszt modelu.

Pozwala to wyznaczać nie tylko samą funkcję regresji, ale także przedziały ufności dla tej

funkcji oraz prognoz zmiennej y, regresji w oparciu o oceny wariancji funkcji regresji

2

ym

s

i

wariancji przewidywanej zmiennej objaśnianej

2

y

s

, które oblicza się ze wzorów:

T

n

A

n

ym

u

K

u

s

⋅

⋅

=

2

;

2

2

2

r

ym

y

s

s

s

+

=

Model jednoczynnikowe wielomianowe mają wejścia uogólnione o postaci:

u

0n

≡≡≡≡

1; (stała modelu)

u

1n

= x

n

u

2n

= (x

n

)

2

.........

u

Kn

= (x

n

)

K

Model z ograniczeniami równościowymi [Pawłowski str.120]

BA=C

B – znana macierz, C – znany wektor, A – wektor współczynników oryginalnych.

Zmodyfikowany wektor parametrów wyraża się wzorem:

[

]

C

H

A

HB

I

A

⋅

+

−

=

*

gdzie

1

1

1

]

)

(

[

]

[

−

−

−

⋅

⋅

⋅

=

T

T

T

T

B

U

U

B

B

U

U

H

Macierz kowariancji ma postać:

[

]

[

]

2

1

]

[

*

r

T

T

A

s

HB

I

U

U

HB

I

K

⋅

−

⋅

−

=

−

22

Funkcje korelacyjne a zależności regresyjne

W przypadku szeregów czasowych, stosowaną powszechnie analizę współczynnika

korelacji zmiennych losowych można łatwo rozszerzyć, badając korelacje szeregów

przesuniętych względem siebie w czasie, czyli funkcje korelacyjne. Dla szeregów X

Nd

={x

1

, ..

x

N-d

}, Y

N

={y

d+1

, .. y

N

}przesuniętych o d próbek definiuje je formuła:

∑

+

=

−

−

−

−

−

−

=

≅

−

−

−

−

=

N

d

n

sr

d

n

sr

n

x

y

def

yxd

d

N

N

sr

d

N

sr

N

def

yxd

x

x

y

y

s

s

d

N

R

x

X

E

y

Y

E

x

X

y

Y

E

R

1

*

2

2

)

)(

(

1

1

}

)

{(

}

)

{(

)}

)(

{(

(1)

∑

+

=

−

−

−

=

N

d

n

sr

d

n

x

x

x

d

N

s

1

2

)

(

1

,

∑

+

=

−

−

=

N

d

n

sr

n

y

y

y

d

N

s

1

2

)

(

1

(2)

gdzie s

x

, s

y

,

y

,

x

, y

sr

, x

sr

oznaczają dyspersje, wartości oczekiwane i średnie ciągów X

Nd

i Y

N

.

Wzór (1) można zastosować dla dowolnych ciągów, ale funkcja R

yxd

jest miarodajna, gdy

są one stacjonarnymi szeregami czasowymi [6].

Przyjmijmy, że szeregi Y

N

, X

Nd

mają zerowe wartości średnie (y

sr

=0, x

sr

=0) (co można

zawsze uzyskać prowadząc analizy dla szeregów scentrowanych) i są powiązane liniową

funkcją regresji:

n

d

n

n

z

ax

y

+

=

−

,

d

n

n

ax

y

−

=

ˆ

(3)

gdzie z

n

są próbkami zakłócenia,

n

yˆ

- wartością oczekiwaną E{y

n

} (zależną liniowo od x

n-d

).

Jeśli zakłócenia z

n

mają rozkład normalny z zerową wartością oczekiwaną oraz stałą wariancją

(niezależną od n), i nie są skorelowane z poprzednimi wartościami (E{z

n

z

n

−

m

}=0 dla m

>0) i ze

zmienną x (E{z

n

x

n

−

d

}=0), to optymalny, zgodny i nieobciążony estymator współczynnika a

wyraża się wzorem wynikającym z metody najmniejszych kwadratów [Paw]:

*

*

2

1

1

2

1

yxd

x

y

yxd

x

y

s

N

d

n

d

n

n

N

d

n

d

n

R

s

s

R

s

s

s

x

y

x

a

⋅

=

=

=

∑

∑

+

=

−

+

=

−

(4)

Dyspersję s

e

błędów zależności (3) wyraża wzór:

2

*

1

2

*

1

2

)

(

1

)

(

1

)

(

1

yxd

y

N

d

n

d

n

yxd

x

y

n

N

d

n

d

n

n

def

e

R

s

x

R

s

s

y

d

N

ax

y

d

N

s

−

=

⋅

−

−

=

−

−

=

∑

∑

+

=

−

+

=

−

(5)

a dyspersja współczynnika a obliczonego ze wzoru (4) wynosi:

d

N

R

s

s

d

N

s

s

s

x

s

yxd

x

y

x

e

e

N

d

n

d

n

a

−

−

=

−

=

=

∑

+

=

−

2

*

1

2

)

(

1

1