1

RACHUNEK PRAWDOPODOBIEŃSTWA

I STATYSTYKA MATEMATYCZNA

Maria Kotłowska

Przedmiot rachunku prawdopodobieństwa – ścisłe ujęcie

częstościowego

bądź też statystycznego sensu słowa

prawdopodobnie.

Pojęcie prawdopodobieństwa łączymy z reguły z wynikiem

obserwacji lub eksperymentu bądź to rzeczywistego bądź to

myślowego.

W rachunku prawdopodobieństwa możliwy wynik eksperymentu, o

którego prawdopodobieństwie chcemy mówić nazywamy

zdarzeniem.

Zdarzenia elementarne utożsamiamy z elementami pewnego

podstawowego zbioru, reprezentującego pojedyncze, elementarne,

nierozkładalne na drobniejsze części wyniki rozpatrywanego

eksperymentu.

Przestrzeń zdarzeń elementarnych – zbiór elementów stanowiących

wszystkie elementarne, niepodzielne wyniki doświadczeń czy

obserwacji. Oznaczamy ją literą

Ω

, a jej elementy zwane

zdarzeniami elementarnymi literą

ω

, ewentualnie ze wskaźnikiem.

Ogólnie zdarzeniami w teorii prawdopodobieństwa nazywamy

podzbiory przestrzeni zdarzeń elementarnych czyli zbiory zdarzeń

elementarnych.

2

DZIAŁANIA NA ZDARZENIACH

1. Sumą dwóch zdarzeń A i B nazywamy zdarzenie C złożone z tych

wszystkich zdarzeń elementarnych, które należą co najmniej do

jednego ze zdarzeń A , B , co oznaczamy;

A

∪B = C

Sumowanie uogólnia się na dowolną liczbę składników.

Tak więc sumą n zdarzeń A

1

,A

2

,.....,A

n

nazywamy zdarzenie

i

n

i

n

A

A

A

A

C

1

2

1

....

=

∪

=

∪

∪

∪

=

złożone z tych wszystkich zdarzeń elementarnych, które należą co

najmniej do jednego ze zdarzeń A

1

,A

2

,.....,A

n

.

Podobnie definiujemy sumę nieskończonego ciągu zdarzeń.

2. Iloczynem dwóch zdarzeń A i B nazywamy zdarzenie C złożone z

tych zdarzeń elementarnych, które są zawarte jednocześnie i w A i w

B, co oznaczamy:

A

∩B = C

Iloczyn większej ilości zdarzeń

i

n

i

n

A

A

A

A

C

1

2

1

......

=

∩

=

∩

∩

∩

=

to zdarzenie C złożone z tych wszystkich zdarzeń elementarnych ,

które należą jednocześnie do każdego ze zdarzeń A

1

,A

2

,....,A

n

.

Podobnie definiujemy iloczyn nieskończonego ciągu zdarzeń.

3. Różnicą dwóch zdarzeń A i B nazywamy zdarzenie C złożone z

tych zdarzeń elementarnych, które należą do zdarzenia A , ale nie

należą do zdarzenia B, co oznaczamy

A|B = C

3

4. Dopełnieniem zdarzenia A nazywamy zdarzenie B złożone z tych

wszystkich zdarzeń elementarnych, które nie należą do zdarzenia A.

Dopełnienie oznaczamy A`; A` = B oznacza, że B jest dopełnieniem

A`.

5. Zdarzenie pewne – to cala przestrzeń

Ω

zdarzeń elementarnych

(reprezentuje wszystkie możliwe wyniki eksperymentu, a więc musi

się zdarzyć wynik należący do

Ω

).

6. Zdarzenie niemożliwe – oznaczymy przez Ø, czyli A = Ø jest

zdarzeniem niemożliwym, a więc nie zawiera żadnego zdarzenia

elementarnego.

7. Zdarzenia A i B są rozłączne wtedy, gdy ich iloczyn jest

zdarzeniem niemożliwym, A

∩B =Ø , co oznacza, że A i B nie

zawierają wspólnych zdarzeń elementarnych.

8. Zdarzenie A zawiera się w zdarzeniu B wtedy, gdy jeśli realizuje

się zdarzenie A, to realizuje się zdarzenie B. Oznaczamy A

⊂B, czyli

wszystkie zdarzenia elementarne zawarte w A są jednocześnie zawarte

w zdarzeniu B.

9. A

∪A` =

Ω

, suma zdarzenia A i jego dopełnienia A` jest

zdarzeniem pewnym

Ω.

10. A

∩A` = Ø, iloczyn zdarzenia A i jego dopełnienia A` jest

zdarzeniem niemożliwym, czyli są to zdarzenia rozłączne.

11. A

∪A = A

A

∩A = A

(A`)` = A

12. A|B = A

∩B`, co oznacza, że każde zdarzenie elementarne

należące do A i B` nie należy do B.

Związki między dodawaniem i mnożeniem zdarzeń opisują równości

zwane prawami de Morgana.

4

(

)

(

)

(

)

(

)

(

)

(

)

....

.....

....

.....

.

3

....

...

....

....

.

2

.

1

2

1

2

1

2

1

2

1

2

1

2

1

2

1

2

1

∪

′

∪

′

=

′

∩

∩

∩

′

∩

′

=

′

∪

∪

′

∪

∪

′

∪

′

=

′

∩

∩

∩

′

∩

∩

′

∩

′

=

′

∪

∪

∪

′

∪

′

=

′

∩

′

∩

′

=

′

∪

A

A

A

A

A

A

A

A

A

A

A

A

A

A

A

A

A

A

A

A

B

A

B

A

B

A

B

A

n

n

n

n

Z powyższych praw wynikają następujące związki:

(

)

(

)

Ω

=

Ω

∪

′

⎟

⎠

⎞

⎜

⎝

⎛

∪

′

∪

′

=

∩

∩

′

⎟

⎠

⎞

⎜

⎝

⎛

∩

′

∩

′

=

∪

∪

′

⎟

⎠

⎞

⎜

⎝

⎛

′

∪

∪

′

∪

′

=

∩

∩

∩

′

⎟

⎠

⎞

⎜

⎝

⎛

′

∩

∩

′

∩

′

=

∪

∪

∪

′

′

∪

′

=

∩

′

′

∩

′

=

∪

A

A

A

A

A

A

A

A

A

A

A

A

A

A

A

A

A

A

A

A

A

B

A

B

A

B

A

B

A

n

n

n

n

.

4

...

....

...

....

.

3

...

....

...

...

.

2

.

1

2

1

2

1

2

1

2

1

2

1

2

1

2

1

2

1

5

5. Jeżeli A

⊂B, to A∩Ø = Ø

6. Ø

∩Ø = Ø

7. Ø` =

Ω

,

Ω

` = Ø

Zbiór wszystkich zdarzeń nazywamy ciałem zdarzeń i oznaczamy S.

Jednak nie każdy zbiór zdarzeń elementarnych możemy uważać za

zdarzenie i zaliczyć do zbioru S. Wiąże się to z istnieniem przestrzeni

nieprzeliczalnych. Dlatego w ogólnej teorii zamiast mówić o

zdarzeniach

po prostu jako o

podzbiorach przestrzeni zdarzeń

elementarnych mając na myśli wszystkie takie podzbiory, wprowadza

się zbiór S wszystkich zdarzeń i formułuje się jedynie postulaty co do

domknięcia zbioru S ze względu na pewne działania na zdarzeniach.

Postulaty dotyczące zbioru S wszystkich zdarzeń

1. Dopełnienie A` każdego zdarzenia A jest zdarzeniem, czyli jeżeli

A

∈ S ⇒ A` ∈ S.

2. Suma każdego skończonego lub przeliczalnego zbioru zdarzeń A

i

jest zdarzeniem, czyli jeśli dla każdego i przebiegającego zbiór

skończony lub przeliczalny, A

i

∈

S

⇒ ∪A

i

∈S.

i

Z powyższych postulatów wynikają następujące twierdzenia:

1. Zdarzenie pewne i zdarzenie niemożliwe są elementami zbioru S,

czyli jeśli

Ω

∈ S ∧ Ø ∈ S.

2. Iloczyn dwóch zdarzeń jest zdarzeniem, czyli jeśli

A

∈ S ∧B ∈ S ⇒(A∩B) ∈S.

3. Iloczyn skończenie lub przeliczalnie wielu zdarzeń jest

zdarzeniem, czyli jeśli dla skończenie lub przeliczalnie wielu i mamy

A

i

∈ S⇒∩A

i

∈ S.

i

6

4. Różnica zdarzeń jest zdarzeniem, czyli jeśli

A

∈ S∧B ∈S⇒(A|B)∈S.

Zbiór S zdarzeń pokrywa się z klasą wszystkich podzbiorów

przestrzeni zdarzeń elementarnych, gdy przestrzeń zdarzeń

elementarnych składa się ze skończonej bądź przeliczalnej liczby

elementów.

Prawdopodobieństwo odnosimy do eksperymentu, traktując je jako

abstrakcyjny opis jego własności.

DEFINICJE PRAWDOPODOBIEŃSTWA

I. Aksjomatyczna

II. Oparta na częstości względnej

III. Klasyczna – a priori

I. Aksjomatyczna definicja prawdopodobieństwa

Prawdopodobieństwo jest to funkcja, której wartościami są liczby

rzeczywiste, a argumentami zdarzenia i która ma następujące

własności:

1.Prawdopodobieństwo P(A) zdarzenia A przyjmuje wartości od

0 do 1, czyli

0

≤ P(A) ≤ 1 , gdzie A ∈ S

2. Prawdopodobieństwo zdarzenia pewnego

Ω

jest równe 1, czyli

P(

Ω

) = 1

3. Prawdopodobieństwo jest przeliczalnie addytywne, to znaczy, że

dla każdego ciągu parami rozłącznych zdarzeń A

1

, A

2

,.... ze zbioru S

P( A

1

∪ A

2

∪ .......) = P(A

1

) + P(A

2

) + ......... ,

gdzie

A

1

, A

2

, .....

∈ S.

7

Aksjomat 2 – aksjomat unormowania

Aksjomat 3 – aksjomat przeliczalnej addytywności

Elementarne własności prawdopodobieństwa wynikające z jego

aksjomatycznej definicji

1. Prawdopodobieństwo zdarzenia niemożliwego równa się zero, czyli

P(Ø) = 0

2. Jeżeli zdarzenia A

1

, A

2

,......., A

n

są parami rozłączne, to

P( A

1

∪ A

2

∪ ...... ∪ A

n

) = P(A

1

) + P(A

2

) +....+ P(A

n

)

Jeżeli dwa zdarzenia A i B się nie wykluczają, to

P( A

∪ B ) = P(A) + P(B) – P( A ∩ B)

3. Suma prawdopodobieństw zdarzeń przeciwnych równa się

jedności, czyli

P(A) + P(A`) = 1

4. Jeżeli przestrzeń zdarzeń elementarnych

Ω

jest co najwyżej

przeliczalna i przy tym określone są prawdopodobieństwa p

i

poszczególnych zdarzeń jednoelementowych

⎨

ω

i

⎬, czyli

P(

⎨

ω

i

⎬) = p

i ,

p

i

≥ 0

i

p

1

+ p

2

+ ...+ p

n

= 1, gdy przestrzeń

Ω

jest skończona

p

1

+ p

2

+........... = 1, gdy przestrzeń

Ω

jest przeliczalna,

to prawdopodobieństwo zdarzenia A

i

, któremu sprzyjają zdarzenia

elementarne

ω

i1

,.....,

ω

ik

jest dane równością :

P(A

i

) = p

i1

+........+ p

ik

.

8

II. Oparta na częstości względnej – popularna wśród fizyków

i inżynierów

Rozpatrywane doświadczenie powtarzamy n razy. Jeżeli zdarzenie

A pojawia się n

A

razy, to jego prawdopodobieństwo P(A) definiuje się

jako granicę częstości względnej n

n

A

zajścia zdarzenia A, czyli

( )

n

n

A

P

A

n

∞

→

= lim

.

III. Definicja klasyczna

Prawdopodobieństwo P(A) zdarzenia A znajdujemy a priori

( bez przeprowadzenia doświadczenia) przez zliczenie ogólnej liczby

N możliwych wyników. Jeżeli zdarzenie A zachodzi w N

A

wynikach

doświadczenia, to P(A) dane jest wzorem

( )

N

N

A

P

A

=

czyli prawdopodobieństwo P(A) jest równe stosunkowi liczby zdarzeń

sprzyjających do wszystkich możliwych pod warunkiem, że są one

jednakowo możliwe.

Doświadczenie losowe D

Na doświadczenie losowe D składają się:

1. Zbiór

Ω

elementów lub wyników czyli przestrzeń zdarzeń

elementarnych

2. Ciało zdarzeń, zbiór zdarzeń S.

3. Liczba P(A) przypisana każdemu zdarzeniu A. Liczba ta jest

prawdopodobieństwem zdarzenia A i podlega aksjomatycznej

definicji prawdopodobieństwa.

9

Przestrzeń probabilistyczna stanowi matematyczny opis

doświadczenia D, czyli zgodnie z powyższym określają ją dla danego

doświadczenia D: przestrzeń zdarzeń elementarnych

Ω

,

zbiór S zdarzeń i prawdopodobieństwo P określone na zdarzeniach

należących do S. Oznaczamy (

Ω

,S,P).

Prawdopodobieństwo zdarzeń niezależnych

Dwa zdarzenia A, B

∈ S są niezależne, gdy :

P( A

∩ B ) = P(A)

⋅

P(B).

Równość ta nie wyklucza sytuacji, gdy P(A) = 0 i P(B) = 0.

Jeżeli P(A)

> 0 i P(B) > 0, to wówczas każda z równości

P(A

⎪

B) = P(A) , P(B

⎪

A) = P(B)

stanowi warunek konieczny i wystarczający na to, aby zdarzenia były

niezależne.

Statystyka matematyczna dostarcza metod wnioskowania

o wartości pewnych parametrów opisujących całą populację generalną

czyli cały zbiór wyników na podstawie uzyskanych dla losowo

wybranej części zbioru.

Populacja generalna zwana również zbiorowością statystyczną, to

ogół elementów ( przedmioty, grupy wiekowe, próbki, pomiary

wyróżniające się pewną cechą ilościową i jakościową) będących

przedmiotem naszego zainteresowania, dla których w oparciu

o odpowiednią próbę losową ( losowo wybraną część zbioru) chcemy

oszacować niektóre charakterystyki rozkładu prawdopodobieństwa

jednej lub kilku ich cech.

Rozróżniamy populację skończoną i nieskończoną. Populację

generalną nieskończoną tworzy nieskończony zbiór elementów

np. tworzą wyniki pomiarów pewnej wielkości, a więc te, które

zostały wykonane lub zostaną wykonane.

10

Próba losowa będzie losowo wybranym podzbiorem elementów

i badania statystyczne wykonujemy dla wszystkich elementów próby.

Statystyka matematyczna pozwala rozszerzyć wnioski z badań próby

na całą populację pod warunkiem, że próba jest reprezentatywna,

czyli że jej struktura nie różni się od struktury populacji generalnej.

ZMIENNA LOSOWA

Zmienna losowa przyjmuje wartości, których nie można ustalić przed

doświadczeniem, czyli zależy od zdarzenia elementarnego, które

realizowało się w doświadczeniu.

Definicja zmiennej losowej

Niech (

Ω

,S,P) będzie dowolną przestrzenią probabilistyczną.

Zmienną losową nazywamy dowolną funkcję X określoną na

przestrzeni zdarzeń elementarnych

Ω

, o wartościach ze zbioru R liczb

rzeczywistych mającą następujące własności:

dla dowolnej, ustalonej liczby rzeczywistej x zbiór zdarzeń

elementarnych

ω

, dla których spełniona jest nierówność

X(

ω

)

< x , jest zdarzeniem,

czyli

⎨

ω

: X(

ω

)

<

x

⎬∈S , dla każdego x∈R.

Gdy przestrzeń zdarzeń elementarnych jest skończona, a zdarzeniami

są wszystkie podzbiory, wtedy powyższy warunek nie stanowi

żadnego ograniczenia i wobec tego każda funkcja X

odwzorowująca zbiór zdarzeń elementarnych

Ω

w zbiór R liczb

rzeczywistych jest zmienną losową.

Jeżeli zmienna losowa będzie przyjmowała wartości skończone lub

przeliczalne to nazywamy ją zmienną skokową (dyskretną),

natomiast gdy przyjmuje dowolne wartości z pewnego przedziału

nazywamy ją zmienną losową ciągłą.

11

Rozkłady prawdopodobieństwa zmiennej losowej

Niech będzie dana zmienna losowa X i liczba rzeczywista x, która

może przyjmować dowolną wartość ze zbioru liczb rzeczywistych

R = ( -

∞ ,+∞ ). Prawdopodobieństwo zajścia zdarzenia ⎨

ω

: X(

ω

)

<

x

⎬

jest funkcją x i nazywa się dystrybuantą zmiennej losowej X.

F

x

(x) = P[

⎨

ω

: X(

ω

)

< x ⎬] = P( X< x)

Posiada ona następujące własności:

1. 0

≤ F(x) ≤1 dla każdego x ∈ R

1.

( )

,

0

lim

=

−∞

→

x

F

x

( )

1

lim

=

+∞

→

x

F

x

2. F(x) jest funkcją niemalejącą

3. F(x) jest funkcją ( co najmniej ) lewostronnie ciągłą, czyli:

F( x

0

– 0 ) = F(x

0

) dla każdego x

∈ R,

gdzie F( x

0

– 0) oznacza granicę lewostronną funkcji F w punkcie

x

0

:

(

)

( )

x

F

x

F

x

x

−

→

=

−

0

lim

0

0

4. Prawdopodobieństwo P( a

≤ X < b) przyjęcia przez zmienną

losową X wartości z przedziału

<a, b) jest równe przyrostowi

dystrybuanty F między punktami a, b:

P( a

≤X < b) = F(b) – F(a)

5. Prawdopodobieństwo P(X=x

0

) przyjęcia przez zmienną losową X

dowolnej ustalonej wartości x

0

wyraża się za pomocą dystrybuanty F

równością:

12

P ( X= x

0

) = F( x

0

+ 0) – F( x

0

),

gdzie F( x

0

+0) oznacza granicę prawostronną dystrybuanty w punkcie

x

0

, czyli:

(

)

( )

x

F

x

F

x

x

+

→

=

+

0

lim

0

0

Zmienna losowa skokowa ( dyskretna)

Zmienna losowa X jest typu skokowego, jeżeli istnieje skończony lub

przeliczalny zbiór W

x

= { x

1

, ......, x

n

,.....} jej wartości x

1

, ......,

x

n

, ... taki, że:

P ( X=x

i

) = p

i

> 0, i∈ N

∑ p

i

= 1 ( warunek unormowania )

i=1

gdzie górna granica sumowania wynosi n albo

∞

stosownie do tego, czy zbiór W

x

jest skończony czy przeliczalny,

x

1

,......,x

n -

punkty

skokowe

p

1

, ..........,p

n

- skoki

Rozkład prawdopodobieństwa zmiennej losowej skokowej można

przedstawić za pomocą:

1.funkcji prawdopodobieństwa

2.dystrybuanty

13

1. Funkcja prawdopodobieństwa zmiennej losowej skokowej

Funkcję p określoną na zbiorze W

x

równością

p ( x

i

) = P(X=x

i

)

≡

p

i

, x

i

∈W

x

,

albo co jest równoważne, dwuwierszową tablicą

x

i

x

1

x

2

..... x

n

p

i

P

1

p

2

..... p

n

i spełniającą warunek unormowania

∑ p

i

= 1,

i =1

nazywamy funkcją prawdopodobieństwa zmiennej losowej X.

2. Dystrybuanta zmiennej losowej skokowej

Gdy dana jest funkcja p prawdopodobieństwa zmiennej losowej X, to

prawdopodobieństwo przyjęcia przez tę zmienną wartości ze zbioru

A jest określone równością:

P( X

∈A) = ∑ p

i

x

i

∈A

Dystrybuanta zmiennej losowej wyraża się wówczas następująco:

F(x) = P (X

< x ) = ∑ p

i

−∞<x

i

<x

Zmienna losowa ciągła

Zmienna losowa X przyjmująca wartości z pewnego

przedziału, dla której istnieje nieujemna funkcja f taka, że

dystrybuantę F zmiennej losowej X można przedstawić w postaci:

14

x

F(x) =

∫ f(t) dt dla x∈ R,

−

∞

nazywamy zmienną losową ciągłą, a funkcję f jej gęstością

prawdopodobieństwa.

Jeżeli x jest punktem ciągłości gęstości f, to:

F`(x) =

dx

x

dF )

(

= f(x)

przy czym

+∞

∫ f(x) dx = 1. ( warunek unormowania)

−∞

Własności zmiennej losowej ciągłej

P( a

≤ X<b ) = P ( a<X≤b) = P( a<X<b) = P( a≤X≤b) = F(b) – F(a)

∧ P(X=c) = 0

c

∈R

b

P( a

≤ X ≤b ) = ∫ f(x) dx = F(b) – F(a)

a

Rozkład prawdopodobieństwa zmiennej losowej ciągłej

przedstawiamy za pomocą

1. gęstości prawdopodobieństwa f(x)

2. dystrybuanty F(x)

15

Funkcje zmiennej losowej X

1. Zmienna losowa skokowa

Niech X będzie skokową zmienną losową o zbiorze W

x

jej

punktów skokowych x

i

i funkcji prawdopodobieństwa p. Niech

g będzie dowolną funkcją o wartościach rzeczywistych określoną co

najmniej na zbiorze W

x

.

Wówczas równość:

Y =g(X) , czyli Y(

ω

) = g[X(

ω

)] ,

ω

∈

Ω

,

określona na przestrzeni zdarzeń elementarnych

Ω

jest nową skokową

zmienną losową Y, zwaną funkcją zmiennej losowej X,

o punktach skokowych y

j

, gdzie y

j

= g(x

i

), tworzących pewien zbiór

W

y

; gdy g nie jest funkcją różnowartościową, to ten sam punkt

skokowy y

j

może odpowiadać więcej niż jednemu punktowi

skokowemu x

i

.

Niech q oznacza funkcję prawdopodobieństwa zmiennej losowej Y.

Funkcja ta jest wyznaczona przez prawdopodobieństwa

p

i

następującymi równościami:

( ) (

)

( )

( )

∑

⎭

⎬

⎫

⎩

⎨

⎧

∈

∈

=

=

=

=

≡

y

j

x

i

j

i

i

W

y

W

x

y

x

g

x

i

j

j

j

x

p

y

Y

P

y

q

q

,

:

2. Zmienna losowa ciągła

Rozważmy zmienną losową Y określoną równością:

Y = g(X), gdzie y = g(x) jest określona co najmniej na zbiorze

wartości zmiennej losowej X. Zmienna losowa X jest zmienną ciągłą

o dystrybuancie F.

Rozkład prawdopodobieństwa zmiennej losowej Y można wyznaczyć

bezpośrednio z definicji dystrybuanty G tej zmiennej.

16

G(y) = P(Y

<y) = P[g(X)

<

y]

Gęstość prawdopodobieństwa k zmiennej losowej Y, w przypadku

gdy funkcja g jest ściśle monotoniczna wyznaczamy, korzystając

z następującego twierdzenia.

Twierdzenie

Jeżeli X jest zmienną losową ciągłą o gęstości f skoncentrowanej na

przedziale (a, b) oraz y = g(x) jest funkcją ściśle monotoniczną klasy

C

1

o pochodnej g`(x)

≠ 0 w tym przedziale, przy czym x = h(y) jest

funkcją odwrotną do y = g(x), to gęstość k zmiennej losowej ciągłej

Y =g(X), jest postaci:

( )

( )

[ ]

( )

⎩

⎨

⎧

≥

≤

〈

〈

=

d

y

c

y

dla

d

y

c

dla

y

h

y

h

f

y

k

0

'

gdzie c = min(c

1

, d

1

), d= max(c

1

, d

1

)

c

1

= lim g(x) d

1

= lim g(x)

x

→

a+ x

→

b

−

CHARAKTERYSTYKI LICZBOWE

Charakterystyki liczbowe – parametry charakteryzujące rozkład

prawdopodobieństwa zmiennej losowej.

MOMENTY STATYSTYCZNE

W przypadku wyboru funkcji

g(X) = (X- a)

l

,

wartości oczekiwane

E[g(X)] = E[(X-a)

l

] =

μ

l

,

17

nazywane są l- tymi momentami statystycznymi względem

punktu a.

Jeżeli

a = 0 - momenty bezwzględne

a = E(X) - momenty centralne

1. Zmienna losowa skokowa

μ

l

=

∑ (x

i

– a )

l

P(X=x

i

)

x

i

∈W

x

2. Zmienna losowa ciągła

+∞

μ

l

=

∫ (x- a)

l

f(x) dx

-

∞

I. Wartość oczekiwana (przeciętna, średnia) zmiennej losowej

Wartość oczekiwana E(X) zmiennej losowej X jest bezwzględnym

momentem statystycznym pierwszego rzędu,

0

1

μ

= E(X).

I.1. Zmienna losowa skokowa

Wartość oczekiwana E(X) jest równa sumie możliwych wartości x

i

zmiennej losowej X mnożonych przez ich prawdopodobieństwa p

i

( )

∑

∑

∈

∈

=

≡

=

x

i

x

i

W

x

W

x

i

i

i

i

x

X

P

x

p

x

X

E

)

(

18

E(Y) = E[g(X)] =

∑g(x

i

) P(X=x

i

)

( )

⎪⎭

⎪

⎬

⎫

⎪⎩

⎪

⎨

⎧

∈

∈

=

y

j

x

i

j

i

i

W

y

W

x

y

x

g

x

,

:

I. 2. Zmienna losowa ciągła

+∞

E(X) =

∫ x f(x) dx

−∞

+

∞

E(Y) = E[g(X)] =

∫ g(x) f(x) dx

−∞

+

∞

E(Y) =

∫ y k(y) dy

−∞

Własności wartości oczekiwanych

1. E(cX) = c E(X) c – stała

2. E(c) = c

3. E( X + Y ) = E(X) + E(Y)

4.

(

)

( ) ( )

( )

,

2

1

2

1

n

n

X

E

X

E

X

E

X

X

X

E

⋅⋅

⋅⋅

⋅

=

⋅⋅

⋅⋅

⋅

jeżeli zmienne losowe X

1

, X

2

, ......., X

n

są niezależne i mają wartości

oczekiwane.

II. Wariancja zmiennej losowej

Moment statystyczny centralny drugiego rzędu

μ

2

= E{[ X – E(X) ]

2

} = D

2

(X)

nazywamy wariancją D

2

(X) zmiennej losowej X.

Wariancja D

2

(X) zmiennej losowej X jest miarą szerokości rozkładu

w pobliżu wartości oczekiwanej E(X).

19

Dodatni pierwiastek z wariancji tj.

( )

X

D

2

nazywamy

odchyleniem standardowym i jest on miarą średniego odchylenia

wartości zmiennej losowej X od jej wartości oczekiwanej E(X).

II.1. Zmienna losowa skokowa

D

2

(X) =

∑ [ x

i

– E(X)]

2

P(X=x

i

)

x

i

∈W

x

II.2. Zmienna losowa ciągła

+

∞

D

2

(X) =

∫ [x-E(X)]

2

f(x) dx

- -

∞

Własności wariancji

1. D

2

( X

±Y ) = D

2

(X) + D

2

(Y), gdy X, Y są niezależne.

2. D

2

(c) = 0 c - stała

3. D

2

(cX) = c

2

D

2

(X)

4. D

2

(X +b) = D

2

(X)

5. D

2

(X) =E(X

2

) – [E(X)]

2

III. Współczynnik asymetrii

Trzeci moment statystyczny centralny trzeciego rzędu

μ

3

= E{[X – E(X) ]

3

}

nazywamy skośnością.

20

Wygodniej jest jednak zdefiniować parametr bezwymiarowy

( )

( )

X

D

X

D

2

2

3

μ

γ

=

,

który nazywamy współczynnikiem asymetrii rozkładu

prawdopodobieństwa zmiennej losowej X.

Zawiera on informację o możliwych różnicach między dodatnimi

a ujemnymi odchyleniami od wartości oczekiwanej.

IV. Współczynnik spłaszczenia

Moment statystyczny centralny czwartego rzędu pozwala

zdefiniować współczynnik spłaszczenia

( )

[

]

3

`

2

2

4

−

=

X

D

μ

γ

,

przy czym dla rozkładu normalnego standaryzowanego

μ

4

= 3 [D

2

(X)]

2

,

γ

` = 0.

Jeżeli

γ

`

< 0, to krzywa w pobliżu max jest rozmyta w porównaniu

z rozkładem standaryzowanym, a jeżeli

γ

>0 bardziej wysmukła.

V. Wartość modalna (moda, dominanta)

Wartość modalną x

M

rozkładu prawdopodobieństwa

definiujemy jako wartość zmiennej losowej X odpowiadającej

maximum:

a) funkcji prawdopodobieństwa p(x

i

) dla zmiennej skokowej,

p(x

M

) = P(X=x

M

) = max,

czyli będzie to punkt skokowy oprócz punktu x

min

i x

max

,

21

b) maximum absolutnemu gęstości f(x) dla zmiennej ciągłej,

czyli, jeżeli gęstość f(x) posiada pierwszą i drugą pochodną,

wartość modalna x

M

odpowiada maximum rozkładu, określone

przez warunki

( )

( )

0

,

0

2

2

〈

=

x

f

dx

d

x

f

dx

d

Jeżeli gęstość f(x) posiada więcej niż jedno maximum, to modą jest ta

wartość zmiennej losowej, która odpowiada maximum absolutnemu

( f(x) przyjmuje tu największą wartość).

Jeżeli rozkład prawdopodobieństwa zmiennej losowej X ma jedno

max, to mówimy, że jest to rozkład jednomodalny, jeżeli więcej to

wielomodalny. Wartość modalna dla rozkładu prawdopodobieństwa

w próbie nazywa się dominantą(D).

VI. Mediana (wartość środkowa)

Medianę x

0.5

( dla próby Me ) rozkładu prawdopodobieństwa

zmiennej losowej X definiujemy jako wartość zmiennej losowej dla

której dystrybuanta przyjmuje wartość równą 0.5,

F(x

0.5

) = P(X

<

x

0.5

) = 0.5

VI.1. Zmienna losowa skokowa

F(x

0.5

) =

∑ P(X=x

i

) = 0.5

−∞<x

i

<

x

0.5

VI.2. Zmienna losowa ciągła

x

0.5

F(x

0.5

) =

∫ f(x) dx = 0.5

−∞

Mediana dzieli cały zakres wartości zmiennej losowej na dwa obszary

o równym prawdopodobieństwie.

22

Dla rozkładu jednomodalnego, symetrycznego, posiadającego

ciągłą gęstość prawdopodobieństwa, wartość modalna, średnia

i mediana są identyczne.

VII. Kwantyle

Definicję mediany można uogólnić wprowadzając

kwantyle(fraktyle) będącymi wartościami x

q

zmiennej losowej X, dla

których

x

q

F(x

q

) =

∫ f(x) dx = q 0<q<1

−∞

F(x

0.25

) = 0.25 - kwartyl dolny

F(x

0,75

) = 0.75 - kwartyl górny

x

0.1

, x

0.2

, - decyle

Definicja ogólna kwantyli

Kwantylem rzędu q, 0

<q<1 zmiennej losowej X

o dystrybuancie F(x) nazywamy taką liczbę x

q

, że

P(X

< x

q

)

≤ q ≤ P(X ≤ x

q

),

czyli

F(x

q

)

≤ q ≤ F(x

q

+ 0).

WYBRANE ROZKŁADY PRAWDOPODOBIEŃSTWA

I. Zmienna losowa skokowa

I.1. Rozkład dwumianowy(binomialny), Bernouliego

23

Definicja

Zmienna losowa K typu skokowego ma rozkład dwumianowy

z parametrami (n,p), n

∈N, 0< p < 1, jeżeli jej funkcja

prawdopodobieństwa p

k

≡

P(k; n ,p) = P(K =k), jest postaci :

(

)

k

n

k

q

p

p

n

k

P

k

n

−

⎟

⎠

⎞

⎜

⎝

⎛

=

,

;

,

k=0,1,2.....,n i q = 1 – p

Zmienna ta przyjmuje z dodatnimi prawdopodobieństwami

( n+1) wartości: 0,1.....,n.

Wśród nich jest jedna albo dwie wartości najbardziej prawdopodobne:

a) gdy (n+1)p jest liczbą całkowitą to tymi wartościami są liczby

k

1

= (n+1)p – 1, k

2

= (n+1)p,

b) gdy ( n+1)p nie jest liczbą całkowitą to wartość najbardziej

prawdopodobna dana jest wzorem

k

0

=[(n+1)p],

czyli częścią całkowitą liczby (n+1)p.

E(K) = np, D

2

(X) = npq ,

npq

p

2

1

−

=

γ

I.2. Rozkład wielomianowy

Uogólniony na przypadek, gdy w wyniku jednego doświadczenia

może wystąpić l zdarzeń rozłącznych A

1

, A

2

,......., A

l

i

Ω

= A

1

∪A

2

∪.......∪A

l.

Definicja

Niech prawdopodobieństwa zajścia wzajemnie wykluczających

się zdarzeń A

j

będą dane przez :

24

P(A

j

) = p

j

i

.

1

1

=

∑

=

l

j

j

p

Każdemu zdarzeniu A

j

przyporządkowujemy zmienną losową K

j

, tak

że

( )

{

}

j

j

j

j

k

A

K

:

A

=

, to prawdopodobieństwa zajścia k

j

zdarzeń A

j

w n doświadczeniach

{

}

∏

∏

=

=

=

=

=

=

l

j

k

j

l

j

j

l

l

j

p

k

n

k

K

k

K

k

K

P

1

1

2

2

1

1

!

!

;

;.........

;

E(K

j

)=np

j

, D

2

(K

j

)=np

j

(1 – p

j

).

I.3. Rozkład hipergeometryczny

Jest to rozkład dla prób bez zwrotu, tzn. po wylosowaniu danego

elementu zmienia się wzajemna proporcja pozostałych.

Definicja

Zmienna losowa skokowa K ma rozkład hipergeometryczny

z parametrami (N, M, n), gdzie N,M,n liczby naturalne oraz M,n

≤

N,

jeżeli jej funkcja prawdopodobieństwa

p

k

≡

P(k; N,M,n ) = P(K=k) jest postaci:

(

)

( )( )

( )

N

n

M

N

k

n

M

k

n

M

N

k

P

−

−

=

,

,

;

,

gdzie k=0,1,....,n n

≤ N, k ≤ M, k ≤n, n – k ≤ N – M

E(K)=np,

( )

1

2

−

−

=

N

n

N

npq

X

D

,

25

gdzie

N

M

p

=

i q=1 – p

Możemy powiedzieć, że zmienna losowa K jest możliwą liczbą

elementów mających wyróżnioną cechę A wśród n wylosowanych

bez zwrotu z populacji N elementów wśród których znajdowało się

M elementów cechy A.

Gdy N

→

∞, M

→

∞, tak że

p

N

M →

, 0

<p<1,

wtedy

P(k;N,M,n)

→

P(k;n,p)

Powyższy rozkład możemy rozszerzyć na przypadek, gdy

wyróżnionych cech w populacji jest więcej.

Definicja

Niech każde z N elementów naszej populacji posiada jedną

z l cech

N = N

1

+ N

2

+.......+ N

l

.

Prawdopodobieństwo wylosowania bez zwrotu k

j

( j= 1,2,.......,l)

elementów każdego rodzaju przy n losowaniach

(

)

( )( )

( )

( )

N

n

N

k

N

k

N

k

l

l

l

l

k

K

k

K

k

K

P

.....

;.......;

;

2

2

1

1

2

2

1

1

=

=

=

=

,

gdzie k

1

+ k

2

+..+k

n

= n.

I.4. Rozkład Poissona

Stosujemy, gdy n

→∞

, a p bardzo małe,

λ

= np.

26

Definicja

Zmienna losowa skokowa K ma rozkład Poissona

z parametrem

λ

,

λ>

0, jeżeli jej funkcja prawdopodobieństwa

p

k

≡

P(k;

λ

) = P(K=k) jest postaci:

( )

!

;

k

e

k

P

k

λ

λ

λ

−

=

, k

∈N

0

=N

∪{0}.

W praktyce stosujemy, gdy n

≥50, p ≤ 0.1, np≤ 10.

Rozkład Poissona jest granicznym przypadkiem rozkładu

dwumianowego.

Twierdzenie

Jeżeli K

1

,K

2

, ......, K

n

,.. jest ciągiem zmiennych losowych

o rozkładzie dwumianowym odpowiednio z parametrami

(1, p

1

),..,(n,p

n

),... oraz np

n

→λ

,

λ

>0, gdy n→∞, to:

( )

,

!

)

1

(

lim

k

e

p

p

k

k

n

n

k

n

n

k

n

λ

λ

−

−

∞

→

=

−

k

∈N∪{0}

czyli ciąg rozkładów dwumianowych jest zbieżny do rozkładu

Poissona z parametrem

λ

.

λ

λ

λ

λ

e

k

e

n

k

k

n

n

=

=

⎟

⎠

⎞

⎜

⎝

⎛ −

∑

∞

=

−

∞

→

0

!

,

1

lim

E(K)=

λ

, D

2

(K) =

λ

,

λ

γ

1

=

Rozkład Poissona jest rozkładem o asymetrii prawostronnej .

27

II. Zmienna losowa ciągła

II.1 Rozkład jednostajny

Definicja

Zmienna losowa X ma rozkład jednostajny ( prostokątny )

skoncentrowany na przedziale

<

a, b

>

jeżeli jej gęstość

prawdopodobieństwa jest określona wzorem:

⎪⎩

⎪

⎨

⎧

〉

〈

≤

≤

−

=

b

x

a

x

dla

b

x

a

dla

a

b

x

f

lub

0

1

)

(

Dystrybuantą tego rozkładu jest funkcja

( )

⎪

⎩

⎪

⎨

⎧

〉

≤

〈

−

−

≤

=

b

x

dla

b

x

a

dla

a

b

a

x

a

x

dla

x

F

1

0

( ) (

)

( ) ( )

x

x

b

x

x

a

x

X

D

a

b

X

D

b

a

X

E

rzecz

rzecz

Δ

+

=

Δ

−

=

Δ

=

−

=

+

=

,

3

,

12

,

2

)

(

2

2

2

2

28

II.2. Rozkład normalny standaryzowany

Twierdzenie Moivrea – Laplacea pozwala na przejście

z rozkładu dwumianowego do rozkładu normalnego

standaryzowanego.

Dla ustalonego p, 0

< p < 1 i q = 1 – p, prawdopodobieństwo

( )

∑

+

〈

〈

+

=

=

npq

b

np

k

npq

a

np

n

k

K

P

b

a

P

)

(

,

,

tego, że w serii n prób Bernouliego o prawdopodobieństwie

p zdarzenia sprzyjającego, ilość tych zdarzeń będzie zawarta

w granicach

npq

b

np

k

npq

a

np

+

〈

〈

+

przy n

→

∞, będzie dążyć

( )

du

e

b

a

P

u

b

a

n

n

2

2

2

1

,

lim

−

∞

→

∫

=

π

.

Zmienna losowa U ma rozkład normalny standaryzowany, jeżeli

jej gęstość

ϕ

określona jest wzorem

( )

2

2

2

1

u

e

u

−

=

π

ϕ

dla

−∞

<

u

<+∞

π

2

1

2

2

=

∫

+∞

∞

−

−

dt

e

t

t

,

π

=

∫

+∞

∞

−

−

dt

e

t

2

π

4

3

2

4

=

−

+∞

∞

−

∫

dt

e

t

t

29

Dystrybuanta

Φ

(u) wyraża się następująco:

( )

( )

dt

e

dt

t

u

t

u

u

2

2

1

−

∞

−

∞

−

∫

∫

=

=

Φ

π

ϕ

. ( funkcje Laplacea)

( )

( )

( )

( )

( )

[

]

( )

6826

.

0

1

8413

.

0

2

1

1

2

1

1

1

1

1

1

1

=

−

⋅

=

=

−

+

Φ

=

+

Φ

−

−

+

Φ

=

−

Φ

−

+

Φ

=

∫

+

−

du

u

ϕ

( )

( )

( )

( )

9973

.

0

1

998650

.

0

2

1

3

2

3

3

3

3

=

−

⋅

=

−

+

Φ

=

−

Φ

−

+

Φ

=

∫

+

−

du

u

ϕ

II.3. Rozkład normalny

Wprowadzamy zmienną losową X, która jest liniową funkcją

zmiennej U

X=m+

σ

U gdzie m,

σ

są stałymi i

σ

>0

Gęstość f zmiennej losowej X wyznaczymy następująco:

X=g(U) U=h(X)

( )

σ

m

X

X

h

−

=

,

( )

(

)

( )

x

h

e

x

f

m

x

′

=

−

−

2

2

2

2

1

σ

π

stąd

( )

(

)

2

2

2

2

1

σ

π

σ

m

x

e

x

f

−

−

=

30

Rozkład prawdopodobieństwa zmiennej losowej X określony

gęstością f

( )

(

)

2

2

2

2

1

σ

π

σ

m

x

e

x

f

−

−

=

gdzie

−∞<x<+∞

nazywamy rozkładem normalnym N(m,

σ

).

Podobnie oznaczamy rozkład normalny standaryzowany, czyli

N(0,1).

E(X)=m, D

2

(X) = D

2

(m) +

σ

2

D

2

(U) , D

2

(X)=

σ

2

punkty przegięcia

x

1

= m –

σ

, x

2

= m+

σ

Dystrybuanta F(x) ma następującą postać:

( )

( )

(

)

( )

σ

−

=

Φ

=

π

σ

=

=

σ

−

−

∞

−

∞

−

∫

∫

m

x

u

gdzie

,

u

e

dt

t

f

x

F

m

x

x

x

2

2

2

2

1

Zmienną losową X nazywamy zmienną normalną, natomiast

zmienną U normalną standaryzowaną. Powyższe zależności opisują

standaryzację zmiennej losowej X.

P(m-

σ<

X

<

m+

σ

) = F(m

+σ

)

−

F(m

−σ

) =

Φ

(

+1)

−Φ

(

−1)=0.6826,

ponieważ dla

x

1

=m –

σ

1

1

−

=

−

−

=

σ

σ

m

m

u

x

2

=m

+σ

1

2

=

−

+

=

σ

σ

m

m

u

31

P(x –

σ

<m<x+

σ

)

≅0.68 gdzie przyjmujemy m = x

rzecz

Podobnie możemy pokazać, że

P(m –3

σ<

X

<

m+3

σ

)

≅ 0.998

PRÓBA LOSOWA

Najprostszym rodzajem próby statystycznej jest próba prosta.

Definicja

Jeżeli X

1

,X

2

, ......., X

n

jest ciągiem niezależnych obserwacji

losowych ze zbiorowości, w której dystrybuanta zmiennej losowej X

jest równa F(x) i jeżeli mechanizm doboru obserwacji jest taki, że

każda ze zmiennych losowych X

i

( i=1,2,3..,n) ma dystrybuantę

równą F(x), to ciąg odpowiednich wyników obserwacji x

1

, x

2

,....,x

n

nazywać będziemy statystyczną próbą prostą ze zbiorowości

o dystrybuancie F(x).

Każdą inną próbę nie będącą próbą prostą będziemy nazywać próbą

złożoną.

Próba prosta ( losowanie niezależne, losowanie zwrotne)

Próba złożona ( losowanie zależne, losowanie bezzwrotne)

Losowanie prób prostych

1. Tablice liczb losowych (2,4,6 cyfrowe)

Zostały tak utworzone, że dzieląc liczby w tablicach przez

10

r

(r=2,4,6) otrzymujemy ciąg niezależnych zmiennych losowych

o rozkładzie jednostajnym w przedziale

<0, 1>.

2. Losowanie systematyczne

Jeżeli elementy zbiorowości są w naturalny sposób ponumerowane

i tak wyznaczony porządek nie jest powiązany ze zmienną losową,

wówczas do próby bierzemy co k-ty element, gdzie k jest największą

liczbą naturalną nie przekraczającą

n

N

(N – liczebność populacji

32

n – liczebność próby).

n

0

≤

k n

0

, n

0

+k, n

0

+2k, ,N

np. N=50 , n

0

=3 , n= 10

k=5, 3,8,11,14,17,20,23,26,29,32.

Losowanie prób złożonych

A. Kryterium podzielności populacji

a) losowanie nieograniczone (z całej populacji)

b) losowanie warstwowe (elementy z warstw populacji)

B. Jednostki biorące udział w losowaniu

a)losowanie indywidualne

b)losowanie grupowe (grupy charakteryzuje wspólna cecha,

większa ilość elementów)

W przypadku badań eksperymentalnych mamy do czynienia

z populacjami nieskończonymi. Stąd trudno mówić o sposobie

losowania. Sposób losowania nie jest istotny, ponieważ realizacje

zmiennych losowych są znane. Badania statystyczne polegają tu na

wnioskowaniu o dystrybuantach badanych zmiennych losowych.

Często badamy wpływ czynników stabilizowanych, kontrolowanych z

odpowiednim natężeniem na naszą próbę. Jeżeli natężenie czynników

zmienia się w sposób ciągły mamy do czynienia

z modelem regresyjnym, jeżeli skokowo lub nie jest mierzalne

liczbowo z analizą wariancji.

Wstępnym badaniem próby zajmuje się statystyka opisowa, gdzie nie

stosujemy rachunku prawdopodobieństwa.

33

STATYSTYKA OPISOWA

Wstępnym badaniem próby zajmuje się statystyka opisowa.

Rozróżniamy trzy rodzaje prób. W każdej z nich wyznaczamy:

a) wartość średnią

( )

x

b) medianę ( Me )

c) dominantę( wartość modalną )(D)

d) miary rozproszenia

d

1

) najprostszy rozstęp (R = x

max

– x

min

)

d

2

) odchylenie standardowe

⎟

⎠

⎞

⎜

⎝

⎛

∧

S

S,

e) współczynnik zmienności

x

S

V

=

f) kwartyl dolny Q

1

( mediana wartości mniejszych i równych Me )

g) kwartyl górny Q

3

( mediana wartości większych i równych Me)

h) odchylenie ćwiartkowe

2

1

3

Q

Q

Q

−

=

Rodzaje prób

1. Mamy n różnych wartości x

i

a)

∑

=

=

n

i

i

x

n

x

1

1

b) Me =

x

n

2

1

+

dla n nieparzystego

Me

=

2

1

2

2

x

x

n

n

+

+

dla n parzystego, przy uporządkowaniu

rosnącym

d

2

)

(

)

∑

−

−

=

∧

2

1

1

x

x

n

s

i

dla n<30

34

(

)

∑

=

−

=

n

i

i

x

x

n

s

1

2

1

dla n

≥ 30

2. Wartości x

i

powtarzają się n

i

- krotnie

a)

∑

=

=

k

i

i

i

n

x

n

x

1

1

,

gdzie

n

n

k

i

i

=

∑

=1

b) przed wyznaczeniem wartości Me, musimy znaleźć liczebności N

i

skumulowane (ponumerowane obserwacje odpowiadające danej

wartości x

i

)

N

i

= N

i-1

+ n

i

Wartość mediany odpowiada tej wartości x

i

dla której

N

i-1

< N

Me

≤ N

i

,

gdzie

2

1

+

=

n

N

Me

dla n nieparzystego

2

n

N

Me

=

dla n parzystego

c) dominanta (D) to wartość x

i

dla n

i

= max

d

2

)

(

)

n

n

x

x

s

k

i

i

i

∑

=

−

=

1

2

35

3. Szeregi rozdzielcze

Wyniki grupujemy i przedstawiamy w postaci klas (przedziałów).

Liczbę k klas możemy ustalić korzystając z następujących

zależności:

k

≤

5 lnn ,

n

k

=

, k = 1 + 3.322lnn (k

max

= 30)

Szerokość przedziału h (h = x

i

– x

i-1

) zależy od ilości klas i wartości

rozstępu

R.

k

R

h

≥

Dolną granicę pierwszego przedziału przyjmujemy: [ x

min

– (

α/

2) ],

gdzie

α

jest dokładnością pomiarów.

a)

∑

=

i

i

n

n

x

x

0

1

, gdzie

2

1

0

i

i

i

x

x

x

+

=

−

jest środkiem i-tego

przedziału, n

i

jego liczebnością

b)

(

)

∗

−

+

=

N

N

n

h

x

Me

Me

0

0

,

gdzie

N

Me

–

numer obserwacji odpowiadającej medianie

N

*

- skumulowana liczba obserwacji przed przedziałem mediany

x

0

– dolna granica przedziału klasowego mediany

n

0

– liczebność przedziału mediany

36

c) dominanta – wybieramy przedział o n

i

= max ( przedział

dominanty)

)

(

)

(

1

1

1

0

+

−

−

−

+

−

−

+

=

d

d

d

d

d

d

n

n

n

n

n

n

h

x

D

,

x

0

– dolna granica przedziału dominanty

n

d

– liczebność przedziału dominanty

n

d-1

– liczebność przedziału przed przedziałem dominanty

n

d+1

– liczebność przedziału za przedziałem dominanty

d

2

)

(

)

n

n

x

x

s

k

i

i

i

∑

=

−

=

1

2

0

Jeżeli n

> 1000 lub k > 20 musimy od S

2

odjąć poprawkę

Shepparda:

2

12

1

h

STATYSTYKI, ROZKŁADY

PRAWDOPODOBIEŃSTWA

Statystyką nazywamy każdą zdefiniowaną funkcję obserwowanych

w próbie zmiennych losowych, która sama jest zmienną losową. Jako

zmienna losowa statystyka ma pewien rozkład prawdopodobieństwa

a ponieważ jest określoną funkcją zmiennych losowych, przeto jej

rozkład jest wyznaczony przez rozkład zmiennych losowych i postać

funkcji.

STATYSTYKI

1. Średnia arytmetyczna z próby, X

∑

=

=

n

i

i

X

n

X

1

1

37

Twierdzenie

o rozkładzie prawdopodobieństwa zmiennej losowej .

X

Jeżeli X

1,

X

2,

......,X

n

jest ciągiem niezależnych zmiennych losowych

o rozkładach normalnych N(m,

σ

) i jeżeli

∑

=

=

n

i

i

X

n

X

1

1

to zmienna losowa

X

ma rozkład normalny

⎟⎟

⎠

⎞

⎜⎜

⎝

⎛

n

m

N

σ

,

.

Twierdzenie

Niech

X

będzie średnią arytmetyczną niezależnych zmiennych

losowych X

1,

X

2,

......, X

n1

o rozkładach normalnych N

(m

1

,

σ

1

) i niech

Y

będzie średnią arytmetyczną niezależnych zmiennych losowych

Y

1

, Y

2

, ......, Y

n2

o rozkładach normalnych N(m

2

,

σ

2

). Jeżeli zmienne

losowe X

1

, X

2

,........,X

n1

oraz Y

1

, Y

2

,.........,Y

n2

są niezależne,

wówczas zmienna losowa

Y

X

−

ma rozkład normalny

⎟

⎟

⎠

⎞

⎜

⎜

⎝

⎛

+

−

2

2

2

1

2

1

2

1

,

n

n

m

m

N

σ

σ

.

2. Statystyka

χ

2

Niech U

1

, U

2

,......, U

k

będzie ciągiem niezależnych zmiennych

standaryzowanych N(0,1). Statystykę

∑

=

=

k

i

i

U

1

2

2

χ

definiujemy jako sumę kwadratów zmiennych losowych U

1

,

U

2

,....,U

k

. Rozkład prawdopodobieństwa statystyki

χ

2

będziemy

nazywać rozkładem chi-kwadrat, a liczbę niezależnych składników

składających się na

χ

2

nazywamy stopniami swobody k.

E(

χ

2

) = k ,

,

4

k

=

γ

f(

χ

2

) = max dla

χ

2

= k – 2

38

Twierdzenie

Jeżeli zmienne losowe

χ

1

2

i

χ

2

2

są niezależne i mają rozkłady chi-

kwadrat o k

1

i

k

2

stopniach swobody, to zmienna losowa

χ

2

=

χ

1

2

+

χ

2

2

ma rozkład chi-kwadrat

o k

1

+k

2

stopniach swobody.

ROZKŁAD PRAWDOPODOBIEŃSTWA DLA

WARIANCJI I ODCHYLENIA STANDARDOWEGO

Wprowadzamy dwie definicje:

(

)

(

)

m

znamy

nie

gdy

X

X

n

S

m

znamy

gdy

m

X

n

S

n

i

i

n

i

i

2

1

2

2

1

2

1

1

∑

∑

=

=

∗

−

=

−

=

Twierdzenie

Jeżeli X

1,

X

2

,.......,X

n

jest ciągiem niezależnych zmiennych

losowych o rozkładzie normalnym N(m,

σ

) to zmienna losowa

2

2

σ

∗

nS

ma rozkład chi- kwadrat o n stopniach swobody.

Dowód

(

)

∑

∑

∑

=

=

=

∗

=

⎟

⎠

⎞

⎜

⎝

⎛

−

=

−

⋅

=

n

i

i

n

i

i

n

i

i

U

m

X

m

X

n

n

nS

1

2

2

1

1

2

2

2

2

1

σ

σ

σ

ponieważ

i

i

U

m

X

=

−

σ

jest zmienną losową o rozkładzie

N(m,

σ

), zmienne są niezależne, ilość stopni swobody równa jest n.

39

n

nS

E

=

⎟⎟

⎠

⎞

⎜⎜

⎝

⎛

∗

2

2

σ

,

( )

2

2

σ

=

∗

S

E

Twierdzenie

Jeżeli X

1

, X

2

, ......,X

n

jest ciągiem zmiennych losowych o

rozkładzie normalnym N(m,

σ

), to zmienna losowa

2

2

σ

nS

ma rozkład

chi-kwadrat o n – 1 stopniach swobody, ponieważ ostatni składnik

sumy musi spełniać warunek

(

)

0

1

=

−

∑

=

n

i

i

X

X

.

3. Statystyka F( Snedecora)

Definicja

Niech

2

1

χ

i

2

2

χ będą niezależnymi zmiennymi losowymi

o rozkładzie chi-kwadrat i odpowiednio k

1

i k

2

stopniach swobody,

to statystyka

1

2

2

2

2

1

k

k

F

⋅

⋅

=

χ

χ

,

ma rozkład F (rozkład Snedecora) o k

1

i k

2

stopniach swobody.

Rozkład F ma zastosowanie do badania wariancji dwóch populacji.

Twierdzenie

Jeżeli

2

1

∧

S

i

2

2

∧

S

są wariancjami z prób prostych, pobranych ze

zbiorowości o rozkładach normalnych w których odchylenia

standardowe są jednakowe, i zdefiniowane są następująco:

(

)

2

1

1

1

1

2

1

1

1

1

∑

=

∧

−

−

=

n

j

j

X

X

n

S

,

(

)

∑

=

∧

−

−

=

2

1

2

2

2

2

2

2

1

1

n

j

j

X

X

n

S

40

to gdy obie próby są niezależne zmienna losowa

2

2

2

1

∧

∧

S

S

ma rozkład F

o (n

1

– 1) oraz (n

2

– 1 ) stopniach swobody.

4. Statystyka t-Studenta

Definicja

Niech U będzie zmienną losową standaryzowaną N(0,1) i niech

χ

2

będzie zmienną losową o rozkładzie chi-kwadrat i k stopniach

swobody. Jeżeli zmienne U i

χ

2

są niezależne, to statystyka

k

U

t

2

χ

=

ma rozkład t-Studenta o k- stopniach swobody.

E(t) = 0, -

∞<t<+∞ ,

γ

= 0

Twierdzenie

Ciąg dystrybuant zmiennej losowej o rozkładzie f(t) przy k

→∞

jest zbieżny do dystrybuanty rozkładu normalnego standaryzowanego

N(0,1).

Twierdzenie

Jeżeli X

1

, X

2

, .........,X

n

jest ciągiem niezależnych zmiennych

losowych o rozkładzie normalnym N(m,

σ

) i mamy określone zmienne

losowe

X

, S

2

, to zmienna losowa

1

−

−

=

n

S

m

X

t

ma rozkład t- Studenta o n – 1 stopniach swobody.

41

Twierdzenie

Jeżeli

1

X

i S

1

oznaczają odpowiednio średnią arytmetyczną

i odchylenie standardowe z próby liczącej n

1

niezależnych obserwacji

losowych ze zbiorowości o rozkładzie N(m

1

,

σ

) i jeżeli

2

X

, S

2

to

średnia arytmetyczna oraz odchylenie standardowe z drugiej próby

liczącej n

2

niezależnych obserwacji pobranych ze zbiorowości

o rozkładzie N(m

2

,

σ

) i jeżeli obie próby są niezależne, to zmienna

losowa

(

)

⎟⎟

⎠

⎞

⎜⎜

⎝

⎛

+

−

+

⋅

+

⋅

−

−

−

=

2

1

2

1

2

2

2

2

1

1

2

1

2

1

1

1

2

n

n

n

n

S

n

S

n

m

m

X

X

t

ESTYMACJA

I. ESTYMACJA PUNKTOWA

II. ESTYMACJA PRZEDZIAŁOWA

Ad.I Szukanie liczby, która w oparciu o odpowiednie wyniki z próby i

odpowiednie kryteria dokładności będzie najlepszym przybliżeniem

nieznanego, interesującego nas parametru rozkładu zmiennej losowej

dla populacji.

Ad.II Szukanie przedziałów liczbowych takich, by z odpowiednim

prawdopodobieństwem bliskim jedności można oczekiwać, że wartość

szukanego parametru rozkładu(charakterystyki liczbowej) znajdzie się

w tym przedziale.

Parametry rozkładu – wielkości stałe, nielosowe

Wyniki próby statystycznej – losowe

42

Definicja estymatora

Estymatorem parametru

Θ

rozkładu prawdopodobieństwa

zmiennej losowej X nazywamy każdą taką funkcję zmiennych

losowych obserwowanych w próbie, że jest ona zmienną losową o

rozkładzie zależnym od

Θ

i że wnioskowanie o wartości

Θ

można

oprzeć na zaobserwowanej w próbie wartości funkcji.

Jeżeli przez X

1

, X

2

,.......,X

n

oznaczymy zaobserwowane w próbie

zmienne losowe to oparty na tych zmiennych estymator będziemy

oznaczać T

n

( X

1

, X

2

,.......,X

n

;

Θ

)

≡

T

n

.

METODY WYZNACZANIA ESTYMATORÓW

1. Metoda momentów Pearsona

Obliczamy momenty z próby i przyrównujemy do odpowiednich

momentów rozkładu, będących funkcjami nieznanych parametrów

rozkładu . Rozwiązujemy równania i znajdujemy wzory na

odpowiednie estymatory.

a) wartość oczekiwana E(X)

E(X) =

μ

1

0

x

x

n

n

x

n

i

i

n

i

i

=

=

=

∑

∑

=

=

1

1

0

1

1

1

μ

b) wariancja D

2

(X)

D

2

(X) =

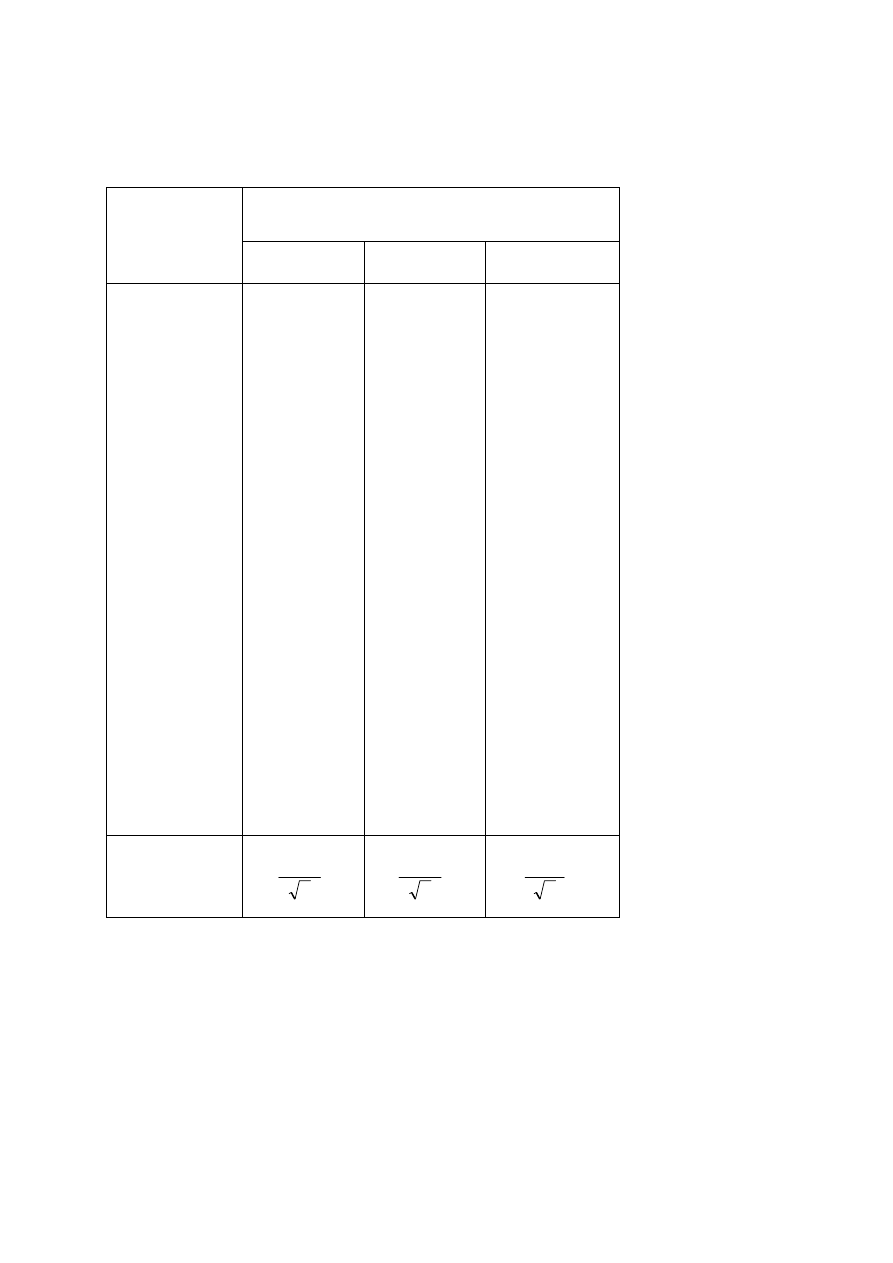

μ

0

2

– [

μ

0

1

]

2

( )

( )

{

}

( )

( )

(

)

(

)

2

2

1

1

2

2

2

1

1

2

2

1

2

2

1

2

2

0

1

0

2

1

2

1

2

2

1

2

2

1

1

S

x

x

n

x

x

x

x

n

x

x

x

n

x

x

x

n

x

x

x

x

x

x

n

x

n

x

n

i

i

n

i

i

i

n

i

i

n

i

i

i

i

i

n

i

i

n

i

i

=

−

=

+

−

=

−

+

⎟

⎠

⎞

⎜

⎝

⎛

−

=

=

−

+

−

=

−

=

−

∑

∑

∑

∑

∑

∑

=

=

=

=

=

=

μ

μ

43

2

. Metoda najmniejszych kwadratów Gaussa

Niech X

1

, X

2

,.....,X

n

będzie ciągiem obserwowanych w próbie

zmiennych losowych, których rozkład zależy od parametrów

Θ

1

,

Θ

2

,....,

Θ

k

. Niech h(

Θ

1

,

Θ

2,

......,

Θ

k

) będzie liniową funkcją

parametrów

Θ

1

,

Θ

2

,.......,

Θ

k

; x

1

,x

2

,.....,x

n

obserwacje zmiennych

losowych X

1

,X

2

,....,X

n

.

Metoda najmniejszych kwadratów polega na

dobraniu takich ocen

ϑ

j

parametrów

Θ

j

, by spełniony był warunek:

(

)

[

]

min

,......,

,

2

1

2

1

=

Θ

Θ

Θ

−

=

∑

=

n

j

k

j

h

X

ψ

Stosowana wtedy, gdy h jest liniową funkcję względem

poszczególnych parametrów i wówczas

i

Θ

∂

∂

ψ

są pewnymi stałymi

niezależnymi od

Θ

i

. Z otrzymanych układów równań znajdujemy

wzory na odpowiednie estymatory.

3

. Metoda największej wiarygodności Fishera

Metoda ta polega na realizacji zdarzenia (doświadczenia)

o największym prawdopodobieństwie.

W tym celu wprowadzamy pojęcie wiarygodności próby.

Definicja

Niech X

1

, X

2

,....,X

n

będzie ciągiem obserwacji pobranych do

próby z populacji w której zmienna losowa X ma dystrybuantę F(x)

zależną od k nieznanych parametrów

Θ

1

,

Θ

2

,.....,

Θ

k

, które należy

oszacować za pomocą próby.

Zakładamy: n

>

k . Zmienna X może być ciągła lub dyskretna.

44

Jeżeli zmienna losowa X jest ciągła, to rozkład opisujemy gęstością

prawdopodobieństwa f(x;

Θ

1

,

Θ

2

,......,

Θ

k

), a jeżeli skokowa to

funkcją prawdopodobieństwa P(X=x;

Θ

1

,

Θ

2

,....,

Θ

k

).

Wyrażenie

)

∏

=

Θ

Θ

Θ

=

n

i

k

i

x

f

L

1

2

1

,.....,

,

;

(

dla zmiennej ciągłej

lub

(

)

∏

=

Θ

Θ

Θ

=

=

n

i

k

i

x

X

P

L

1

2

1

,......,

,

;

dla zmiennej skokowej

nazywamy wiarygodnością próby.

Jeżeli funkcja L jest dwukrotnie różniczkowalna, to poszukiwanie

ocen czyli estymatorów można przeprowadzić za pomocą rachunku

różniczkowego. Najlepiej szukać max dla ln L, ponieważ dla L

>0

L i lnL mają ekstremum w tym samym punkcie, czyli

0

ln

=

Θ

∂

∂

i

L

WŁASNOŚCI ESTYMATORÓW

Estymatory muszą spełniać trzy podstawowe warunki:

1. muszą być nieobciążone

2. zgodne

3. efektywne

45

ad.1

Estymator T

n

parametru

Θ

nazywamy nieobciążonym, jeżeli

spełniona jest równość:

E(T

n

) =

Θ

.

Różnicę

B

n

= E(T

n

) –

Θ

nazywamy obciążeniem estymatora.

Jeżeli

0

lim

=

∞

→

n

n

B

to estymator nazywamy asymptotycznie nieobciążonym.

ad.2

Estymator nazywamy zgodnym, jeżeli spełniona jest relacja

(

)

1

lim

=

〈

Θ

−

∞

→

ε

n

n

T

P

,

dla dowolnie małej wartości dodatniej

ε

.

Tak więc, zgodność estymatora badamy korzystając z dwóch

warunków:

a)

( )

0

lim

2

=

∞

→

n

n

T

D

b) estymator jest nieobciążony lub jego obciążenie B

n

spełnia

warunek

0

lim

=

∞

→

n

n

B

46

ad.3

Efektywność

estymatora

i

n

T

będącego i-tym estymatorem tego

samego parametru populacji

Θ

, mierzymy miernikiem efektywności

( )

( )

i

n

n

i

T

D

T

D

W

2

2

∗

=

,

gdzie

∗

n

T

jest estymatorem o największej efektywności,

0

< W ≤ 1.

Pierwiastek kwadratowy z wariancji estymatora nieobciążonego

nazywamy błędem średnim szacunku.

W przypadku estymowania jednego parametru, wariancja dowolnego

nieobciążonego estymatora spełnia następującą nierówność, zwaną

nierównością Rao – Cramera.

( )

(

)

⎪⎭

⎪

⎬

⎫

⎪⎩

⎪

⎨

⎧

⎥⎦

⎤

⎢⎣

⎡

Θ

Θ

∂

∂

≥

2

2

;

ln

1

X

f

nE

T

D

n

Nierówność jest spełniona dla wszystkich rozkładów

prawdopodobieństwa oprócz rozkładu jednostajnego.

ESTYMACJA PRZEDZIAŁOWA

Polega na budowaniu przedziałów ufności zwanych przedziałami

Neymana.

47

Przedział liczbowy [ T

n

(1)

, T

n

(2)

] spełniający dwa warunki:

1. końce przedziału, czyli wielkości T

n

(1)

i T

n

(2)

zależą od wyników

próby i nie zależą w sposób funkcyjny od

Θ

,

2. prawdopodobieństwo tego, że nieznana wartość

Θ

należy do tego

przedziału równe jest z góry określonej liczbie 1 –

α

>0;

nazywać będziemy przedziałem ufności dla parametru

Θ

.

1 –

α

nazywamy współczynnikiem ufności.

PRZEDZIAŁY UFNOŚCI DLA WARTOŚCI OCZEKIWANEJ

Przyjmujemy dwa założenia .

1. Zmienna losowa X ma rozkład normalny N(m,

σ

), taki że średnia

z próby ma rozkład

⎟⎟

⎠

⎞

⎜⎜

⎝

⎛

n

m

N

σ

,

przy dowolnej wielkości próby.

2. Zmienna losowa X ma rozkład różny od normalnego, ale próba jest

na tyle duża, że można przyjąć, że średnia z próby ma w przybliżeniu

rozkład

⎟⎟

⎠

⎞

⎜⎜

⎝

⎛

n

m

N

σ

,

.

Jeżeli spełnione jest jedno z tych założeń, to wówczas zmienna

losowa

n

m

X

σ

−

ma rozkład N(0,1).

A.

Znana wariancja

Zgodnie z powyższym, możemy znaleźć taki kwantyl ( wartość

krytyczną) u

α

, że

α

σ

α

α

−

=

⎭

⎬

⎫

⎩

⎨

⎧

〈

−

〈

−

1

u

n

m

X

u

P

48

Po przekształceniach

α

σ

σ

α

α

−

=

⎭

⎬

⎫

⎩

⎨

⎧

+

〈

〈

−

1

n

u

X

m

n

u

X

P

Przedział ten budujemy dla dowolnej liczebności n próby.

B

. Wariancja nieznana

1. Jeżeli liczebność n próby jest duża (n

≥30),

σ

przybliżamy S

i wówczas

α

α

α

−

=

⎭

⎬

⎫

⎩

⎨

⎧

+

〈

〈

−

1

n

S

u

X

m

n

S

u

X

P

Wartości kwantyli u

α

zwane również wartościami krytycznymi

odczytujemy ze stabelaryzowanych wartości dystrybuanty

Φ

(u

α

) =1 –

α

\2 i

Φ

(-u

α

) =

α

\2.

2. Liczebność n próby jest mała (n

< 30), wówczas przedział ufności

budujemy w oparciu o rozkład t-Studenta, gdzie zmienna losowa

1

−

−

=

n

S

m

X

t

ma rozkład t-Studenta o n – 1 stopniach swobody,

czyli możemy znaleźć taki kwantyl t

α

,, że

{

}

α

α

α

−

=

〈

〈

−

1

t

t

t

P

Stąd po podstawieniu mamy

α

α

α

−

=

⎭

⎬

⎫

⎩

⎨

⎧

−

+

〈

〈

−

−

1

1

1

n

S

t

X

m

n

S

t

X

P

,

przy czym

49

x

S

n

S

n

S

∧

∧

=

=

−1

Wartość krytyczną t

α

odczytujemy z rozkładu t-Studenta dla

określonej wartości

α

i k = n – 1 stopni swobody. Z tych tablic

można również odczytać u

α

, dla określonego

α

i k

→∞.

Szerokość przedziału możemy ustalać za pomocą wartości

współczynnika ufności lub liczebności próby. Ustalanie za pomocą

liczebności próby przeprowadza się według dwuetapowej

procedury Steina.

Δ

=

−1

n

S

t

α

Δ- ustalona dokładność (połowa

szerokości przedziału)

n

S

n

S

2

2

1

∧

=

−

Stąd niezbędną liczbę n obserwacji, by szerokość budowanego

przedziału wynosiła 2

Δ, obliczamy z zależności:

2

2

0

2

Δ

⋅

=

∧

S

t

n

α

gdzie

(

)

∑

=

∧

−

−

=

0

1

2

0

2

0

1

1

n

i

i

X

X

n

S

,

n

0

– liczebność próby wstępnej.

PRZEDZIAŁ UFNOŚCI DLA WARIANCJI

Zakładamy , że zmienna losowa X ma rozkład normalny N(m,

σ

),

nie znamy m. Próba jest mała. Przedział ufności budujemy w oparciu

o rozkład chi-kwadrat, ponieważ zmienna losowa

2

2

σ

nS

ma rozkład

chi-kwadrat o n – 1 stopniach swobody.

Oznacza to, że możemy znaleźć takie dwa kwantyle

2

1

χ

i

2

2

χ , że

50

α

χ

σ

χ

−

=

⎭

⎬

⎫

⎩

⎨

⎧

〈

〈

1

2

2

2

2

2

1

nS

P

Wartość krytyczną

2

1

χ odczytujemy z rozkładu chi-kwadrat dla

1–

α

\2 i k = n – 1 stopni swobody

( )

2

1

2

1

2

2

α

χ

χ

χ

−

=

∫

∞

d

f

, natomiast

2

2

χ dla

α

\2 i k = n – 1 stopni swobody

( )

⎟

⎟

⎠

⎞

⎜

⎜

⎝

⎛

=

∫

∞

2

2

2

2

2

α

χ

χ

χ

d

f

Po przekształceniach otrzymujemy:

α

χ

σ

χ

−

=

⎭

⎬

⎫

⎩

⎨

⎧

〈

〈

1

2

1

2

2

2

2

2

nS

nS

P

.

Dla odchylenia standardowego przedział budujemy następująco:

α

χ

σ

χ

−

=

⎪⎭

⎪

⎬

⎫

⎪⎩

⎪

⎨

⎧

〈

〈

1

2

1

2

2

2

2

nS

nS

P

Jeżeli jest znana wartość m, to zamiast

2

S

wstawiamy

2

∗

S

, a ilość

stopni swobody k = n .

WERYFIKACJA HIPOTEZ STATYSTYCZNYCH

Jest to typ wnioskowania statystycznego polegający na wyrokowaniu

o słuszności lub fałszu pewnych wysuniętych przypuszczeń

dotyczących rozkładu prawdopodobieństwa obserwowanej zmiennej

losowej lub co do wartości określonych parametrów rozkładu.

51

Definicja

Hipotezą statystyczną będziemy nazywać każdy sąd o populacji

generalnej, tj. o rozkładzie prawdopodobieństwa zmiennej losowej X

lub o parametrach rozkładu, o którego prawdziwości lub fałszu można

wnioskować na podstawie losowo pobranej próby, będącej realizacją

tej zmiennej losowej.

Hipotezy dzielimy na parametryczne i nieparametryczne.

Parametryczne

dotyczą parametrów rozkładu.

Nieparametryczne

dotyczą funkcji rozkładu prawdopodobieństwa

badanej zmiennej losowej, losowości próby.