ROZDZIAŁ 10

ANALIZA WARIANCJI

I. Wprowadzenie

W rozdziale ósmym omawialiśmy testy istotności dla hipotezy, że dwie populacje

o rozkładach normalnych mają jednakowe wartości średnie. Co jednak zrobić, gdy średnich

(grup porównywalnych) jest więcej? Możemy się spotkać z następującym problemem.

Przykład 1 (Armitage [2])

Badano czterema różnymi metodami czas krzepnięcia osocza krwi dziesięciu losowo

wybranym pacjentom. Otrzymano następujące wyniki:

Metoda 1

Metoda 2

Metoda 3

Metoda 4

9,1

10

10

10,9

8,9

10,2

9,9

11,1

8,4

9,8

9,8

12,2

12,8

11,6

12,9

14,4

8,7

9,5

11,2

9,8

9,2

9,2

9,9

12

7,6

8,6

8,5

8,5

8,6

10,3

9,8

10,9

8,9

9,4

9,2

10,4

7,9

8,5

8,2

10

Chcemy porównać średnie czasy krzepnięcia dla każdej metody.

Wydawałoby się, że wystarczy przeprowadzić test t-Studenta dla każdej pary. Nie

możemy jednak tak postąpić. Przy poziomie istotności 0,05 prawdopodobieństwo, że się

nie pomylimy, dla jednego porównania wynosi 0,95, a dla dwóch porównań 0,95

2

= 0,905.

Dla czterech grup mamy sześć porównań, a wówczas wartość ta wynosi 0,95

6

= 0,7351.

Prawdopodobieństwo, że pomylimy się co najmniej raz, wynosi teraz 1- 0,7351 = 0,265,

a na tak duży błąd pierwszego rodzaju zgodzić się nie możemy. Do analizy takich

problemów wykorzystujemy zespół metod statystycznych zwanych analizą wariancji.

Powstanie i rozwój analizy wariancjizawdzięczamy angielskiemu biologowi

R. A. Fisherowi (1925 r.), który rozwinął ją dla rozwiązania problemów doświadczalnictwa

rolniczego. Testy analizy wariancji są do dziś podstawowym narzędziem tzw. statystyki

eksperymentalnej. Są to rozwinięte dla potrzeb doświadczalnictwa przyrodniczego metody

oceny wpływów pewnych kontrolowanych czynników na wynik eksperymentu. Można

powiedzieć, że analiza wariancji jest podstawową metodą statystyczną, wobec której inne

metody są jedynie jej modyfikacjami.

177

Przystępny kurs statystyki

178

W praktyce występują najczęściej dwa najprostsze schematy analizy wariancji:

• analiza wariancji dla klasyfikacji pojedynczej,

• wieloczynnikowa analiza wariancji.

W tym rozdziale przedstawimy analizę wariancji (ANOVA) dla klasyfikacji pojedynczej,

w której bada się wpływ tylko jednego czynnika klasyfikującego (kontrolowanego na wielu

poziomach) na wyniki przeprowadzanego badania. Rozpoczniemy od przedstawienia

podstawowych założeń:

1. Analizowana zmienna jest mierzalna

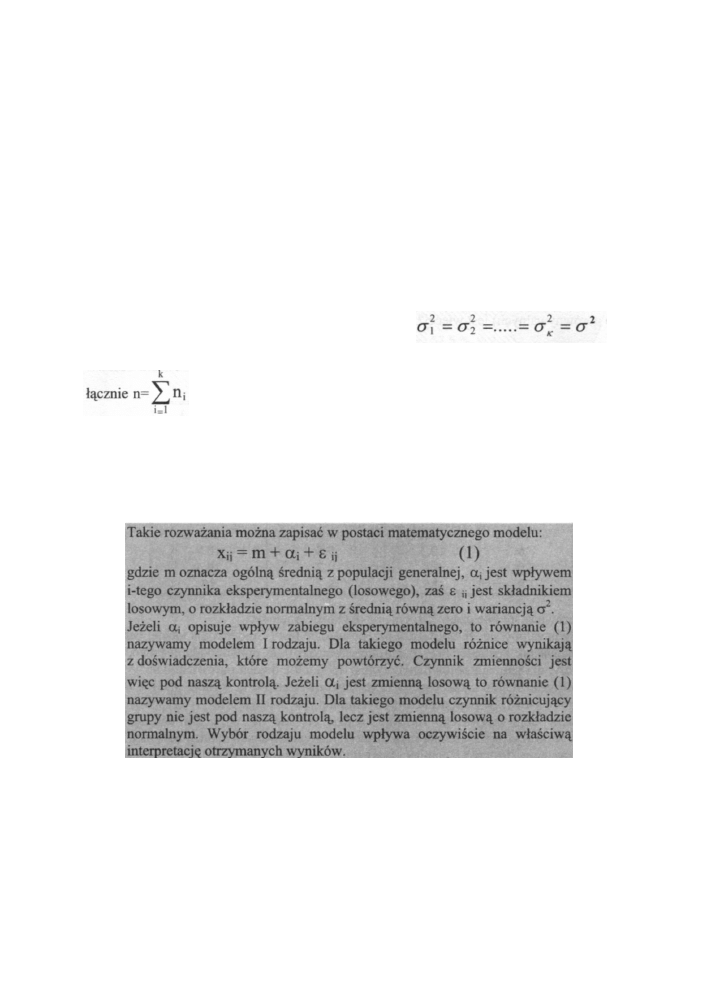

2. Rozważanych k niezależnych populacji ma rozkłady normalne N(m

i

, σ

i

)

i = 1,2,..., k

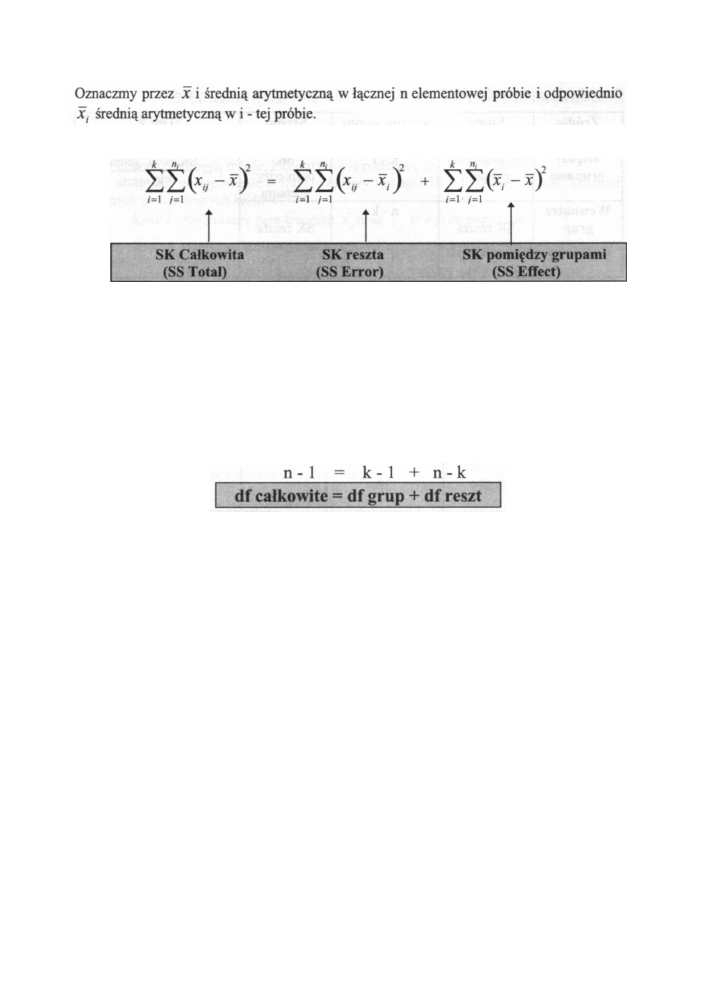

Podstawą analizy wariancji jest możliwość rozbicia sumy kwadratów wariancji całkowitej

dla wszystkich wyników obserwacji na dwa składniki:

* sumę kwadratów opisującą zmienność wewnątrz prób,

* sumę kwadratów opisującą zmienność między grupami (populacjami).

3. Rozkłady te mają jednakową wariancję,

Z każdej z tych populacji wylosowano próbę o liczebności n

i

elementów. Otrzymujemy

niezależnych obserwacji xij dla j = 1, 2, ...n

i

. Dane te stanowią podstawę

do weryfikacji hipotezy, że średnie w grupach są jednakowe:

Ho: m

1

= m

2

= ....m

k

wobec hipotezy alternatywnej:

H

1

: co najmniej dwie średnie różnią się między sobą

Analiza wariancji

Wówczas omawiane rozbicie przyjmuje postać:

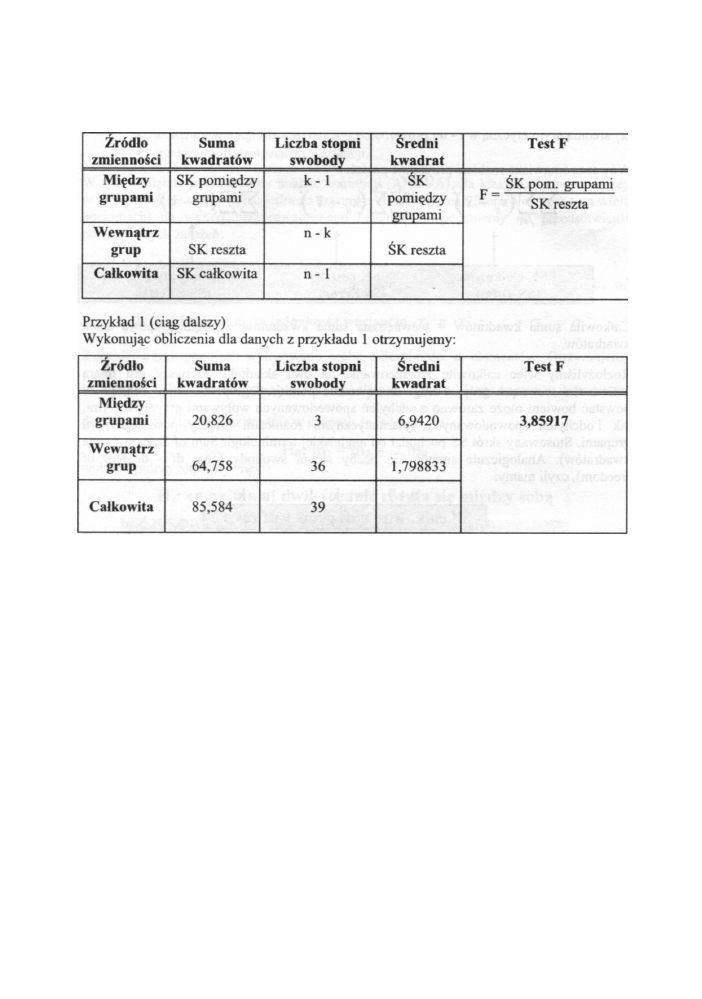

Następnym etapem obliczeń są tzw. średnie kwadraty odchyleń (oznaczane skrótem MS od

angielskiego Mean sąuares). Obliczamy je następująco:

ŚK pom. grupami (MS Effect) = SS pom. grupami /df grup = SS pom. grupami/(k - 1)

ŚK reszt. (MS Error) = SS Reszty/df reszt = SS reszt./n-k

Przy założeniu hipotezy zerowej zarówno średni kwadrat odchyleń międzygrupowych (ŚK

pom. grupami), jak i średni kwadrat odchyleń wewnątrzgrupowych (ŚK reszt.) są nie

obciążonymi estymatorami wariancji. Oszacowanie wariancji powyższymi estymatorami

powinno się więc różnić w granicach losowych odchyleń. Jeżeli hipoteza zerowa nie jest

prawdziwa, to wówczas średni kwadrat między grupami (ŚK pom. grupami) rośnie i jest

wyższy od średniego kwadratu odchyleń wewnątrzgrupowych. Hipotezę zerową należałoby

wtedy odrzucić. Do porównywania ŚK pom. grupami i ŚK reszt, używamy statystyki

F (Fishera-Snedocora) ok-1 i n-k stopniach swobody. Statystyka ta jest podstawą

wyznaczania obszaru krytycznego dla naszej hipotezy zerowej o równości wszystkich

średnich. Wartości F bliskie jedności „świadczą za" sprawdzaną hipotezą, natomiast

wartości dużo większe od 1 przemawiają za jej odrzuceniem. Wszystko oczywiście zależy

od przyjętego przez nas poziomu istotności.

179

Całkowita suma kwadratów = wewnętrzna suma kwadratów + międzygrupowa suma

kwadratów

Rozłożyliśmy więc całkowite zróżnicowanie na dwa składniki. Pierwszy jest miarą

zmienności wewnątrz grup, a drugi miarą różnic pomiędzy grupami. Suma kwadratów

powstać bowiem może zarówno z odchyleń spowodowanych wpływami przypadkowymi,

jak i odchyleń spowodowanych systematycznymi różnicami między poszczególnymi

grupami. Stosowany skrót SS pochodzi od angielskiej terminologii Sum of Sąuares (suma

kwadratów). Analogicznie sumują się liczby stopni swobody (ang. df - degrees of

freedom), czyli mamy:

Przystępny kurs statystyki

Przyjęło się zapisywać wyniki analizy wariancji w postaci następującej tabeli:

Przyjmijmy poziom istotności α = 0,05, wówczas wartość krytyczna wynosi F

α, 3, 36

=

2,866.

Ponieważ F

obliczone=

3,85917 > F

α, 3, 36

= 2,866,

więc hipotezę zerową o równości

wszystkich średnich odrzucamy.

Jeżeli analiza wariancji nie pokaże istotności różnic między rozpatrywanymi, nie

przeprowadza się już dalszych testów. Natomiast kiedy hipoteza zerowa zostanie

odrzucona w analizie wariancji, to powstaje pytanie, które z porównywanych populacji są

odpowiedzialne za odrzucenie hipotezy zerowej. Chcemy wiedzieć, które z n średnich

różnią się między sobą, a które są równe. Musimy wtedy koniecznie przeprowadzić

dokładniejsze badania różnic między średnimi z poszczególnych grup. Wykorzystujemy do

tego celu specjalne testy post-hoc zwane też testami wielokrotnych porównań. Jest ich cała

gama. Można wyróżnić trzy grupy:

• Analiza kontrastów i związane z nią testy (test Scheffego)

• Testy oparte na studentyzowanym rozstępie umożliwiające grupowanie

średnich (testy Tukeya, Duncana, Newmana-Keulsa)

• Wnioskowanie na podstawie przedziałów ufności (test Scheffego,

Benferroniego oraz test Dunneta)

Dokładniejsze omówienie powyższych testów nastąpi później w tym rozdziale przy

omawianiu ich możliwości w pakiecie STATISTICA. Obecnie dla przykładu przedstawimy

180

Analiza wariancji

jak liczy się „na piechotę" tylko dwa z nich - test Duncana i test NIR (najmniejszych

istotnych różnic).

Zaczniemy od historycznie najwcześniej sformułowanego problemu przez samego

twórcę analizy wariancji A. Fishera w 1949 roku. Podstawą jego jest wyznaczenie tzw.

najmniejszych istotnych różnic, które stanowią podstawę dalszych porównań.

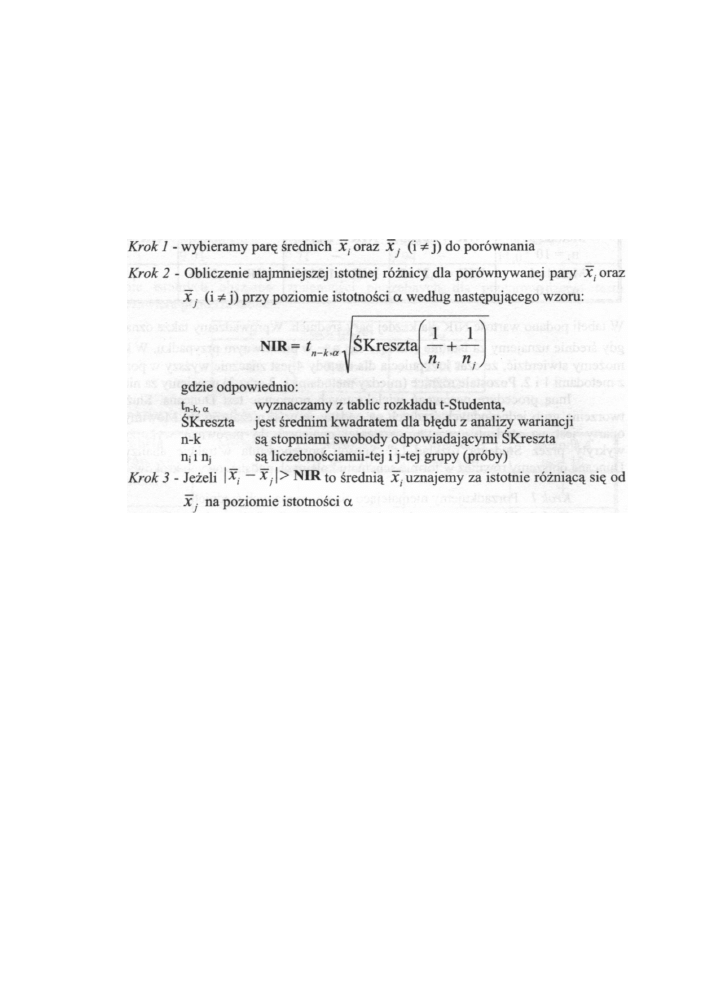

Sposób postępowanie w trakcie analizy testem NIR opiszemy w formie schematu

kolejnych podstawowych kroków:

Rozważania teoretyczne zilustrujemy konkretnym przykładem.

Przykład 1 (ciąg dalszy):

Wykorzystując wyniki analizy wariancji dla danych z przykładu 1 (gdzie odrzuciliśmy

hipotezę zerową), przeprowadzimy dokładniejsze badania różnic między średnimi

z poszczególnych grup przy pomocy testu NIR (najmniejszych istotnych różnic).

Zaczniemy od uporządkowania, niemalejąco, otrzymanych średnich:

Metoda 1 Metoda 2 Metoda 3 Metoda 4

9,01 9,71 9,94 11,02

Przyjmujemy założenie, że poziom istotności α = 0,05. Otrzymane wyniki obliczeń

zestawiono w poniższej tabeli:

181

Przystępny kurs statystyki

W tabeli podano wartość NIR dla każdej pary średnich. Wprowadzamy także oznaczenia +

gdy średnie uznajemy za istotnie różniące się, a — w przeciwnym przypadku. W konkluzji

możemy stwierdzić, że czas krzepnięcia dla metody 4 jest znacznie wyższy w porównaniu

z metodami 1 i 2. Pozostałe różnice (między metodami 1, 2 oraz 3) uznajemy za nieistotne.

Inną procedurę porównań wielokrotnych proponuje test Duncana. Służy on do

tworzenia grup jednorodnych średnich na podstawie prób niezależnych. Mówimy, że test

oparty jest na studentyzowanym rozstępie, ponieważ do porównań wykorzystujemy

wykryty przez Studenta rozkład „t" Sposób postępowania w trakcie analizy testem

Duncana opiszemy również w formie schematu kolejnych podstawowych kroków:

Krok 1

Porządkujemy niemalejąco ciąg otrzymanych średnich.

Krok 2

Wybieramy parę średnich X

(

oraz X. (i * j ) do porównania.

Krok 3

Odczytujemy z tablic Studentyzowany rozstęp zmienności q

a

(p,n-k).

Zależy on nie tylko od poziomu istotności a, ale też od stopni swobody n-

k dla średniego kwadratu odchyleń wewnątrzgrupowych (ŚK reszt.) oraz

od liczby p wyrażającej ilość wartości średnich zawartych w jednym

szeregu pomiędzy porównywanymi średnimi. Przykładowo dla ciągu

średnich xi < x

2

< x

3

< x, p = 4 dla porównania między x, i xi a p = 3 dla

porównań między x

3

i x,.

Krok 4

Wyliczamy tzw. istotny obszar zmienności

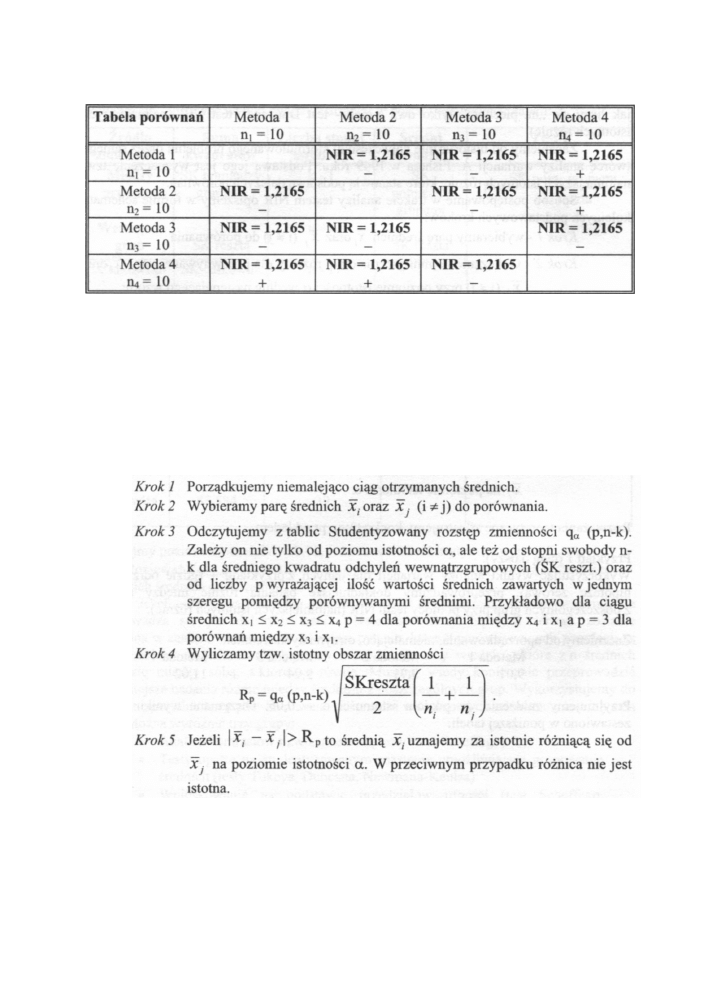

Prześledzimy kolejne kroki testu Duncana dla danych z przykładu 1.

182

Analiza wariancji

Przykład 1 (ciąg dalszy)

Wykorzystując wyniki analizy wariancji dla danych z przykładu 1 (gdzie odrzuciliśmy

hipotezę zerową) przeprowadzimy dokładniejsze badania różnic między średnimi

z poszczególnych grup tym razem przy pomocy testu Duncana. Przyjmujemy założenie, że

poziom istotności α = 0,05.

Przypomnijmy

niemalejące uporządkowanie otrzymanych średnich:

Metoda 1 Metoda 2 Metoda 3 Metoda 4

9,01 9,71 9,94 11,02

Wyliczenie istotnych obszarów zmienności potrzebnych dla przeprowadzenia testu

Duncana zawiera poniższa tablica:

p

Qo.05 (P,36)

Ra

4

3,112

1,31988

3

3,016

1,27917

2

2,865

1,21512

Otrzymane decyzje z wyników obliczeń zestawiono w poniższej tabeli:

Tabela

porównań

Metoda 1

n

1

= 10

Metoda 2

n

2

= 10

Metoda 3

n

3

= 10

Metoda 4

I Ł t = 10

Metoda 1

—

—

+

Metoda 2

—

+

Metoda 3

—

—

—

Metoda 4

+

+

—

W tabeli wprowadzamy oznaczenia +, gdy średnie uznajemy za istotnie różniące się, a —

w przeciwnym przypadku. W konkluzji możemy stwierdzić, że (podobnie jak dla analizy

testem NIR) czas krzepnięcia dla metody 4 jest znacznie wyższy w porównaniu

z metodami 1 i 2. Pozostałe różnice (między metodami 1, 2 oraz 3) uznajemy za nieistotne.

II. A jak to się liczy w programie STATISTICA

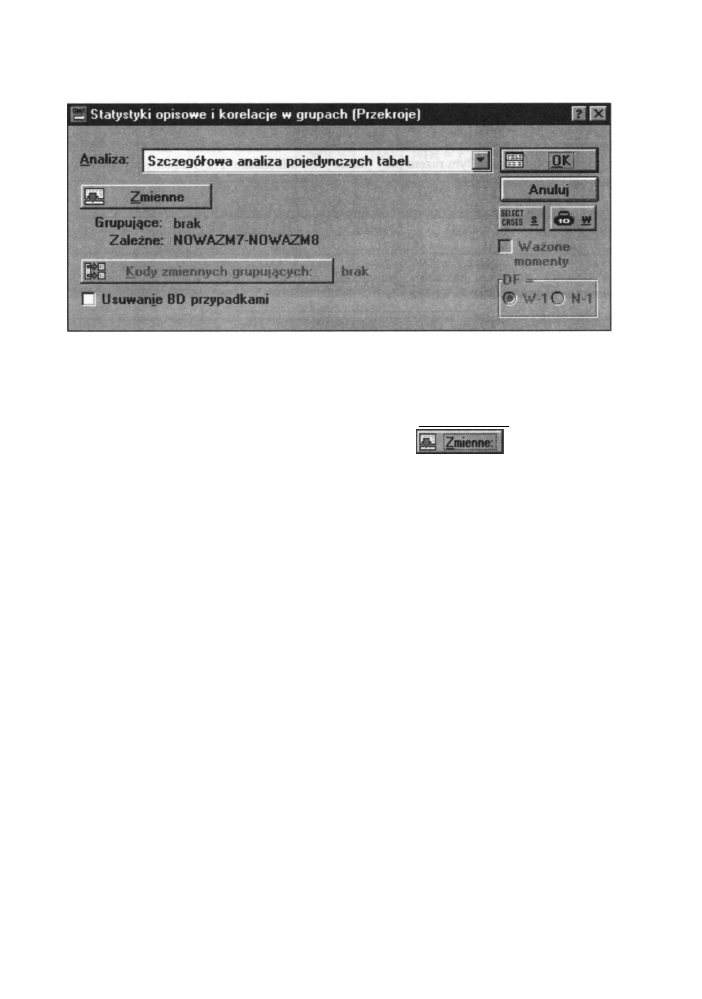

W programie STATISTICA do przeprowadzenia jednoczynnikowej analizy wariancji służy

opcja Przekroje, prosta ANOVA w module Podstawowe statystyki i tabele. Po

wybraniu tej opcji i naciśnięciu OK (lub po dwukrotnym kliknięciu na nazwie opcji)

otwiera się okno Statystyki opisowe i korelacje w grupach-Przekroje przedstawione

poniżej.

183

Przystępny kurs statystyki

Rys. 10.1 Okno Statystyki opisowe i korelacje w grupach - Przekroje

W oknie tym wybieramy przede wszystkim zmienne do analizy. Dane musimy mieć

wpisane przypadek za przypadkiem. Wówczas każdy wiersz w zbiorze danych przedstawia

jedną obserwację (osobę), a każda kolumna reprezentuje jedną badaną zmienną. Następnie

w jednej kolumnie należy wprowadzić kody (wartości zmiennej grupującej) określające

otwiera się okno

grupy, które chcemy porównać. Po kliknięciu przycisku

wyboru dwóch list zmiennych - zmiennej grupującej (maksymalnie sześć zmiennych) oraz

listę zmiennych zależnych. Dokładny opis pracy w tym oknie omówiony został w rozdziale

3.

Przycisk Kody zmiennych grupujących wywołuje okno wyboru kodów. Przy

jego pomocy możemy dokonać wyboru kodów używanych jako wartości zmiennych

grupujących (decydują one o przynależności grupowej każdego przypadku). Kiedy naciśnie

się OK bez dokonania jakiegokolwiek wyboru, to STATISTICA automatycznie wybierze

wszystkie dostępne wartości całkowite jako kody. Jeżeli nie pamiętamy kodów

grupujących, należy kliknąć przycisk Podgląd. Otworzy się wówczas okno zawierające

wszystkie kody liczbowe.

Poniżej omawianego przycisku znajduje się pole wyboru opcji Usuwanie BD

przypadkami. Jeżeli ta opcja jest włączona, to z analizy zostaną usunięte wszystkie

przypadki, w których brakuje danych dla jakiejkolwiek zmiennej zależnej (usuwanie

braków danych przypadkami). W przeciwnym przypadku dane będą usuwane jedynie

wtedy, gdy danych brakuje dla zmiennej aktualnie przeznaczonej do obliczeń. Możemy

mieć wtedy różną liczbę przypadków dla różnych zmiennych.

O sposobie przeprowadzenia analizy decyduje wybór dokonany na liście Analiza,

znajdującej się na samej górze omawianego okna. Do wyboru mamy dwie możliwości:

• Szczegółowa analiza pojedynczych tabel

Opcja ta umożliwia wybór różnych opcji analizy, wykresów i statystyk opisowych

z podziałem na grupy. Użytkownik decyduje zarówno o wyborze zmiennych, jak

i o metodzie analizy i rodzaju wykresu.

184

Analiza wariancji

• Przetwarzanie wsadowe (i wydruk) listy tabel

Opcja ta pozwala na obliczanie dużej liczby tabel w trybie wsadowym bez

konieczności naszego w tym udziału. Wyliczane są i drukowane bez udziału

użytkownika najczęściej stosowane obliczenia i analizy oraz wykresy.

W dalszym ciągu prześledzimy analizy statystyczne przy założeniu wyboru pierwszej

z omawianych opcji.

Po wyborze zmiennych i kodów klikamy przycisk OK dla kontynuacji analizy.

Otworzymy wówczas pośrednie okno Statystyki opisowe i korelacje w grupach - wyniki

umożliwiające wybór obliczanych statystyk i wykresów. Okno to wraz z zaznaczonymi

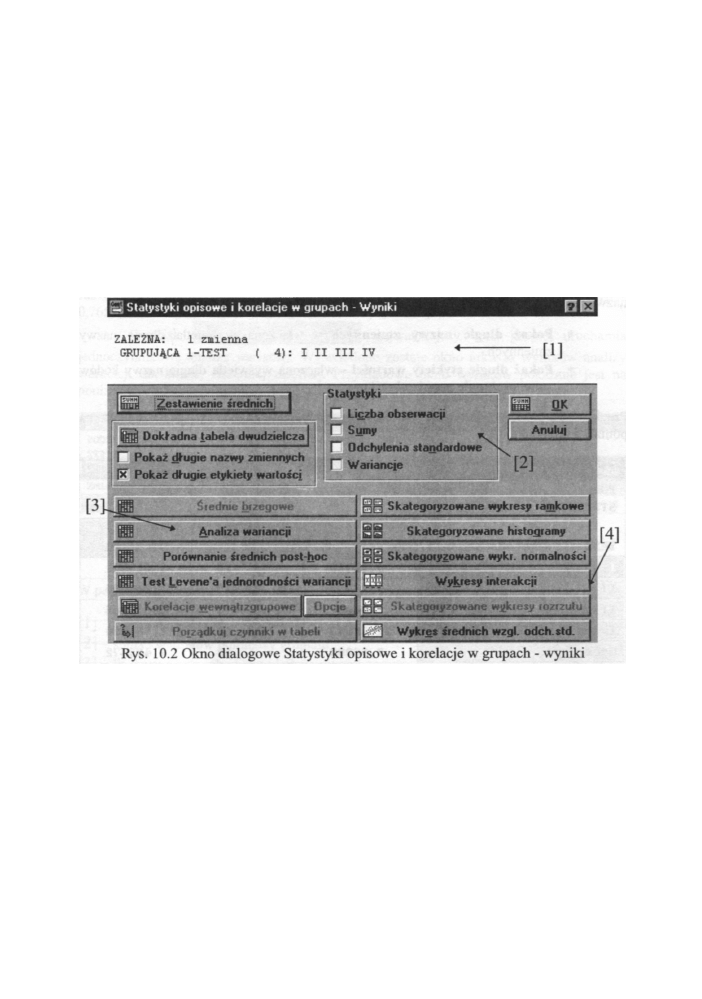

najważniejszymi grupami opcji widoczne jest na poniższym rysunku.

Rys. 10.2 Okno dialogowe Statystyki opisowe i korelacje w grupach - wyniki

W tym wstępnym oknie możemy:

• Jeszcze raz sprawdzić, jakie wybraliśmy zmienne do analizy i kody zmiennej

grupującej - pole [1].

• Przeprowadzić wstępną analizę opisową (zestawienie sum, średnich, wariancji

itd...) - pole opcji [2].

• Przeprowadzić analizę wariancji i testy po fakcie (post-hoc) oraz inne

potrzebne testy - przyciski w polu [3].

• Zinterpretować graficznie otrzymane wyniki - [4].

Obecnie opiszemy bliżej omawiane pola [2] - [3].

185

Przystępny kurs statystyki

[2] - Statystyki opisowe

Umieszczony w tym polu przycisk Zestawienie średnich wyświetla sumaryczną tabelę

podstawowych statystyk opisowych dla każdej grupy. Jakie statystyki zostaną obliczone,

zależy od wyboru dokonanego w polu Statystyki. Możemy wybrać : liczbę obserwacji,

sumy, wariancje oraz odchylenia standardowe.

Przycisk Dokładna tabela dwudzielcza wywoła kaskadę arkuszy wyników

z tabelami dwudzielczymi. Jeśli wybraliśmy jedną lub dwie zmienne, wówczas

wyświetlony zostanie pojedynczy arkusz wyników. W arkuszu tym oprócz wybranych

statystyk opisowych wyświetlane też są sumaryczne statystyki brzegowe (statystyki dla

każdego czynnika z pominięciem pozostałych). W tabelach możemy też wyświetlić długie

nazwy zmiennych i długie nazwy wartości. Umożliwiają to opcje:

* Pokaż długie nazwy zmiennych - włączona wyświetla długie nazwy

zmiennych.

* Pokaż długie etykiety wartości - włączona wyświetla długie nazwy kodów

zmiennych o ile zostały określone.

Przykładowa tabela dwudzielcza dla danych z przykładu pierwszego widoczna jest na

poniższym rysunku.

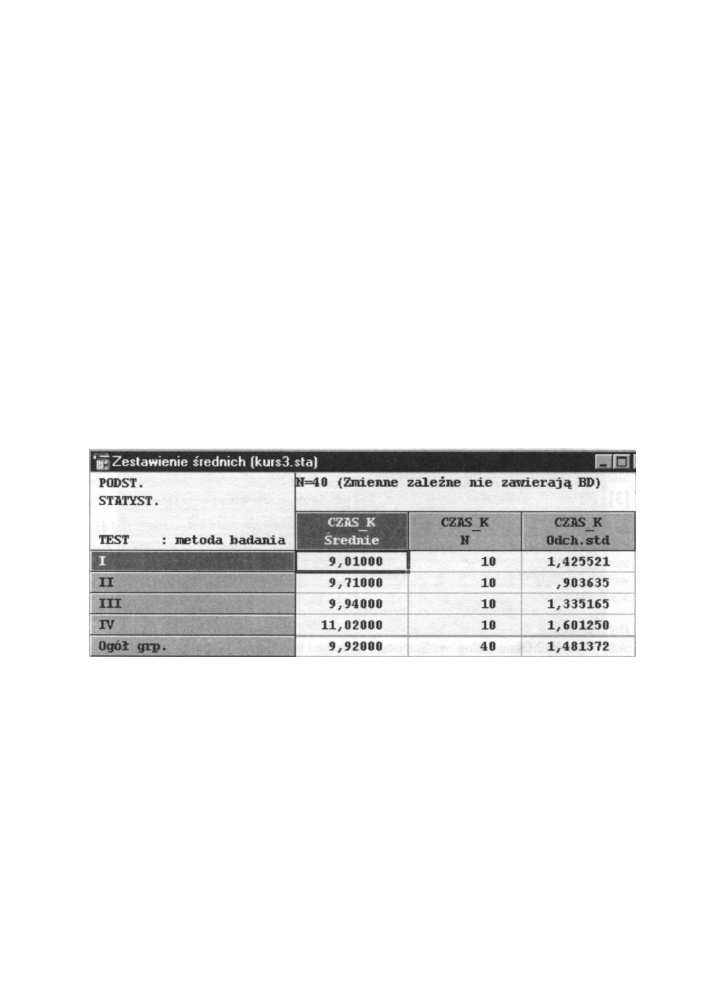

Rys. 10.3 Arkusz wyników z zestawieniem średnich

[3] - Testy analizy wariancji

W tej grupie znajdują się najważniejsze przyciski umożliwiające przeprowadzenie analizy

wariancji i przeprowadzenie testów po fakcie. Omówimy je wszystkie po kolei.

Zaczniemy od przycisku Test Levene'a jednorodności wariancji. Testy analizy

wariancji wymagają założenia, że wariancje w różnych grupach są jednorodne (takie

same). Najmocniejszym testem do sprawdzenia tego założenia jest test Levene'a.

Kliknięcie tego przycisku uruchamia przeprowadzenie testu Levene'a dla wybranych

zmiennych. Jeżeli test Levene'a okaże się istotny, wówczas odrzucamy hipotezę

o jednorodności wariancji.

186

Analiza wariancji

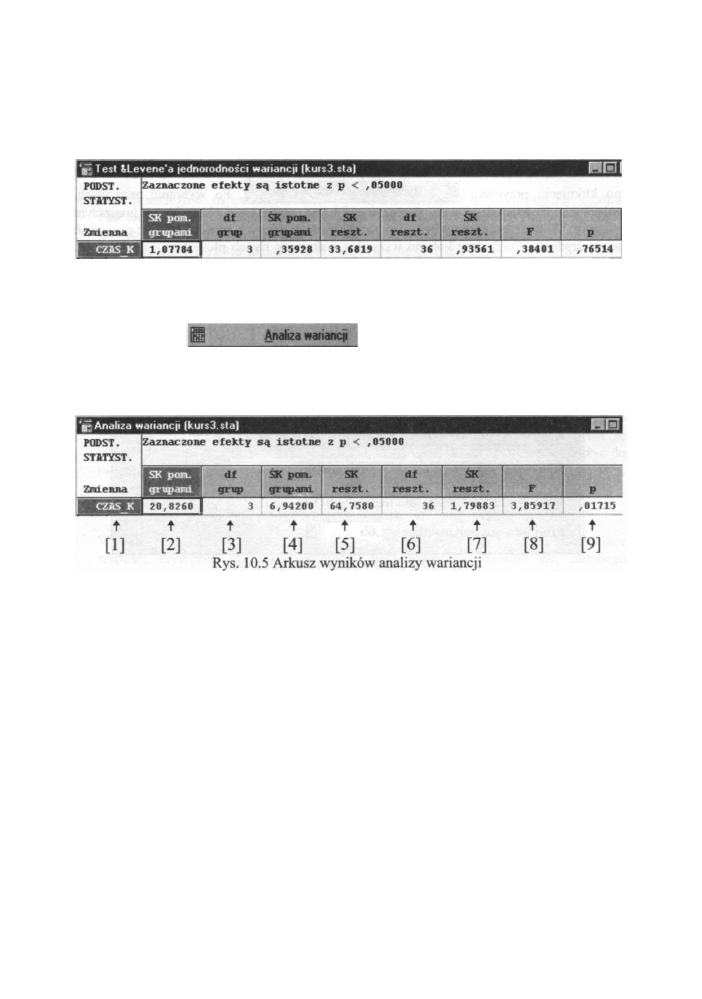

Przykładowe okno wyników test Levene'a dla danych z przykładu 1 pokazane jest na

poniższym rysunku.

Rys. 10.4 Okno z wynikami testu Levene'a

Jak widać, nie mamy podstaw do odrzucenia hipotezy zerowej o równości wariancji (p =

0,7651). Możemy spokojnie przystąpić do analizy wariancji.

187

Przycisk

najważniejszy w tej grupie, uruchamia

jednoczynnikową analizę wariancji. Wyświetlone zostaje okno arkusza wyników analizy

wariancji dla każdej zmiennej zależnej. Przykładowe okno wyników pokazane jest na

poniższym rysunku.

W powyższym oknie wyników mamy następujące wartości liczbowe:

[1] - nazwa zmiennej zależnej

[2] - suma kwadratów pomiędzy grupami

[3] - liczba stopni swobody pomiędzy grupami

[4] - średnie kwadraty pomiędzy grupami

[5] - suma kwadratów wewnątrzgrupowa (resztowa)

[6] - liczba stopni swobody wewnątrz grup (resztowa)

[7] - średnia suma kwadratów wewnątrz grup

[8] - wartość testu F

[9] - poziom prawdopodobieństwa p

Hipotezę zerową odrzucamy, gdy p < 0,05 lub wartości mniejszej.

Jeżeli analiza wariancji pokaże istotności różnic między rozpatrywanymi, to

powstaje pytanie, które z porównywanych populacji są odpowiedzialne za odrzucenie

hipotezy zerowej. Chcemy wiedzieć, które z n średnich różnią się między sobą, a które są

Przystępny kurs statystyki

równe. Musimy wtedy koniecznie przeprowadzić dokładniejsze badania różnic między

średnimi z poszczególnych grup. Wykorzystujemy do tego celu specjalne testy post-hoc,

zwane też testami wielokrotnych porównań.

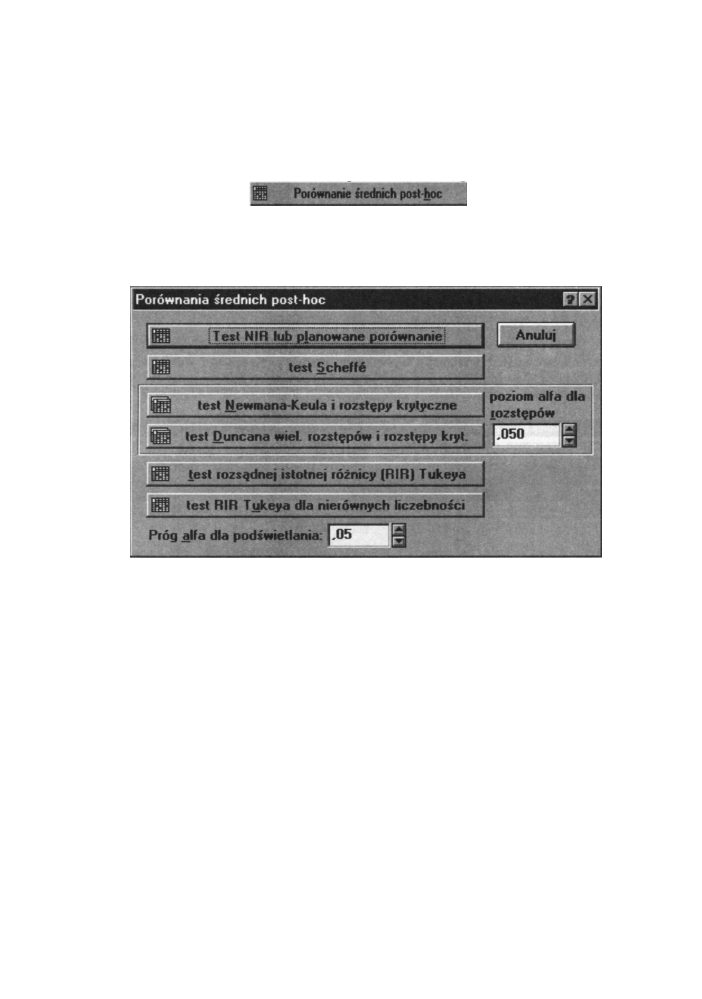

W pakiecie STATISTICA okno z pełną listą testów post-hoc zostaje wyświetlone

Rys. 10.6 Okno wyboru testów Post-hoc

Test NIR (najmniejszych istotnych różnic - ang. least significant differences (LSD)) to

historycznie najstarszy test zaproponowany w 1949 roku przez R. A. Fishera. Polega on

na wyznaczeniu tzw. najmniejszych istotnych różnic (dokładne obliczenia dla tego testu

zostały opisane na początku rozdziału). Najczęściej procedurę Fishera stosuje się do

średnich uporządkowanych niemalejąco i porównanie rozpoczynamy od średnich

najbardziej oddalonych. W rezultacie w zbiorze wszystkich średnich wyróżniamy

podzbiory wewnętrznie jednorodne. Podzbiory te niekoniecznie muszą być rozłączne.

Możliwa też jest sytuacja, że nie wydzieliliśmy żadnego podzbioru różnego od

pozostałych, mimo że test F analizy wariancji wskazał na istotne zróżnicowanie.

Odrzucenie hipotezy zerowej H

0

: m

1

= m

2

= ....m

k

wynikać bowiem może z istotności

pewnych porównań, które niekoniecznie muszą być porównaniem par (np. m

1

z (m

1

+m

2

+m

3

)/3). Ta procedura umożliwia również wyznaczenie przedziałów ufności. Test NIR

jest najmniej odporny na zwiększone wartości a spowodowaną wielokrotnymi

porównaniami. Poziom istotności a przy weryfikacji hipotezy m

i

= m

j

i # j odnosi się

bowiem do pojedynczego porównania, a nie do wszystkich rezultatów. Jest to poważna

trudność, gdyż przyzwyczajeni jesteśmy wiązać różne warunki w całość, a nie

interpretować oddzielnie. Wraz ze wzrostem liczby średnich wzrasta bardzo szybko

188

po kliknięciu przycisku

Po wybraniu zmiennych,

zależnych dla których chcemy przeprowadzić test, otwiera się okno jak na poniższym

rysunku. W oknie tym mamy pełny wybór najbardziej znanych testów post-hoc porównań

wielu średnich. Omówimy kolejno wszystkie wskazując na ich plusy i minusy (Sitek M.

[54]).

Analiza wariancji

poziom istotności dla całego doświadczenia. Test ten stosujemy więc najczęściej jako

sprawdzian i metodę towarzyszącą innym testom.

W arkuszu wyników wyświetlana jest macierz wartości p wskazujących na poziomy

istotności dla kolejnych par średnich.

• Test Scheffego to najbardziej konserwatywny test. Oznacza to, że postępując zgodnie

z metodą Scheffego, rzadziej będziemy odrzucać pojedyncze porównania niż w innych

testach. Test ten ma szerokie zastosowanie, uwzględnia bowiem nie tylko porównania

par cech, ale wszystkie możliwe kontrasty. Ważne jest też to, że w teście Scheffego

mamy zagwarantowany łączny poziom istotności dla wszystkich testowanych par,

czego nie gwarantowała poprzednia metoda (test NIR). Metoda Scheffego jest też

metodą najbardziej zachowawczą, ponieważ stopień błędu typu pierwszego jest

najmniejszy. Jednak dla porównań par średnich bardziej zalecany jest test Tukeya

i Newmana-Keulsa.

W arkuszu wyników wyświetlana jest macierz wartości p wskazujących na poziomy

istotności dla kolejnych par średnich.

• Test Newmana-Keulsa należy do grupy testów opartych na studentyzowanym

rozstępie. Test Newmana-Keulsa bada każdą hipotezę o równości pewnej grupy

średnich. Przy jego pomocy możemy więc tworzyć grupy jednorodne. Test ten ze

względu na niejednoczesne testowanie hipotez o równości średnich nie może służyć do

tworzenia przedziałów ufności. Idea obliczeń jest następująca:

• sortujemy średnie w porządku niemalejącym,

• dla każdej pary średnich testujemy różnicę rozstępów przy ustalonych

liczebnościach.

W arkuszu wyników wyświetlana jest tablica wartości p, a następnie okno zawierające

wartości krytyczne rozstępów pomiędzy posortowanymi średnimi dla zadanego

poziomu istotności. Wielkość tego poziomu istotności (domyślnie 0,05) możemy

regulować w okienku obok przycisku uruchamiającego obliczanie tego testu.

• Test Duncana to drugi test opartych na studentyzowanym rozstępie. Dokładne

obliczenia dla tego testu zostały opisane na początku rozdziału. Podobnie jak poprzedni,

test Duncana ze względu na niejednoczesne testowanie hipotez o równości średnich nie

może służyć do tworzenia przedziałów ufności. Przy teście Duncana poziom istotności

dla porównań wszystkich średnich jest równy 1 - (1 - α)

n-1

i wzrasta do 1 gdy n

rośnie

do nieskończoności. Zatem dla dużej liczby średnich prawdopodobieństwo błędu może

być duże (np. dla α = 0,05 i n = 10 wartość ta wynosi 0,401). Można więc przy dużej

ilości średnich podjąć błędną decyzję. Test ten stosujemy więc najczęściej jako

sprawdzian i metodę towarzyszącą innym testom.

W arkuszu wyników wyświetlana jest tablica wartości p, a następnie okno zawierające

wartości krytyczne rozstępów pomiędzy posortowanymi średnimi dla zadanego

poziomu istotności. Wielkość poziomu istotności (domyślnie 0,05) możemy regulować

w okienku obok przycisku uruchamiającego obliczania.

189

Przystępny kurs statystyki

• Test Tukeya występuje w dwóch wariantach - test dla równej liczebności próbek i dla

nierównej liczebności (test Spjotvolla i Stolinea). Test Tukeya jest również oparty na

studentyzowanym rozkładzie. Metoda Tukea jest bardziej konserwatywna od testu NIR,

a mniej od testu Scheffego. Oznacza to, że postępując zgodnie z metodą Tukeya

rzadziej będziemy odrzucać pojedyncze porównania niż w metodzie NIR. Test ten

najbardziej polecany do porównań par średnich. Przy jego pomocy możemy

tworzyć grupy jednorodne. Błąd pierwszego rodzaju jest tutaj mniejszy niż wyznaczony

innymi testami (NIR, Duncana, Newmana-Keulsa). Ważne jest też to, że w teście

Scheffego mamy zagwarantowany łączny poziom istotności dla wszystkich

testowanych par.

W arkuszu wyników wyświetlana jest macierz wartości p wskazujących na poziomy

istotności dla kolejnych par średnich.

Przykłady

Przykład 1 (ciąg dalszy)

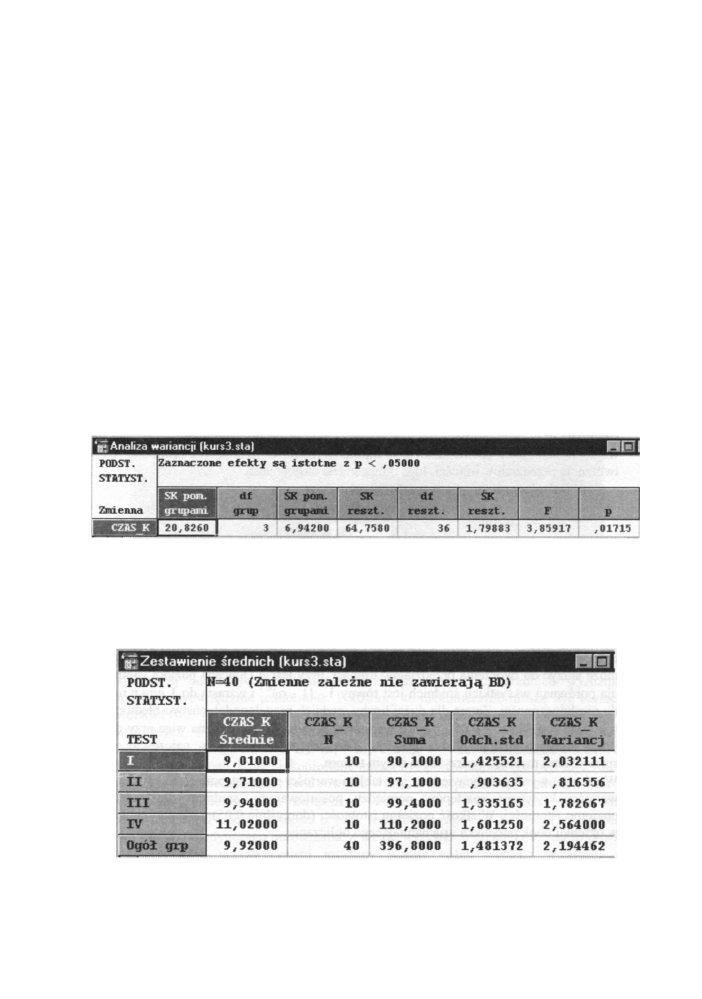

Przeprowadźmy dla danych z przykładu 1 pełną analizę w pakiecie STATISTICA. Po

wprowadzeniu danych i kliknięciu na przycisku Analiza wariancji wyświetlony jest

arkusz wyników jak na poniższym rysunku.

Rys. 10.7 Arkusz wyników analizy wariancji dla danych z przykładu 1

Potwierdza on dotychczasowe obliczenia (z początku rozdziału). Możemy odrzucić

hipotezę o równości średnich nawet na poziomie równym 0,017. Wywołujemy

(przyciskiem Zestawienie średnich) okno z wartościami średnich w poszczególnych

podgrupach. Przyjmuje ono postać jak na poniższym rysunku:

Rys. 10.8 Zestawienie średnich dla danych z przykładu 1

190

Analiza wariancji

W zestawieniu średnich zaobserwowano znaczne odchylenie średniego czasu krzepnięcia

dla metody czwartej w porównaniu z innymi metodami (zwłaszcza pierwszą). To być może

przyczyniło się do obalenia hipotezy zerowej o równości wszystkich średnich. Sprawdzimy

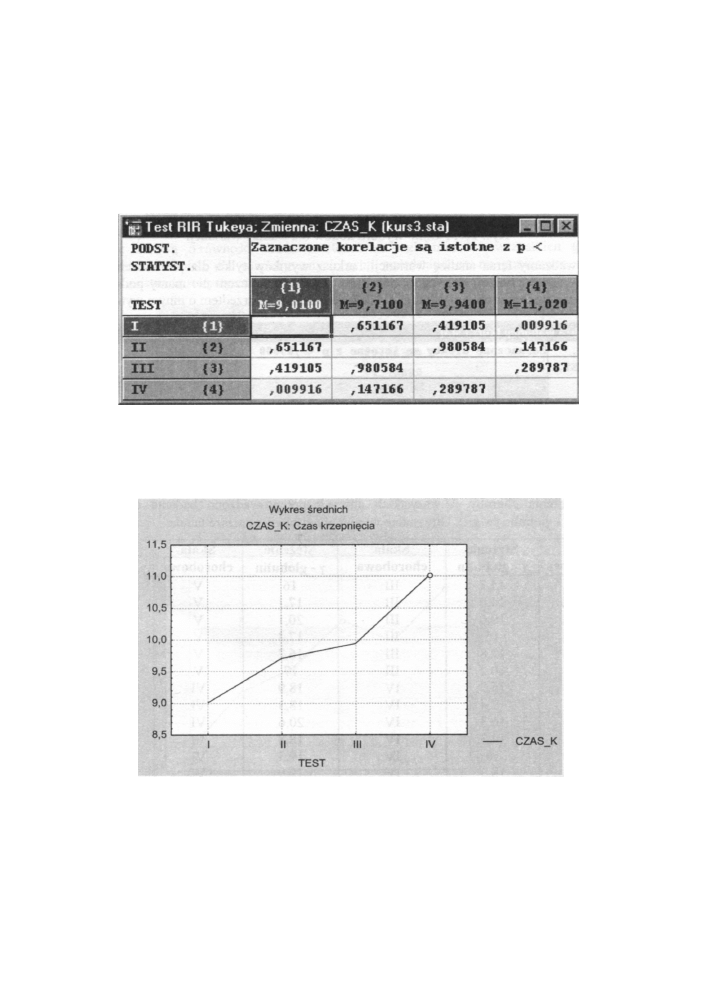

to wykorzystując testy po fakcie (post-hoc). Wybieramy test Tukeya i otrzymujemy arkusz

wyników widoczny na poniższym rysunku. Procedura Tukeya utworzyła dwie grupy

jednorodne - pierwsza {metodal, metoda2, metoda3} i druga {metoda2, metoda 3,

metoda4}, przez co potwierdziła nasze przypuszczenia wysnute ze średnich.

Rys. 10.9 Arkusz wyników testu Tukeya dla danych z przykładu 1

Również interpretacja graficzna otrzymana przez kliknięcie na przycisku Wykres

interakcji (rysunek poniżej) potwierdza dotychczasowe wnioski, że o odrzuceniu hipotezy

zerowej zadecydowała znaczna różnica pomiędzy średnimi metody pierwszej i czwartej.

Wykres średnich

CZAS_K: Czas krzepnięcia

Rys. 10.10 Interpretacja graficzna wyników analizy wariancji - przykład 1

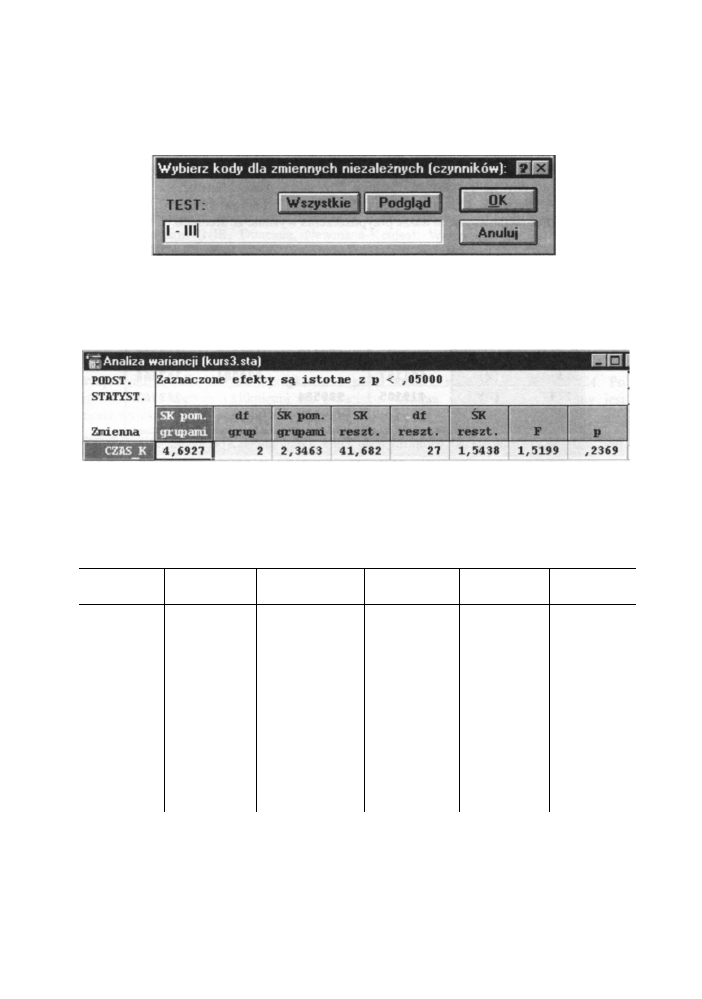

Spróbujmy teraz przeprowadzić analizę wariancji tylko dla pierwszych trzech metod.

W oknie Statystyki opisowe i korelacje w grupach-Przekroje klikamy na przycisku

191

Przystępny kurs statystyki

Kody zmiennych grupujących i w nowo otwartym oknie wprowadzamy kody tylko dla

metod od I do III. Sytuacja taka widoczna jest na poniższym rysunku:

Rys. 10.11 Okno wyboru kodów dla analizy wariancji

Przeprowadzamy teraz analizę wariancji i arkusz wyników tylko dla pierwszych trzech

metod (rysunek poniżej) daje zgoła odmienny wynik. Tym razem nie mamy podstaw do

odrzucenia hipotezy zerowej. Metoda IV decydowała jednak przedtem o innym wyniku.

Rys. 10.12 Wyniki analizy wariancji dla trzech pierwszych metod

Przykład 2

Grupę 36 chorych na pewną chorobę podzielono na sześć podgrup (od I do VI) według

skali natężenia choroby. U wszystkich chorych przeprowadzono badanie określające

stężenie y - globulin (w g/l). Otrzymane wyniki przedstawia poniższa tabela:

Skala

Stężenie

Skala

Stężenie

Skala

Stężenie

chorobowa

γ - globulin

chorobowa

γ - globulin

chorobowa

γ - globulin

I

15,2

III

16

V

18,4

I

14,0

III

17,1

V

16,9

I

10,6

III

20,1

V

17,3

I

16

III

17,3

V

21

I

17,8

III

16,2

V

19,9

I

10,2

III

17

V

16,9

II

15,5

IV

18,9

VI

19,5

II

17,4

IV

18,3

VI

21

II

16,3

IV

20,6

VI

25,5

II

14,3

IV

18,8

VI

21,1

II

16

IV

19,3

VI

18,5

II

18,3

IV

19,9

VI

17,9

Co

możemy powiedzieć o średnim poziomie stężenia γ - globulin we wszystkich sześciu

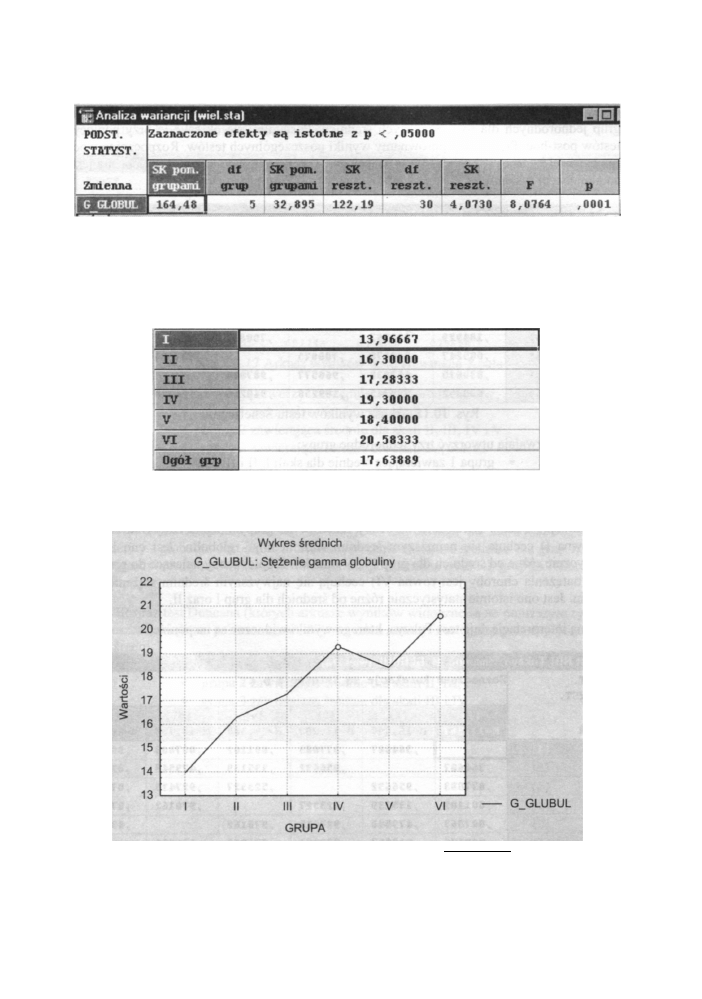

podgrupach? Po wprowadzeniu danych i kliknięciu na przycisku Analiza wariancji

wyświetlony jest arkusz wyników jak na poniższym rysunku.

192

Analiza wariancji

Rys. 10.13 Arkusz wyników analizy wariancji dla danych z przykładu 2

Z arkusza wnioskujemy, że możemy na poziomie p = 0,0001 (bardzo małym) odrzucić

hipotezę zerową o równości średnich stężeń γ - globulin we wszystkich grupach.

Zestawienie

średnich dla rozpatrywanych grup przedstawione na poniższym rysunku

ilustruje zaistniałą statystycznie istotną różnicę pomiędzy średnimi.

Również analiza graficzna otrzymana przez kliknięcie na przycisku Wykres interakcji

(rysunek poniżej) potwierdza wniosek o odrzuceniu hipotezy zerowej.

Wykres średnich

GGLUBUL: Stężenie gamma globuliny

I II III IV V VI G_GLUBUL

GRUPA

Rys. 10.14 Wykres średnich dla danych z przykładu 2

193

Przystępny kurs statystyki

Powyższy rysunek wskazuje na duże zróżnicowanie średnich i podpowiada istnienie kilku

grup jednorodnych dla rozpatrywanych średnich. Postaramy się określić je przy pomocy

testów post-hoc. Przy okazji porównamy wyniki poszczególnych testów. Rozpoczniemy od

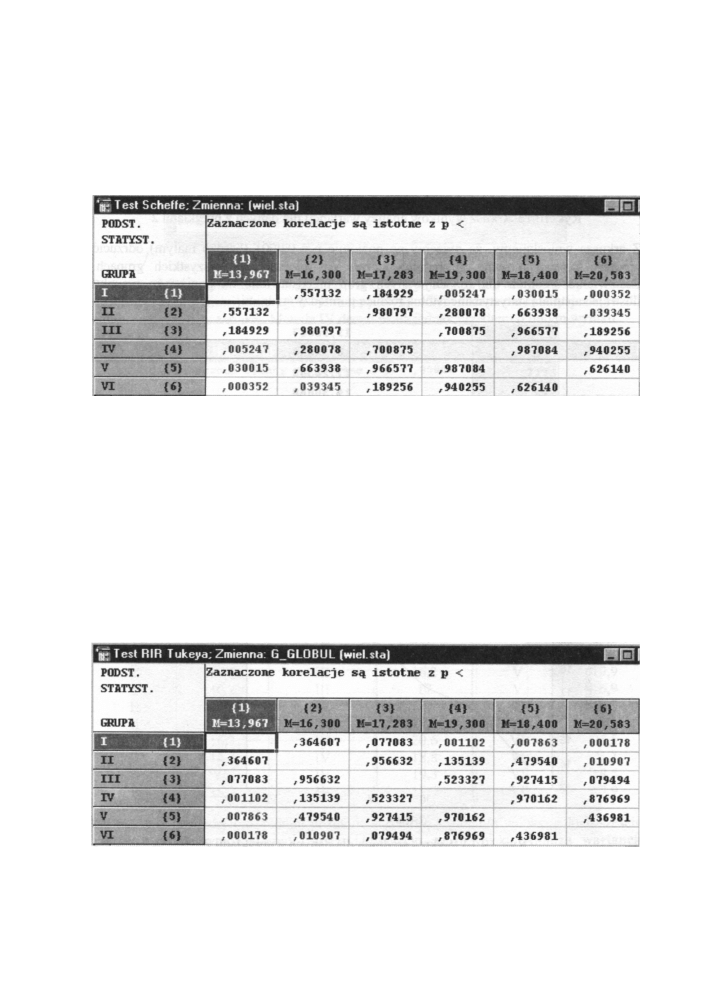

(najbardziej konserwatywnego) testu Scheffego. Arkusz wyników tego testu widoczny jest

na poniższym rysunku.

Rys. 10.15 Arkusz wyników testu Scheffego

Wyniki te pozwalają utworzyć trzy jednorodne grupy:

* grupa 1 zawierająca średnie dla skali I, II i III

* grupa 2 zawierająca średnie dla skali II, III, IV i V

* grupa 3 zawierająca średnie dla skali III, IV, V i VI

W konkluzji możemy stwierdzić, że osoby należące do grupy I (skala natężenia choroby

jest równa I) cechują się najniższym średnim stężeniem y - globulin. Jest ono istotnie

statystycznie różne od średnich dla grup IV, V oraz VI. Z kolei osoby należące do grupy VI

(skala natężenia choroby jest równa VI) cechują się najwyższym średnim stężeniem y -

globulin. Jest ono istotnie statystycznie różne od średnich dla grup I oraz II.

Podobną interpretację daje test Tukeya, którego wyniki widoczne są na poniżej.

Rys. 10.16 Arkusz wyników testu Tukeya

194

Analiza wariancji

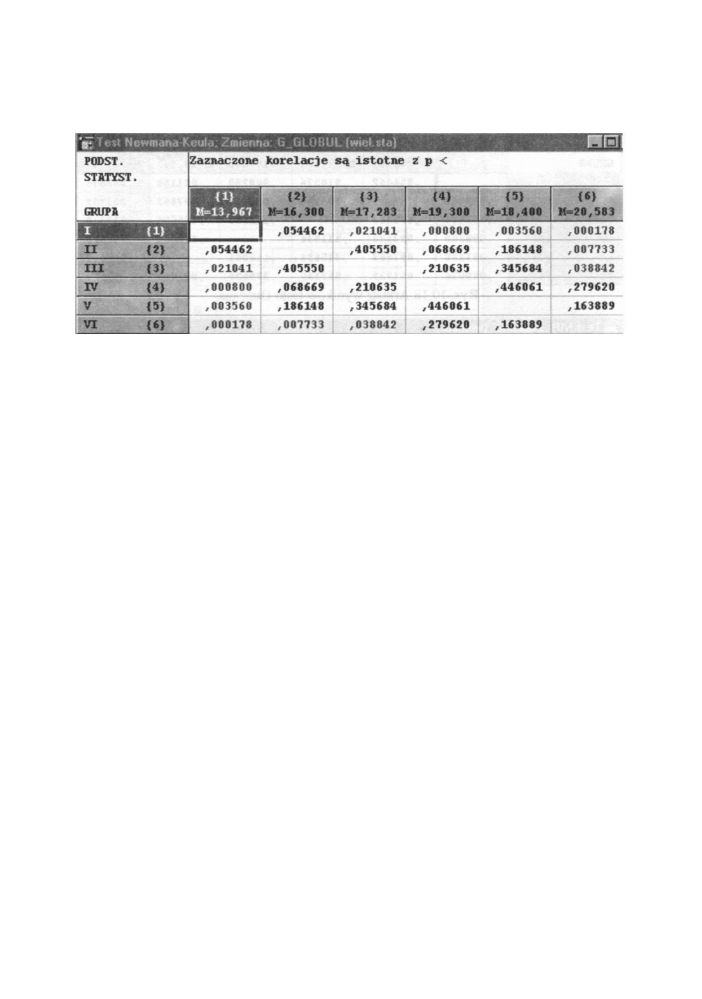

Zastosowanie testu Newmana-Keula daje trochę inne grupy jednorodne. Arkusz wyników

tego testu widoczny jest na poniższym rysunku.

Rys. 10.17 Arkusz wyników testu Newmana-Keula

Tym razem wyniki pozwalają utworzyć następujące jednorodne grupy:

* grupa 1 zawierająca średnie dla skali I i II

* grupa 2 zawierająca średnie dla skali II, III, IV i V

* grupa 3 zawierająca średnie dla skali IV, V i VI

W konkluzji możemy stwierdzić, że osoby należące do grupy I (skala natężenia choroby

równa jest I) cechują się najniższym średnim stężeniem y - globulin. Jest ono istotnie

statystycznie różne od średnich dla grup III, IV, V oraz VI. Z kolei osoby należące do

grupy VI (skala natężenia choroby równa jest VI) cechują się najwyższym średnim

stężeniem γ - globulin. Jest ono istotnie statystycznie różne od średnich dla grup I, II oraz

III. Poprzednie testy nie wykazały istotności dla porównania średnich grup I i III oraz grup

III i VI.

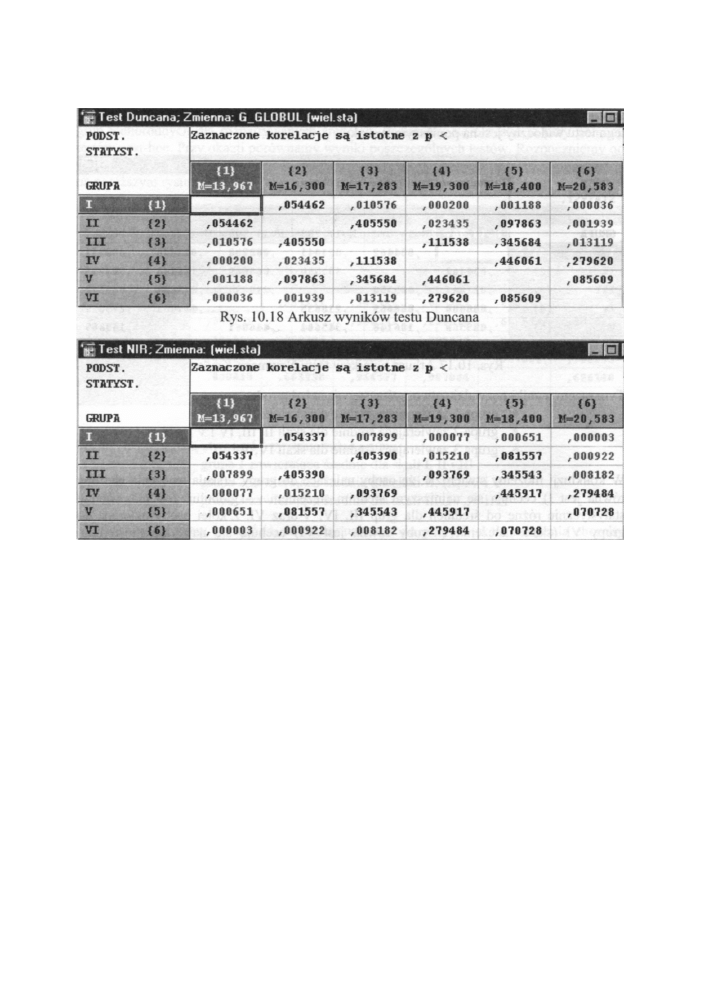

Test NIR oraz test Duncana (których arkusze wyników widoczne są na poniższym rysunku)

dają jeszcze większe zróżnicowanie. Tym razem mamy następujące cztery jednorodne

grupy średnich:

* grupa 1 zawierająca średnie dla skali I i II

* grupa 2 zawierająca średnie dla skali II, III, i V

* grupa 3 zawierająca średnie dla skali III i IV

* grupa 4 zawierająca średnie dla skali IV, V i VI

195

Przystępny kurs statystyki

Rys. 10.19 Arkusz wyników testu NIR

Ostatnie dwa testy wskazały na istotność porównania średnich grup II i IV, którego

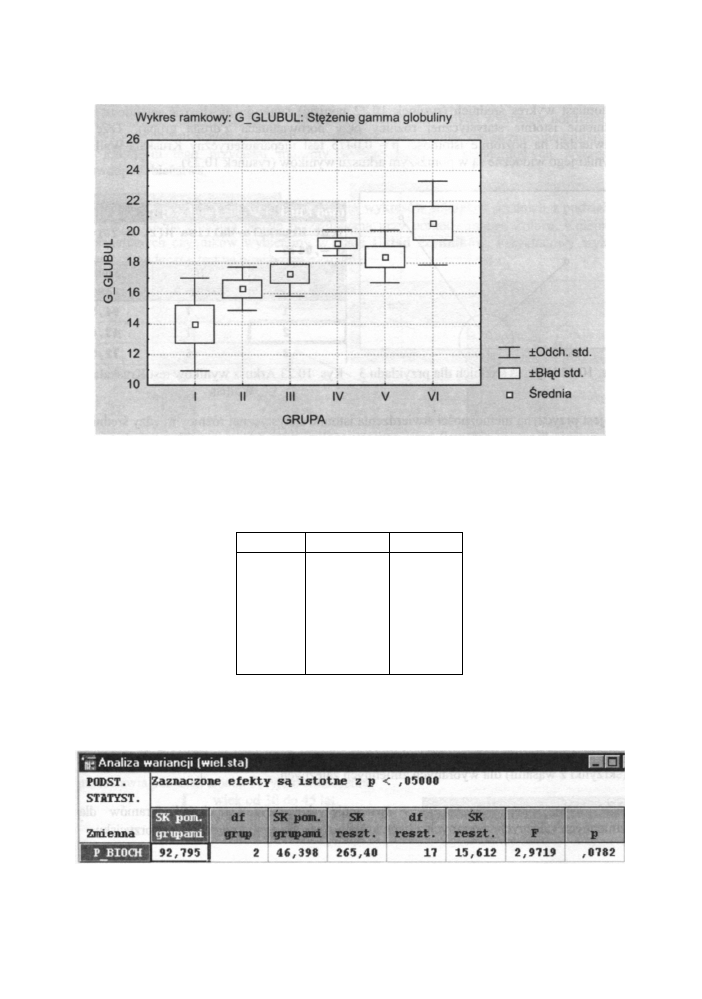

wcześniejsze testy nie sygnalizowały. Na koniec jeszcze jedna interpretacja graficzna

otrzymanych wyników. Tym razem przedstawimy skrzynki z wąsami dla poszczególnych

grup. Ich układ widoczny jest na poniższym rysunku.

196

Analiza wariancji

Rys. 10.20 Interpretacja graficzna danych z przykładu 2

Przykład 3

W celach diagnostycznych dokonano pomiaru pewnego parametru biochemicznego

w trzech grupach chorych na pewną chorobę. Łącznie przebadano 20 chorych. Wyniki

zestawiono w poniższej tabeli:

Grupa 1

Grupa 2

Grupa 3

12

9

11

14

8

15

12

10

26

15

13

11

16

13

22

12

10

10

16

11

Analiza wariancji przeprowadzona dla tych danych nie daje podstaw do odrzucania

hipotezy zerowej (wartość poziomu p = 0 0782). Jej wyniki widoczne są na poniższym

rysunku.

Rys. 10.21 Arkusz wyników analizy wariancji dla danych z przykładu 3

197

Przystępny kurs statystyki

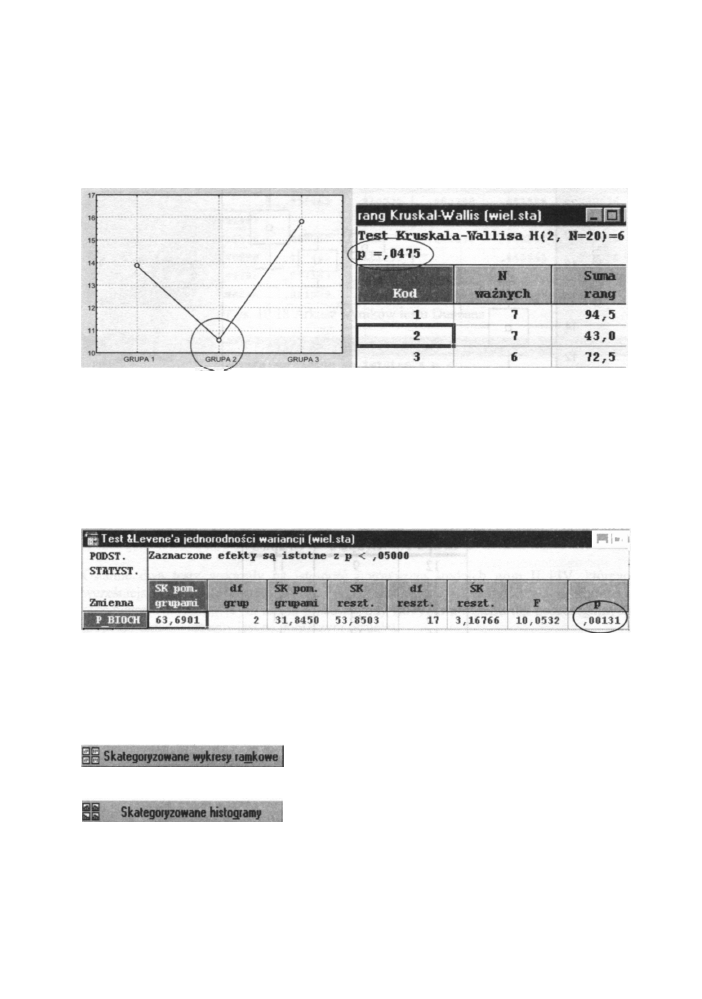

Natomiast wykres średnich (rysunek 10.22 poniżej) sugeruje możliwość jej odrzucenia

(istnienie istotnie statystycznej różnicy przy porównaniach z drugą grupą). Tezę tą

potwierdził na poziomie istotności p = 0,0475 test nieparametryczny Kruskala-Wallisa.

Wyniki jego widoczne są w poniższym arkuszu wyników (rysunek 10.23).

Co jest przyczyną niemożności stwierdzenia istotnie statystycznej różnicy między średnimi

(odrzucenia hipotezy zerowej) przy pomocy analizy wariancji, mimo że mniej skuteczne

testy nieparametryczne wskazują na jej istnienie? Otóż nie sprawdziliśmy wszystkich jej

założeń. Test Levene'a (którego arkusz wyników pokazany jest na rysunku 10.24)

wyraźnie wskazuje na brak jednorodności wariancji. Należy sprawdzać założenia

stosowanych testów.

nm,

Rys 10.24. Arkusz wyników testu Levene'a

[4] - Interpretacja graficzna

Grupa przycisków znajdująca się w tej grupie wyjaśnia graficznie otrzymane wyniki,

ułatwiając ich zrozumienie i interpretację. Przyciski umożliwiają:

tworzenie skategoryzowanych histogramów dla

zmiennych zależnych wybranych z listy, która pokaże się po kliknięciu na tym przycisku.

198

Rys. 10.22 Wykres średnich dla przykładu 3 Rys. 10.23 Arkusz wyników test Kruskala-

Wallisa

- tworzenie skategoryzowanych wykresów ramkowych

(skrzynki z wąsami) dla wybranych zmiennych zależnych.

Analiza wariancji

- tworzenie skategoryzowanych wykresów normalności

dla wybranych zmiennych zależnych. Czynnikami kategoryzującymi są zmienne grupujące.

Po kliknięciu tego przycisku możemy wybrać jeden ze standardowych wykresów

prawdopodobieństwa.

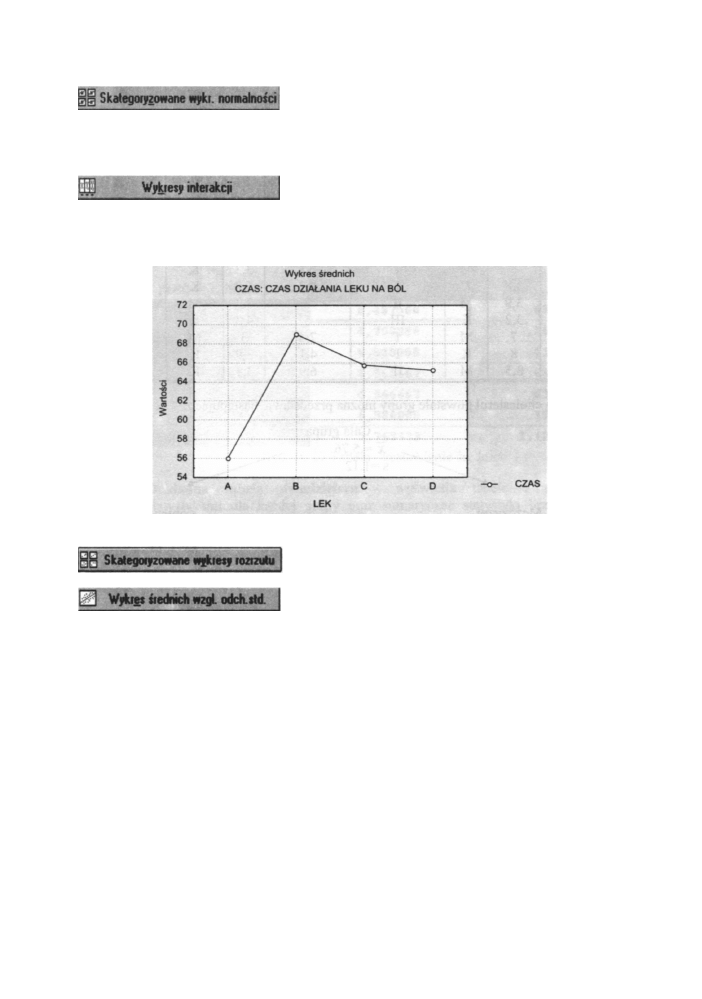

na grupy. Każda zmienna będzie prezentowana przy pomocy innego koloru. Kolejność

wyświetlanych czynników wybieramy w oknie Układ czynników. Przykładowy wykres

interakcji widoczny jest na poniższym rysunku.

Rys. 10.25 Przykładowy wykres interakcji

- tworzenie skategoryzowanych wykresów rozrzutu.

odpowiednich odchyleń standardowych. Wykres taki pomaga wychwycić odstające

średnie, które mogą prowadzić do błędnych wniosków przy ocenie istotności różnic między

średnimi.

W opisywanej grupie oprócz jednoczynnikowej analizy wariancji, możemy obliczyć też

różne statystyki opisowe dla grup skontrastowanych (tzw. przekrojów).

Załóżmy, że w grupie 30 pacjentów badamy poziom cholesterolu oraz stężenie wolnej T

3

(F T

3

) w surowicy krwi Otrzymane wyniki z uwzględnieniem płci i grupy wiekowej

przedstawia poniższa tabela. Przyjęto oznaczenia:

I wiek od 30 do 45 lat

II wiek od 45 do 60 lat

III wiek od 60 do 75 lat

199

- tworzenie wykresów interakcji średnich z podziałem

- tworzenie wykresów wartości średnich względem

Przystępny kurs statystyki

Cholesterol F T

3

Pleć Gr. wiekowa Cholesterol F T

3

Płeć

Gr.

Wiekowa

5,9

8

M

II

6,7

3,4

K

III

6,3

3,4

K

III

6,1

3,6

K

III

3,8

9

K

I

5,4

5,6

K

II

4,4

7

M

I

7,2

3,1

K

II

6,5

3,4

M

III

6

8,5

K

III

7

3,1

M

II

6,1

3,8

K

III

3,8

10

K

II

7,4

2,9

K

II

6,5

3,4

K

III

4,1

7,4

K

I

4,8

8

M

I

6,8

3,3

K

III

5,2

3,8

K

I

4,2

6,9

K

II

5,8

3,9

M

II

7

3,2

M

III

6,6

3,2

K

III

5

4,3

K

I

4,9

7

M

I

7,4

3

M

II

5,2

8

K

I

4,1

3,9

K

I

5,8

3,5

M

II

6,9

3,1

K

III

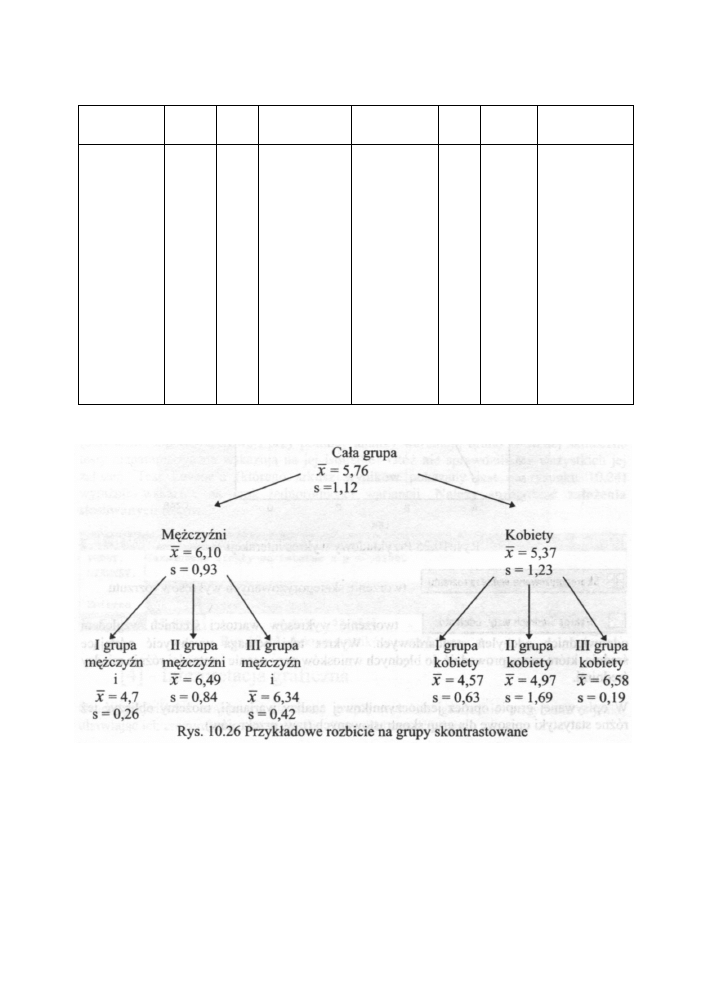

Dla zmiennej cholesterol powstałe grupy można przedstawić następująco:

Oczywiście możemy zmienić kolejność podziału - najpierw rozbicie na grupy wiekowe

potem rozbicie ze względu na płeć. Otrzymamy inne drzewo grup kontrastowych.

Podawane tam podstawowe statystyki można szybko i prosto wyliczyć. W programie

STATISTICA

znajdują się bowiem opcje do obliczania elementarnych statystyk i korelacji

w każdej grupie zdefiniowanej przez jedną lub kilka zmiennych grupujących. Wartości są

dostępne po kliknięciu w następujące przyciski opcji:

200

Analiza wariancji

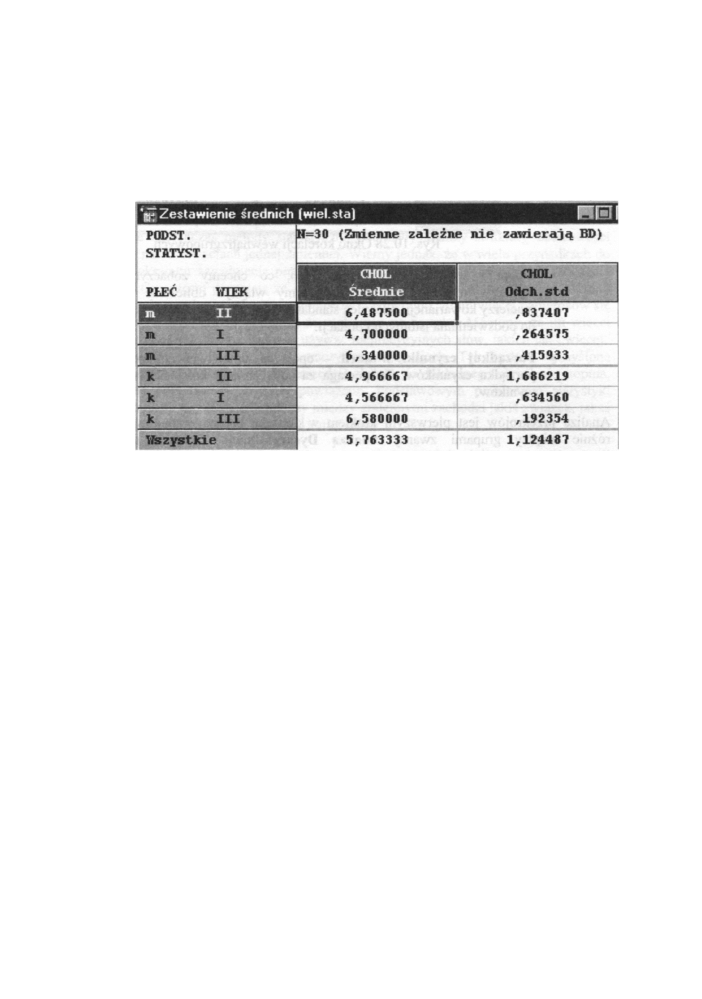

• Zestawienie średnich - wyświetla tabelę statystyk opisowymi

z uwzględnieniem podziału na grupy wyznaczone przez zmienne grupujące.

Jakie statystyki zostaną wyświetlone, zależy od dokonanego przez nas wyboru

w sąsiednim oknie Statystyki. Przykładowe zestawienie średnich dla

rozpatrywanych (zmienna cholesterol) danych wyświetlone jest na poniższym

rysunku;

Rys. 10.27 Tabela - zestawienie średnich

• Dokładna tabela dwudzielcza - wyświetla tabelę z sumarycznymi

statystykami dla każdej grupy oraz sumaryczne statystyki brzegowe (tzn.

statystyki dla każdego czynnika z pominięciem pozostałych). Jakie statystyki

zostaną wyświetlone zależy od dokonanego przez nas wyboru w sąsiednim

oknie Statystyki. O kolejności wyświetlanych statystyk decydują ustawienia

w opcji Porządkuj czynniki w tabeli (omówionej poniżej).

• Średnie brzegowe - wyświetla okno sumarycznych statystyk dla każdej tabeli

brzegowej (tabela zawierająca podzbiór aktualnych zmiennych grupujących

z pominięciem zmiennych wyłączonych).

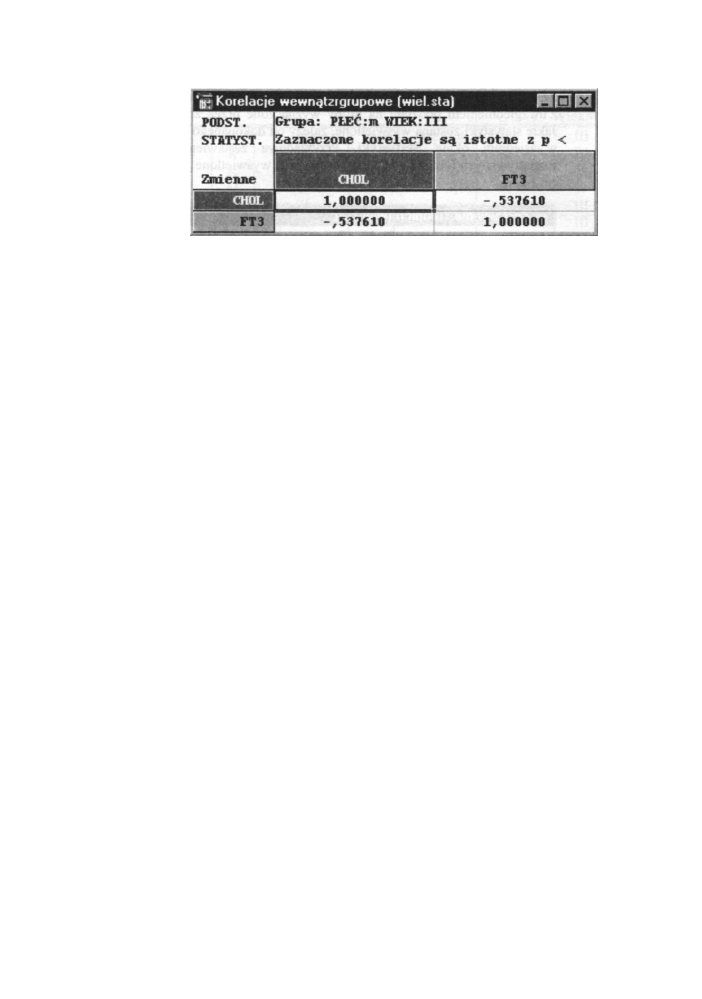

• Korelacje wewnątrzgrupowe - wyświetla macierz korelacji dla zmiennych

w wybranej podgrupie lub dla wszystkich podgrup. Podgrupy wybieramy

w pierwszym oknie, które pokaże się po kliknięciu na tym przycisku.

Przykładowe okno korelacji dla zmiennych zależnych cholesterol i F T3

w wybranej podgrupie (mężczyźni z trzeciej grupy) widoczne jest na

poniższym rysunku.

201

Przystępny kurs statystyki

Rys. 10.28 Okno korelacji wewnątrzgrupowych

• Opcje - umożliwia określenie tego, co chcemy zobaczyć w arkuszu

wynikowym powyższej opcji. Możemy włączyć obliczanie poziomu p,

macierzy kowariancji, odchyleń standardowych oraz określić poziom istotności

do podświetlania istotnych korelacji.

Analiza przekrojów jest pierwszym krokiem w kierunku bardzo rozbudowanej analizy

różnic między grupami zwanej Analizą Dyskryminacji. Opisanie tego bardzo

interesującego modułu nastąpi w kolejnych tomach.

202

• Porządkuj czynniki w tabeli - opcja ta umożliwia zmianę kolejności

porządku czynników. To pociąga za sobą zmiany kolejności wyświetlania

wyników.

Wyszukiwarka

Podobne podstrony:

wyklad 10 analiza wariancji

Opis analizowanych wariantów inwestycji

10 Analiza fin Analiza fundamentalna

Cw 5 10 Analiza tolerancji i od Nieznany

Jednoczynnikowa analiza wariancji

Analiza wariancji wprowadzenie

Cw 9 i 10 Analiza mikrobiologiczna GLEBY

Analiza wariancji

Hierarchiczna analiza wariancji zadania Word2003, Elementy matematyki wyższej

Analiza wariancji, Jednoczynnikowy model analizy wariancji

Cwiczenie nr 10 Analiza ilościowa Alkacymetria Oznacznie weglanow i wodoroweglanow

8 1 analiza wariancji odp

ANALIZA 3 WARIANTÓW ZAMIENNEGO WYKONANIA OKIEN

10[1] ANALIZA EFEKTYWNOĹšCI INWESTYCJIid 10774 ppt

analiza wariancji

analiza wariancji metodologia wyk4

6 jednoczynnikowa analiza wariancji

Analiza wariancji

więcej podobnych podstron